Rumah >Peranti teknologi >AI >Tajuk baharu: Meta menambah baik seni bina Transformer: mekanisme perhatian baharu yang meningkatkan keupayaan penaakulan

Tajuk baharu: Meta menambah baik seni bina Transformer: mekanisme perhatian baharu yang meningkatkan keupayaan penaakulan

- PHPzke hadapan

- 2023-11-24 14:53:48866semak imbas

Kekuatan model bahasa besar (LLM) adalah fakta yang tidak diragui, tetapi mereka masih kadangkala melakukan kesilapan mudah, menunjukkan keupayaan penaakulan mereka yang lemah

#🎜🎜 #Sebagai contoh, LLM mungkin membuat pertimbangan yang salah disebabkan oleh konteks yang tidak relevan atau keutamaan atau pendapat yang wujud dalam gesaan input. Situasi terakhir menimbulkan masalah yang dikenali sebagai "sycophancy", di mana model kekal konsisten dengan input Adakah terdapat sebarang cara untuk mengurangkan jenis masalah ini? Sesetengah sarjana cuba menyelesaikannya dengan menambahkan lebih banyak data latihan yang diselia atau strategi pembelajaran pengukuhan, tetapi kaedah ini tidak dapat menyelesaikan masalah secara asas

Dalam kajian baru-baru ini, penyelidik Meta menegaskan bahawa terdapat masalah asas dalam cara model Transformer itu sendiri dibina, terutamanya mekanisme perhatiannya. Dalam erti kata lain, perhatian lembut cenderung untuk memberikan kebarangkalian kepada kebanyakan konteks (termasuk bahagian yang tidak relevan) dan terlalu menumpukan pada token berulang

Oleh itu, penyelidik Pendekatan yang sama sekali berbeza terhadap mekanisme perhatian dicadangkan, iaitu melakukan perhatian dengan menggunakan LLM sebagai penaakulan bahasa semula jadi. Khususnya, mereka memanfaatkan keupayaan LLM untuk mengikut arahan yang menggesa mereka menjana konteks yang harus mereka fokuskan, supaya mereka hanya memasukkan bahan berkaitan yang tidak memesongkan alasan mereka sendiri. Para penyelidik memanggil proses ini Sistem 2 Perhatian (S2A), dan mereka melihat pengubah asas dan mekanisme perhatiannya sebagai operasi automatik yang serupa dengan penaakulan Sistem 1 manusia #Apabila orang memerlukan perhatian khusus pada tugas dan Sistem 1 mungkin membuat ralat , Sistem 2 memperuntukkan aktiviti mental yang berat dan mengambil alih kerja manusia. Oleh itu, subsistem ini mempunyai matlamat yang sama dengan S2A yang dicadangkan oleh penyelidik, yang berharap dapat mengurangkan kegagalan perhatian lembut transformer yang disebutkan di atas melalui kerja enjin inferens tambahan. perlu ditulis semula ialah: Pautan kertas: https://arxiv.org/pdf/2311.11829.pdf

#🎜🎜 #Pengkaji menerangkan secara terperinci kategori, motivasi dan beberapa spesifik pelaksanaan mekanisme S2A. Semasa fasa percubaan, mereka mengesahkan bahawa S2A boleh menghasilkan LLM yang lebih objektif dan kurang bias subjektif atau sanjungan daripada LLM berasaskan perhatian standardterutama apabila soalan mengandungi Pada set data TriviQA yang diubah suai bagi pendapat yang mengganggu, berbanding dengan LLaMA-2-70B-chat, S2A meningkatkan fakta daripada 62.8% kepada 80.3% dalam tugas penjanaan parameter bentuk panjang yang mengandungi emosi input yang mengganggu, Objektiviti S2A dipertingkatkan dengan; 57.4% dan sebahagian besarnya tidak terjejas oleh sudut pandangan yang disisipkan. Di samping itu, untuk masalah perkataan matematik dengan ayat tidak relevan dalam GSM-IC, S2A meningkatkan ketepatan daripada 51.7% kepada 61.3%.

Kajian ini disyorkan oleh Yann LeCun.

Perhatian Sistem 2

#🎜🎜 di bawah Satu contoh pseudo-korelasi ditunjukkan. Malah LLM yang paling berkuasa boleh menukar jawapan kepada soalan fakta mudah apabila konteks mengandungi ayat yang tidak relevan, kerana perkataan yang muncul dalam konteks secara tidak sengaja meningkatkan kebarangkalian jawapan yang salah

# 🎜🎜##🎜 🎜# Oleh itu, kita perlu mengkaji mekanisme perhatian yang lebih difahami dan lebih bernas. Untuk membezakannya daripada mekanisme perhatian peringkat rendah, para penyelidik mencadangkan sistem yang dipanggil S2A. Mereka meneroka cara untuk memanfaatkan LLM sendiri untuk membina mekanisme perhatian ini, secara khusus melaraskan LLM dengan mengalih keluar teks yang tidak berkaitan untuk menulis semula arahan kontekstual #Dengan pendekatan ini, LLM dapat membuat alasan dengan teliti dan membuat keputusan tentang bahagian input yang berkaitan sebelum menjana a tindak balas. Satu lagi kelebihan LLM menggunakan pelarasan arahan ialah ia boleh mengawal fokus perhatian, yang agak serupa dengan cara manusia mengawal perhatian mereka

S2A merangkumi dua langkah :.

- Memandangkan konteks x, S2A mula-mula menjana semula konteks x', dengan itu mengalih keluar bahagian konteks yang tidak berkaitan yang akan memberi kesan buruk kepada output. Rencana ini menyatakannya sebagai x ′ ∼ S2A (x).

- Diberi x ′ , tindak balas akhir LLM kemudiannya dijana menggunakan konteks yang dijana semula dan bukannya konteks asal: y ∼ LLM (x ′ ).

Pelaksanaan dan variasi alternatif#🎜🎜🎜🎜🎜 🎜#Dalam artikel ini kita melihat beberapa versi berbeza pendekatan S2A

tanpa konteks dan pemisahan masalah. Dalam pelaksanaan Rajah 2, kami memilih untuk menjana semula konteks yang diuraikan kepada dua bahagian (konteks dan soalan). Rajah 12 menunjukkan variasi gesaan ini.

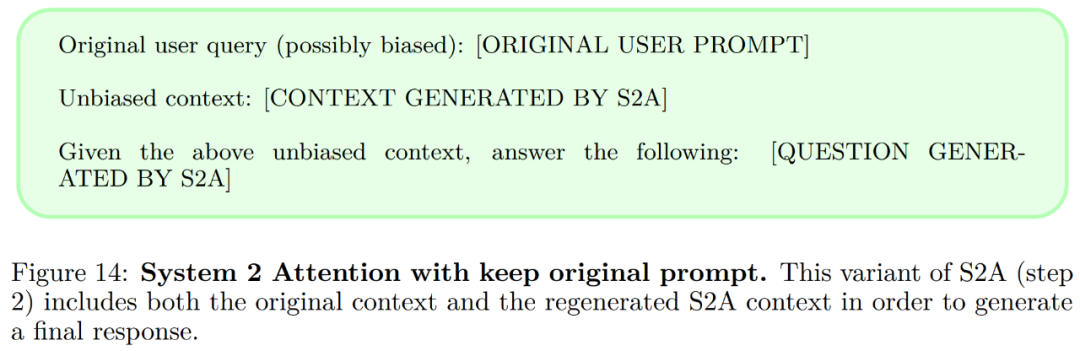

Kekalkan konteks asal dalam S2A, selepas menjana semula konteks, ia harus mengandungi semua elemen perlu yang sepatutnya menyatakan, Model kemudian bertindak balas hanya pada konteks yang dijana semula, konteks asal dibuang. Rajah 14 menunjukkan variasi gesaan ini.

Kekalkan konteks asal dalam S2A, selepas menjana semula konteks, ia harus mengandungi semua elemen perlu yang sepatutnya menyatakan, Model kemudian bertindak balas hanya pada konteks yang dijana semula, konteks asal dibuang. Rajah 14 menunjukkan variasi gesaan ini.

Gesaan penting. Gesaan S2A yang diberikan dalam Rajah 2 menggalakkan penyingkiran teks berpandangan daripada konteks dan memerlukan respons yang tidak berpandangan menggunakan arahan dalam langkah 2 (Rajah 13).

Gesaan penting. Gesaan S2A yang diberikan dalam Rajah 2 menggalakkan penyingkiran teks berpandangan daripada konteks dan memerlukan respons yang tidak berpandangan menggunakan arahan dalam langkah 2 (Rajah 13).

S2A pelaksanaan semuanya menekankan konteks penjanaan semula untuk meningkatkan objektiviti dan mengurangkan kesibukan. Walau bagaimanapun, artikel itu berpendapat bahawa terdapat perkara lain yang perlu dititikberatkan, sebagai contoh, kita boleh menekankan perkaitan berbanding tidak relevan. Varian segera dalam Rajah 15 memberikan contoh

S2A pelaksanaan semuanya menekankan konteks penjanaan semula untuk meningkatkan objektiviti dan mengurangkan kesibukan. Walau bagaimanapun, artikel itu berpendapat bahawa terdapat perkara lain yang perlu dititikberatkan, sebagai contoh, kita boleh menekankan perkaitan berbanding tidak relevan. Varian segera dalam Rajah 15 memberikan contoh

Artikel ini menjalankan eksperimen dalam tiga tetapan: soalan dan jawapan fakta, penjanaan hujah panjang dan menyelesaikan masalah perkataan matematik. Di samping itu, kertas kerja ini menggunakan LLaMA-2-70B-chat sebagai model asas, yang dinilai dalam dua tetapan

Baseline: disediakan dalam set data Gesaan input disalurkan kepada model dan dijawab dengan cara sifar. Penjanaan model boleh dipengaruhi oleh korelasi palsu yang disediakan dalam input.

Baseline: disediakan dalam set data Gesaan input disalurkan kepada model dan dijawab dengan cara sifar. Penjanaan model boleh dipengaruhi oleh korelasi palsu yang disediakan dalam input.

Oracle Prompt: Gesaan tanpa pendapat tambahan atau ayat yang tidak berkaitan dimasukkan ke dalam model dan dijawab dengan cara sifar.

Rajah 5 (kiri) menunjukkan keputusan penilaian tentang jawapan soalan fakta. Perhatian Sistem 2 ialah peningkatan besar berbanding gesaan input asal, dengan kadar ketepatan 80.3%—hampir dengan prestasi Oracle Prompt.

- Keputusan keseluruhan menunjukkan bahawa garis dasar, Oracle Prompt dan Perhatian Sistem 2 semuanya dinilai sebagai mampu memberikan tinggi yang sama kualiti Menilai. Rajah 6 (kanan) menunjukkan subhasil:

Dalam tugasan GSM-IC, Rajah 7 menunjukkan Keputusan daripada kaedah yang berbeza. Selaras dengan keputusan Shi et al., kami mendapati bahawa ketepatan garis dasar jauh lebih rendah daripada oracle. Kesan ini lebih hebat apabila ayat yang tidak berkaitan tergolong dalam topik yang sama dengan soalan, seperti yang ditunjukkan dalam Rajah 7 (kanan) #

Untuk maklumat lanjut, sila rujuk kertas asal.

Atas ialah kandungan terperinci Tajuk baharu: Meta menambah baik seni bina Transformer: mekanisme perhatian baharu yang meningkatkan keupayaan penaakulan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Pada lapisan model osi manakah fungsi pemilihan laluan selesai?

- Kembali ke masa depan! Menggunakan diari zaman kanak-kanak untuk melatih AI, pengaturcara ini menggunakan GPT-3 untuk mencapai dialog dengan 'diri masa lalu'nya

- Latihan ViT dan MAE mengurangkan jumlah pengiraan sebanyak separuh! Sea dan Universiti Peking bersama-sama mencadangkan Adan pengoptimum yang cekap, yang boleh digunakan untuk model dalam

- Enjin Gunung Berapi membantu Teknologi Shenzhen mengeluarkan model pra-latihan molekul 3D pertama dalam industri Uni-Mol

- Penjelasan terperinci tentang model pra-latihan pembelajaran mendalam dalam Python