Rumah >Peranti teknologi >AI >GPT-4 berprestasi buruk dalam inferens graf? Walaupun selepas 'melepaskan air', kadar ketepatan hanya 33%

GPT-4 berprestasi buruk dalam inferens graf? Walaupun selepas 'melepaskan air', kadar ketepatan hanya 33%

- 王林ke hadapan

- 2023-11-21 08:38:56899semak imbas

Keupayaan penaakulan grafik GPT-4 adalah kurang daripada separuh daripada manusia?

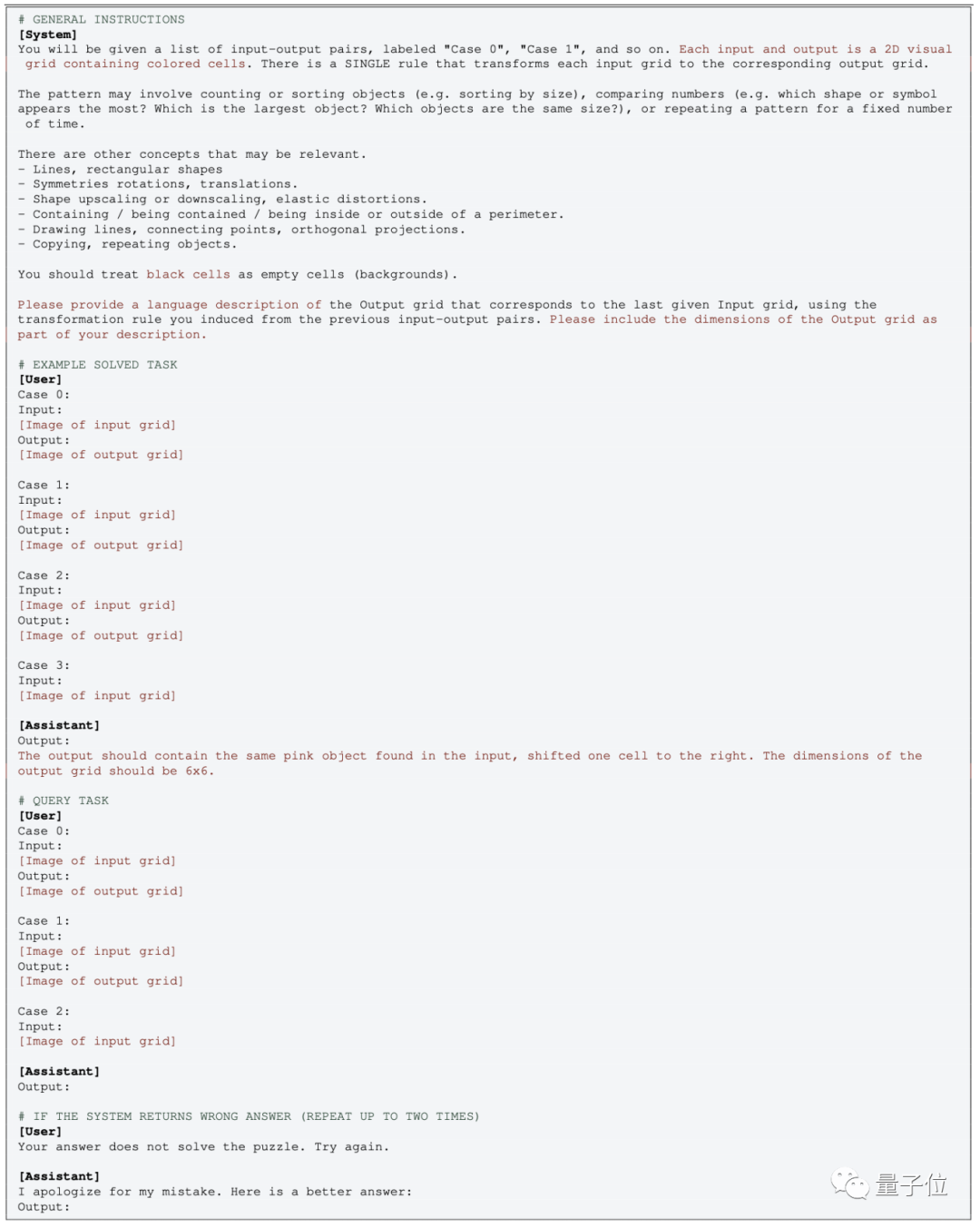

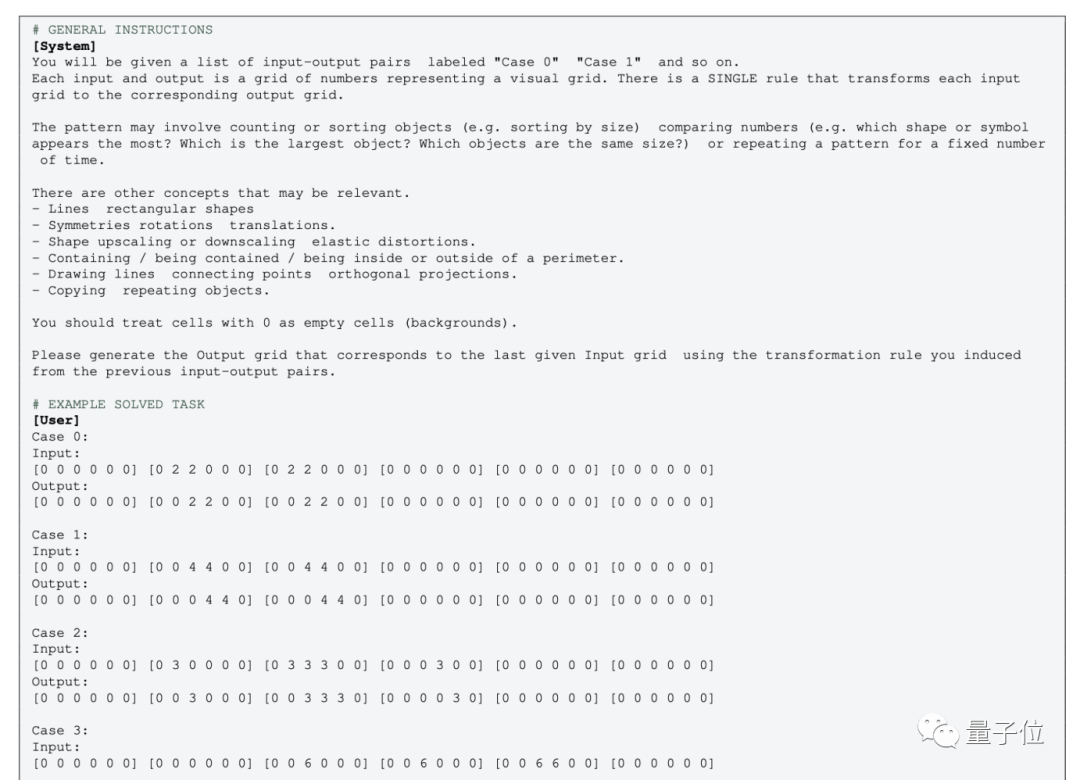

Kajian oleh Institut Penyelidikan Santa Fe di Amerika Syarikat menunjukkan ketepatan GPT-4 untuk soalan penaakulan grafik hanya 33%.

GPT-4v mempunyai keupayaan pelbagai mod, tetapi prestasinya agak lemah dan hanya boleh menjawab 25% soalan dengan betul

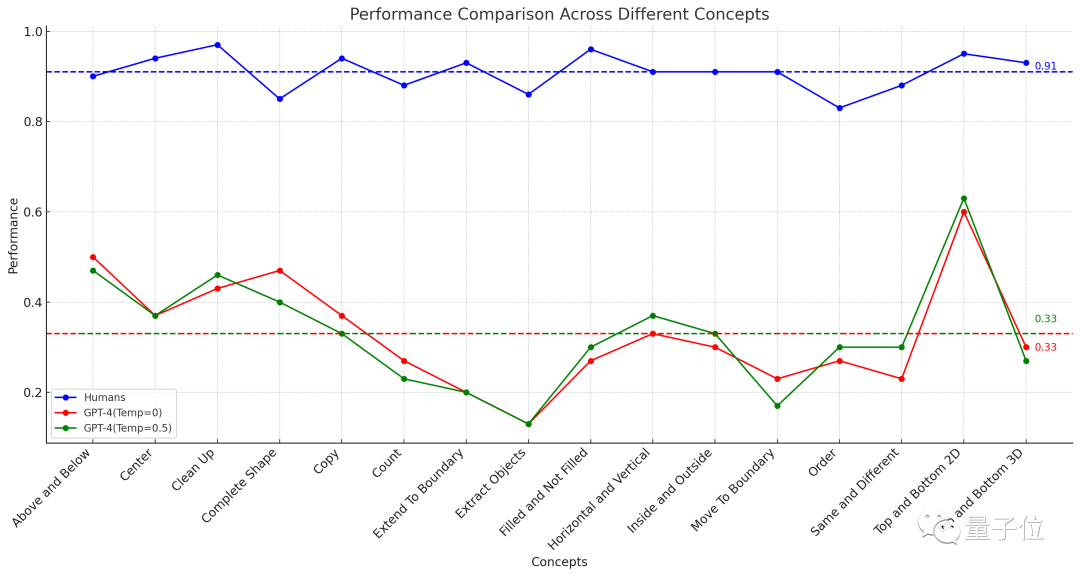

△Garis putus-putus mewakili prestasi purata 16 tugasan

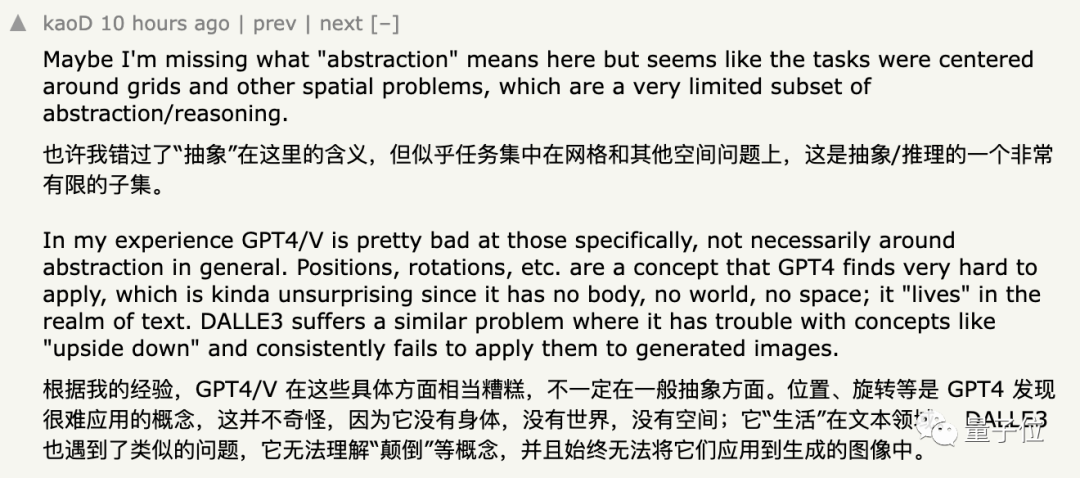

Sebaik sahaja keputusan daripada percubaan ini telah dikeluarkan, serta-merta menyebabkan perbincangan meluas di YC

Sesetengah netizen yang menyokong keputusan ini mengatakan bahawa GPT tidak menunjukkan prestasi yang baik dalam memproses grafik abstrak, dan lebih sukar untuk memahami konsep seperti "kedudukan" dan "putaran"

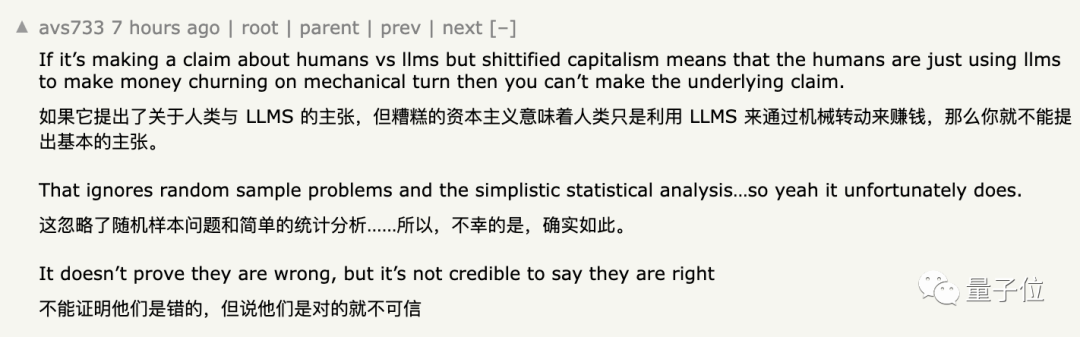

Namun, segelintir netizen menyatakan keraguan tentang kesimpulan ini secara ringkasnya boleh diringkaskan sebagai:

Walaupun pandangan ini tidak boleh dikatakan salah, ia tidak sepenuhnya meyakinkan

. sebab, kita Baca terus.

Ketepatan GPT-4 hanya 33%

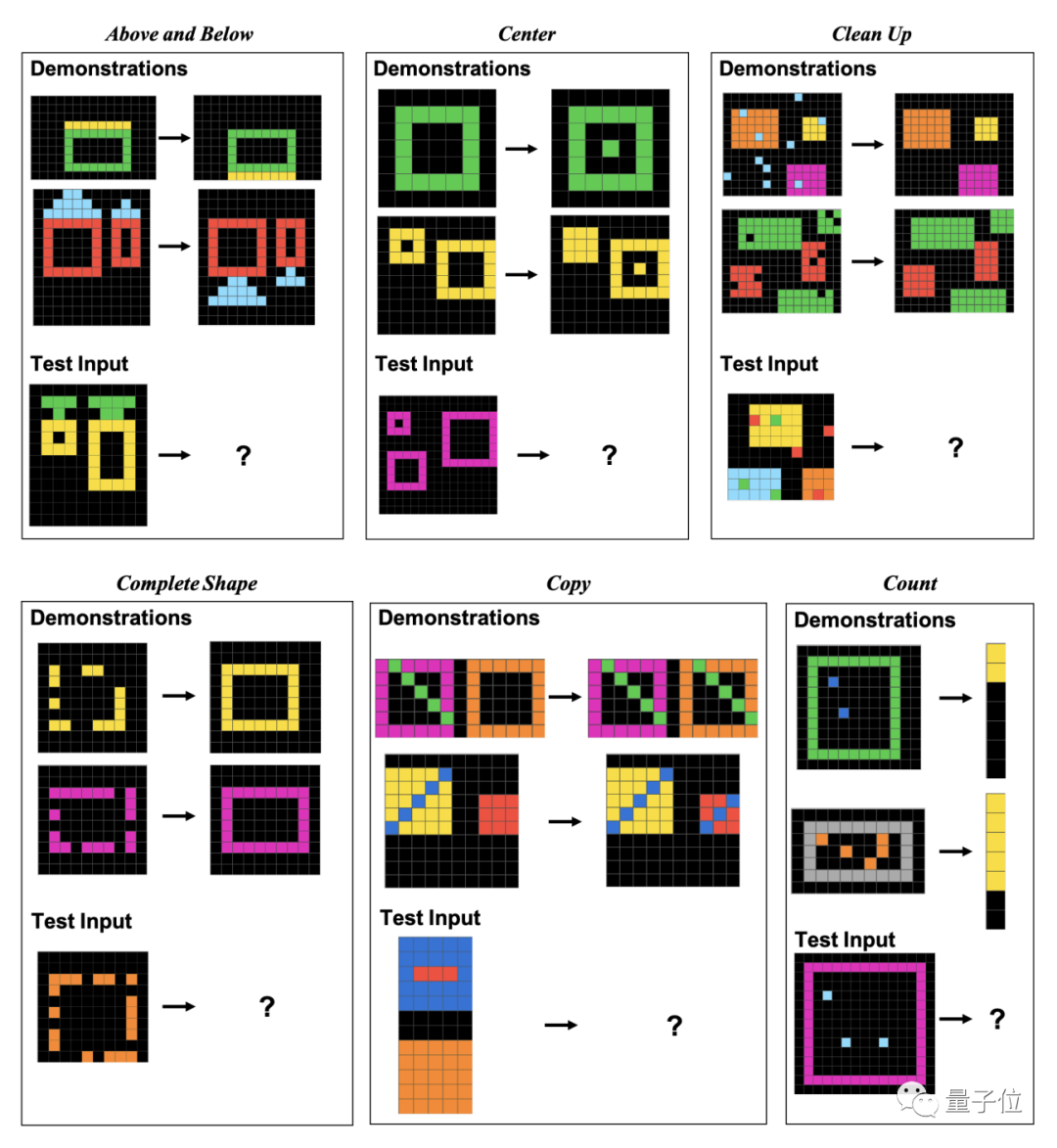

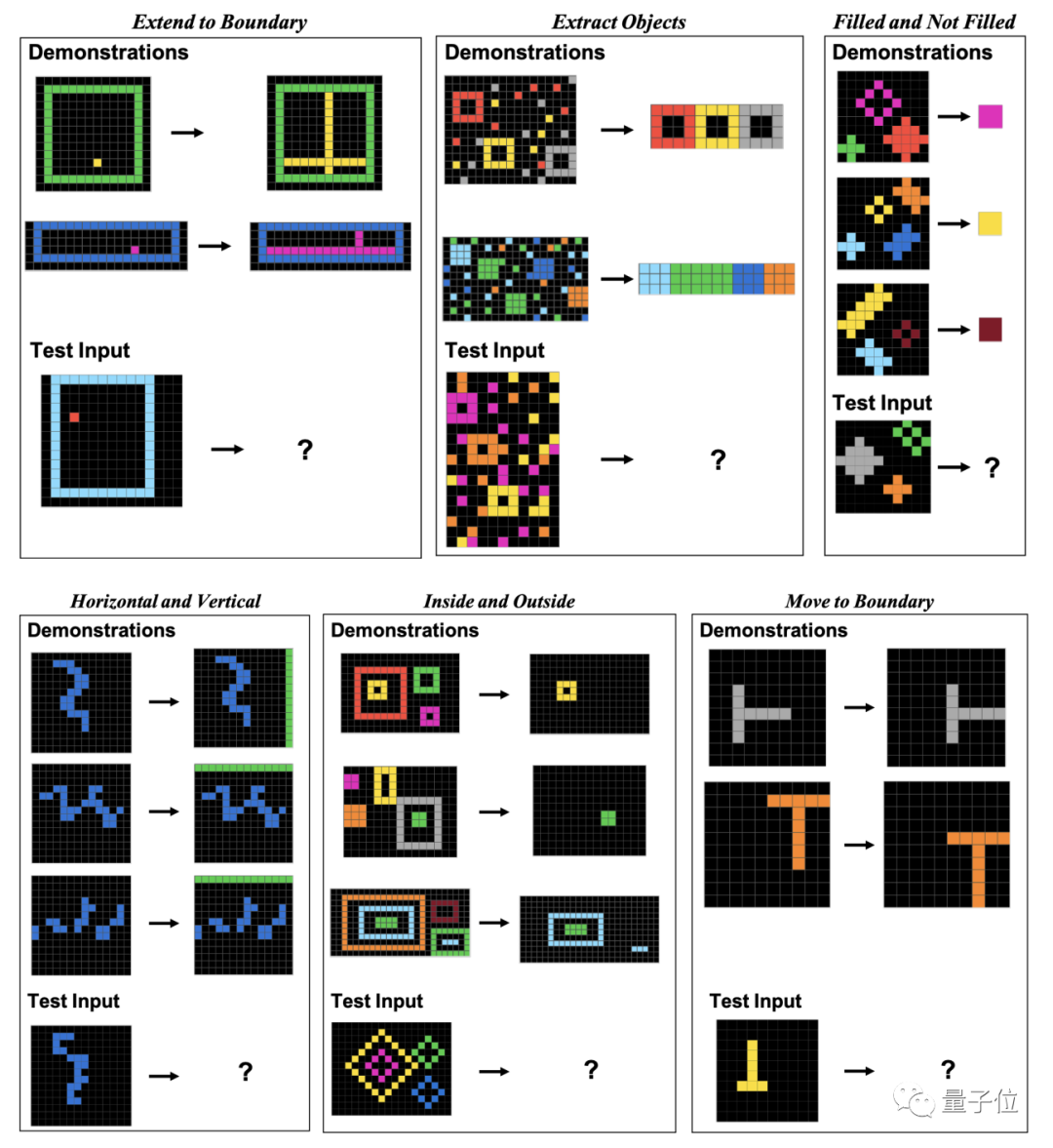

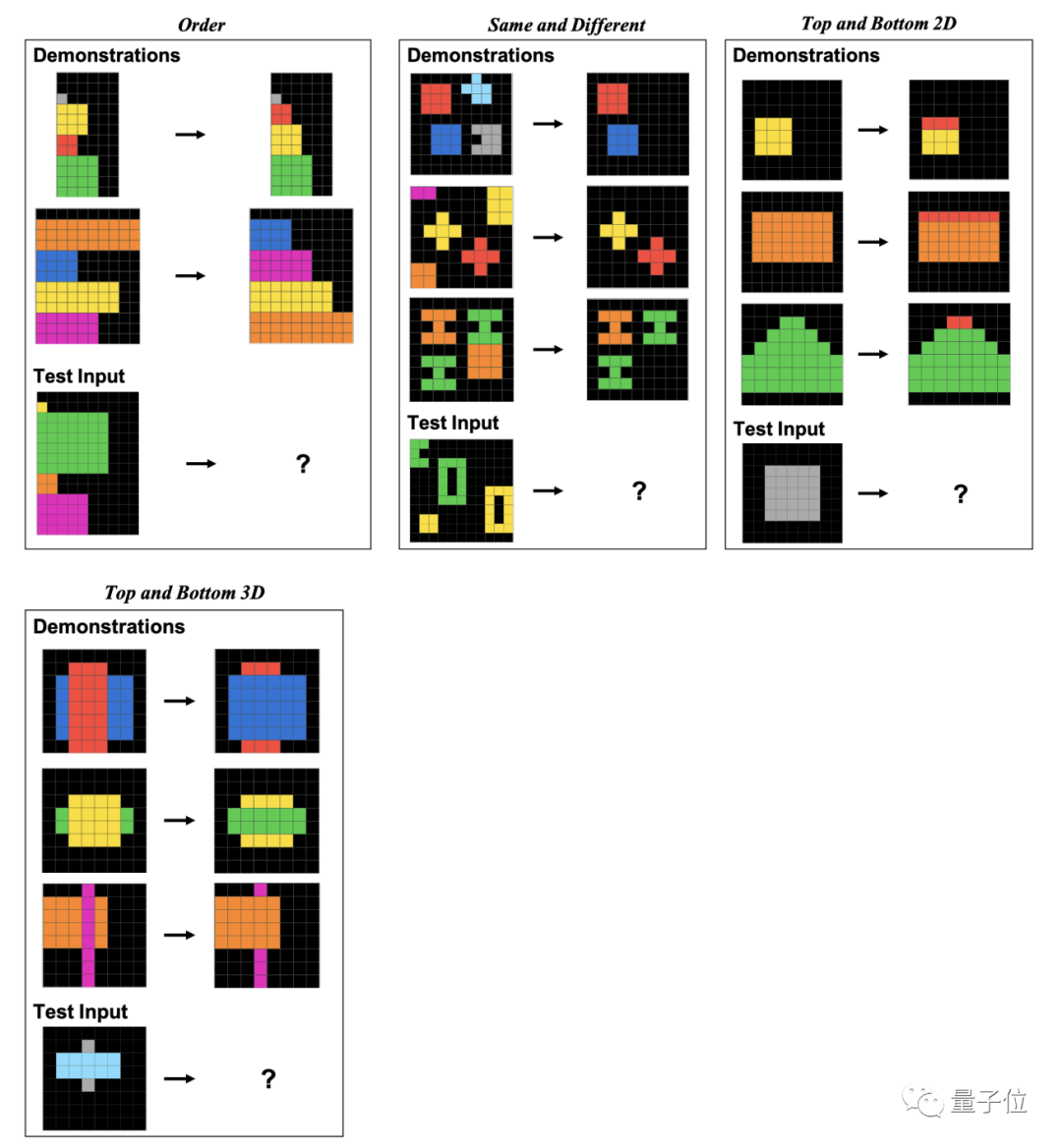

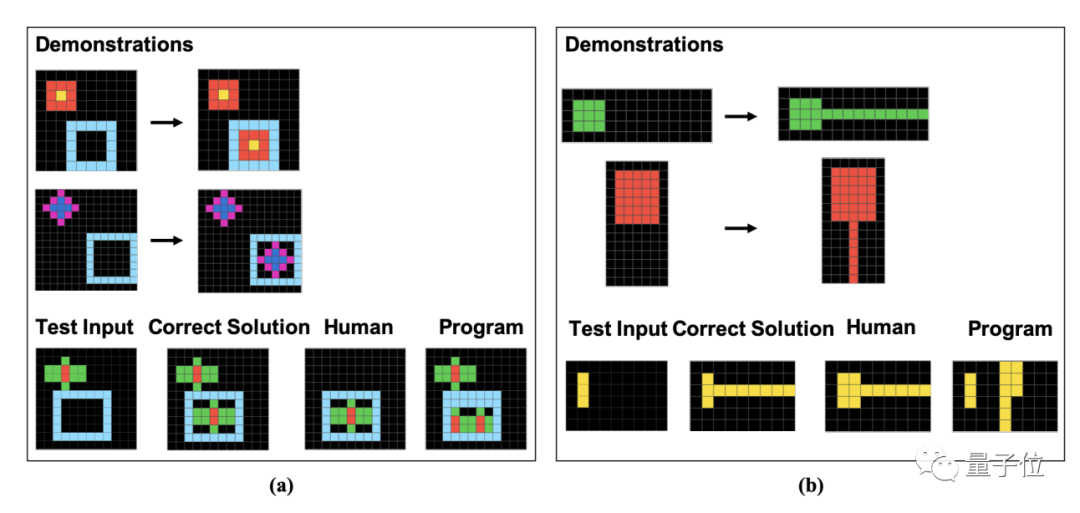

Untuk menilai prestasi manusia dan GPT-4 terhadap masalah grafik ini, para penyelidik menggunakan set data ConceptARC yang dilancarkan pada Mei tahun iniConceptARC merangkumi sejumlah 16 subkategori Soalan penaakulan grafik

, 30 soalan setiap kategori, 480 soalan kesemuanya.

16 subkategori ini termasuk perhubungan kedudukan, bentuk, operasi, perbandingan, dll.

Secara khusus, soalan ini terdiri daripada blok piksel. Manusia dan GPT perlu mencari corak berdasarkan contoh yang diberikan dan menganalisis hasil imej yang diproses dengan cara yang sama

Pengarang secara khusus menunjukkan contoh 16 subkategori ini dalam kertas, satu untuk setiap kategori.

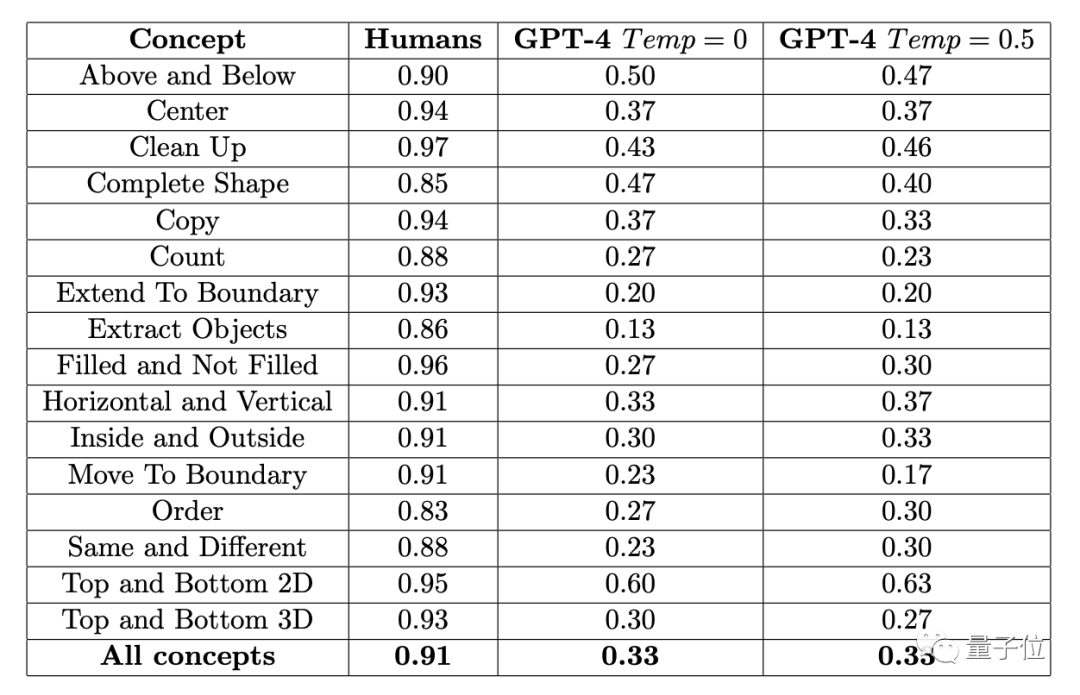

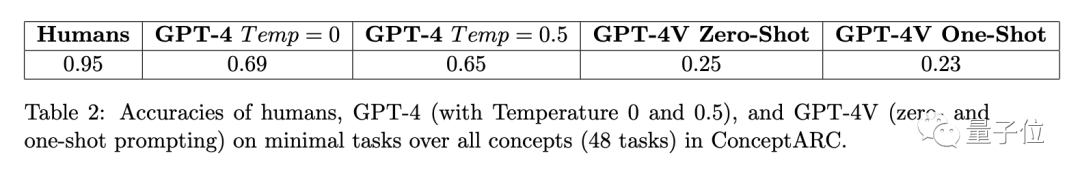

Hasil kajian menunjukkan purata kadar ketepatan 451 subjek manusia adalah tidak kurang daripada 83% dalam setiap sub-item, dan purata 16 tugasan mencapai 91%.

Dalam kes di mana anda boleh mencuba soalan tiga kali (jika anda betul sekali), ketepatan tertinggi GPT-4 (sampel tunggal) tidak melebihi 60%, dan purata hanya 33%

Pagi Beberapa ketika dahulu, pengarang ConceptARC Benchmark yang terlibat dalam eksperimen ini juga menjalankan eksperimen yang sama, tetapi ujian sampel sifar

telah dijalankan dalam GPT-4 Hasilnya, kadar ketepatan purata 16 tugasan adalah hanya 19%.

GPT-4v ialah model pelbagai mod, tetapi ketepatannya rendah. Pada set data ConceptARC berskala kecil yang terdiri daripada 48 soalan, kadar ketepatan ujian sampel sifar dan ujian sampel tunggal masing-masing hanya 25% dan 23%

Setelah menganalisis lebih lanjut jawapan yang salah, penyelidik mendapati Sesetengah kesilapan manusia nampaknya berpunca daripada "kecuaian", manakala GPT langsung tidak memahami peraturan soalan

.

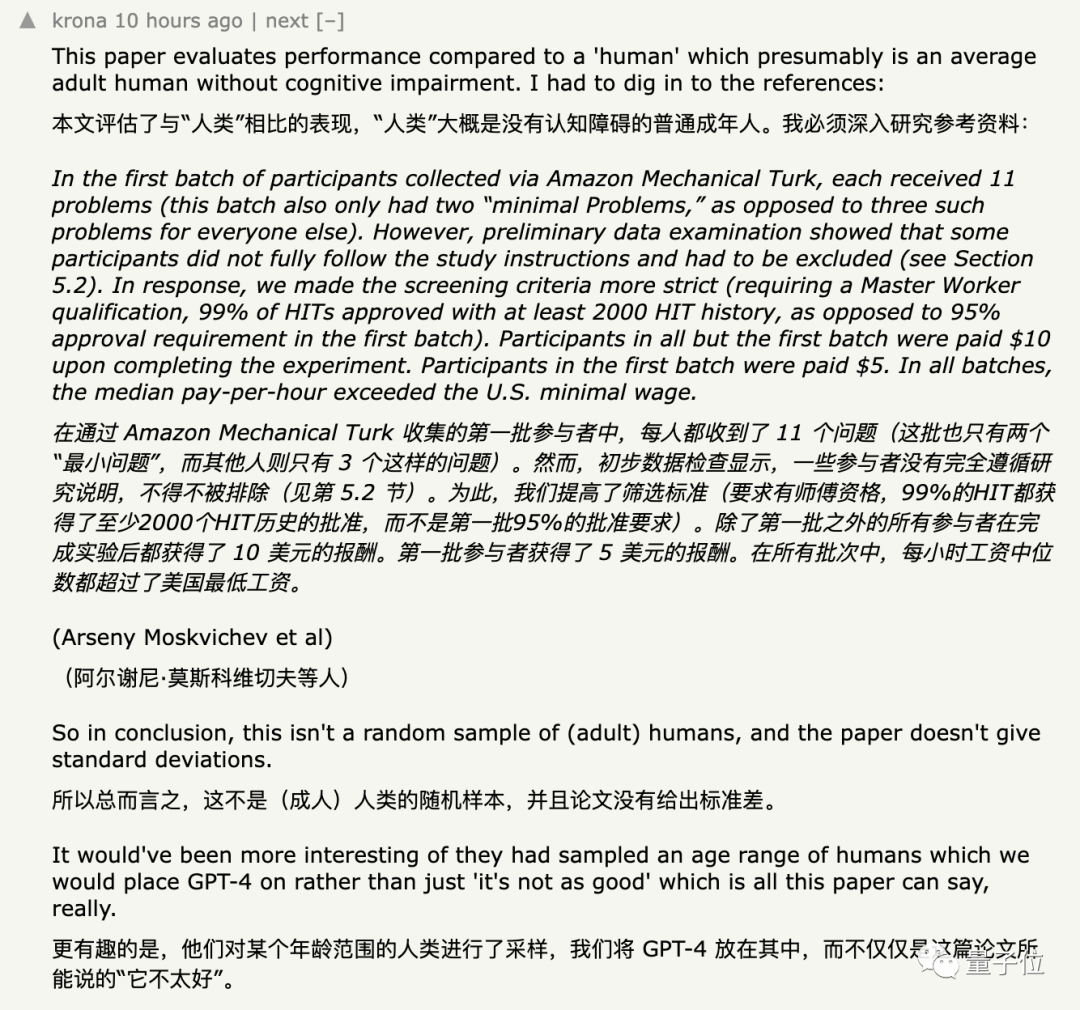

Kebanyakan netizen tidak ragu-ragu tentang data ini, tetapi apa yang menyebabkan eksperimen ini dipersoalkan adalah kumpulan subjek yang diambil dan kaedah input yang diberikan kepada GPT

Kaedah pemilihan subjek dipersoalkan

Pada mulanya, peserta kajian merekrut subjek pada platform sumber ramai Amazon.

Pengkaji mengekstrak beberapa soalan mudah daripada set data sebagai ujian pengenalan Subjek perlu menjawab sekurang-kurangnya dua daripada 3 soalan rawak dengan betul sebelum memasuki ujian formal.

Hasil yang ditemui oleh penyelidik menunjukkan bahawa sesetengah orang hanya mengambil ujian kemasukan untuk tujuan tamak wang, dan tidak menyelesaikan soalan seperti yang dikehendaki sama sekali

Sebagai langkah terakhir, penyelidikmeningkatkan ambang untuk mengambil ujianke tahap di mana mereka boleh diselesaikan di platform Lulus tidak kurang daripada 2,000 tugasan, dan kadar lulus mesti mencapai 99%.

Namun, walaupun penulis menggunakan kadar lulus untuk menyaring orang, dari segi kebolehan tertentu, selain daripada keperluan subjek untuk mengetahui bahasa Inggeris, "tiada syarat khas" untuk kebolehan profesional lain seperti grafik.

Untuk mencapai kepelbagaian data, para penyelidik memindahkan usaha pengambilan ke platform penyumberan ramai yang lain kemudian dalam percubaan. Pada akhirnya, seramai 415 subjek telah mengambil bahagian dalam eksperimen ini

Namun, sesetengah orang masih mempersoalkan bahawa sampel dalam eksperimen itu adalah "tidak cukup rawak".

Sesetengah netizen menyatakan bahawa pada platform sumber ramai Amazon yang digunakan oleh penyelidik untuk merekrut subjek, terdapat model besar yang berpura-pura menjadi manusia. .

Tetapi untuk versi teks biasa GPT-4 (0613) tanpa pelbagai mod, anda perlu menukar imej kepada titik grid, gunakan nombor dan bukannya warna

gunakan nombor dan bukannya warna

.

Sesetengah orang tidak bersetuju dengan operasi ini:

Selepas menukar imej kepada matriks digital, konsepnya telah berubah sepenuhnya Malah manusia, melihat "grafik" yang diwakili oleh nombor, bolehkah saya tidak boleh faham sama ada

One More Thing

Kebetulan, Joy Hsu, pelajar kedoktoran Cina di Universiti Stanford, turut menguji keupayaan pemahaman graf GPT-4v pada set data geometriTahun lepas, set data telah dikeluarkan bertujuan untuk Menguji pemahaman anda tentang geometri Euclidean dengan model besar. Selepas GPT-4v dibuka, Hsu menggunakan set data untuk mengujinya semula Hasilnya ialah GPT-4v seolah-olah memahami grafik "sangat berbeza daripada manusia."

Dari segi data, GPT-4v jelas lebih rendah daripada manusia dalam menjawab soalan geometri ini

Dari segi data, GPT-4v jelas lebih rendah daripada manusia dalam menjawab soalan geometri ini

Alamat kertas:

[1]https://arxiv.org/abs/71420 ]https ://arxiv.org/abs/2311.09247Atas ialah kandungan terperinci GPT-4 berprestasi buruk dalam inferens graf? Walaupun selepas 'melepaskan air', kadar ketepatan hanya 33%. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!