Rumah >Peranti teknologi >AI >Lima model utama AI generatif: VAEs, GANs, Diffusion, Transformers, NeRFs

Lima model utama AI generatif: VAEs, GANs, Diffusion, Transformers, NeRFs

- PHPzke hadapan

- 2023-11-20 17:30:473605semak imbas

Memilih model GenAI yang betul untuk tugas memerlukan pemahaman teknologi yang digunakan oleh setiap model dan keupayaan khususnya Sila pelajari tentang lima model GenAI VAE, GAN, Diffusion, Transformers dan NerF di bawah.

Sebelum ini, kebanyakan model AI menumpukan pada pemprosesan, menganalisis dan mentafsir data yang lebih baik. Sehingga baru-baru ini, penemuan dalam model rangkaian saraf generatif telah membawa kepada pelbagai alat baharu untuk mencipta semua jenis kandungan, daripada foto dan lukisan kepada puisi, kod, lakon layar dan filem.

Ikhtisar Model Generatif AI Teratas

Pada pertengahan 2010-an, penyelidik menemui prospek baharu untuk model AI generatif. Pada masa itu, mereka membangunkan autoenkoder variasi (VAE), rangkaian adversarial generatif (GAN), dan model resapan (Difusi). Transformers, yang diperkenalkan pada 2017, merupakan rangkaian neural yang terobosan yang mampu menganalisis set data besar pada skala untuk mencipta model bahasa besar (LLM) secara automatik. Menjelang 2020, penyelidik memperkenalkan teknologi Neural Radiation Field (NeRF), yang boleh menjana kandungan 2D daripada imej 3D

Pembangunan pesat model generatif ini sedang dalam proses apabila penyelidik menyesuaikan Ia sering membawa kepada peningkatan yang besar, dan yang luar biasa. kemajuan tidak menjadi perlahan. Profesor White berkata di University of California, Berkeley: "Seni bina model sentiasa berubah, dan seni bina model baharu akan terus dibangunkan

Setiap model mempunyai keupayaan istimewanya pada masa ini, model penyebaran (Difusi). digunakan dalam imej dan video Medan sintesis berprestasi sangat baik, Transformer berprestasi baik dalam medan teks, dan GAN pandai menambah set data kecil dengan sampel sintetik yang munasabah. Tetapi memilih model terbaik sentiasa bergantung pada kes penggunaan tertentu.

Semua model adalah berbeza dan penyelidik AI dan jurutera ML (pembelajaran mesin) mesti memilih yang sesuai untuk kes penggunaan yang sesuai dan prestasi yang diperlukan, dengan mengambil kira kemungkinan had model dari segi pengiraan, memori dan had modal .

Model penukar khususnya telah menyumbang kepada kemajuan dan keterujaan terkini dalam model generatif. Adnan Masood, ketua arkitek AI di UST Digital Transformation Consulting, berkata: "Penemuan terkini dalam model AI datang daripada pra-latihan pada sejumlah besar data dan menggunakan pembelajaran diselia sendiri untuk melatih model tanpa label yang jelas

Untuk contoh , keluarga model penukar pra-latihan generatif OpenAI adalah antara yang terbesar dan paling berkuasa dalam kategori itu. Antaranya, model GPT-3 mengandungi 17.5 bilion parameter

Aplikasi utama model AI generatif teratas

Masood menjelaskan bahawa model AI generatif teratas menggunakan pelbagai teknologi dan kaedah yang berbeza untuk menjana data baharu . Ciri dan kegunaan utama model ini termasuk:

- VAE menggunakan seni bina penyahkod pengekod untuk menjana data baharu, yang biasa digunakan untuk penjanaan imej dan video, seperti menjana muka sintetik untuk perlindungan privasi.

- GAN menggunakan penjana dan diskriminasi untuk menjana data baharu, sering digunakan dalam pembangunan permainan video untuk mencipta watak permainan yang realistik.

- Resapan menambah dan kemudian mengalih keluar hingar untuk menghasilkan imej berkualiti tinggi dengan perincian tahap tinggi, menghasilkan imej pemandangan semula jadi yang hampir realistik.

- Transformer dengan cekap memproses data berurutan secara selari untuk terjemahan mesin, ringkasan teks dan penciptaan imej.

- NeRF menyediakan pendekatan baharu kepada pembinaan semula pemandangan 3D menggunakan perwakilan saraf.

Mari kita semak setiap kaedah dengan lebih terperinci di bawah.

VAE

VAE telah dibangunkan pada 2014 untuk menggunakan rangkaian saraf untuk mengekod data dengan lebih cekap

Yael Lev, ketua AI di Sisense, berkata platform analisis maklumat kecerdasan buatan VAE lebih berkesan dipelajari. VAE terdiri daripada dua bahagian: pengekod yang memampatkan data dan penyahkod yang memulihkan data kepada bentuk asalnya. Ia bagus untuk menjana kejadian baharu daripada maklumat yang lebih kecil, membaiki imej atau data yang bising, mengesan kandungan anomali dalam data dan mengisi maklumat yang hilang

Walau bagaimanapun, pengekod auto variasi (VAE) juga cenderung menghasilkan imej yang kabur atau berkualiti rendah, menurut Masood UST. Masalah lain ialah ruang terpendam berdimensi rendah yang digunakan untuk menangkap struktur data adalah kompleks dan mencabar. Kelemahan ini mungkin mengehadkan keberkesanan VAE dalam aplikasi yang memerlukan imej berkualiti tinggi atau pemahaman yang jelas tentang ruang terpendam. Lelaran VAE seterusnya berkemungkinan akan menumpukan pada meningkatkan kualiti data yang dijana, mempercepatkan latihan dan meneroka kebolehgunaannya pada data jujukan angka. GAN mengadu rangkaian saraf yang menjana kandungan sebenar terhadap rangkaian saraf yang mengesan kandungan palsu. Anand Rao, peneraju AI global di PwC, berkata: "Secara beransur-ansur, kedua-dua rangkaian bergabung untuk menghasilkan imej terjana yang tidak dapat dibezakan daripada data asal

GAN biasanya digunakan untuk penjanaan imej, penyuntingan imej, resolusi super." , penambahan data, pemindahan gaya, penjanaan muzik dan penciptaan deepfake. Satu masalah dengan GAN ialah mereka boleh mengalami keruntuhan mod, di mana penjana menghasilkan output terhad dan berulang, menjadikannya sukar untuk dilatih. Masood berkata generasi GAN akan datang akan menumpukan pada meningkatkan kestabilan dan penumpuan proses latihan, memperluaskan kebolehgunaannya kepada bidang lain, dan membangunkan metrik penilaian yang lebih berkesan. GAN juga sukar untuk dioptimumkan dan distabilkan, dan tiada kawalan yang jelas ke atas sampel yang dihasilkan.

GAN biasanya digunakan untuk penjanaan imej, penyuntingan imej, resolusi super." , penambahan data, pemindahan gaya, penjanaan muzik dan penciptaan deepfake. Satu masalah dengan GAN ialah mereka boleh mengalami keruntuhan mod, di mana penjana menghasilkan output terhad dan berulang, menjadikannya sukar untuk dilatih. Masood berkata generasi GAN akan datang akan menumpukan pada meningkatkan kestabilan dan penumpuan proses latihan, memperluaskan kebolehgunaannya kepada bidang lain, dan membangunkan metrik penilaian yang lebih berkesan. GAN juga sukar untuk dioptimumkan dan distabilkan, dan tiada kawalan yang jelas ke atas sampel yang dihasilkan.

Diffusion

Model resapan telah dibangunkan pada tahun 2015 oleh pasukan penyelidik di Universiti Stanford untuk mensimulasikan dan menyongsangkan entropi dan bunyi. Teknik resapan menyediakan cara untuk memodelkan fenomena seperti cara bahan seperti garam meresap ke dalam cecair dan kemudian membalikkannya Model yang sama ini juga membantu menjana kandungan baharu daripada imej kosong.

Model penyebaran kini merupakan pilihan pertama untuk penjanaan imej, ia adalah model asas untuk perkhidmatan penjanaan imej popular, seperti Dall-E 2, Stable Diffusion, Midjourney dan Imagen. Ia juga digunakan dalam saluran paip untuk menjana pertuturan, video dan kandungan 3D. Selain itu, teknik resapan boleh digunakan untuk imputasi data, di mana data yang hilang diramalkan dan dijana

Model penyebaran kini merupakan pilihan pertama untuk penjanaan imej, ia adalah model asas untuk perkhidmatan penjanaan imej popular, seperti Dall-E 2, Stable Diffusion, Midjourney dan Imagen. Ia juga digunakan dalam saluran paip untuk menjana pertuturan, video dan kandungan 3D. Selain itu, teknik resapan boleh digunakan untuk imputasi data, di mana data yang hilang diramalkan dan dijana

Banyak aplikasi menggandingkan model resapan dengan LLM untuk penjanaan teks-ke-imej atau teks-ke-video. Sebagai contoh, Stable Diffusion 2 menggunakan model pra-latihan imej bahasa kontras sebagai pengekod teks, dan ia juga menambah model untuk kedalaman dan penskalaan.

Masood meramalkan bahawa penambahbaikan lanjut pada model seperti resapan stabil mungkin tertumpu pada penambahbaikan isyarat negatif, meningkatkan keupayaan untuk menjana imej dalam gaya artis tertentu dan menambah baik imej selebriti.

Transformers

Model Transformer telah dibangunkan pada 2017 oleh pasukan di Google Brain untuk menambah baik terjemahan bahasa. Model ini bagus untuk memproses maklumat dalam susunan yang berbeza dan boleh memproses data secara selari, sambil turut memanfaatkan data tidak berlabel untuk dijadikan skala kepada model besar

Kandungan ditulis semula: Teknik ini boleh digunakan pada ringkasan teks, chatbots , enjin cadangan, terjemahan bahasa , pangkalan pengetahuan, pengesyoran diperibadikan (melalui model keutamaan), analisis sentimen dan pengiktirafan entiti bernama untuk mengenal pasti orang, tempat dan benda. Selain itu, ia boleh digunakan dalam pengecaman pertuturan, seperti teknologi Whisper OpenAI, serta dalam bidang seperti pengesanan objek dalam video dan imej, kapsyen imej, klasifikasi teks dan penjanaan dialog

Walaupun serba boleh,

TransformersHad memang wujud. Mereka boleh mahal untuk dilatih dan memerlukan set data yang besar. Model yang terhasil juga agak besar, menjadikannya mencabar untuk mengenal pasti sumber bias atau keputusan yang tidak tepat. "Kerumitan mereka juga menyukarkan untuk menjelaskan kerja dalaman mereka, menghalang kebolehtafsiran dan ketelusan mereka," kata Massoud

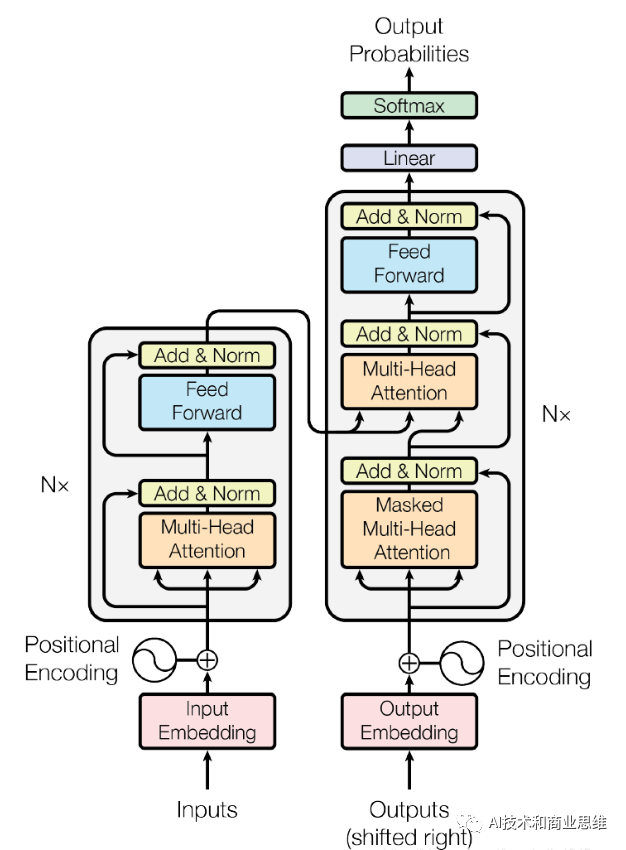

Transformer Model Architecture

NeRF

telah dibangunkan dalam 30 RF. perwakilan medan cahaya ke dalam rangkaian saraf, pelaksanaan pertama adalah sangat perlahan, mengambil masa beberapa hari untuk menangkap imej 3D pertama

telah dibangunkan dalam 30 RF. perwakilan medan cahaya ke dalam rangkaian saraf, pelaksanaan pertama adalah sangat perlahan, mengambil masa beberapa hari untuk menangkap imej 3D pertama

Walau bagaimanapun, pada tahun 2022, penyelidik di NVIDIA menemui cara untuk menjana model baharu dalam masa kira-kira 30 saat. Model ini boleh mewakili objek 3D dalam unit beberapa megabait dengan kualiti yang setanding manakala teknologi lain mungkin memerlukan gigabait. Model ini berjanji untuk membawa kepada teknik yang lebih cekap untuk menangkap dan menjana objek 3D dalam Metaverse. Pengarah penyelidikan Nvidia Alexander Keller berkata bahawa NeRF akhirnya mungkin sama pentingnya dengan grafik 3D seperti kamera digital untuk fotografi moden

Masood berkata bahawa NeRF mempunyai aplikasi penting dalam robotik, pemetaan bandar dan navigasi autonomi dan aplikasi realiti maya potensi. Walau bagaimanapun, NERF kekal mahal dari segi pengiraan dan menggabungkan berbilang NERF ke dalam pemandangan yang lebih besar adalah satu-satunya kes penggunaan yang berdaya maju untuk NeRF hari ini adalah untuk menukar imej kepada objek atau pemandangan 3D. Walaupun had ini, Masood meramalkan bahawa NeRF akan mencari peranan baharu dalam tugas pemprosesan imej asas seperti penyahnotaan, penyahkaburan, pensampelan naik, pemampatan dan penyuntingan imej

Apa yang penting semasa ekosistem GenAI meneruskan

Penting untuk ambil perhatian bahawa model ini sedang dalam proses, dan penyelidik sedang mencari cara untuk menambah baik model individu dan menggabungkannya dengan model dan teknik pemprosesan lain. Lev meramalkan bahawa model generatif akan menjadi lebih serba boleh, aplikasi akan berkembang melangkaui domain tradisional dan pengguna akan dapat membimbing model AI dengan lebih berkesan dan memahami cara ia berfungsi dengan lebih baik.

Terdapat juga kerja yang sedang dijalankan pada model multimodal yang menggunakan kaedah dapatkan semula untuk memanggil perpustakaan model yang dioptimumkan untuk tugasan tertentu. Beliau juga berharap model generatif akan dapat membangunkan keupayaan lain, seperti membuat panggilan API dan menggunakan alat luaran Sebagai contoh, LLM yang diperhalusi berdasarkan pengetahuan pusat panggilan syarikat akan memberikan jawapan kepada soalan dan melakukan penyelesaian masalah, seperti. sebagai menetapkan semula modem pelanggan atau apabila masalah telah diselesaikan.

Malah, mungkin ada sesuatu yang lebih cekap untuk menggantikan seni bina model popular masa kini pada masa hadapan. "Apabila seni bina baharu muncul, model Diffusion dan Transformer mungkin tidak lagi berguna, " kata White kami melihat ini dengan pengenalan Diffusion, kerana pendekatan mereka terhadap aplikasi bahasa semula jadi tidak kondusif untuk algoritma memori jangka pendek dan saraf berulang. networks. (RNN)

Sesetengah orang meramalkan bahawa ekosistem AI generatif akan berkembang menjadi model tiga lapisan. Lapisan asas ialah satu siri model asas berdasarkan teks, imej, pertuturan dan kod Model ini menyerap sejumlah besar data dan dibina pada model pembelajaran mendalam yang besar, digabungkan dengan pertimbangan manusia. Seterusnya, model domain khusus industri dan fungsi akan meningkatkan penjagaan kesihatan, undang-undang atau jenis pemprosesan data lain. Di peringkat atasan, syarikat akan membina model proprietari menggunakan data proprietari dan kepakaran subjek. Tiga lapisan ini akan mengganggu cara pasukan membangunkan model dan menyambut era baharu model sebagai perkhidmatan

Cara memilih model AI generatif: Pertimbangan teratas

Antara model, menurut pertimbangan Lev Top Sisense apabila memilih termasuk berikut:

Masalah yang ingin anda selesaikan. Pilih model yang diketahui sesuai untuk tugas khusus anda. Contohnya, gunakan transformer untuk tugasan bahasa dan NeRF untuk adegan 3D.

Kuantiti dan kualiti data. Penyebaran memerlukan banyak data yang baik untuk berfungsi dengan betul, manakala VAE berfungsi lebih baik dengan kurang data.

Kualiti hasil. GAN lebih baik untuk imej yang jelas dan terperinci, manakala VAE lebih baik untuk hasil yang lebih lancar.

Betapa mudahnya untuk melatih model. GAN boleh menjadi sukar untuk dilatih, manakala VAE dan Diffusion lebih mudah.

Mengira keperluan sumber. NeRF dan Diffusion kedua-duanya memerlukan banyak kuasa komputer untuk berfungsi dengan baik.

memerlukan kawalan dan pemahaman. Jika anda mahukan lebih kawalan ke atas hasil atau pemahaman yang lebih baik tentang cara model berfungsi, VAE mungkin lebih baik daripada GAN.

Atas ialah kandungan terperinci Lima model utama AI generatif: VAEs, GANs, Diffusion, Transformers, NeRFs. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!