Peranti teknologi

Peranti teknologi AI

AI S-LoRA: Ada kemungkinan untuk menjalankan beribu-ribu model besar pada satu GPU

S-LoRA: Ada kemungkinan untuk menjalankan beribu-ribu model besar pada satu GPUSecara amnya, penggunaan model bahasa besar biasanya menggunakan kaedah "pra-latihan-penalaan-halus". Walau bagaimanapun, apabila memperhalusi model asas untuk pelbagai tugas (seperti pembantu peribadi), kos latihan dan servis menjadi sangat tinggi. Penyesuaian Pangkat Rendah (LoRA) ialah kaedah penalaan halus parameter yang cekap, yang biasanya digunakan untuk menyesuaikan model asas kepada berbilang tugas, dengan itu menjana sejumlah besar penyesuai LoRA terbitan

Ditulis semula: Inferens kelompok memberikan banyak peluang semasa penyajian, dan corak ini telah ditunjukkan untuk mencapai prestasi yang setanding dengan penalaan halus penuh dengan penalaan halus pemberat penyesuai. Walaupun pendekatan ini mendayakan inferens penyesuai tunggal berkependaman rendah dan pelaksanaan bersiri merentas penyesuai, pendekatan ini mengurangkan daya pemprosesan keseluruhan perkhidmatan dengan ketara dan meningkatkan kependaman keseluruhan apabila menyediakan berbilang penyesuai secara serentak. Oleh itu, cara menyelesaikan masalah perkhidmatan berskala besar bagi varian yang diperhalusi ini masih tidak diketahui

Baru-baru ini, penyelidik dari UC Berkeley, Stanford dan universiti lain mencadangkan kaedah penalaan halus baharu yang dipanggil S-LoRA dalam kertas kerja

- Alamat kertas: https://arxiv.org/pdf/2311.03285.pdf

- Alamat projek: https://github.com/S-LoRA/S-LoRA

S-LoRA ialah sistem yang direka untuk penyajian berskala bagi banyak penyesuai LoRA. Ia menyimpan semua penyesuai dalam memori utama dan mengambil penyesuai yang digunakan oleh pertanyaan yang sedang dijalankan ke dalam memori GPU.

S-LoRA mencadangkan teknologi "Unified Paging", yang menggunakan kumpulan memori bersatu untuk mengurus tahap pemberat penyesuai dinamik yang berbeza dan tensor cache KV dengan panjang jujukan yang berbeza. Selain itu, S-LoRA menggunakan strategi selari tensor baharu dan kernel CUDA tersuai yang sangat dioptimumkan untuk membolehkan pemprosesan kumpulan heterogen pengiraan LoRA.

Ciri-ciri ini membolehkan S-LoRA menyediakan beribu-ribu penyesuai LoRA pada GPU tunggal atau berbilang pada sebahagian kecil daripada kos (menyediakan 2000 penyesuai serentak) dan meminimumkan kos pengiraan LoRA tambahan. Sebagai perbandingan, vLLM-packed perlu mengekalkan berbilang salinan pemberat dan hanya boleh menyediakan kurang daripada 5 penyesuai kerana had memori GPU

Berbanding dengan terkini seperti HuggingFace PEFT dan vLLM (hanya menyokong perkhidmatan LoRA ) Berbanding dengan perpustakaan, S-LoRA boleh meningkatkan daya pengeluaran sehingga 4 kali ganda, dan bilangan penyesuai yang disampaikan boleh ditingkatkan dengan beberapa urutan magnitud. Oleh itu, S-LoRA mampu menyediakan perkhidmatan berskala untuk banyak model penalaan halus khusus tugas dan menawarkan potensi untuk penyesuaian berskala besar perkhidmatan penalaan halus.

S-LoRA mengandungi tiga bahagian inovatif utama. Bahagian 4 memperkenalkan strategi kelompok yang digunakan untuk menguraikan pengiraan antara model asas dan penyesuai LoRA. Di samping itu, para penyelidik juga menyelesaikan cabaran penjadualan permintaan, termasuk aspek seperti pengelompokan penyesuai dan kawalan kemasukan. Keupayaan untuk membatch merentas penyesuai serentak membawa cabaran baharu kepada pengurusan memori. Pada bahagian kelima, penyelidik mempromosikan PagedAttention kepada Unfied Paging untuk menyokong pemuatan dinamik penyesuai LoRA. Pendekatan ini menggunakan kumpulan memori bersatu untuk menyimpan cache KV dan berat penyesuai dalam cara berhalaman, yang boleh mengurangkan pemecahan dan mengimbangi saiz cache KV dan berat penyesuai yang berubah secara dinamik. Akhir sekali, Bahagian 6 memperkenalkan strategi selari tensor baharu yang boleh memisahkan model asas dan penyesuai LoRA dengan cekap

Berikut ialah sorotan:

Pemprosesan kelompok

untuk penyesuai tunggal. (2021) mencadangkan kaedah yang disyorkan, iaitu menggabungkan pemberat penyesuai dengan pemberat model asas, menghasilkan model baharu (lihat Persamaan 1). Faedahnya ialah tiada overhed penyesuai tambahan semasa inferens kerana model baharu mempunyai bilangan parameter yang sama dengan model asas. Malah, ini juga merupakan ciri ketara karya LoRA asal

Artikel ini menunjukkan bahawa penggabungan penyesuai LoRA ke dalam model asas adalah tidak cekap untuk persediaan perkhidmatan pemprosesan tinggi berbilang LoRA. Sebaliknya, penyelidik mencadangkan untuk mengira LoRA dalam masa nyata untuk mengira xAB (seperti ditunjukkan dalam Persamaan 2).

Dalam S-LoRA, pengiraan model asas dikumpulkan dan kemudian xAB tambahan dilakukan untuk semua penyesuai secara individu menggunakan kernel CUDA tersuai. Proses ini ditunjukkan dalam Rajah 1. Daripada menggunakan padding dan inti GEMM berkumpulan daripada perpustakaan BLAS untuk mengira LoRA, kami melaksanakan kernel CUDA tersuai untuk mencapai pengiraan yang lebih cekap tanpa padding, butiran pelaksanaan terdapat dalam subseksyen 5.3.

Jika penyesuai LoRA disimpan dalam ingatan utama, bilangannya mungkin besar, tetapi kumpulan sedang berjalan Bilangan Penyesuai LoRA yang diperlukan boleh dikawal kerana saiz kelompok dihadkan oleh memori GPU. Untuk memanfaatkan ini, kami menyimpan semua penyesuai LoRA dalam memori utama dan, apabila membuat kesimpulan untuk kumpulan yang sedang berjalan, ambil hanya penyesuai LoRA yang diperlukan untuk kumpulan itu ke dalam GPU RAM. Dalam kes ini, bilangan maksimum penyesuai yang boleh diservis dihadkan oleh saiz memori utama. Rajah 2 menggambarkan proses ini. Bahagian 5 juga membincangkan teknik untuk pengurusan ingatan yang cekap 🎜🎜#Melayani berbilang kad penyesuai LoRA secara serentak membawa cabaran pengurusan memori baharu berbanding dengan menyediakan model asas tunggal. Untuk menyokong berbilang penyesuai, S-LoRA menyimpannya dalam memori utama dan secara dinamik memuatkan berat penyesuai yang diperlukan untuk kumpulan yang sedang berjalan ke dalam RAM GPU.

#🎜🎜 #Unified Paging

Para penyelidik mengembangkan konsep PagedAttention kepada Unified Paging. Paging bersatu digunakan bukan sahaja untuk mengurus cache KV, tetapi juga untuk mengurus berat penyesuai. Paging bersatu menggunakan kumpulan memori bersatu untuk mengurus bersama cache KV dan berat penyesuai. Untuk mencapai matlamat ini, mereka mula-mula memperuntukkan penimbal besar secara statik ke kolam memori, yang menggunakan semua ruang yang ada kecuali ruang yang digunakan untuk menyimpan berat model asas dan tensor pengaktifan sementara. Cache KV dan berat penyesuai disimpan dalam kolam memori dengan cara berhalaman, dan setiap halaman sepadan dengan vektor H. Oleh itu, tensor cache KV dengan panjang jujukan S menduduki halaman S, manakala tensor berat LoRA peringkat R menduduki halaman R. Rajah 3 menunjukkan susun atur kolam memori, di mana cache KV dan pemberat penyesuai disimpan dalam cara bersilang dan tidak bersebelahan. Pendekatan ini sangat mengurangkan pemecahan dan memastikan tahap pemberat penyesuai yang berbeza boleh wujud bersama cache KV dinamik dengan cara yang berstruktur dan sistematik 🎜🎜#

Tensor parallelism#🎜🎜🎜## 🎜🎜# Selain itu, para penyelidik mereka bentuk strategi selari tensor baru untuk inferens LoRA kelompok untuk menyokong pelbagai transformasi model Transformer besar. Tensor parallelism ialah pendekatan selari yang paling banyak digunakan kerana program tunggal, paradigma berbilang data memudahkan pelaksanaan dan penyepaduannya dengan sistem sedia ada. Keselarian tensor boleh mengurangkan penggunaan memori dan kependaman bagi setiap GPU apabila menyediakan model besar. Dalam tetapan ini, penyesuai LoRA tambahan memperkenalkan matriks berat dan pendaraban matriks baharu, yang memerlukan strategi pembahagian baharu untuk penambahan ini.

evaluation#🎜🎜🎜🎜🎜🎜,#

evaluation #🎜🎜🎜🎜,##🎜 Menyediakan perkhidmatan untuk Llama-7B/13B/30B/70B untuk menilai S-LoRA LoRA boleh menyediakan beribu-ribu penyesuai LoRA pada satu GPU atau berbilang GPU dengan sedikit overhed. S-LoRA mencapai daya pemprosesan sehingga 30x lebih tinggi berbanding Huggingface PEFT, perpustakaan penalaan halus cekap parameter terkini. S-LoRA meningkatkan daya pemprosesan sebanyak 4x dan meningkatkan bilangan penyesuai perkhidmatan dengan beberapa susunan magnitud berbanding menggunakan sistem perkhidmatan pemprosesan tinggi vLLM yang menyokong perkhidmatan LoRA.

#🎜🎜🎜🎜,##🎜 Menyediakan perkhidmatan untuk Llama-7B/13B/30B/70B untuk menilai S-LoRA LoRA boleh menyediakan beribu-ribu penyesuai LoRA pada satu GPU atau berbilang GPU dengan sedikit overhed. S-LoRA mencapai daya pemprosesan sehingga 30x lebih tinggi berbanding Huggingface PEFT, perpustakaan penalaan halus cekap parameter terkini. S-LoRA meningkatkan daya pemprosesan sebanyak 4x dan meningkatkan bilangan penyesuai perkhidmatan dengan beberapa susunan magnitud berbanding menggunakan sistem perkhidmatan pemprosesan tinggi vLLM yang menyokong perkhidmatan LoRA.

Untuk butiran penyelidikan lanjut, sila rujuk kertas asal.

Atas ialah kandungan terperinci S-LoRA: Ada kemungkinan untuk menjalankan beribu-ribu model besar pada satu GPU. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

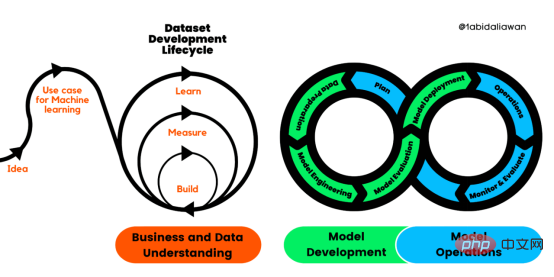

解读CRISP-ML(Q):机器学习生命周期流程Apr 08, 2023 pm 01:21 PM

解读CRISP-ML(Q):机器学习生命周期流程Apr 08, 2023 pm 01:21 PM译者 | 布加迪审校 | 孙淑娟目前,没有用于构建和管理机器学习(ML)应用程序的标准实践。机器学习项目组织得不好,缺乏可重复性,而且从长远来看容易彻底失败。因此,我们需要一套流程来帮助自己在整个机器学习生命周期中保持质量、可持续性、稳健性和成本管理。图1. 机器学习开发生命周期流程使用质量保证方法开发机器学习应用程序的跨行业标准流程(CRISP-ML(Q))是CRISP-DM的升级版,以确保机器学习产品的质量。CRISP-ML(Q)有六个单独的阶段:1. 业务和数据理解2. 数据准备3. 模型

人工智能的环境成本和承诺Apr 08, 2023 pm 04:31 PM

人工智能的环境成本和承诺Apr 08, 2023 pm 04:31 PM人工智能(AI)在流行文化和政治分析中经常以两种极端的形式出现。它要么代表着人类智慧与科技实力相结合的未来主义乌托邦的关键,要么是迈向反乌托邦式机器崛起的第一步。学者、企业家、甚至活动家在应用人工智能应对气候变化时都采用了同样的二元思维。科技行业对人工智能在创建一个新的技术乌托邦中所扮演的角色的单一关注,掩盖了人工智能可能加剧环境退化的方式,通常是直接伤害边缘人群的方式。为了在应对气候变化的过程中充分利用人工智能技术,同时承认其大量消耗能源,引领人工智能潮流的科技公司需要探索人工智能对环境影响的

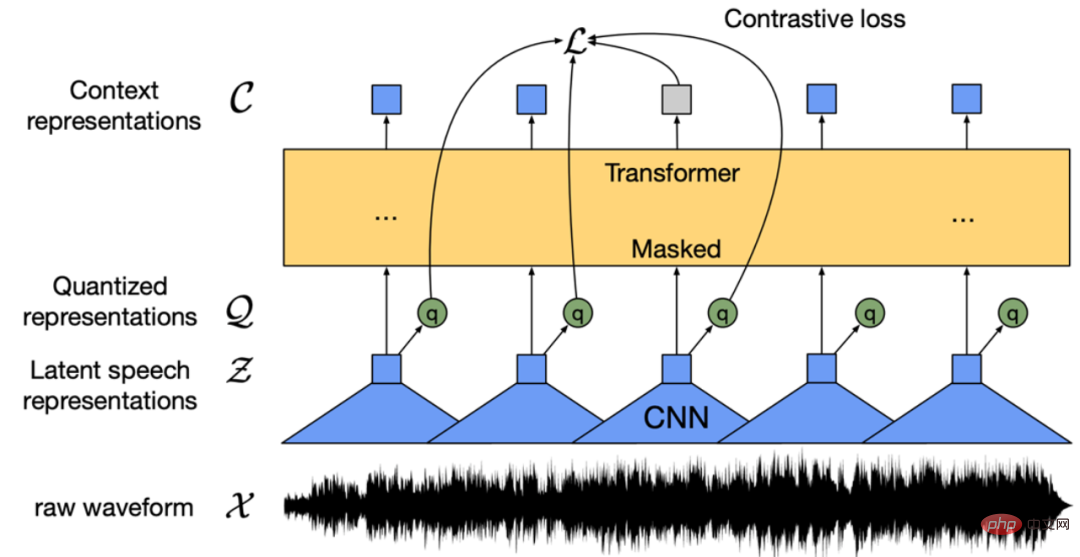

找不到中文语音预训练模型?中文版 Wav2vec 2.0和HuBERT来了Apr 08, 2023 pm 06:21 PM

找不到中文语音预训练模型?中文版 Wav2vec 2.0和HuBERT来了Apr 08, 2023 pm 06:21 PMWav2vec 2.0 [1],HuBERT [2] 和 WavLM [3] 等语音预训练模型,通过在多达上万小时的无标注语音数据(如 Libri-light )上的自监督学习,显著提升了自动语音识别(Automatic Speech Recognition, ASR),语音合成(Text-to-speech, TTS)和语音转换(Voice Conversation,VC)等语音下游任务的性能。然而这些模型都没有公开的中文版本,不便于应用在中文语音研究场景。 WenetSpeech [4] 是

条形统计图用什么呈现数据Jan 20, 2021 pm 03:31 PM

条形统计图用什么呈现数据Jan 20, 2021 pm 03:31 PM条形统计图用“直条”呈现数据。条形统计图是用一个单位长度表示一定的数量,根据数量的多少画成长短不同的直条,然后把这些直条按一定的顺序排列起来;从条形统计图中很容易看出各种数量的多少。条形统计图分为:单式条形统计图和复式条形统计图,前者只表示1个项目的数据,后者可以同时表示多个项目的数据。

自动驾驶车道线检测分类的虚拟-真实域适应方法Apr 08, 2023 pm 02:31 PM

自动驾驶车道线检测分类的虚拟-真实域适应方法Apr 08, 2023 pm 02:31 PMarXiv论文“Sim-to-Real Domain Adaptation for Lane Detection and Classification in Autonomous Driving“,2022年5月,加拿大滑铁卢大学的工作。虽然自主驾驶的监督检测和分类框架需要大型标注数据集,但光照真实模拟环境生成的合成数据推动的无监督域适应(UDA,Unsupervised Domain Adaptation)方法则是低成本、耗时更少的解决方案。本文提出对抗性鉴别和生成(adversarial d

数据通信中的信道传输速率单位是bps,它表示什么Jan 18, 2021 pm 02:58 PM

数据通信中的信道传输速率单位是bps,它表示什么Jan 18, 2021 pm 02:58 PM数据通信中的信道传输速率单位是bps,它表示“位/秒”或“比特/秒”,即数据传输速率在数值上等于每秒钟传输构成数据代码的二进制比特数,也称“比特率”。比特率表示单位时间内传送比特的数目,用于衡量数字信息的传送速度;根据每帧图像存储时所占的比特数和传输比特率,可以计算数字图像信息传输的速度。

数据分析方法有哪几种Dec 15, 2020 am 09:48 AM

数据分析方法有哪几种Dec 15, 2020 am 09:48 AM数据分析方法有4种,分别是:1、趋势分析,趋势分析一般用于核心指标的长期跟踪;2、象限分析,可依据数据的不同,将各个比较主体划分到四个象限中;3、对比分析,分为横向对比和纵向对比;4、交叉分析,主要作用就是从多个维度细分数据。

聊一聊Python 实现数据的序列化操作Apr 12, 2023 am 09:31 AM

聊一聊Python 实现数据的序列化操作Apr 12, 2023 am 09:31 AM在日常开发中,对数据进行序列化和反序列化是常见的数据操作,Python提供了两个模块方便开发者实现数据的序列化操作,即 json 模块和 pickle 模块。这两个模块主要区别如下:json 是一个文本序列化格式,而 pickle 是一个二进制序列化格式;json 是我们可以直观阅读的,而 pickle 不可以;json 是可互操作的,在 Python 系统之外广泛使用,而 pickle 则是 Python 专用的;默认情况下,json 只能表示 Python 内置类型的子集,不能表示自定义的

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Penyesuai Pelayan SAP NetWeaver untuk Eclipse

Integrasikan Eclipse dengan pelayan aplikasi SAP NetWeaver.

MinGW - GNU Minimalis untuk Windows

Projek ini dalam proses untuk dipindahkan ke osdn.net/projects/mingw, anda boleh terus mengikuti kami di sana. MinGW: Port Windows asli bagi GNU Compiler Collection (GCC), perpustakaan import yang boleh diedarkan secara bebas dan fail pengepala untuk membina aplikasi Windows asli termasuk sambungan kepada masa jalan MSVC untuk menyokong fungsi C99. Semua perisian MinGW boleh dijalankan pada platform Windows 64-bit.

Dreamweaver CS6

Alat pembangunan web visual

Versi Mac WebStorm

Alat pembangunan JavaScript yang berguna