Rumah >Peranti teknologi >AI >Nvidia mengeluarkan cip AI H200: prestasi melonjak sebanyak 90%, kelajuan inferens Llama 2 meningkat dua kali ganda

Nvidia mengeluarkan cip AI H200: prestasi melonjak sebanyak 90%, kelajuan inferens Llama 2 meningkat dua kali ganda

- 王林ke hadapan

- 2023-11-14 12:09:54988semak imbas

DoNews melaporkan pada 14 November bahawa NVIDIA mengeluarkan cip superkomputer kecerdasan buatan generasi akan datang pada masa Beijing ke-13 Cip ini akan memainkan peranan penting dalam pembelajaran mendalam dan model bahasa besar (LLM), seperti GPT-4 OpenAI.

Generasi cip baharu telah mencapai kemajuan yang ketara berbanding dengan generasi sebelumnya dan akan digunakan secara meluas dalam pusat data dan superkomputer untuk mengendalikan tugas yang kompleks seperti ramalan cuaca dan iklim, penyelidikan dan pembangunan dadah, serta pengkomputeran kuantum

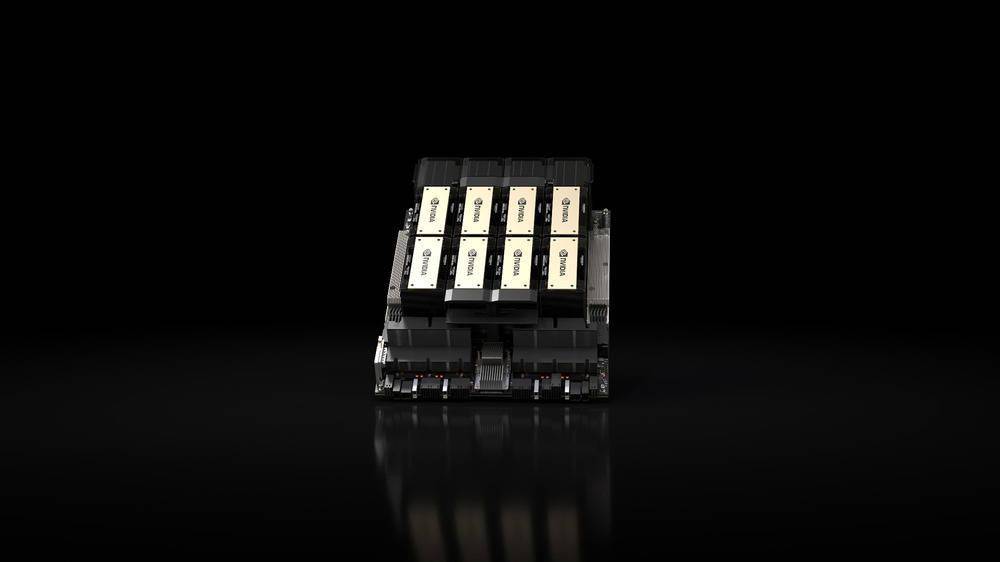

Produk utama yang dikeluarkan ialah GPU HGX H200 berdasarkan seni bina "Hopper" Nvidia, yang merupakan pengganti kepada GPU H100 dan merupakan cip pertama syarikat yang menggunakan memori HBM3e. Memori HBM3e mempunyai kelajuan yang lebih pantas dan kapasiti yang lebih besar, jadi ia sangat sesuai untuk aplikasi model bahasa yang besar

NVIDIA berkata: "Dengan teknologi HBM3e, kelajuan memori NVIDIA H200 mencapai 4.8TB sesaat, kapasiti ialah 141GB, hampir dua kali ganda berbanding A100, dan lebar jalur juga telah meningkat sebanyak 2.4 kali ganda."

Dalam bidang kecerdasan buatan, NVIDIA mendakwa bahawa kelajuan inferens HGX H200 pada Llama 2 (70 bilion parameter LLM) adalah dua kali lebih pantas daripada H100. HGX H200 akan tersedia dalam konfigurasi 4 hala dan 8 hala, serasi dengan perisian dan perkakasan dalam sistem H100Ia akan tersedia di setiap jenis pusat data (on-premise, cloud, hybrid cloud dan edge) dan digunakan oleh Amazon Web Services, Google Cloud, Microsoft Azure dan Oracle Cloud Infrastructure, dan akan tersedia pada Q2 2024.

Satu lagi produk utama yang dikeluarkan oleh NVIDIA kali ini ialah "supercip" GH200 Grace Hopper, yang menggabungkan GPU HGX H200 dan CPU NVIDIA Grace berasaskan Arm melalui sambung NVLink-C2C syarikat Direka untuk superkomputer, ia membolehkan "saintis dan penyelidik untuk menyelesaikan masalah paling mencabar di dunia dengan mempercepatkan aplikasi AI dan HPC kompleks yang menjalankan terabait data.”

GH200 akan digunakan dalam "lebih daripada 40 superkomputer AI di pusat penyelidikan, pengeluar sistem dan pembekal awan di seluruh dunia," termasuk Dell, Eviden, Hewlett Packard Enterprise (HPE), Lenovo, QCT dan Supermicro.

Terutamanya, komputer super Cray EX2500 HPE akan menampilkan GH200 empat hala, boleh berskala kepada puluhan ribu nod cip besar Grace Hopper

Atas ialah kandungan terperinci Nvidia mengeluarkan cip AI H200: prestasi melonjak sebanyak 90%, kelajuan inferens Llama 2 meningkat dua kali ganda. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI