Peranti teknologi

Peranti teknologi AI

AI Penyelidikan model besar Google telah mencetuskan kontroversi sengit: keupayaan generalisasi di luar data latihan telah dipersoalkan, dan netizen berkata bahawa singulariti AGI mungkin ditangguhkan.

Penyelidikan model besar Google telah mencetuskan kontroversi sengit: keupayaan generalisasi di luar data latihan telah dipersoalkan, dan netizen berkata bahawa singulariti AGI mungkin ditangguhkan.Keputusan baharu yang ditemui baru-baru ini oleh Google DeepMind telah menyebabkan kontroversi meluas dalam medan Transformer:

Keupayaan generalisasinya tidak boleh diperluaskan kepada kandungan di luar data latihan.

Kesimpulan ini belum lagi disahkan, tetapi ia telah membimbangkan banyak nama besar Contohnya, Francois Chollet, bapa Keras, berkata bahawa jika berita itu Benar, ia akan menjadi perkara besar dalam dunia model besar.

Google Transformer ialah infrastruktur di sebalik model besar hari ini, dan "T" dalam GPT yang kita kenali merujuk kepadanya.

Serangkaian model besar menunjukkan keupayaan pembelajaran kontekstual yang kukuh dan boleh mempelajari contoh dengan cepat dan menyelesaikan tugasan baharu.

Tetapi kini, penyelidik juga dari Google nampaknya telah menunjukkan kelemahannya yang maut - di luar data latihan, iaitu pengetahuan manusia yang sedia ada, ia tidak berkuasa.

Untuk sementara waktu, ramai pengamal percaya bahawa AGI telah tidak dapat dicapai lagi.

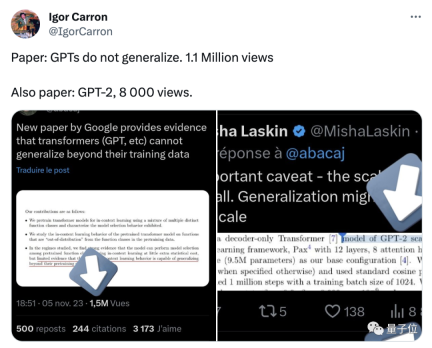

Beberapa netizen menegaskan bahawa terdapat beberapa butiran penting yang telah diabaikan dalam kertas, seperti eksperimen hanya melibatkan skala GPT-2 , dan data latihan tidak mencukupi Kaya

Semakin masa berlalu, lebih ramai netizen yang mengkaji kertas ini dengan teliti menunjukkan bahawa tidak ada yang salah dengan kesimpulan penyelidikan itu sendiri, tetapi orang berdasarkan Ini adalah tafsiran yang berlebihan.

Selepas kertas itu mencetuskan perbincangan hangat di kalangan netizen, salah seorang penulis turut membuat dua penjelasan secara terbuka:

Pertama , Percubaan menggunakan Transformer mudah, yang bukan model "besar" mahupun model bahasa; 🎜#新TYPE

Task

Sejak itu, seorang lagi netizen mengulangi percubaan ini dalam Colab, tetapi mendapat keputusan yang sama sekali berbeza .

Fungsi baharu hampir tidak dapat diramalkan

Fungsi baharu hampir tidak dapat diramalkan

Dalam eksperimen ini, penulis menggunakan rangka kerja pembelajaran mesin berasaskan Jax untuk melatih model Transformer dengan skala yang hampir dengan GPT-2, yang hanya mengandungi bahagian Penyahkod

Model ini mengandungi 12 lapisan, 8 kepala perhatian, dimensi ruang benam ialah 256, dan bilangan parameter adalah kira-kira 9.5 juta

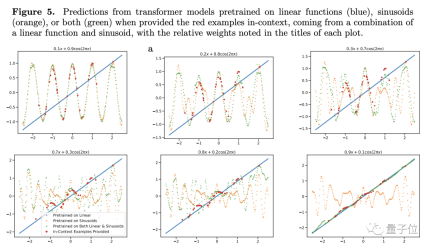

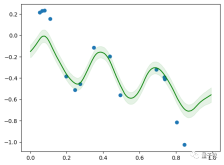

Untuk menguji keupayaan generalisasi, pengarang memilih fungsi sebagai objek ujian. Mereka memasukkan fungsi linear dan fungsi sinus ke dalam model sebagai data latihan

Kedua-dua fungsi ini diketahui oleh model pada masa ini, dan hasil yang diramalkan secara semula jadi sangat baik, tetapi apabila penyelidik meletakkan Masalah linear timbul apabila gabungan cembung bagi fungsi dan fungsi sinus dilakukan.

Gabungan cembung tidak begitu misteri Pengarang membina fungsi bentuk f(x)=a·kx+(1-a)sin(x), yang pada pendapat kami hanyalah dua Fungsi. hanya tambah secara berkadar.

Sebab mengapa kita fikir ini adalah kerana otak kita mempunyai keupayaan generalisasi ini, tetapi model berskala besar adalah berbeza

Untuk model yang hanya mempelajari fungsi linear dan sinus Untuk ini fungsi baru, ramalan Transformer hampir tiada ketepatan (lihat Rajah 4c), jadi penulis percaya bahawa model tidak mempunyai generalisasi pada fungsi Ability

Untuk mengesahkan lagi kesimpulannya, penulis melaraskan berat fungsi linear atau sinus, tetapi walaupun begitu, prestasi ramalan Transformer tidak berubah dengan ketara.

Terdapat satu pengecualian - apabila berat salah satu item menghampiri 1, hasil ramalan model lebih konsisten dengan keadaan sebenar.

Jika beratnya 1, ini bermakna fungsi baru yang tidak dikenali secara langsung menjadi fungsi yang telah dilihat semasa latihan. Data seperti ini jelas tidak membantu untuk keupayaan generalisasi model#🎜🎜 ##🎜 🎜#

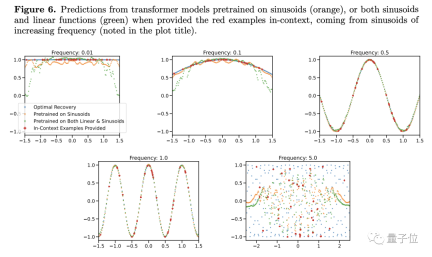

Eksperimen lanjut juga menunjukkan Transformer bukan sahaja sangat sensitif kepada jenis fungsi, malah jenis fungsi yang sama mungkin menjadi keadaan yang tidak biasa.

Eksperimen lanjut juga menunjukkan Transformer bukan sahaja sangat sensitif kepada jenis fungsi, malah jenis fungsi yang sama mungkin menjadi keadaan yang tidak biasa.

Pengkaji mendapati bahawa apabila menukar frekuensi fungsi sinus, walaupun model fungsi mudah, keputusan ramalan akan kelihatan berubah

Hanya apabila frekuensi hampir dengan itu dalam Fungsi data latihan, model boleh memberikan ramalan yang lebih tepat Apabila frekuensi terlalu tinggi atau terlalu rendah, keputusan ramalan mempunyai penyelewengan yang serius...

#. 🎜🎜# Berdasarkan perkara ini, penulis percaya bahawa selagi syaratnya berbeza sedikit, model besar tidak akan tahu bagaimana untuk melakukannya. Bukankah ini bermakna keupayaan generalisasi adalah lemah?

Berdasarkan kandungan komprehensif keseluruhan artikel, kesimpulan CEO Quora dalam artikel ini adalah sangat sempit dan hanya boleh diwujudkan apabila banyak andaian adalah benar

Berdasarkan kandungan komprehensif keseluruhan artikel, kesimpulan CEO Quora dalam artikel ini adalah sangat sempit dan hanya boleh diwujudkan apabila banyak andaian adalah benar

Menurut kajian terdahulu, model Transformer tidak boleh membuat generalisasi hanya apabila berhadapan dengan kandungan yang berbeza dengan ketara daripada data pra-latihan. Malah, keupayaan generalisasi model besar biasanya dinilai oleh kepelbagaian dan kerumitan tugas

Menurut kajian terdahulu, model Transformer tidak boleh membuat generalisasi hanya apabila berhadapan dengan kandungan yang berbeza dengan ketara daripada data pra-latihan. Malah, keupayaan generalisasi model besar biasanya dinilai oleh kepelbagaian dan kerumitan tugas

Tetapi walaupun kita benar-benar kurang keupayaan untuk membuat generalisasi, apa yang boleh kita lakukan?

Tetapi walaupun kita benar-benar kurang keupayaan untuk membuat generalisasi, apa yang boleh kita lakukan?

Saintis AI NVIDIA Jim Fan berkata bahawa fenomena ini sebenarnya tidak menghairankan, kerana Transformer

bukan ubat penawar di tempat pertamamodel besar berprestasi baik kerana#🎜 🎜#. Data latihan adalah perkara yang kami pentingkan

.Jim seterusnya menambah bahawa ini seperti berkata, gunakan 100 bilion foto kucing dan anjing untuk melatih model visual, dan kemudian biarkan model mengenal pasti Hidup kapal terbang, saya sedar, wow, saya benar-benar tidak mengenali dia.

Apabila manusia menghadapi beberapa tugas yang tidak diketahui, bukan sahaja model berskala besar mungkin tidak dapat mencari penyelesaian. Adakah ini juga membayangkan bahawa manusia kekurangan keupayaan generalisasi?

Oleh itu, dalam proses berorientasikan matlamat, sama ada model besar atau manusia, matlamat utama adalah untuk menyelesaikan masalah, dan generalisasi hanyalah sarana

Tukar ungkapan ini kepada bahasa Cina Memandangkan keupayaan generalisasi tidak mencukupi, kemudian latih ia sehingga tiada data selain daripada sampel latihan

Jadi, apa pendapat anda tentang penyelidikan ini?

Alamat kertas: https://arxiv.org/abs/2311.00871

Atas ialah kandungan terperinci Penyelidikan model besar Google telah mencetuskan kontroversi sengit: keupayaan generalisasi di luar data latihan telah dipersoalkan, dan netizen berkata bahawa singulariti AGI mungkin ditangguhkan.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apakah graf pemikiran dalam kejuruteraan segeraApr 13, 2025 am 11:53 AM

Apakah graf pemikiran dalam kejuruteraan segeraApr 13, 2025 am 11:53 AMPengenalan Dalam kejuruteraan segera, "Grafik Pemikiran" merujuk kepada pendekatan baru yang menggunakan teori graf untuk struktur dan membimbing proses penalaran AI. Tidak seperti kaedah tradisional, yang sering melibatkan linear

Mengoptimumkan pemasaran e -mel organisasi anda dengan agen genaiApr 13, 2025 am 11:44 AM

Mengoptimumkan pemasaran e -mel organisasi anda dengan agen genaiApr 13, 2025 am 11:44 AMPengenalan Tahniah! Anda menjalankan perniagaan yang berjaya. Melalui laman web anda, kempen media sosial, webinar, persidangan, sumber percuma, dan sumber lain, anda mengumpul 5000 ID e -mel setiap hari. Langkah jelas seterusnya adalah

Pemantauan Prestasi Aplikasi Masa Nyata dengan Apache PinotApr 13, 2025 am 11:40 AM

Pemantauan Prestasi Aplikasi Masa Nyata dengan Apache PinotApr 13, 2025 am 11:40 AMPengenalan Dalam persekitaran pembangunan perisian pantas hari ini, memastikan prestasi aplikasi yang optimum adalah penting. Memantau metrik masa nyata seperti masa tindak balas, kadar ralat, dan penggunaan sumber dapat membantu utama

Chatgpt mencecah 1 bilion pengguna? 'Dua kali ganda dalam beberapa minggu' kata Ketua Pegawai Eksekutif OpenaiApr 13, 2025 am 11:23 AM

Chatgpt mencecah 1 bilion pengguna? 'Dua kali ganda dalam beberapa minggu' kata Ketua Pegawai Eksekutif OpenaiApr 13, 2025 am 11:23 AM"Berapa banyak pengguna yang anda ada?" Dia ditakdirkan. "Saya fikir kali terakhir yang kami katakan ialah 500 juta aktif mingguan, dan ia berkembang dengan pesat," jawab Altman. "Anda memberitahu saya bahawa ia seperti dua kali ganda dalam beberapa minggu sahaja," kata Anderson. "Saya mengatakan bahawa priv

Pixtral -12b: Model Multimodal Pertama Mistral Ai 'Apr 13, 2025 am 11:20 AM

Pixtral -12b: Model Multimodal Pertama Mistral Ai 'Apr 13, 2025 am 11:20 AMPengenalan Mistral telah mengeluarkan model multimodal yang pertama, iaitu Pixtral-12B-2409. Model ini dibina atas parameter 12 bilion Mistral, NEMO 12B. Apa yang membezakan model ini? Ia kini boleh mengambil kedua -dua gambar dan Tex

Rangka Kerja Agentik untuk Aplikasi AI Generatif - Analytics VidhyaApr 13, 2025 am 11:13 AM

Rangka Kerja Agentik untuk Aplikasi AI Generatif - Analytics VidhyaApr 13, 2025 am 11:13 AMBayangkan mempunyai pembantu berkuasa AI yang bukan sahaja memberi respons kepada pertanyaan anda tetapi juga mengumpulkan maklumat, melaksanakan tugas, dan juga mengendalikan pelbagai jenis teks, imej, dan kod. Bunyi futuristik? Dalam ini a

Aplikasi AI Generatif di Sektor KewanganApr 13, 2025 am 11:12 AM

Aplikasi AI Generatif di Sektor KewanganApr 13, 2025 am 11:12 AMPengenalan Industri kewangan adalah asas kepada mana -mana pembangunan negara, kerana ia memacu pertumbuhan ekonomi dengan memudahkan urus niaga yang cekap dan ketersediaan kredit. The ease with which transactions occur and credit

Panduan untuk pembelajaran dalam talian dan algoritma pasif-agresifApr 13, 2025 am 11:09 AM

Panduan untuk pembelajaran dalam talian dan algoritma pasif-agresifApr 13, 2025 am 11:09 AMPengenalan Data dijana pada kadar yang belum pernah terjadi sebelumnya dari sumber seperti media sosial, urus niaga kewangan, dan platform e-dagang. Mengendalikan aliran maklumat yang berterusan ini adalah satu cabaran, tetapi ia menawarkan

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Penyesuai Pelayan SAP NetWeaver untuk Eclipse

Integrasikan Eclipse dengan pelayan aplikasi SAP NetWeaver.

Muat turun versi mac editor Atom

Editor sumber terbuka yang paling popular

ZendStudio 13.5.1 Mac

Persekitaran pembangunan bersepadu PHP yang berkuasa

VSCode Windows 64-bit Muat Turun

Editor IDE percuma dan berkuasa yang dilancarkan oleh Microsoft

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa