Rumah >Peranti teknologi >AI >Pilih GPT-3.5 atau Jordan Llama 2 dan model sumber terbuka yang lain? Selepas perbandingan menyeluruh, jawapannya ialah

Pilih GPT-3.5 atau Jordan Llama 2 dan model sumber terbuka yang lain? Selepas perbandingan menyeluruh, jawapannya ialah

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-10-16 18:45:05636semak imbas

Dengan membandingkan parameter GPT-3.5 dan Llama 2 pada tugasan yang berbeza, kita boleh mengetahui dalam keadaan apa memilih GPT-3.5 dan dalam keadaan apa memilih Llama 2 atau model lain.

Nampaknya, tork GPT-3.5 sangat mahal. Kertas kerja ini secara eksperimen mengesahkan sama ada model tork manual boleh mendekati prestasi GPT-3.5 pada sebahagian kecil daripada kos GPT-3.5. Menariknya, kertas itu melakukannya.

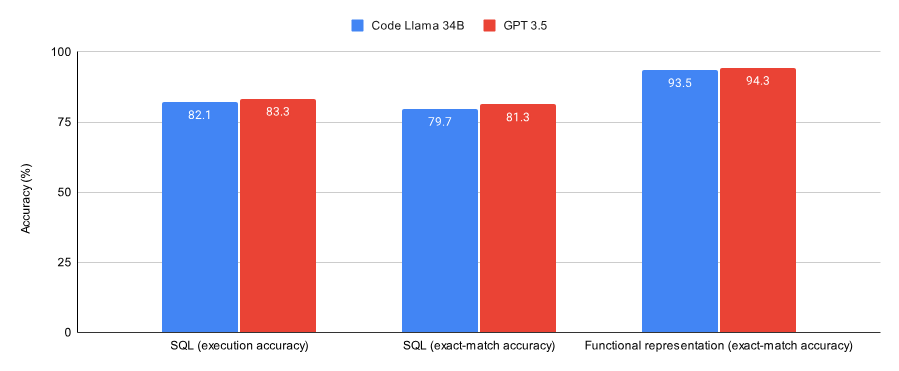

Membandingkan keputusan pada tugas SQL dan tugas perwakilan fungsi, kertas itu mendapati:

GPT-3.5 lebih baik daripada Kod selepas Lora pada kedua-dua set data (subset set data Spider dan set data perwakilan fungsi Viggo ) Llama 34B menunjukkan prestasi yang lebih baik sedikit.

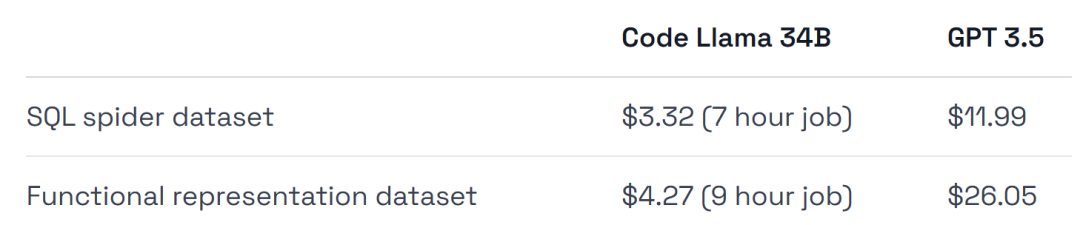

Kos latihan GPT-3.5 adalah 4-6 kali lebih tinggi, dan kos penggunaan juga lebih tinggi.

Salah satu kesimpulan eksperimen ini ialah GPT-3.5 sesuai untuk kerja pengesahan awal, tetapi selepas itu, model seperti Llama 2 mungkin pilihan terbaik, untuk meringkaskan secara ringkas:

Jika anda mahukan pengesahan untuk menyelesaikan khusus Pendekatan yang betul untuk tugasan/set data anda, atau jika anda mahukan persekitaran terurus sepenuhnya, kemudian laraskan GPT-3.5.

Jika anda ingin menjimatkan wang, dapatkan prestasi maksimum daripada set data anda, mempunyai lebih fleksibiliti dalam melatih dan menggunakan infrastruktur, dan mahu atau mengekalkan beberapa data, kemudian gunakan sesuatu seperti model sumber Terbuka Llama 2.

Seterusnya mari kita lihat bagaimana kertas kerja itu dilaksanakan.

Rajah di bawah menunjukkan prestasi Kod Llama 34B dan GPT-3.5 yang dilatih untuk menumpu pada tugas SQL dan tugas perwakilan fungsi. Keputusan menunjukkan bahawa GPT-3.5 mencapai ketepatan yang lebih baik pada kedua-dua tugas.

Dari segi penggunaan perkakasan, percubaan menggunakan GPU A40, iaitu lebih kurang AS$0.475.

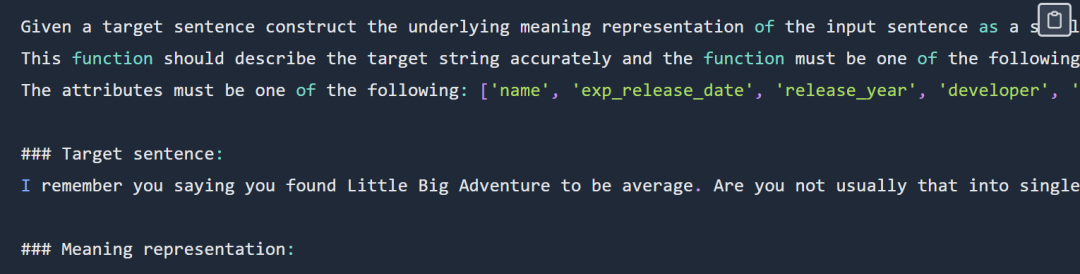

Selain itu, eksperimen menyenaraikan dua set data yang sangat sesuai untuk menakutkan, subset set data Spider dan fungsi Viggo mewakili set data.

Untuk membuat perbandingan yang adil dengan model GPT-3.5, eksperimen telah dijalankan pada Llama dengan hiperparameter minimum.

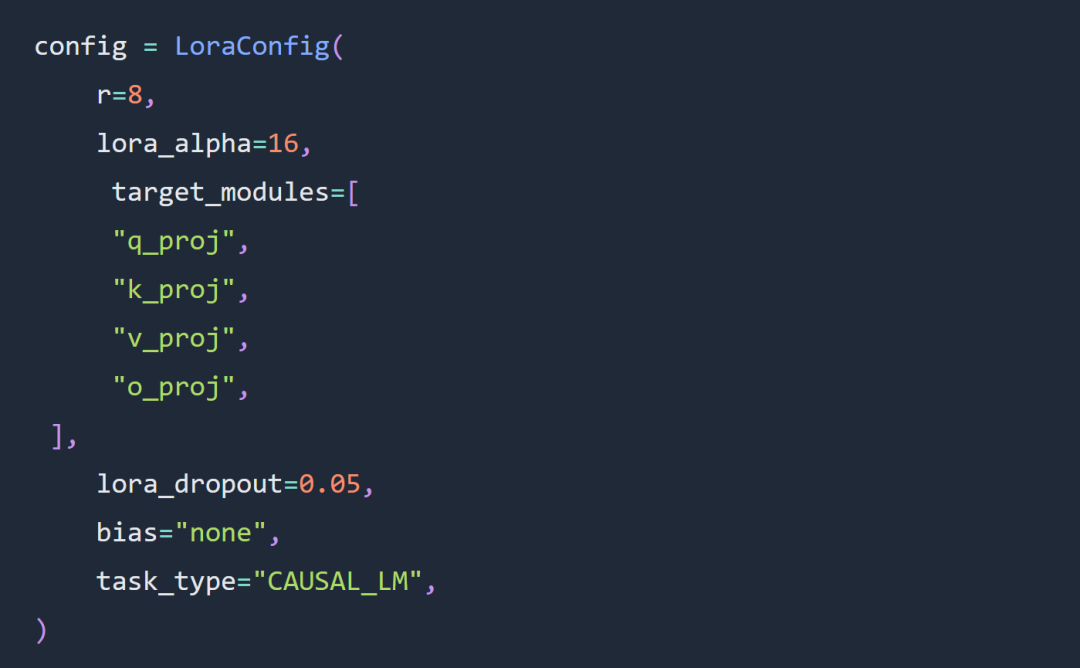

Dua pilihan utama untuk percubaan artikel ini ialah menggunakan parameter Kod Llama 34B dan Lora dan bukannya parameter parameter penuh.度 Percubaan ini sebahagian besarnya diikuti oleh peraturan konfigurasi parameter super LoRa Beban LoRA adalah seperti berikut:

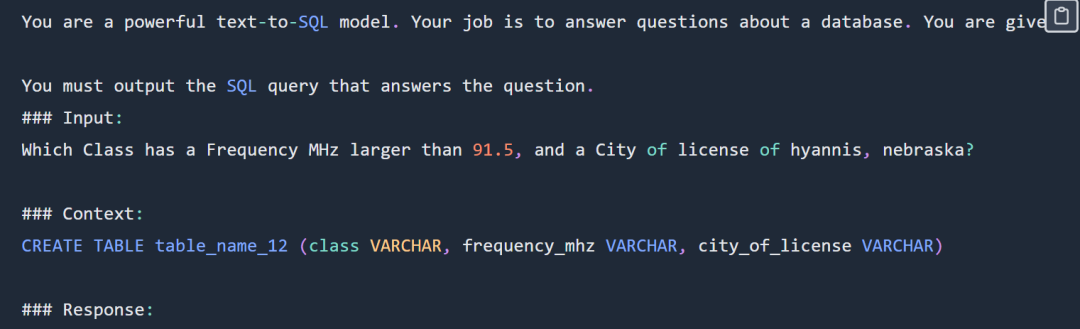

Gesaan SQL adalah seperti berikut:

Gesaan SQL adalah seperti berikut:

, sila semak bahagian paparan SQL. blog asal untuk gesaan lengkap, sila semak blog asal Percubaan tidak menggunakan set data Spider yang lengkap Borang khusus adalah seperti berikut

department : Department_ID [ INT ] primary_key Name [ TEXT ] Creation [ TEXT ] Ranking [ INT ] Budget_in_Billions [ INT ] Num_Employees [ INT ] head : head_ID [ INT ] primary_key name [ TEXT ] born_state [ TEXT ] age [ INT ] management : department_ID [ INT ] primary_key management.department_ID = department.Department_ID head_ID [ INT ] management.head_ID = head.head_ID temporary_acting [ TEXT ]

CREATE TABLE table_name_12 (class VARCHAR, frequency_mhz VARCHAR, city_of_license VARCHAR)

Contoh gesaan perwakilan fungsi Seperti yang ditunjukkan di bawah: Fungsi 提 menunjukkan bahagian gesaan paparan Untuk gesaan yang lengkap, sila lihat output blog asal seperti yang ditunjukkan di bawah

Fungsi mewakili kod tugas dan alamat data: https://github.com/. samlhuillier/viggo-finetune

Pautan asal:

https://ragntune.com/blog/gpt3.5-vs-llama2-finetuning?continueFlag=11fc7786e20d7786e20d7786e20d498c94daaaAtas ialah kandungan terperinci Pilih GPT-3.5 atau Jordan Llama 2 dan model sumber terbuka yang lain? Selepas perbandingan menyeluruh, jawapannya ialah. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!