Rumah >Peranti teknologi >AI >'Sangat terkejut' CTO: ujian pemanduan autonomi GPT-4V selama lima kali berturut-turut

'Sangat terkejut' CTO: ujian pemanduan autonomi GPT-4V selama lima kali berturut-turut

- 王林ke hadapan

- 2023-10-16 11:29:021017semak imbas

Artikel ini dicetak semula dengan kebenaran AI New Media Qubit (ID akaun awam: QbitAI Sila hubungi sumber untuk mencetak semula).

Di bawah perhatian ramai, GPT4 akhirnya melancarkan fungsi berkaitan penglihatan hari ini.

Saya dengan cepat menguji keupayaan persepsi imej GPT dengan rakan-rakan saya petang ini Walaupun kami mempunyai jangkaan, kami masih sangat terkejut.

Sudut pandangan teras:

Saya berpendapat bahawa isu berkaitan semantik dalam pemanduan autonomi sepatutnya telah diselesaikan dengan baik oleh model besar, tetapi kredibiliti dan keupayaan persepsi ruang model besar masih tidak memuaskan.

Ia sepatutnya lebih daripada mencukupi untuk menyelesaikan beberapa kes sudut yang dipanggil berkaitan kecekapan, tetapi masih jauh untuk bergantung sepenuhnya pada model besar untuk melengkapkan pemanduan secara bebas dan memastikan keselamatan.

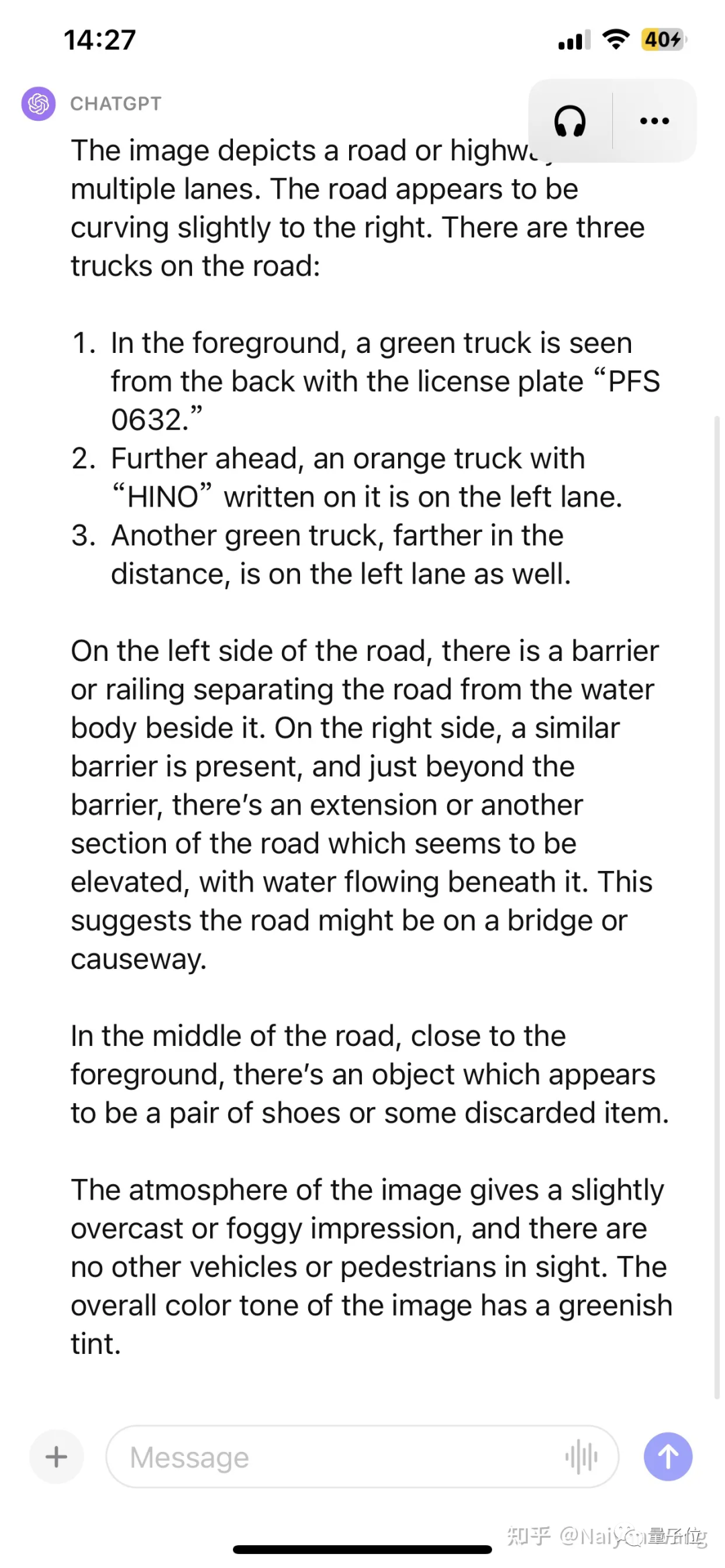

Contoh1: Beberapa halangan yang tidak diketahui muncul di jalan raya

△ perihalan GPT4

Bahagian tepat: 3 lori telah dikesan, nombor plat kenderaan di hadapan adalah betul (berkarakter Cina tidak betul) ), cuaca Betul dengan persekitaran, mengenal pasti dengan tepat halangan yang tidak diketahui di hadapan tanpa gesaan .

Bahagian yang tidak tepat: Kedudukan trak ketiga tidak dapat dibezakan dari kiri ke kanan, dan teks di atas kepala trak kedua adalah tekaan rawak (kerana resolusi tidak mencukupi?).

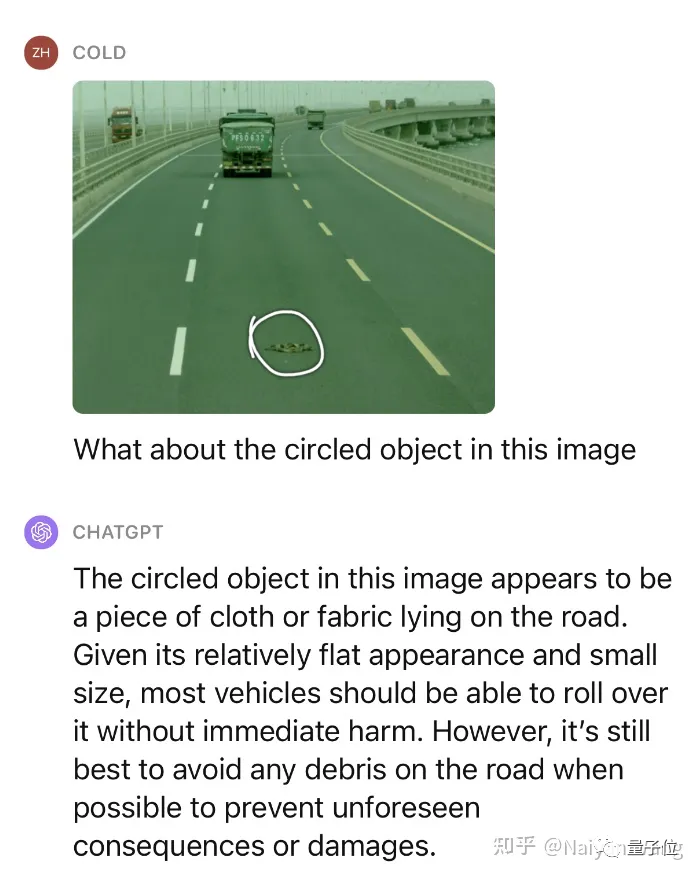

Ini tidak mencukupi, mari teruskan memberi sedikit petunjuk dan bertanya apakah objek ini dan sama ada ia boleh ditekan.

Mengagumkan! Kami telah menguji beberapa senario yang serupa, dan prestasi pada halangan yang tidak diketahui boleh dikatakan sangat menakjubkan.

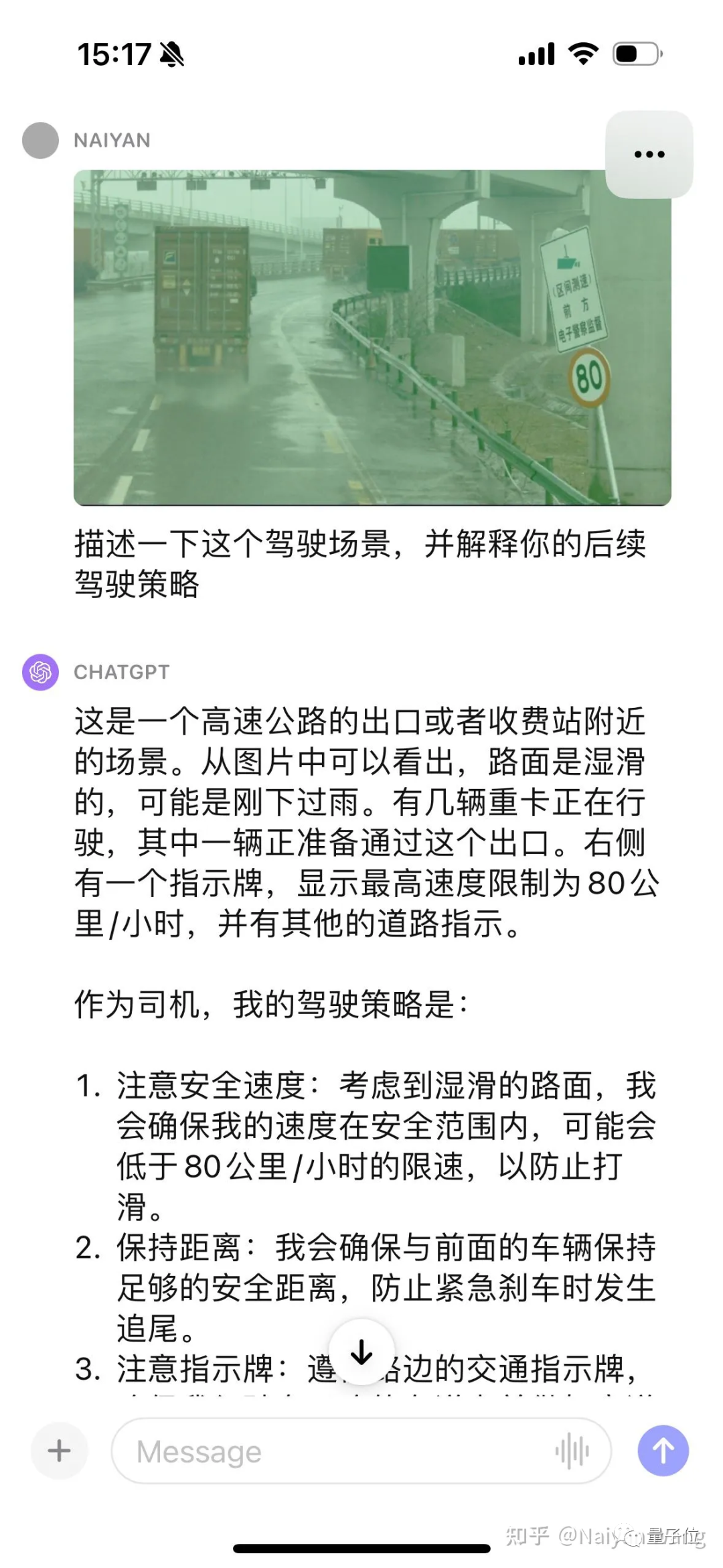

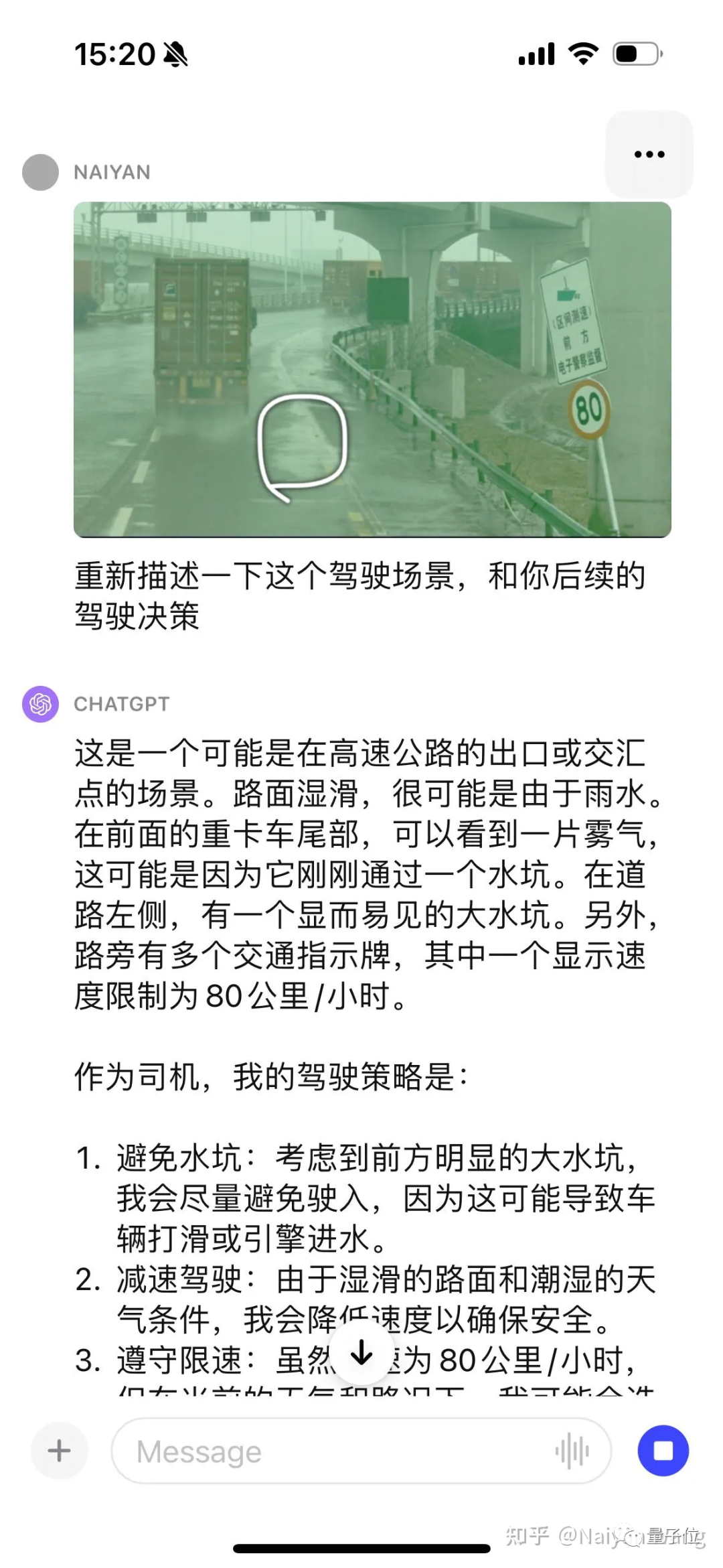

Contoh2: Memahami pengumpulan air jalan raya

Tiada gesaan untuk mengenali tanda secara automatik Ini sepatutnya asas, mari kita teruskan memberi beberapa petunjuk.

Saya terkejut lagi. . . Dia secara automatik boleh memberitahu kabus di belakang trak dan juga menyebut lopak, tetapi sekali lagi berkata arahnya ke kiri. . . Saya merasakan bahawa beberapa kejuruteraan segera mungkin diperlukan di sini untuk membolehkan GPT mengeluarkan kedudukan dan arah dengan lebih baik.

Contoh3: Sebuah kenderaan berpusing dan melanggar pagar terus

Bingkai pertama adalah input Kerana tiada maklumat masa, trak di sebelah kanan hanya dianggap sebagai diletakkan. Jadi ini satu lagi bingkai:

boleh dikatakan secara automatik Kereta ini terbabas melalui pagar dan berlegar di tepi jalan. . . Tetapi sebaliknya papan tanda jalan yang kelihatan lebih mudah adalah salah. . . Apa yang boleh saya katakan ialah ini adalah model yang besar Ia akan sentiasa mengejutkan anda dan anda tidak tahu bila ia akan membuat anda menangis. . . Bingkai lain:

Kali ini, ia bercakap secara langsung mengenai serpihan di jalan raya, dan saya mengaguminya sekali lagi. . . Tetapi pernah saya menyebut anak panah yang salah di jalan raya. . . Secara umumnya, maklumat yang memerlukan perhatian khusus dalam adegan ini dilindungi Untuk isu seperti papan tanda jalan, kelemahan tidak disembunyikan.

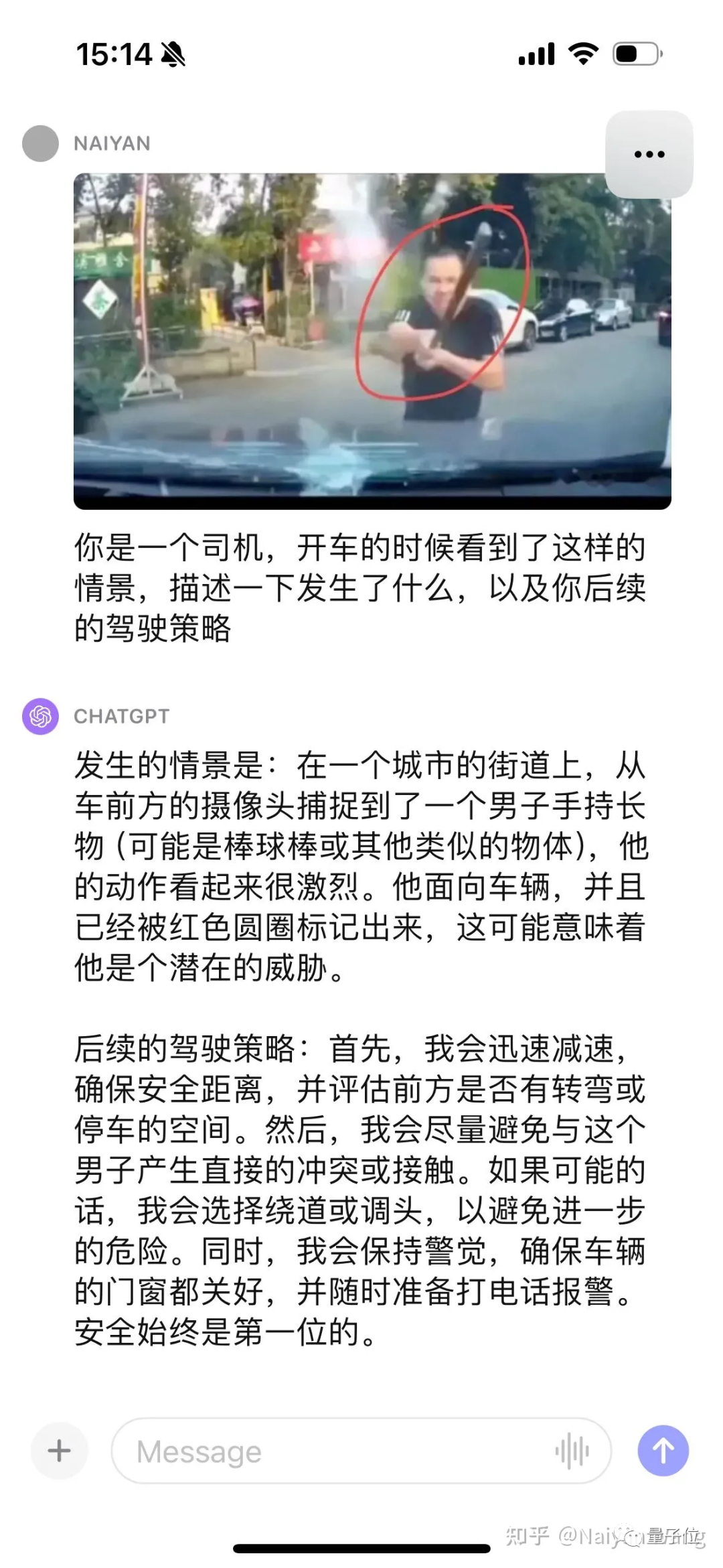

Contoh4: Mari kita bersenang-senang

Hanya boleh dikatakan sangat tepat Berbanding dengan kes-kes yang sukar sebelum ini seperti "seseorang melambai kepada anda", ia seperti permainan kanak-kanak dan boleh diselesaikan dengan kes sudut semantik.

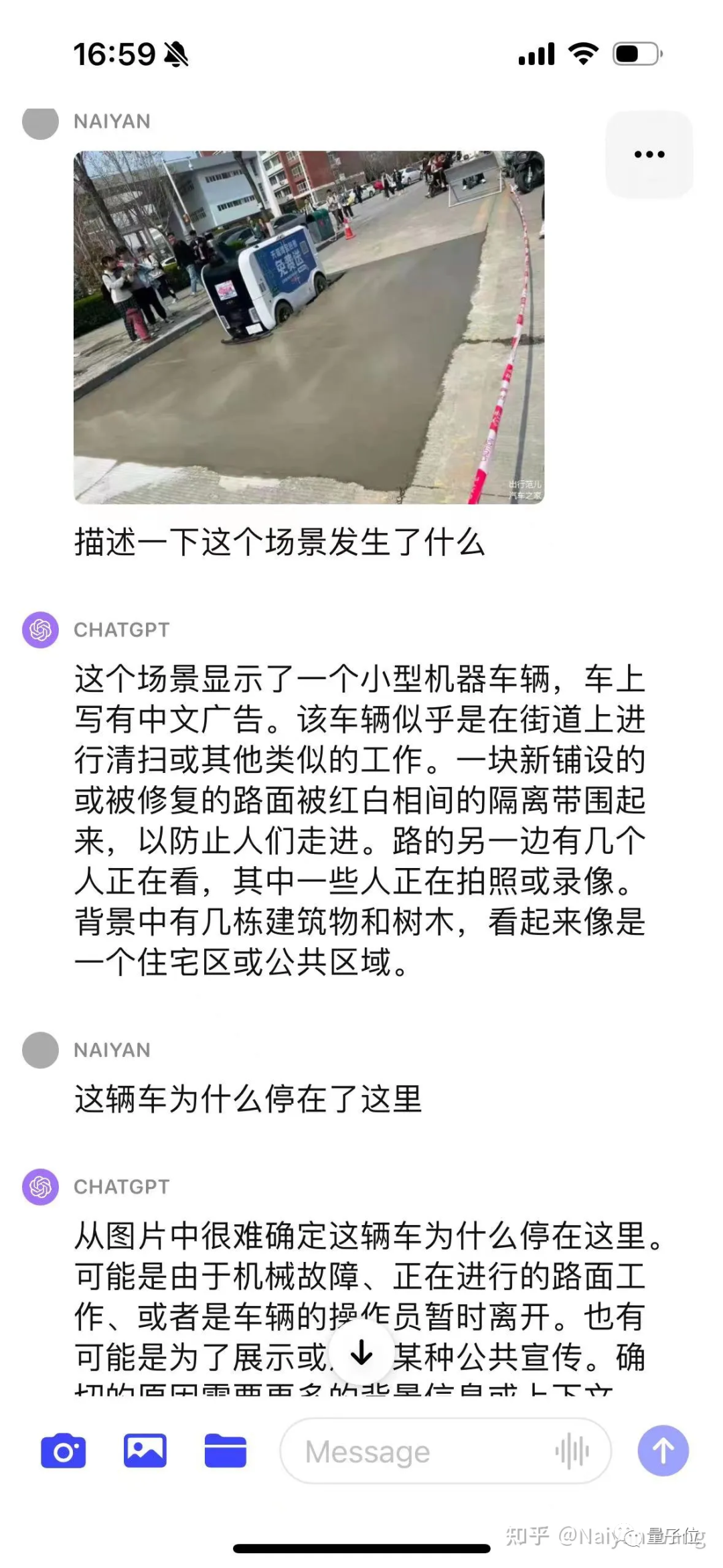

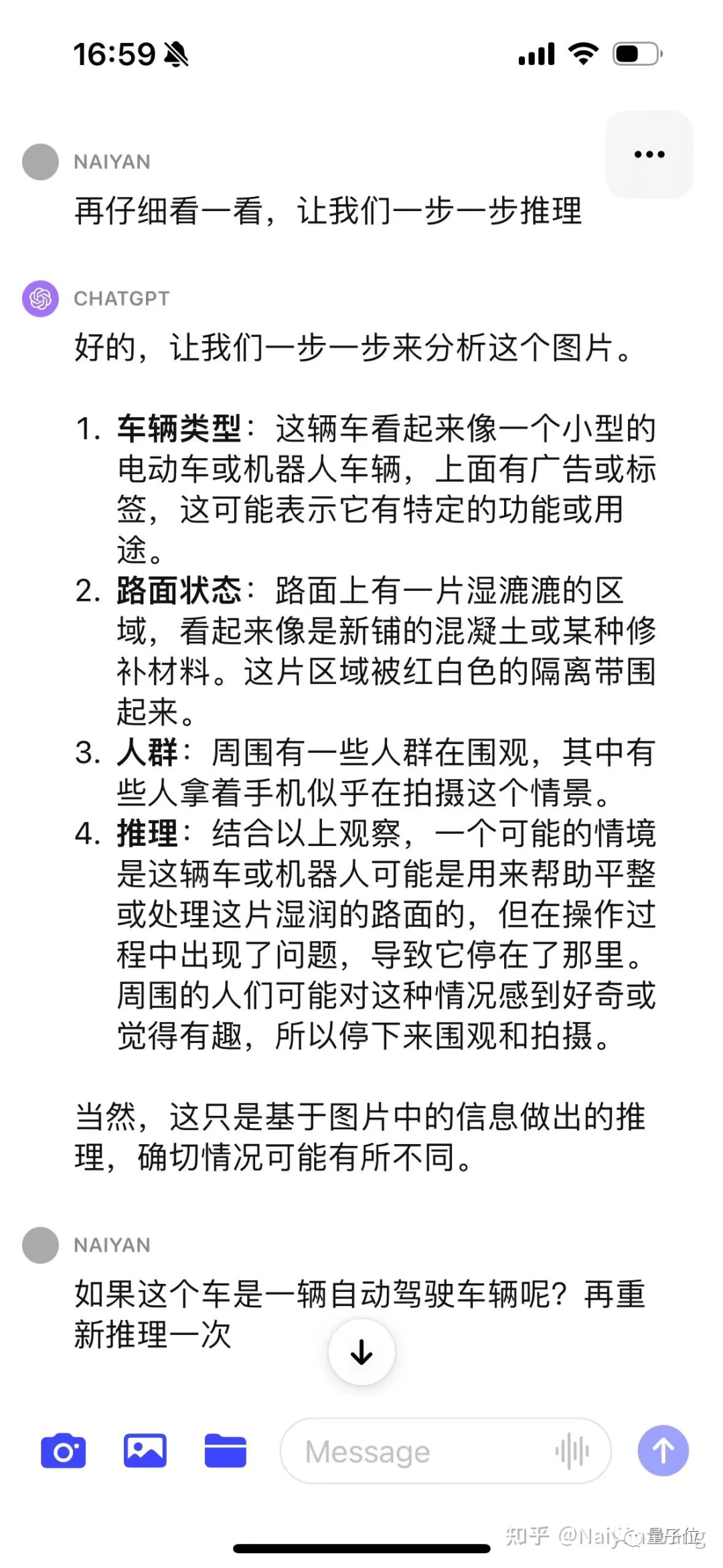

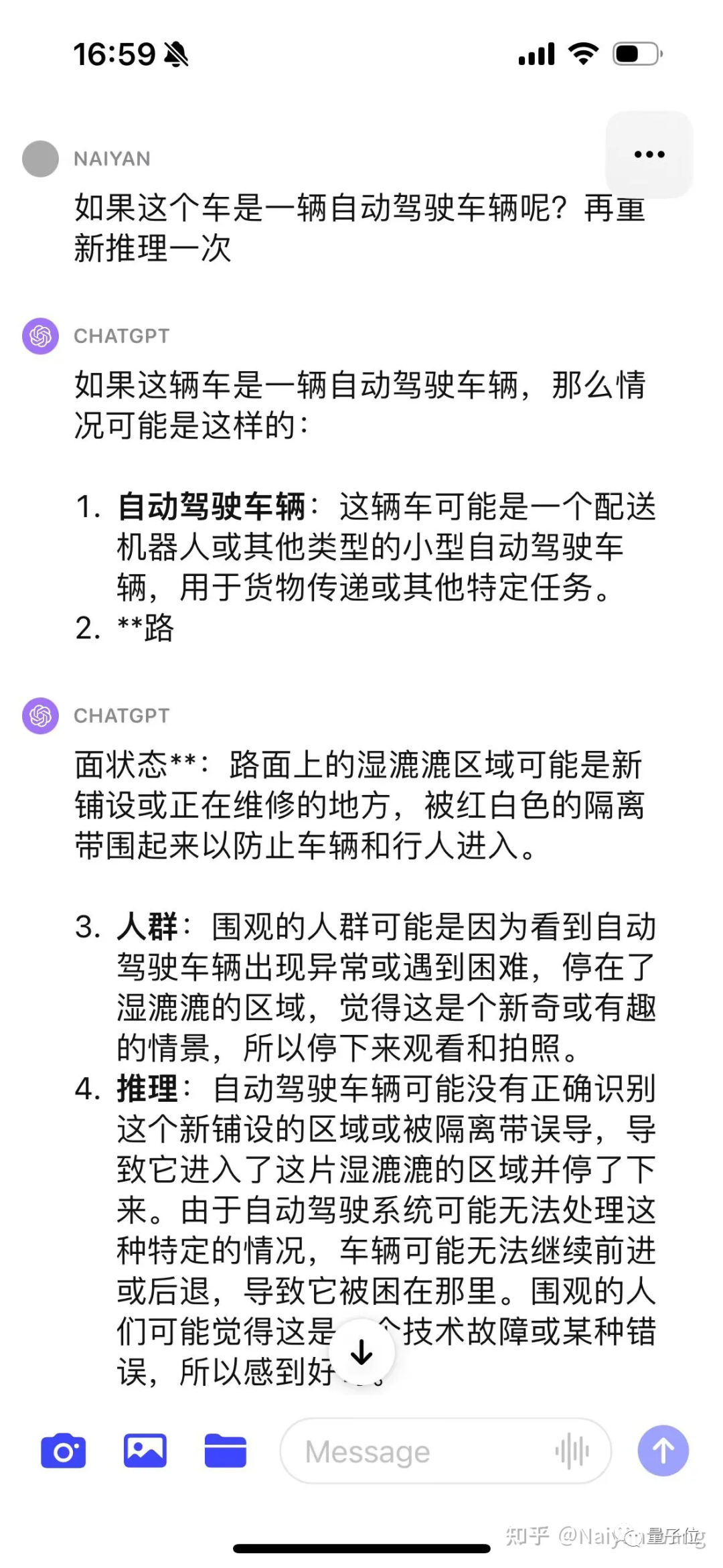

Contoh5 Mari kita lihat adegan yang terkenal. . . Lori penghantar tersilap masuk ke jalan yang baru dibina

Saya agak konservatif pada mulanya dan tidak meneka secara langsung puncanya matlamat penjajaran.

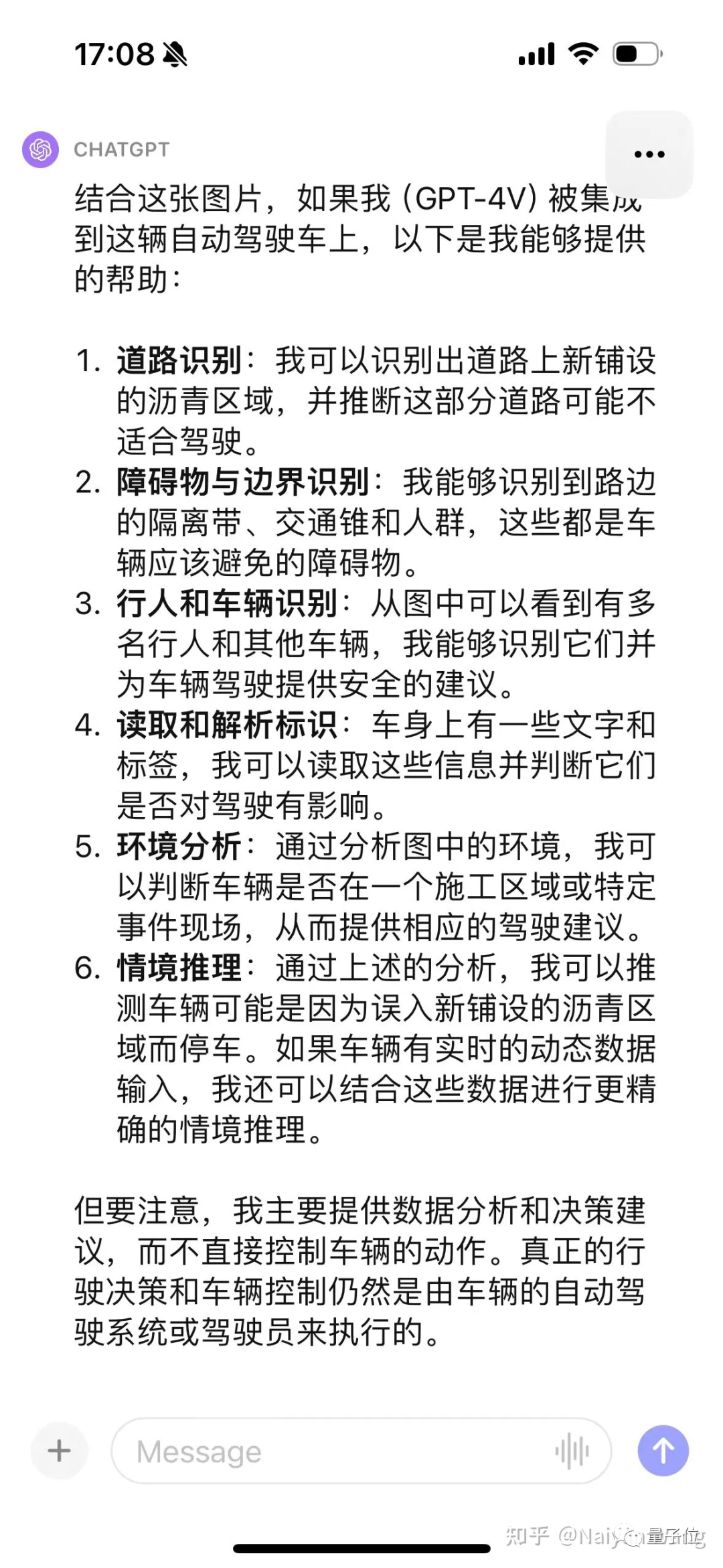

Selepas menggunakan CoT, didapati masalahnya ialah kereta itu tidak difahamkan sebagai kenderaan pandu sendiri, jadi dengan memberi maklumat ini melalui segera boleh memberikan maklumat yang lebih tepat.

Akhirnya, melalui sekumpulan gesaan, saya dapat membuat kesimpulan bahawa asfalt yang baru dipasang tidak sesuai untuk memandu. Keputusan akhir masih OK, tetapi prosesnya lebih berliku-liku dan memerlukan kejuruteraan yang lebih cepat dan reka bentuk yang teliti.

Sebab ini juga mungkin kerana gambar itu bukan dari perspektif pertama dan hanya boleh disimpulkan dari perspektif ketiga. Jadi contoh ini tidak begitu tepat.

Ringkasan

Sesetengah percubaan pantas telah membuktikan sepenuhnya kuasa dan prestasi generalisasi GPT4V Gesaan yang sesuai seharusnya dapat menggunakan kekuatan GPT4V sepenuhnya.

Ia sepatutnya sangat menjanjikan untuk menyelesaikan kes sudut semantik, tetapi masalah ilusi masih akan melanda beberapa aplikasi dalam senario berkaitan keselamatan.

Sangat mengujakan Saya secara peribadi berpendapat bahawa penggunaan rasional model besar sebegini boleh mempercepatkan pembangunan pemanduan autonomi L4 dan juga L5 Namun, adakah LLM perlu memandu secara langsung? Pemanduan hujung ke hujung, khususnya, masih menjadi isu yang boleh dipertikaikan.

Atas ialah kandungan terperinci 'Sangat terkejut' CTO: ujian pemanduan autonomi GPT-4V selama lima kali berturut-turut. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- 硬盘技术指标有哪些

- Apakah yang dirujuk terutamanya oleh penunjuk prestasi teknikal komputer?

- Teknologi pengkomputeran tepi dalam sistem pemanduan autonomi

- Adakah guru memandu sendiri Tesla akan terlibat dalam ChatGPT? Akan menyertai OpenAI

- Saham teknologi Titanium Media telah lama diketahui: pemanduan autonomi + robot humanoid, peranti penting ini adalah asas dan teras persepsi