Rumah >Peranti teknologi >AI >Zhipu AI bekerjasama dengan Tsinghua KEG untuk mengeluarkan model besar berbilang modal sumber terbuka yang dipanggil CogVLM-17B

Zhipu AI bekerjasama dengan Tsinghua KEG untuk mengeluarkan model besar berbilang modal sumber terbuka yang dipanggil CogVLM-17B

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-10-12 11:41:011499semak imbas

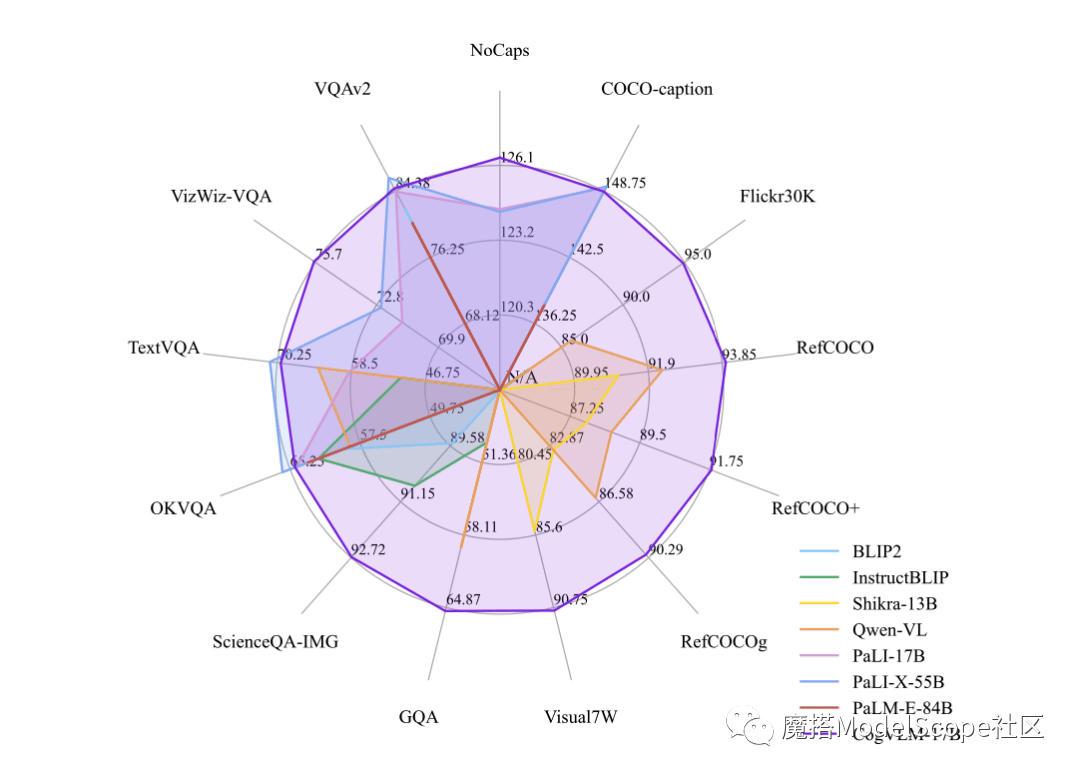

Builder News pada 12 Oktober, baru-baru ini, Zhipu AI & Tsinghua KEG mengeluarkan dan sumber terbuka secara langsung model besar berbilang mod-CogVLM-17B dalam komuniti Moda. Dilaporkan bahawa CogVLM ialah model bahasa visual sumber terbuka yang berkuasa yang menggunakan modul pakar visual untuk menyepadukan pengekodan bahasa dan pengekodan visual secara mendalam, dan telah mencapai prestasi SOTA pada 14 penanda aras silang modal yang berwibawa.

CogVLM-17B kini merupakan model dengan prestasi komprehensif pertama dalam senarai akademik berwibawa berbilang modal, dan telah mencapai keputusan tempat paling maju atau kedua pada 14 set data. Kesan CogVLM bergantung pada idea "keutamaan visual", iaitu, memberikan pemahaman visual keutamaan yang lebih tinggi dalam model berbilang modal. Ia menggunakan pengekod visual parameter 5B dan modul pakar visual parameter 6B, dengan jumlah parameter 11B untuk memodelkan ciri imej, malah lebih daripada parameter 7B teks

Atas ialah kandungan terperinci Zhipu AI bekerjasama dengan Tsinghua KEG untuk mengeluarkan model besar berbilang modal sumber terbuka yang dipanggil CogVLM-17B. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- 360 telah mencapai kerjasama strategik dengan Zhipu AI untuk bersama-sama membangunkan model bahasa besar 360GLM

- 360 dan Zhipu AI mengumumkan kerjasama strategik untuk bersama-sama membangunkan model bahasa besar peringkat 100 bilion '360GLM'

- Replika domestik pertama model R&D ChatGPT, model bahasa besar kerjasama strategik 360 dan Zhipu AI

- 360 akan melancarkan model bahasa besar 100 bilion peringkat 360GLM dan bekerjasama secara strategik dengan Zhipu AI

- 2023 Sohu Technology Summit Pengenalan Tetamu Zhang Fan: Zhipu AI COO