Rumah >Peranti teknologi >AI >Zhiyuan membuka 300 juta data latihan model vektor semantik, dan model BGE terus dikemas kini secara berulang.

Zhiyuan membuka 300 juta data latihan model vektor semantik, dan model BGE terus dikemas kini secara berulang.

- 王林ke hadapan

- 2023-09-21 21:33:111540semak imbas

Dengan perkembangan pesat dan aplikasi model berskala besar, kepentingan Embedding, yang merupakan komponen asas teras model berskala besar, telah menjadi semakin menonjol. Model vektor semantik Cina-Inggeris sumber terbuka dan tersedia secara komersial BGE (BAAI General Embedding) yang dikeluarkan oleh Syarikat Zhiyuan sebulan yang lalu telah menarik perhatian meluas dalam komuniti, dan telah dimuat turun ratusan ribu kali pada platform Hugging Face. Pada masa ini, BGE telah melancarkan versi 1.5 secara berulang-ulang dan mengumumkan berbilang kemas kini. Antaranya, BGE telah membuka sumber terbuka 300 juta data latihan berskala besar buat kali pertama, menyediakan komuniti bantuan dalam melatih model serupa dan mempromosikan pembangunan teknologi dalam bidang ini

- Pautan set data MTP: https://data.baai. ac.cn/details/BAAI-MTP

- Pautan model BGE: https://huggingface.co/BAAI

- repositori kod BGE: https://www.php .cn/link/8944871f1c9865a77a3d9c92cadf124d

3

data latihan sumber terbuka pertamacina dan data Bahasa Inggeris

Kecemerlangan BGE Keupayaannya sebahagian besarnya berpunca daripada data latihan berskala besar dan pelbagai. Sebelum ini, rakan industri jarang mengeluarkan set data yang serupa. Dalam kemas kini ini, Zhiyuan membuka data latihan BGE kepada komuniti buat kali pertama, meletakkan asas untuk pembangunan lanjut jenis teknologi ini.

Set data MTP yang dikeluarkan kali ini terdiri daripada sejumlah 300 juta pasangan teks berkaitan bahasa Cina dan Inggeris. Antaranya, terdapat 100 juta rekod dalam bahasa Cina dan 200 juta rekod dalam bahasa Inggeris. Sumber data termasuk Wudao Corpora, Pile, DuReader, Sentence Transformer dan korporat lain. Diperolehi selepas pensampelan, pengekstrakan dan pembersihan yang diperlukan

Untuk butiran, sila rujuk Hab Data: https://data.baai.ac.cn

MTP ialah set data pasangan teks berkaitan Cina-Inggeris sumber terbuka terbesar setakat ini, menyediakan asas penting untuk melatih model vektor semantik Cina dan Inggeris.

Sebagai tindak balas kepada komuniti pembangun, peningkatan fungsi BGE

Berdasarkan maklum balas komuniti, BGE telah dioptimumkan lagi berdasarkan versi 1.0nya untuk menjadikan prestasinya lebih stabil dan cemerlang. Kandungan peningkatan khusus adalah seperti berikut:

- Kemas kini model. BGE-*-zh-v1.5 mengurangkan masalah pengedaran persamaan dengan menapis data latihan, memadamkan data berkualiti rendah dan meningkatkan pekali suhu semasa latihan kepada 0.02, menjadikan nilai persamaan lebih stabil.

- Model baharu ditambah. Model pengekod silang BGE-reranker sumber terbuka boleh mencari teks yang berkaitan dengan lebih tepat dan menyokong dwibahasa Cina dan Inggeris. Berbeza daripada model vektor yang memerlukan vektor keluaran, BGE-reranker secara langsung mengeluarkan persamaan antara pasangan teks dan mempunyai ketepatan kedudukan yang lebih tinggi Ia boleh digunakan untuk menyusun semula keputusan penarikan semula vektor dan mempertingkatkan perkaitan hasil akhir.

- Ciri baharu. BGE1.1 menambah skrip perlombongan sampel sukar-ke-negatif dengan berkesan boleh meningkatkan kesan perolehan selepas penalaan halus ditambah kepada kod penalaan halus; juga akan ditukar secara automatik ke dalam format pengubah ayat, menjadikannya lebih mudah untuk memuatkan model.

Perlu dinyatakan bahawa baru-baru ini, Zhiyuan dan Hugging Face mengeluarkan laporan teknikal, yang mencadangkan menggunakan C-Pack untuk meningkatkan model vektor semantik universal Cina.

"C-Pack: Packaged Resources To Advance General Chinese Embedding"

Pautan: https://arxiv.org/pdf/2309.07597.pdf

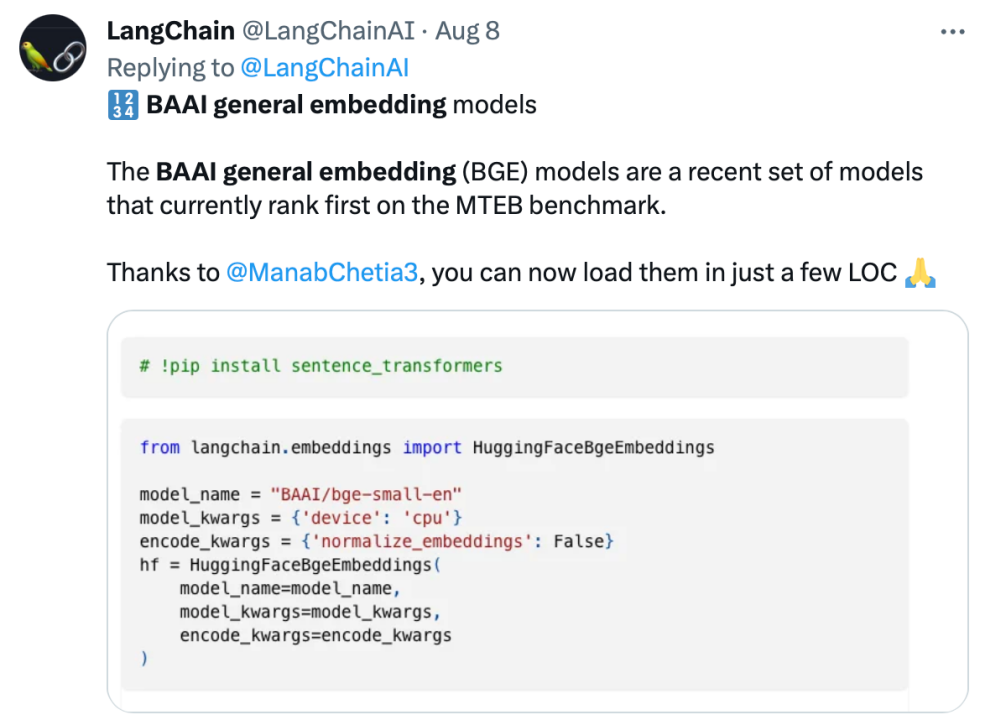

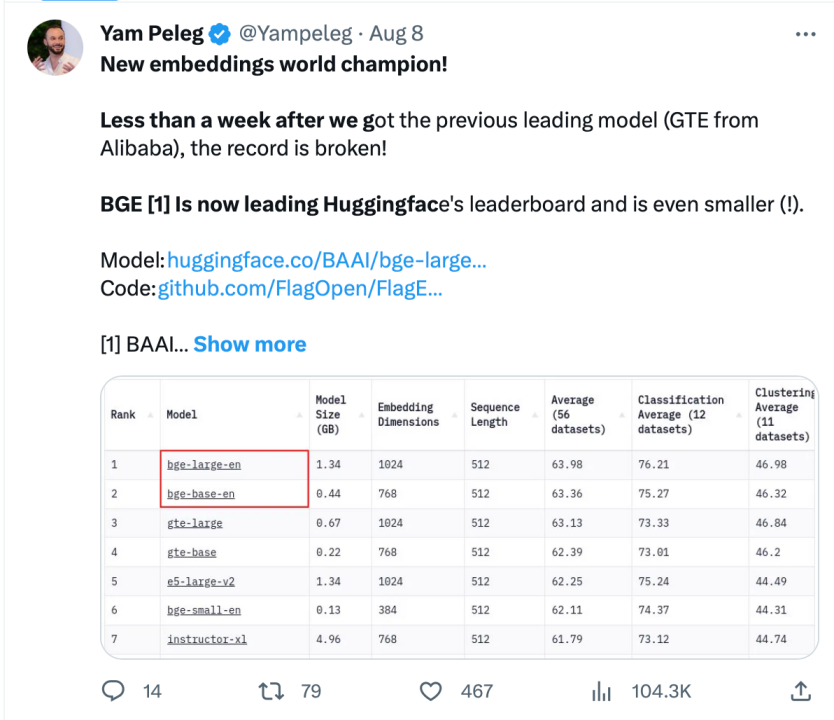

mendapat populariti tinggi dalam komuniti BGE telah menarik perhatian komuniti pembangun model besar sejak dikeluarkan Pada masa ini, Hugging Face telah dimuat turun ratusan ribu kali, dan telah disepadukan dan digunakan oleh projek sumber terbuka yang terkenal seperti LangChain, LangChain-Chachat, llama_index, dsb.

Pegawai Langchain, pengasas bersama dan Ketua Pegawai Eksekutif LangChain Harrison Chase, pengasas Deep trading Yam Peleg dan pengaruh komuniti lain menyatakan kebimbangan mengenai BGE.

Mematuhi sumber terbuka dan keterbukaan, mempromosikan inovasi kolaboratif, sistem pembangunan teknologi model besar Sumber Pintar FlagOpen BGE telah menambah bahagian FlagEmbedding baharu, memfokuskan pada teknologi dan model Benamkan adalah salah satu BGE berprofil tinggi projek sumber terbuka. FlagOpen komited untuk membina infrastruktur teknologi kecerdasan buatan dalam era model besar, dan akan terus membuka teknologi tindanan penuh model besar yang lebih lengkap kepada akademia dan industri pada masa hadapan

Atas ialah kandungan terperinci Zhiyuan membuka 300 juta data latihan model vektor semantik, dan model BGE terus dikemas kini secara berulang.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- tencent qqmail plugin是什么软件

- ai合并图层的快捷键是什么

- Terdapat petunjuk tersembunyi dalam kertas GPT-4: GPT-5 boleh melengkapkan latihan, dan OpenAI akan mendekati AGI dalam masa dua tahun

- Enjin Gunung Berapi membantu Teknologi Shenzhen mengeluarkan model pra-latihan molekul 3D pertama dalam industri Uni-Mol

- NUS dan Byte bekerjasama merentas industri untuk mencapai latihan 72 kali lebih pantas melalui pengoptimuman model, dan memenangi Kertas Cemerlang AAAI2023.