Rumah >Peranti teknologi >AI >ReLU menggantikan softmax dalam Transformer visual, helah baharu DeepMind mengurangkan kos dengan cepat

ReLU menggantikan softmax dalam Transformer visual, helah baharu DeepMind mengurangkan kos dengan cepat

- PHPzke hadapan

- 2023-09-20 20:53:021397semak imbas

Seni bina Transformer telah digunakan secara meluas dalam bidang pembelajaran mesin moden. Perkara utama ialah menumpukan pada salah satu komponen teras transformer, yang mengandungi softmax, yang digunakan untuk menjana pengedaran kebarangkalian token. Softmax mempunyai kos yang lebih tinggi kerana ia melakukan pengiraan eksponen dan menjumlahkan panjang jujukan, yang menjadikan penyejajaran sukar dilakukan.

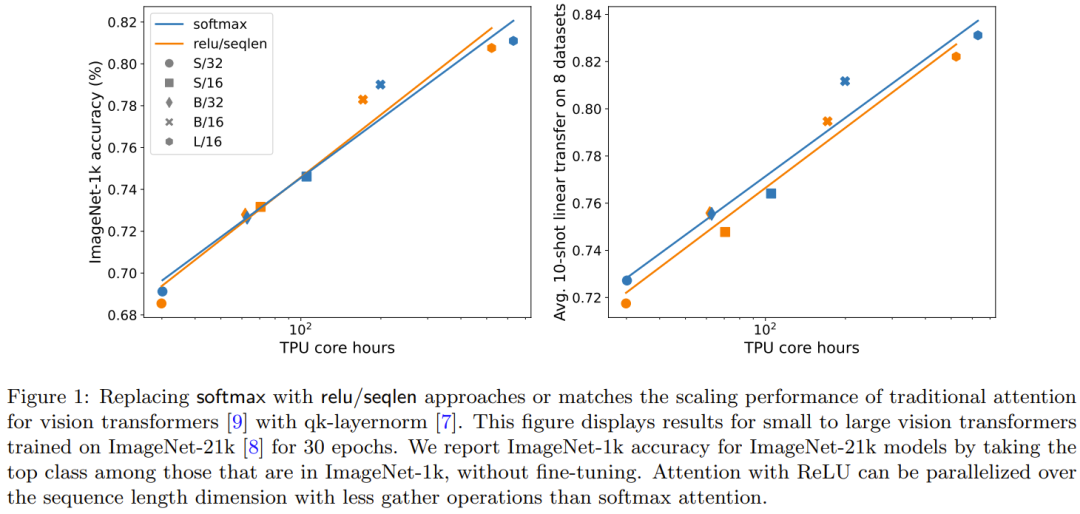

Google DeepMind menghasilkan idea baharu: Ganti operasi softmax dengan kaedah baharu yang tidak semestinya mengeluarkan taburan kebarangkalian. Mereka juga mendapati bahawa menggunakan ReLU dibahagikan dengan panjang jujukan boleh menghampiri atau menyaingi softmax tradisional apabila digunakan dengan Transformer visual.

Pautan kertas: https://arxiv.org/abs/2309.08586#🎜🎜🎜

Hasil ini membawa penyelesaian baharu kepada penyejajaran, kerana ReLU memfokuskan pada menumpukan perhatian dan boleh diselaraskan dalam dimensi panjang jujukan, dan operasi pengumpulan yang diperlukan adalah lebih kecil daripada tumpuan tradisional untuk menumpukan perhatian#🎜 🎜#Kaedah

Kuncinya ialah menumpukan perhatian#🎜🎜🎜🎜🎜 🎜#

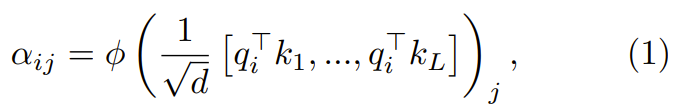

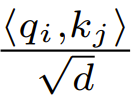

Perkara penting untuk difokuskan ialah mengubah pertanyaan, kunci dan nilai {q_i, k_i, v_i} dimensi d melalui proses dua langkah# 🎜🎜# Dalam langkah pertama, perkara utama ialah fokus pada berat melalui formula berikut

:#🎜 🎜##🎜🎜 #

di mana ϕ biasanya softmax.

di mana ϕ biasanya softmax.

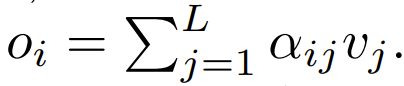

Langkah seterusnya, menggunakan fokus ini ialah memfokus pada pemberat untuk mengira output  Kertas ini meneroka penggunaan pengiraan mengikut titik untuk menggantikan ϕ .

Kertas ini meneroka penggunaan pengiraan mengikut titik untuk menggantikan ϕ .

ReLU Perkara utama ialah fokus

#🎜,Dep🎜 ϕ = softmax dalam Persamaan 1,

#🎜,Dep🎜 ϕ = softmax dalam Persamaan 1,

ialah alternatif yang lebih baik. Mereka akan menggunakan Intinya fokus dipanggil ReLU Intinya fokus.

Fokus titik demi titik yang diperluaskan ialah fokus  #🎜🎜🎜🎜 #🎜 Penyelidik juga telah meneroka pelbagai pilihan

#🎜🎜🎜🎜 #🎜 Penyelidik juga telah meneroka pelbagai pilihan  melalui eksperimen, di mana α ∈ [0, 1] dan h ∈ {relu,relu² , gelu,softplus, identiti,relu6, sigmoid} .

melalui eksperimen, di mana α ∈ [0, 1] dan h ∈ {relu,relu² , gelu,softplus, identiti,relu6, sigmoid} .

Kandungan yang perlu ditulis semula ialah: lanjutan panjang urutan

#🎜 ##🎜 🎜#Mereka juga mendapati bahawa ketepatan boleh dipertingkatkan jika dilanjutkan dengan projek yang melibatkan panjang jujukan L. Usaha penyelidikan terdahulu yang cuba mengeluarkan softmax tidak menggunakan skim penskalaan ini

Antara Transformers yang kini menggunakan softmax dan fokus pada reka bentuk, terdapat  , yang bermaksud

, yang bermaksud  Walaupun ini tidak mungkin menjadi syarat yang diperlukan,

Walaupun ini tidak mungkin menjadi syarat yang diperlukan,  boleh memastikan bahawa semasa permulaan

boleh memastikan bahawa semasa permulaan  kerumitan ialah

kerumitan ialah  , Mengekalkan keadaan ini boleh mengurangkan keperluan untuk menukar hiperparameter lain apabila menggantikan softmax.

, Mengekalkan keadaan ini boleh mengurangkan keperluan untuk menukar hiperparameter lain apabila menggantikan softmax.

Semasa permulaan, elemen q dan k ialah O (1), jadi  juga akan menjadi O (1). Fungsi pengaktifan seperti ReLU mengekalkan O (1), jadi faktor

juga akan menjadi O (1). Fungsi pengaktifan seperti ReLU mengekalkan O (1), jadi faktor  diperlukan untuk menjadikan kerumitan

diperlukan untuk menjadikan kerumitan  menjadi

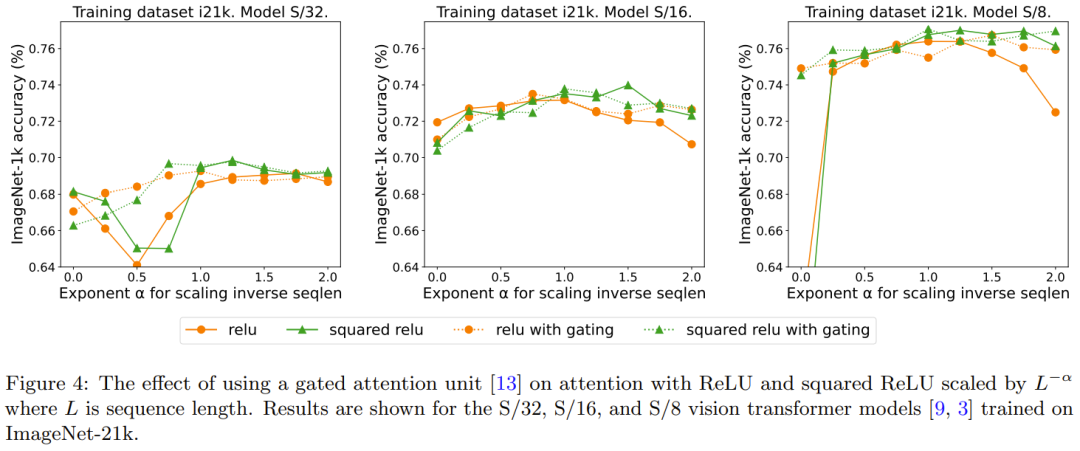

menjadi  . . Paksi-x menunjukkan jumlah masa pengiraan kernel yang diperlukan untuk eksperimen dalam jam. Kelebihan besar ReLU ialah ia boleh diselaraskan dalam dimensi panjang jujukan, yang memerlukan operasi pengumpulan yang lebih sedikit daripada softmax. . daripada alternatif tepat kepada softmax. Secara khusus, ia adalah menggunakan relu, relu², gelu, softplus, identiti dan kaedah lain untuk menggantikan softmax. Paksi-X ialah α. Paksi Y ialah ketepatan model S/32, S/16 dan S/8 Vision Transformer. Keputusan terbaik biasanya diperoleh apabila α menghampiri 1. Memandangkan tiada ketaklinearan optimum yang jelas, mereka menggunakan ReLU dalam eksperimen utama mereka kerana ia lebih pantas.

. . Paksi-x menunjukkan jumlah masa pengiraan kernel yang diperlukan untuk eksperimen dalam jam. Kelebihan besar ReLU ialah ia boleh diselaraskan dalam dimensi panjang jujukan, yang memerlukan operasi pengumpulan yang lebih sedikit daripada softmax. . daripada alternatif tepat kepada softmax. Secara khusus, ia adalah menggunakan relu, relu², gelu, softplus, identiti dan kaedah lain untuk menggantikan softmax. Paksi-X ialah α. Paksi Y ialah ketepatan model S/32, S/16 dan S/8 Vision Transformer. Keputusan terbaik biasanya diperoleh apabila α menghampiri 1. Memandangkan tiada ketaklinearan optimum yang jelas, mereka menggunakan ReLU dalam eksperimen utama mereka kerana ia lebih pantas.

Kesan QK-Layern Corming boleh dinyatakan semula seperti berikut:

QK-Layernorm digunakan dalam eksperimen utama, di mana pertanyaan dan kunci akan dikira. fokus pada pemberat Sebelum dilalui melalui LayerNorm. DeepMind menyatakan bahawa sebab untuk menggunakan qk-layernorm secara lalai ialah ia adalah perlu untuk mengelakkan ketidakstabilan apabila menskalakan saiz model. Rajah 3 menunjukkan kesan pengalihan qk-layernorm. Keputusan ini menunjukkan bahawa qk-layernorm mempunyai sedikit impak pada model ini, tetapi keadaan mungkin berbeza apabila saiz model menjadi lebih besar.

Penerangan Semula: Kesan tambahan pada pintu

Kajian terdahulu yang mengalih keluar softmax menggunakan pendekatan menambah unit gating, tetapi kaedah ini tidak boleh menskalakan dengan panjang jujukan. Khususnya, dalam unit perhatian berpagar, terdapat unjuran tambahan yang menghasilkan output yang diperolehi oleh gabungan darab mengikut unsur sebelum unjuran output. Rajah 4 meneroka sama ada kehadiran get menghapuskan keperluan untuk menulis semula apa itu: lanjutan panjang jujukan. Secara keseluruhannya, DeepMind memerhatikan bahawa ketepatan terbaik dicapai dengan atau tanpa get dengan meningkatkan panjang jujukan, yang memerlukan penulisan semula. Juga ambil perhatian bahawa untuk model S/8 yang menggunakan ReLU, mekanisme gating ini meningkatkan masa teras yang diperlukan untuk eksperimen sebanyak kira-kira 9.3%.

Atas ialah kandungan terperinci ReLU menggantikan softmax dalam Transformer visual, helah baharu DeepMind mengurangkan kos dengan cepat. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!