Rumah >Peranti teknologi >AI >Robot tersembunyi dalam iPhone: berdasarkan seni bina GPT-2, dengan tokenizer emoji, dibangunkan oleh alumni MIT

Robot tersembunyi dalam iPhone: berdasarkan seni bina GPT-2, dengan tokenizer emoji, dibangunkan oleh alumni MIT

- PHPzke hadapan

- 2023-09-20 13:05:09879semak imbas

Peminat telah mendedahkan "rahsia" Apple's Transformer

Di bawah pengaruh gelombang model besar, malah Apple konservatif pasti akan menyebut "Transformer" dalam setiap sidang akhbar

Sebagai contoh, tahun ini Di WWDC, Apple mengumumkan bahawa versi baharu iOS dan macOS akan mempunyai model bahasa Transformer terbina dalam untuk menyediakan kaedah input dengan keupayaan ramalan teks.

Walaupun pegawai Apple tidak mendedahkan lebih banyak maklumat, peminat teknologi tidak sabar menunggu

Seorang lelaki bernama Jack Cook berjaya membuka lembaran baharu macOS Sonoma beta dan secara tidak dijangka menemui banyak dari segi maklumat baharu seni bina, Cook percaya bahawa model bahasa Apple lebih berkemungkinan berdasarkan

GPT-2- .

- Dari segi tokenizer, emoticon

- sangat menonjol di kalangan mereka. Untuk butiran lanjut, mari lihat. Berdasarkan seni bina GPT-2

Pertama sekali, mari kita semak fungsi yang boleh dicapai oleh model bahasa berasaskan Transformer Apple pada iPhone, MacBook dan peranti lain

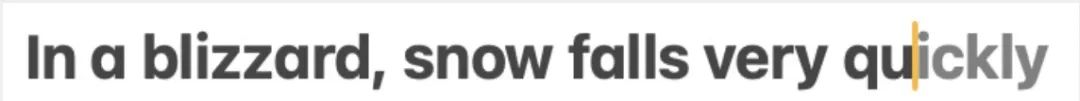

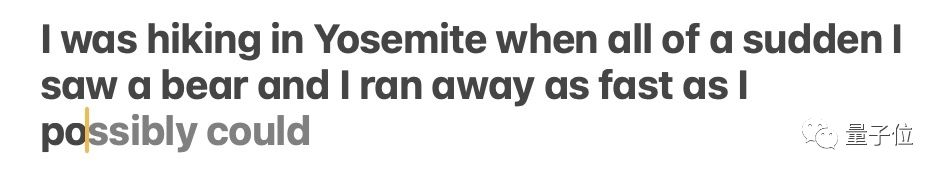

Kandungan yang perlu ditulis semula ialah: terutamanya ditunjukkan dalam kaedah input. Dengan sokongan model bahasa, kaedah input Apple sendiri boleh mencapai ramalan perkataan dan fungsi pembetulan ralat

Jack Cook mengujinya secara khusus dan mendapati bahawa fungsi ini melaksanakan ramalan perkataan tunggal.

Model kadangkala meramalkan beberapa perkataan yang akan datang, tetapi ini terhad kepada situasi di mana semantik ayat itu sangat jelas, lebih serupa dengan Ciri autolengkap Gmail.

Model kadangkala meramalkan beberapa perkataan yang akan datang, tetapi ini terhad kepada situasi di mana semantik ayat itu sangat jelas, lebih serupa dengan Ciri autolengkap Gmail.

Kandungan yang perlu ditulis semula ialah: △Sumber: catatan blog Jack Cook

Jadi di manakah model ini dipasang? Selepas beberapa penggalian yang mendalam, Brother Cook menentukan:

Jadi di manakah model ini dipasang? Selepas beberapa penggalian yang mendalam, Brother Cook menentukan:

Saya menemui model teks ramalan dalam /System/Library/LinguisticData/RequiredAssets_en.bundle/AssetData/en.lm/unilm.bundle.

Alasannya ialah:

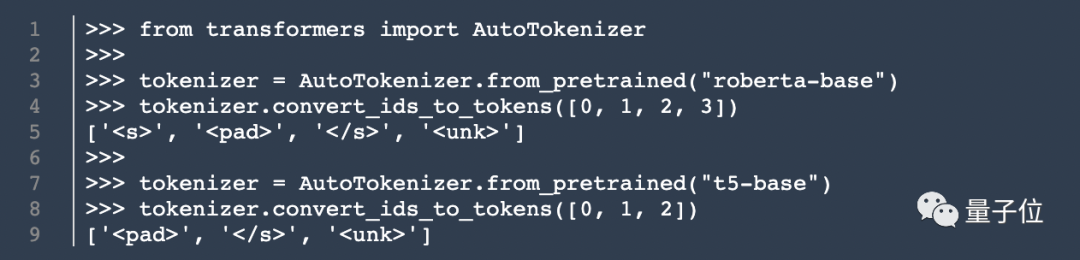

Banyak fail dalam unilm.bundle tidak wujud dalam macOS Ventura (13.5), tetapi hanya muncul dalam versi baharu macOS Sonoma beta (14.0). Terdapat fail sp.dat dalam unilm.bundle, yang boleh didapati dalam kedua-dua Ventura dan Sonoma beta, tetapi versi beta Sonoma telah dikemas kini dengan set token yang jelas kelihatan seperti tokenizer.- Bilangan token dalam sp.dat boleh sepadan dengan dua fail dalam unilm.bundle - unilm_joint_cpu.espresso.shape dan unilm_joint_ane.espresso.shape. Kedua-dua fail ini menerangkan bentuk setiap lapisan dalam model Espresso/CoreML.

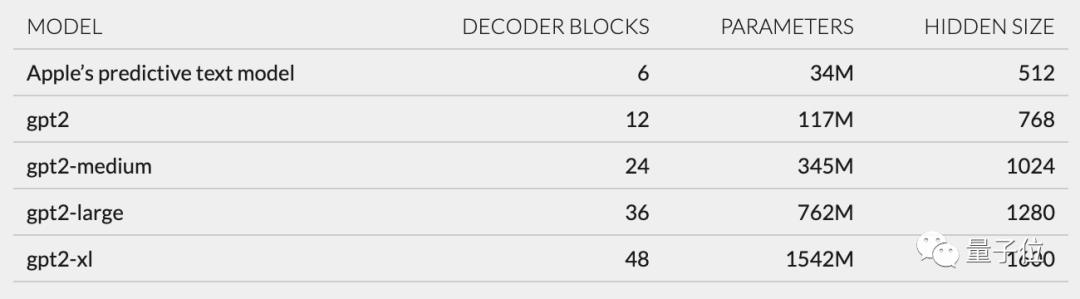

- Spekulasi lanjut, mengikut struktur rangkaian yang diterangkan dalam unilm_joint_cpu, saya percaya bahawa model Apple dibina berdasarkan seni bina GPT-2

- Komponen utama termasuk pembenaman token, pengekodan kedudukan, blok penyahkod dan lapisan output, dalam setiap Perkataan yang serupa dengan "gpt2_transformer_layer_3d" akan muncul dalam setiap blok penyahkod

Berdasarkan saiz setiap lapisan, saya juga membuat spekulasi bahawa model Apple ialah kira-kira 34 juta parameter, saiz lapisan tersembunyi ialah 512. Dalam erti kata lain, ia lebih kecil daripada versi terkecil GPT-2

Berdasarkan saiz setiap lapisan, saya juga membuat spekulasi bahawa model Apple ialah kira-kira 34 juta parameter, saiz lapisan tersembunyi ialah 512. Dalam erti kata lain, ia lebih kecil daripada versi terkecil GPT-2

Saudara saya percaya bahawa ini adalah terutamanya kerana Apple mahukan model yang tidak terlalu memakan kuasa, tetapi boleh berjalan dengan cepat dan kerap pada masa yang sama.

Dan kenyataan rasmi Apple di WWDC ialah, "Setiap kali kekunci diklik, iPhone akan menjalankan model sekali."

Walau bagaimanapun, ini juga bermakna model ramalan teks ini tidak dapat meneruskan ayat atau perenggan dengan baik

Kandungan yang perlu ditulis semula ialah: △Sumber: catatan blog Jack Cook

Selain seni bina model, Cook Xiao Saya juga mencari maklumat tentang tokenizer

Selain seni bina model, Cook Xiao Saya juga mencari maklumat tentang tokenizer

.

Dia menemui satu set 15,000 token dalam unilm.bundle/sp.dat Perlu diingat bahawa ia mengandungi 100 emoji.

Masak Dedahkan Tukang Masak

Walaupun Tukang Masak ini bukan Tukang Masak, catatan blog saya masih menarik perhatian ramai sebaik sahaja ia diterbitkan

Berdasarkan penemuannya, netizen dengan penuh semangat membincangkan pengalaman pengguna dan kecanggihan Apple aplikasi teknologi.

Berbalik kepada Jack Cook sendiri, dia lulus dari MIT dengan ijazah sarjana muda dan ijazah sarjana dalam sains komputer, dan kini sedang belajar untuk ijazah sarjana dalam sains sosial Internet dari Universiti Oxford.

Beliau pernah berkhidmat di NVIDIA, menumpukan pada penyelidikan model bahasa seperti BERT. Beliau juga berkhidmat sebagai jurutera R&D kanan untuk pemprosesan bahasa semula jadi di The New York Times

Atas ialah kandungan terperinci Robot tersembunyi dalam iPhone: berdasarkan seni bina GPT-2, dengan tokenizer emoji, dibangunkan oleh alumni MIT. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!