Rumah >Peranti teknologi >AI >Sehingga 38TB data bocor secara tidak sengaja! Pasukan penyelidik AI Microsoft 'menyebabkan masalah' Bagaimana untuk memastikan keselamatan data?

Sehingga 38TB data bocor secara tidak sengaja! Pasukan penyelidik AI Microsoft 'menyebabkan masalah' Bagaimana untuk memastikan keselamatan data?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-09-19 17:33:091442semak imbas

Financial Associated Press, 19 September (Editor Xiaoxiang)Sejak kebangkitan kegilaan kecerdasan buatan generatif tahun ini, terdapat pertikaian berterusan tentang keselamatan data. Menurut penyelidikan terbaru daripada syarikat keselamatan siber, pasukan penyelidikan kecerdasan buatan Microsoft secara tidak sengaja membocorkan sejumlah besar data peribadi pada platform pembangunan perisian GitHub beberapa bulan lalu, yang termasuk lebih daripada 30,000 maklumat dalaman tentang pasukan Microsoft.

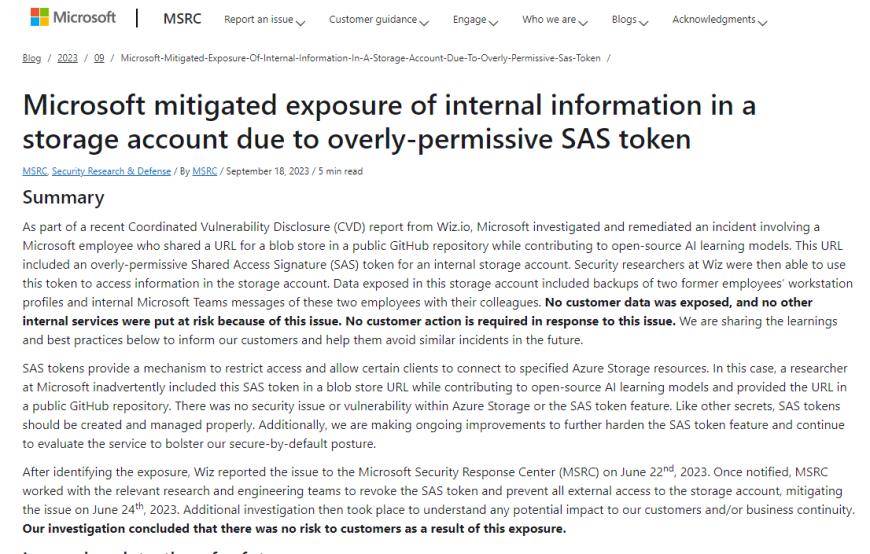

Sebuah pasukan di syarikat keselamatan awan Wiz mendapati bahawa data latihan sumber terbuka telah dibocorkan oleh pasukan penyelidik Microsoft apabila ia dikeluarkan pada GitHub pada bulan Jun. Data yang dihoskan awan telah dibocorkan melalui pautan yang salah konfigurasi.

Menurut catatan blog oleh Wiz, pasukan penyelidik AI Microsoft pada mulanya mengeluarkan data latihan sumber terbuka pada GitHub. Walau bagaimanapun, disebabkan salah konfigurasi token SAS, mereka tersilap mengkonfigurasi kebenaran untuk memberikan keseluruhan akaun storan dan juga memberi pengguna kawalan penuh dan bukannya hanya kebenaran baca sahaja. Ini bermakna mereka boleh memadam dan menulis ganti fail sedia ada

Menurut Wiz, 38TB data yang bocor termasuk sandaran cakera komputer peribadi dua pekerja Microsoft ini mengandungi kata laluan dan kunci untuk perkhidmatan Microsoft dan lebih daripada 30,000 maklumat Pasukan Microsoft dalaman daripada 359 pekerja Microsoft

Para penyelidik Wiz menegaskan bahawa perkongsian data terbuka adalah bahagian penting dalam latihan AI. Namun, jika tidak digunakan dengan betul, perkongsian data berskala besar juga boleh membawa risiko besar kepada syarikatWiz CTO dan pengasas bersama Ami Luttwak menegaskan bahawa Wiz berkongsi situasi dengan Microsoft pada bulan Jun, dan Microsoft segera memadamkan data yang terdedah. Pasukan penyelidik Wiz menemui cache data ini semasa mengimbas Internet untuk storan yang salah konfigurasi.

Sebagai tindak balas, jurucakap Microsoft mengulas selepas itu, "Kami telah mengesahkan bahawa tiada data pelanggan telah didedahkan dan tiada perkhidmatan dalaman lain telah terjejas

Microsoft berkata dalam catatan blog pada hari Isnin bahawa ia telah menyiasat dan membetulkan insiden yang melibatkan pekerja Microsoft yang berkongsi URL ke model pembelajaran kecerdasan buatan sumber terbuka dalam repositori GitHub awam. Microsoft berkata data yang terdedah dalam akaun storan termasuk sandaran fail konfigurasi stesen kerja dua bekas pekerja, serta maklumat dalaman Microsoft Teams mengenai dua bekas pekerja dan rakan sekerja mereka.

Atas ialah kandungan terperinci Sehingga 38TB data bocor secara tidak sengaja! Pasukan penyelidik AI Microsoft 'menyebabkan masalah' Bagaimana untuk memastikan keselamatan data?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI