Rumah >Peranti teknologi >AI >Lao Huang memberikan H100 rangsangan: Nvidia melancarkan pakej pecutan model besar, menggandakan kelajuan inferens Llama2

Lao Huang memberikan H100 rangsangan: Nvidia melancarkan pakej pecutan model besar, menggandakan kelajuan inferens Llama2

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-09-18 15:45:071147semak imbas

Kelajuan inferens model besar telah meningkat dua kali ganda dalam masa satu bulan sahaja!

Baru-baru ini, NVIDIA mengumumkan pelancaran "pakej darah ayam" yang direka khas untuk H100, bertujuan untuk mempercepatkan proses inferens LLM

Mungkin kini anda tidak perlu menunggu GH200 dihantar tahun hadapan .

.

Kuasa pengkomputeran GPU sentiasa mempengaruhi prestasi model besar Kedua-dua pembekal perkakasan dan pengguna berharap untuk memperoleh kelajuan pengkomputeran yang lebih pantas

Sebagai pembekal perkakasan terbesar di sebalik model besar, NVIDIA saya telah mengkaji cara perkakasan. mempercepatkan model besar.

Melalui kerjasama dengan beberapa syarikat AI, NVIDIA akhirnya melancarkan program pengoptimuman inferens model besar TensorRT-LLM (sementara dirujuk sebagai TensorRT).

TensorRT bukan sahaja boleh menggandakan kelajuan inferens model besar, tetapi juga sangat mudah digunakan.

Tidak perlu mempunyai pengetahuan mendalam tentang C++ dan CUDA, anda boleh menyesuaikan strategi pengoptimuman dengan cepat dan menjalankan model besar dengan lebih pantas pada H100.

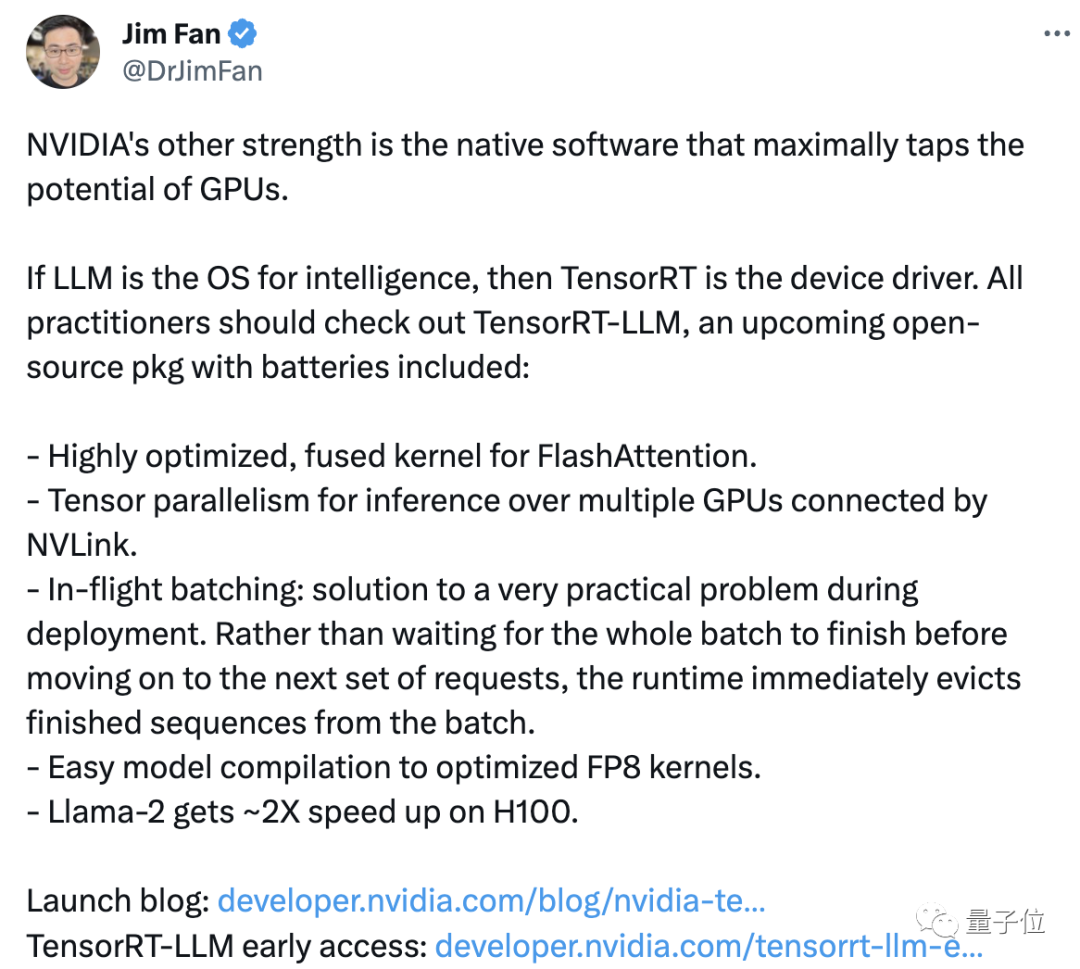

Saintis NVIDIA Jim Fan mengetweet semula dan mengulas bahawa "kelebihan lain" NVIDIA ialah perisian sokongan yang boleh memaksimumkan penggunaan prestasi GPU.

NVIDIA menyuntik tenaga baharu ke dalam produknya melalui perisian, sama seperti mengamalkan kata-kata Lao Huang "lebih banyak anda membeli, lebih banyak anda menjimatkan". Namun, ini tidak menghalang sesetengah pihak beranggapan harga produk tersebut terlalu tinggi

Selain harga, ada netizen turut mempersoalkan keputusan operasinya:

Kami sentiasa melihat berapa kali prestasinya dipertingkatkan. (dalam publisiti), tetapi Apabila saya menjalankan Llama 2 sendiri, saya masih boleh memproses berpuluh-puluh token sesaat.

Untuk TensorRT, kami memerlukan ujian lanjut untuk menentukan sama ada ia benar-benar berkesan. Mari kita lihat dengan lebih dekat TensorRT

Menggandakan kelajuan inferens model besar

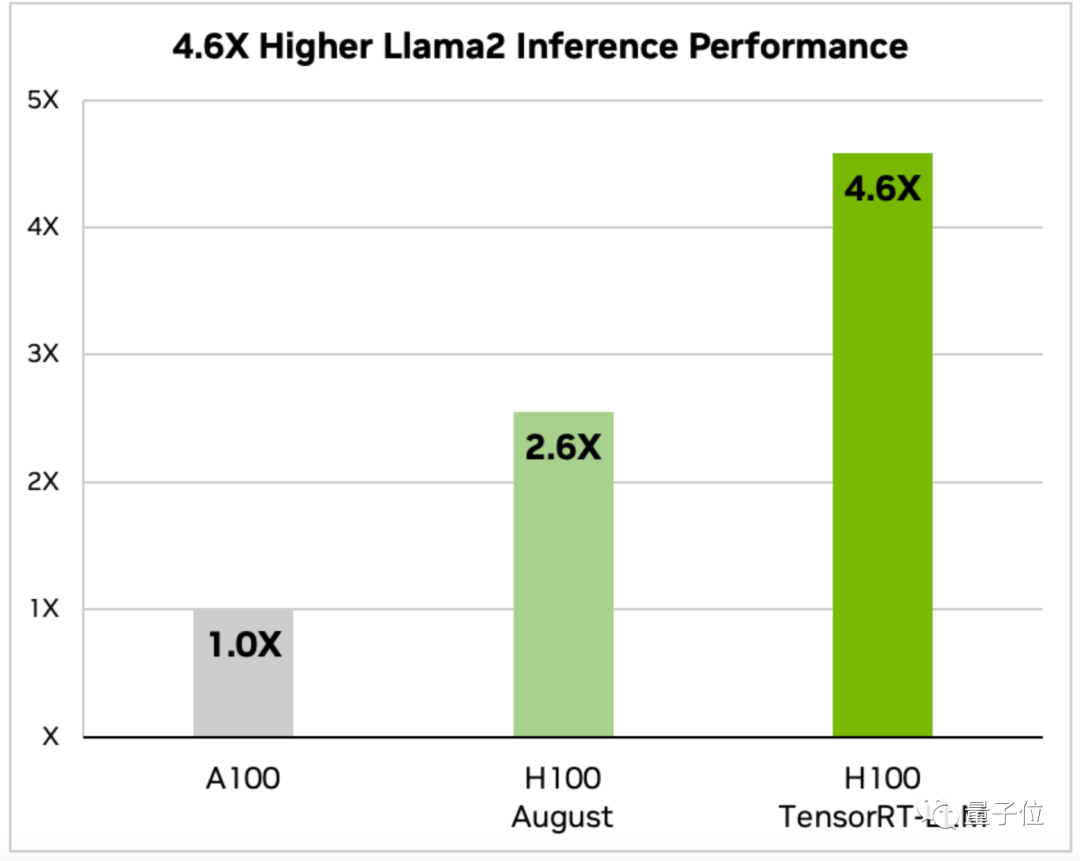

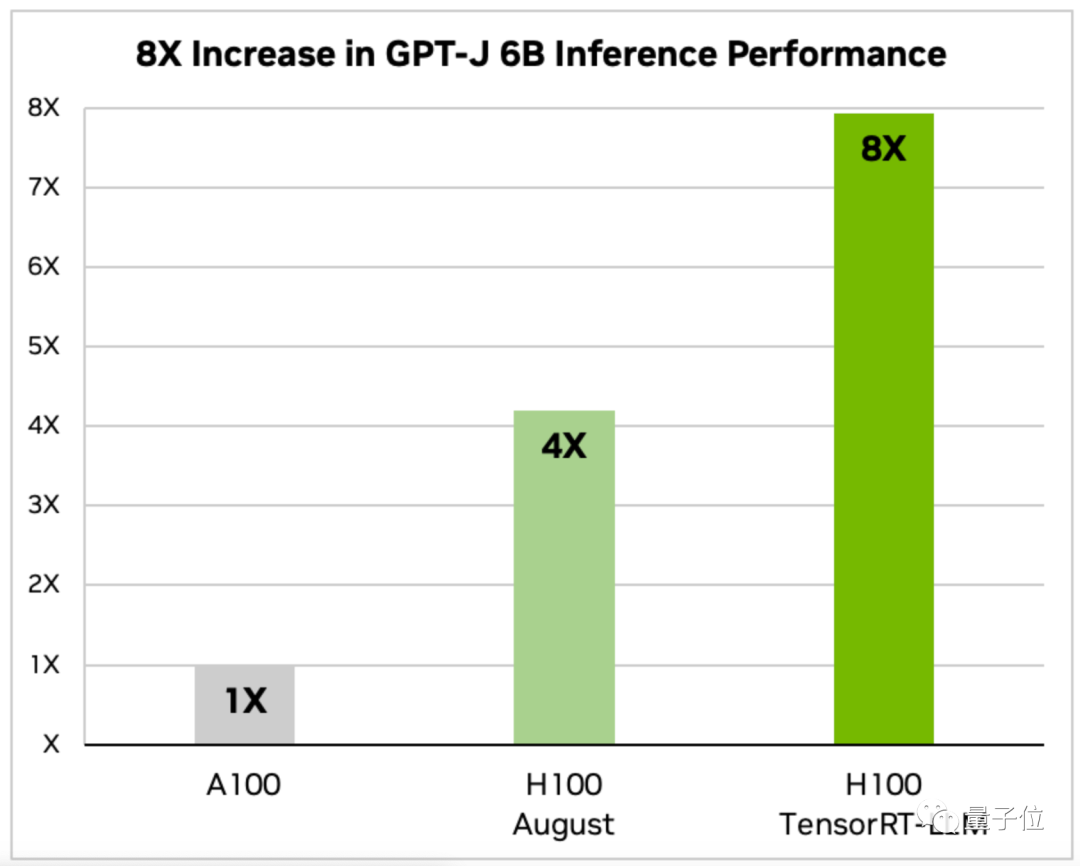

TensorRT-LLM dioptimumkan H100 Seberapa pantas untuk menjalankan model besar?

Pengumuman Nvidia menyediakan data untuk dua model, Llama 2 dan GPT-J-6B. . daripada versi sebelumnya dan 2 kali ganda daripada versi Ogos yang tidak dioptimumkan

.

API ini menyepadukan pengkompil pembelajaran mendalam, pengoptimuman kernel, pra/pasca pemprosesan dan fungsi komunikasi berbilang nod. .

Terdapat juga versi tersuai untuk model biasa seperti GPT(2/3) dan Llama, yang boleh digunakan"di luar kotak" .

.

Melalui kernel AI sumber terbuka terkini dalam TensorRT, pembangun juga boleh mengoptimumkan model itu sendiri, termasuk algoritma perhatian FlashAttention, yang sangat mempercepatkan Transformer.

TensorRT ialah enjin inferens berprestasi tinggi untuk mengoptimumkan inferens pembelajaran mendalam. Ia mengoptimumkan kelajuan inferens LLM dengan menggunakan teknologi seperti pengkomputeran ketepatan campuran, pengoptimuman graf dinamik dan gabungan lapisan. Khususnya, TensorRT meningkatkan kelajuan inferens dengan mengurangkan jumlah pengiraan dan keperluan lebar jalur memori dengan menukar pengiraan titik terapung kepada pengiraan titik terapung separuh ketepatan. Selain itu, TensorRT juga menggunakan teknologi pengoptimuman graf dinamik untuk memilih struktur rangkaian optimum secara dinamik berdasarkan ciri-ciri data input, meningkatkan lagi kelajuan inferens. Selain itu, TensorRT juga menggunakan teknologi gabungan lapisan untuk menggabungkan berbilang lapisan pengkomputeran ke dalam lapisan pengkomputeran yang lebih cekap, mengurangkan pengkomputeran dan akses memori overhed dan meningkatkan lagi kelajuan inferens. Ringkasnya, TensorRT telah meningkatkan dengan ketara kelajuan dan kecekapan inferens LLM melalui pelbagai teknologi pengoptimuman

Pertama sekali, ia mendapat manfaat daripada TensorRTmengoptimumkan kaedah kerja kolaboratif berbilang nod.

Model besar seperti Llama tidak boleh dijalankan pada satu kad. Ia memerlukan berbilang GPU untuk dijalankan bersama.

Pada masa lalu, kerja ini memerlukan orang ramai untuk membuka model secara manual untuk mencapainya.

Dengan TensorRT, sistem boleh memisahkan model secara automatik dan menjalankannya dengan cekap merentas berbilang GPU melalui NVLink

Kedua, TensorRT juga menggunakan penjadualan yang dioptimumkan yang dipanggil teknologi Pemprosesan Kelompok Dinamik.

Semasa proses inferens, LLM sebenarnya meneruskan dengan melaksanakan lelaran model beberapa kali

Teknologi batching dinamik akan menendang keluar urutan yang lengkap serta-merta dan bukannya menunggu keseluruhan kumpulan tugasan selesai sebelum memproses set permintaan seterusnya .

Dalam ujian sebenar, teknologi batching dinamik berjaya mengurangkan pemprosesan permintaan GPU LLM sebanyak separuh, sekali gus mengurangkan kos operasi dengan ketara

Satu lagi perkara penting ialah menukar nombor titik terapung ketepatan 16-bit kepada Ketepatan 8-bit , sekali gus mengurangkan penggunaan memori.

Berbanding dengan FP16 dalam fasa latihan, FP8 mempunyai penggunaan sumber yang lebih rendah dan lebih tepat berbanding INT-8 Ia boleh meningkatkan prestasi tanpa menjejaskan ketepatan model

Menggunakan enjin Hopper Transformer, sistem akan melengkapkan FP16 secara automatik kepada kompilasi penukaran FP8 tanpa mengubah suai mana-mana kod secara manual dalam model

Pada masa ini, versi awal TensorRT-LLM tersedia untuk dimuat turun, dan versi rasmi akan dilancarkan dan disepadukan ke dalam rangka kerja NeMo dalam masa beberapa minggu

Satu Lagi Perkara

Setiap kali peristiwa besar berlaku, sosok "Leewenhoek" amat diperlukan.

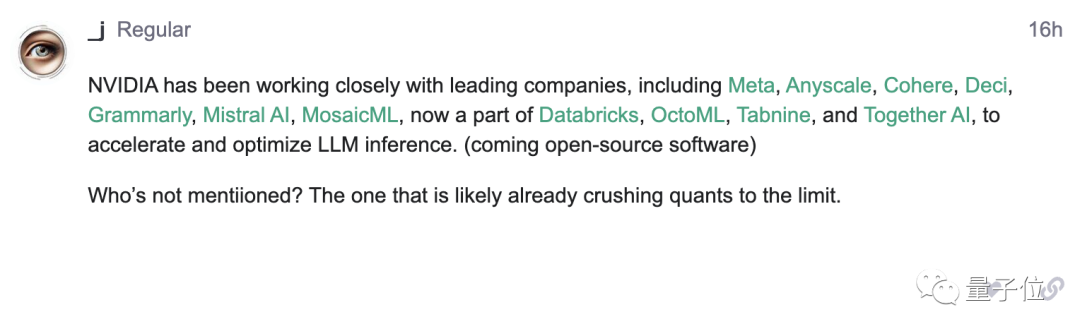

Dalam pengumuman Nvidia, ia menyebut kerjasama dengan syarikat kecerdasan buatan terkemuka seperti Meta, tetapi tidak menyebut OpenAI

Daripada pengumuman ini, beberapa netizen menemui perkara ini dan menyiarkannya ke forum OpenAI:

Sila Izinkan saya lihat siapa belum mendapat petunjuk oleh Lao Huang (kepala anjing manual)

Apakah jenis "kejutan" yang anda jangkakan Lao Huang akan bawakan kepada kami?

Atas ialah kandungan terperinci Lao Huang memberikan H100 rangsangan: Nvidia melancarkan pakej pecutan model besar, menggandakan kelajuan inferens Llama2. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!