Rumah >Peranti teknologi >AI >Digunakan untuk lidar point cloud seliaan sendiri pra-latihan SOTA!

Digunakan untuk lidar point cloud seliaan sendiri pra-latihan SOTA!

- 王林ke hadapan

- 2023-09-15 09:53:071495semak imbas

Idea kertas:

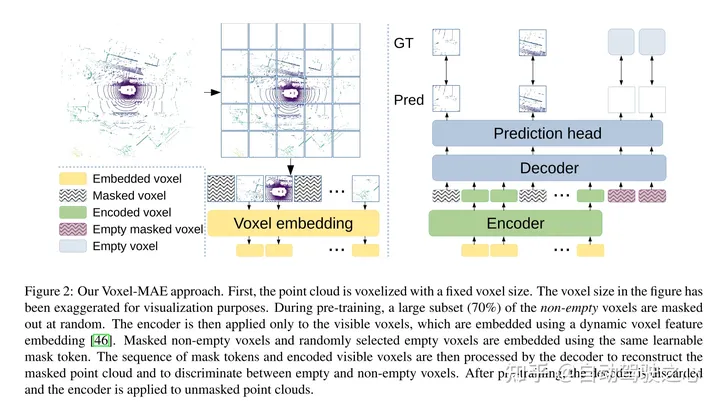

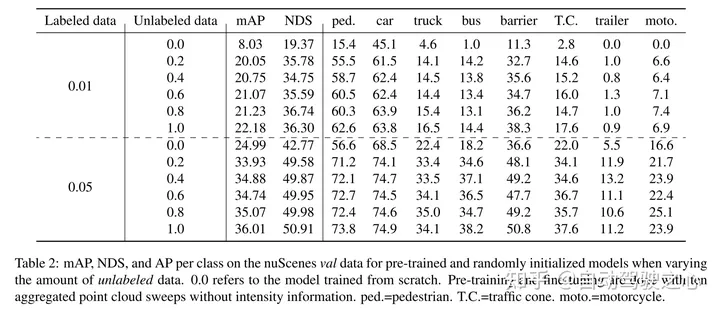

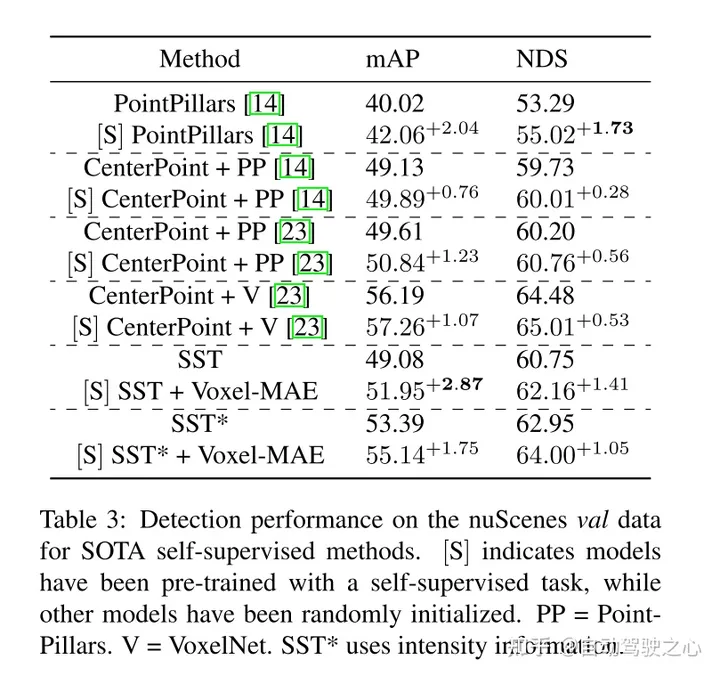

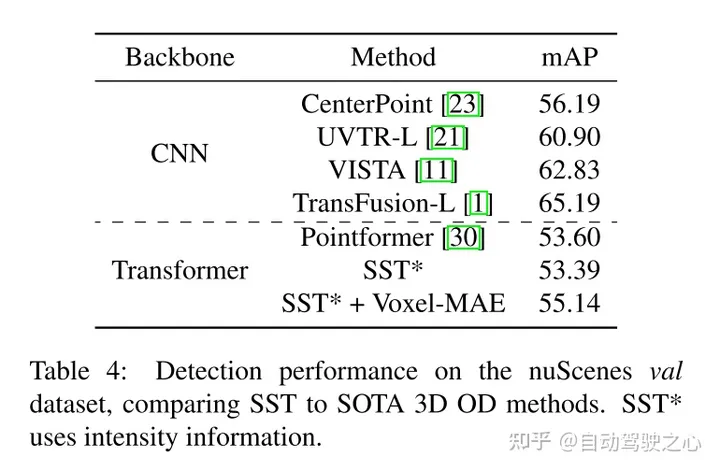

pengekodan auto bertopeng telah menjadi paradigma pra-latihan yang berjaya untuk model Transformer teks, imej dan awan titik terbaharu . Set data kereta mentah sesuai untuk pra-latihan diselia sendiri kerana ia biasanya lebih murah untuk dikumpulkan berbanding anotasi untuk tugas seperti pengesanan objek 3D (OD). Walau bagaimanapun, pembangunan pengekod auto bertopeng untuk awan titik hanya tertumpu pada data sintetik dan dalaman. Oleh itu, kaedah sedia ada telah menyesuaikan perwakilan dan model mereka ke dalam awan titik kecil dan padat dengan ketumpatan titik seragam. Dalam kerja ini, kami mengkaji pengekodan auto bertopeng pada awan titik dalam tetapan automotif, yang jarang dan ketumpatannya boleh berbeza dengan ketara antara objek yang berbeza dalam pemandangan yang sama. Untuk tujuan ini, kertas kerja ini mencadangkan Voxel-MAE, skim pra-latihan pengekodan auto bertopeng mudah yang direka untuk perwakilan voxel. Kertas kerja ini melatih tulang belakang pengesan objek 3D berasaskan Transformer untuk membina semula voxel bertopeng dan membezakan voxel kosong daripada voxel bukan kosong. Kaedah kami meningkatkan prestasi OD 3D sebanyak 1.75 mAP dan 1.05 NDS pada dataset nuScenes yang mencabar. Tambahan pula, kami menunjukkan bahawa dengan menggunakan Voxel-MAE untuk pra-latihan, kami memerlukan hanya 40% data beranotasi untuk mengatasi prestasi data yang setara dengan pemulaan rawak.

Sumbangan utama:

Kertas kerja ini mencadangkan Voxel-MAE (penyerahan gaya MAE automatik pada awan titik voxelized.selia pra-latihan). kaedah) dan menilainya pada nuScenes set awan titik automotif yang besar. Kaedah dalam artikel ini ialah skim pra-latihan diselia sendiri yang pertama menggunakan tulang belakang Transformer awan titik automotif.

Kami menyesuaikan kaedah kami untuk perwakilan voxel dan menggunakan set tugas pembinaan semula yang unik untuk menangkap ciri awan titik tervoksel.

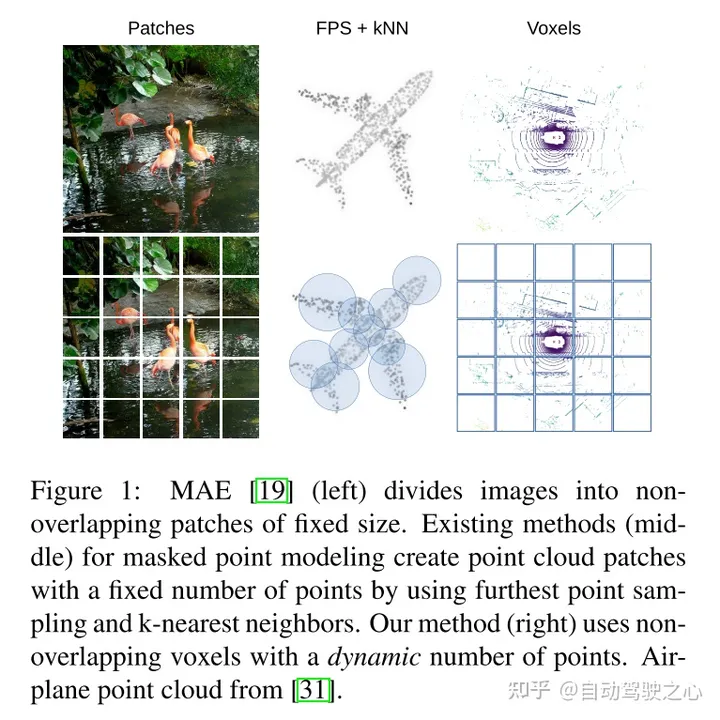

Makalah ini membuktikan bahawa kaedah kami adalah data yang cekap dan mengurangkan keperluan untuk data beranotasi. Dengan pra-latihan, kertas kerja ini mengatasi data yang diselia sepenuhnya apabila menggunakan hanya 40% daripada data beranotasi.

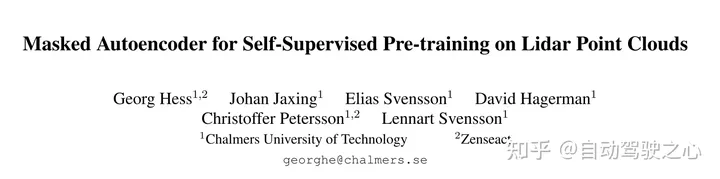

Tambahan pula, kertas kerja ini mendapati bahawa Voxel-MAE meningkatkan prestasi pengesan berasaskan Transformer sebanyak 1.75 mata peratusan dalam mAP dan 1.05 mata peratusan dalam NDS, berbanding dengan kaedah penyeliaan sendiri yang sedia ada prestasi meningkat sebanyak 2 kali ganda. Tujuan kerja ini adalah untuk memanjangkan pra-latihan gaya MAE kepada awan titik voxelized. Idea teras masih menggunakan pengekod untuk mencipta perwakilan terpendam yang kaya daripada pemerhatian separa input, dan kemudian menggunakan penyahkod untuk membina semula input asal, seperti yang ditunjukkan dalam Rajah 2. Selepas pra-latihan, pengekod digunakan sebagai tulang belakang pengesan objek 3D. Walau bagaimanapun, disebabkan perbezaan asas antara imej dan awan titik, beberapa pengubahsuaian diperlukan untuk latihan cekap Voxel-MAE.

Rajah 2: Kaedah Voxel-MAE artikel ini. Pertama, awan titik divoxel dengan saiz voxel tetap. Saiz voxel dalam angka telah dibesar-besarkan untuk tujuan visualisasi. Sebelum latihan, sebahagian besar (70%) voxel tidak kosong bertopeng secara rawak. Pengekod kemudiannya digunakan hanya pada voksel yang boleh dilihat, membenamkan voxel ini menggunakan pembenaman ciri voxel dinamik [46]. Voksel bukan kosong bertopeng dan voksel kosong yang dipilih secara rawak dibenamkan menggunakan token topeng boleh dipelajari yang sama. Penyahkod kemudian memproses jujukan token topeng dan jujukan voxel yang boleh dilihat yang dikodkan untuk membina semula awan titik bertopeng dan membezakan voxel kosong daripada voxel tidak kosong. Selepas pra-latihan, penyahkod dibuang dan pengekod digunakan pada awan titik yang tidak bertopeng.

Hasil percubaan:

#🎜##🎜#

#🎜##🎜🎜 #

#🎜

#🎜

引用:

Hess G, Jaxing J, Svensson E, et al. Pengekod auto bertopeng untuk pra-latihan diselia sendiri pada awan titik lidar[C]//Prosiding Persidangan Musim Sejuk IEEE/CVF mengenai Aplikasi Penglihatan Komputer. 2023: 350-359.

Atas ialah kandungan terperinci Digunakan untuk lidar point cloud seliaan sendiri pra-latihan SOTA!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!