Rumah >Peranti teknologi >AI >Menggunakan contoh GPU untuk menunjukkan sokongan Alibaba Cloud Linux 3 untuk ekosistem AI

Menggunakan contoh GPU untuk menunjukkan sokongan Alibaba Cloud Linux 3 untuk ekosistem AI

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-09-11 21:01:071270semak imbas

Baru-baru ini, Alibaba Cloud Linux 3 telah menyediakan beberapa pengoptimuman dan peningkatan untuk menjadikan pengalaman pembangunan AI lebih cekap Artikel ini adalah pratonton siri artikel "Pengenalan kepada Keupayaan AI Alibaba Cloud Linux 3". contoh sebagai contoh untuk menunjukkan Alibaba Cloud Linux 3. Sokongan untuk ekosistem AI. Seterusnya, dua siri artikel akan diterbitkan, terutamanya memperkenalkan imej pasaran awan berdasarkan Alinux untuk menyediakan pengguna dengan persekitaran perisian asas AI yang luar kotak, dan memperkenalkan pembezaan keupayaan AI berdasarkan AMD. Nantikan. Untuk maklumat lanjut tentang Alibaba Cloud Linux 3, sila lawati tapak web rasmi: https://www.aliyun.com/product/ecs/alinux

Apabila membangunkan aplikasi kecerdasan buatan (AI) pada sistem pengendalian Linux, pembangun mungkin menghadapi beberapa cabaran, termasuk tetapi tidak terhad kepada:

1. Pemacu GPU: Untuk menggunakan GPU NVIDIA untuk latihan atau inferens pada sistem Linux, pemacu GPU NVIDIA yang betul perlu dipasang dan dikonfigurasikan. Beberapa kerja tambahan mungkin diperlukan kerana sistem pengendalian yang berbeza dan model GPU mungkin memerlukan pemacu yang berbeza.

2. Kompilasi Rangka Kerja AI: Apabila pengaturcaraan dengan rangka kerja AI pada sistem Linux, anda perlu memasang dan mengkonfigurasi pengkompil yang sesuai dan kebergantungan lain. Rangka kerja ini selalunya memerlukan penyusunan, jadi anda perlu memastikan bahawa pengkompil dan kebergantungan lain dipasang dengan betul dan bahawa pengkompil dikonfigurasikan dengan betul.

3 Keserasian Perisian: Sistem pengendalian Linux menyokong banyak perisian dan alatan yang berbeza, tetapi mungkin terdapat isu keserasian antara versi dan pengedaran yang berbeza. Ini boleh menyebabkan sesetengah program tidak berjalan dengan betul atau tidak tersedia pada sesetengah sistem pengendalian. Oleh itu, kakitangan R&D perlu memahami keserasian perisian persekitaran kerja mereka dan membuat konfigurasi dan pengubahsuaian yang diperlukan.

4 Isu prestasi: Timbunan perisian AI ialah sistem yang sangat kompleks yang biasanya memerlukan pengoptimuman profesional bagi model CPU dan GPU yang berbeza untuk mencapai prestasi terbaiknya. Pengoptimuman prestasi kerjasama perisian dan perkakasan ialah tugas yang mencabar untuk susunan perisian AI, yang memerlukan teknologi dan kepakaran tahap tinggi.

Alibaba Cloud Linux 3, sistem pengendalian pelayan awan generasi ketiga Alibaba Cloud (selepas ini dirujuk sebagai "Alinux 3"), ialah sistem pengendalian komersial yang dibangunkan berdasarkan OS Anolis, menyediakan pemaju dengan platform pembangunan AI yang berkuasa , Dengan menyokong repo ekologi Dragon Lizard (epao), Alinux 3 telah menyokong sepenuhnya ekosistem GPU nvidia dan CUDA arus perdana, menjadikan pembangunan AI lebih mudah dan cekap. Selain itu, Alinux 3 juga menyokong pengoptimuman AI oleh platform CPU yang berbeza seperti rangka kerja AI arus perdana TensorFlow/PyTorch dan Intel/amd Ia juga akan memperkenalkan sokongan asli untuk SDK model besar seperti modelscope dan huggingface, menyediakan pembangun dengan sumber yang kaya dan alat. Sokongan ini menjadikan Alinux 3 sebagai platform pembangunan AI yang lengkap, menyelesaikan masalah pemaju AI tanpa perlu sentiasa bermain-main dengan persekitaran, menjadikan pengalaman pembangunan AI lebih mudah dan lebih cekap. Alinux 3 menyediakan pemaju dengan platform pembangunan AI yang berkuasa. Untuk menyelesaikan cabaran di atas yang mungkin dihadapi oleh pembangun, Alinux 3 menyediakan peningkatan pengoptimuman berikut:

1.Alinux 3 menyokong pembangun untuk memasang pemacu GPU NVIDIA arus perdana dan perpustakaan pecutan CUDA dengan satu klik dengan memperkenalkan Repositori Perisian Ekologi Naga Lizard (epao)

, menjimatkan masa pemadan versi pemacu dan pemasangan manual.2. Gudang epao juga menyediakan sokongan untuk versi rangka kerja AI arus perdana Tensorflow/PyTorch

Pada masa yang sama, masalah pergantungan rangka kerja AI akan diselesaikan secara automatik semasa proses pemasangan untuk melaksanakan kompilasi tambahan, dan boleh memadankan dengan pantas persekitaran sistem Python.3. Sebelum keupayaan AI Alinux 3 diberikan kepada pembangun, semua komponen telah diuji untuk keserasian

Pembangun boleh memasang keupayaan AI yang sepadan dengan satu klik, menghapuskan kebergantungan sistem yang mungkin muncul dalam konfigurasi persekitaran untuk meningkatkan kestabilan semasa penggunaan.4. Alinux 3 telah dioptimumkan khas untuk AI untuk CPU pada platform yang berbeza seperti Intel/AMD untuk melepaskan prestasi penuh perkakasan

.5. Untuk menyesuaikan diri dengan lebih pantas kepada lelaran pesat industri AIGC, Alinux 3 juga akan memperkenalkan sokongan asli untuk SDK model besar seperti ModelScope dan HuggingFace, memberikan pembangun dengan banyak sumber dan alatan.

Dengan sokongan pengoptimuman berbilang dimensi, Alinux 3 telah menjadi platform pembangunan AI yang lengkap, menyelesaikan masalah kesakitan pembangun AI dan menjadikan pengalaman pembangunan AI lebih mudah dan cekap. Yang berikut menggunakan contoh GPU Awan Alibaba sebagai contoh untuk menunjukkan sokongan Alinux 3 untuk ekosistem AI:

1. Beli contoh GPU

2. Pilih imej Alinux 3

3. Pasang konfigurasi repo epao

dnf install -y anolis-epao-release

4. Pasang pemacu GPU nvidia

Sebelum memasang pemacu nvidia, pastikan kernel-devel dipasang untuk memastikan pemacu nvidia berjaya dipasang.

dnf install -y kernel-devel-$(uname-r)

Pasang pemandu nvidia:

dnf install -y nvidia-driver nvidia-driver-cuda

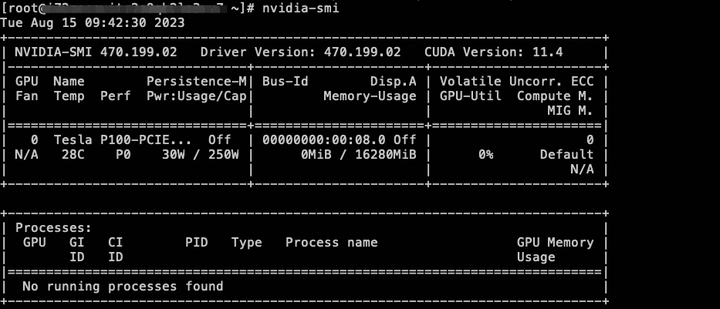

Selepas pemasangan selesai, anda boleh menyemak status peranti GPU melalui arahan nvidia-smi.

5. Pasang perpustakaan ekologi cuda

dnf install -y cuda

6. Pasang kerangka AI tensorflow/pytorch

Pada masa ini, versi CPU tensorflow/pytorch disediakan dan versi GPU rangka kerja AI akan disokong pada masa hadapan.

dnf pasang tensorflow -y dnf pasang pytorch -y

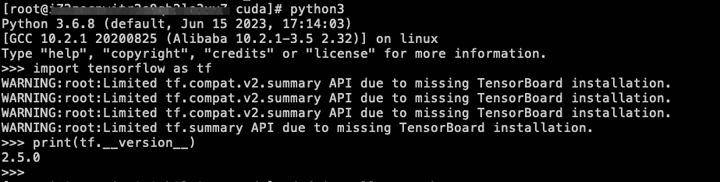

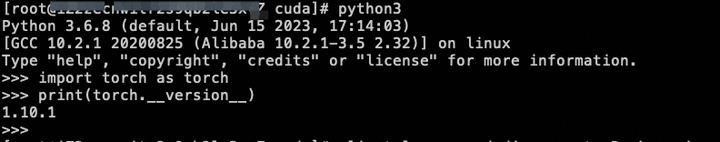

Selepas pemasangan selesai, anda boleh menyemak sama ada pemasangan berjaya melalui arahan mudah:

7. Model penggunaan

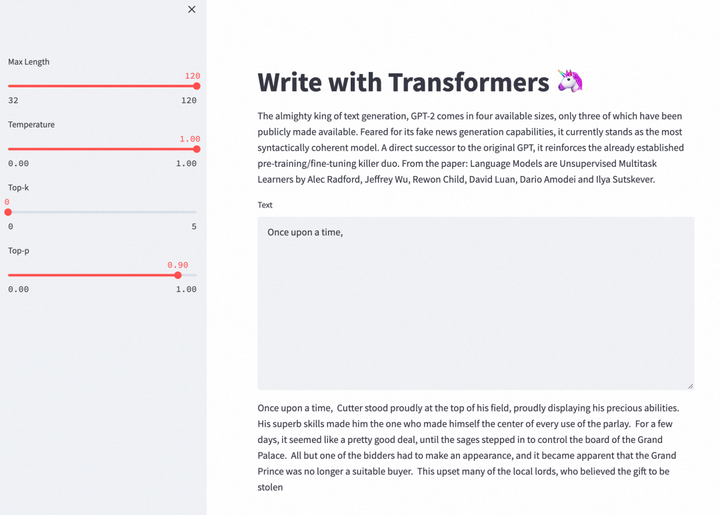

Menggunakan sokongan ekologi Alinux 3 untuk AI, model GPT-2 Large boleh digunakan untuk meneruskan tugas menulis artikel ini.

Pasang Git dan Git LFS untuk memudahkan muat turun model seterusnya.

dnf install -y git git-lfs wget

Kemas kini pip untuk memudahkan penggunaan persekitaran Python seterusnya.

python -m pip install --upgrade pip

Dayakan sokongan Git LFS.

git lfs pasang

Muat turun kod sumber projek tulis-dengan-transformer dan model pra-latihan. Projek tulis-dengan-pengubah ialah APP penulisan web yang boleh menggunakan model besar GPT-2 untuk terus menulis kandungan.

git klon https://huggingface.co/spaces/merve/write-with-transformer

GIT_LFS_SKIP_SMUDGE=1 git klon https://huggingface.co/gpt2-large

wget https://huggingface.co/gpt2-large/resolve/main/pytorch_model.bin -O gpt2-large/pytorch_model.bin

Pasang kebergantungan yang diperlukan oleh write-with-transformer.

cd ~/write-with-transformer

pip install --ignore-installed pyyaml==5.1

pip install -r requirements.txt

Selepas persekitaran digunakan, anda boleh menjalankan versi web APP untuk merasai keseronokan menulis dengan bantuan GPT-2. Pada masa ini GPT-2 hanya menyokong penjanaan teks dalam bahasa Inggeris.

cd ~/write-with-transformer

sed -i 's?"gpt2-large"?"../gpt2-large"?g' app.py

sed -i '34s/10/32/;34s/30/120/' app.py

streamlit run app.py --server.port 7860

URL Luaran: http://

Klik untuk mencuba produk awan secara percuma sekarang: https://click.aliyun.com/m/1000373503/

Pautan asal: https://click.aliyun.com/m/1000379727/

Artikel ini adalah kandungan asal Alibaba Cloud dan tidak boleh diterbitkan semula tanpa kebenaran.

Atas ialah kandungan terperinci Menggunakan contoh GPU untuk menunjukkan sokongan Alibaba Cloud Linux 3 untuk ekosistem AI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI