Rumah >Peranti teknologi >AI >Pelayan penuh sesak, model undang-undang besar Universiti Peking ChatLaw popular: memberitahu anda secara langsung bagaimana Zhang San dijatuhkan hukuman

Pelayan penuh sesak, model undang-undang besar Universiti Peking ChatLaw popular: memberitahu anda secara langsung bagaimana Zhang San dijatuhkan hukuman

- PHPzke hadapan

- 2023-07-05 09:21:161505semak imbas

Model besar "meletup" lagi.

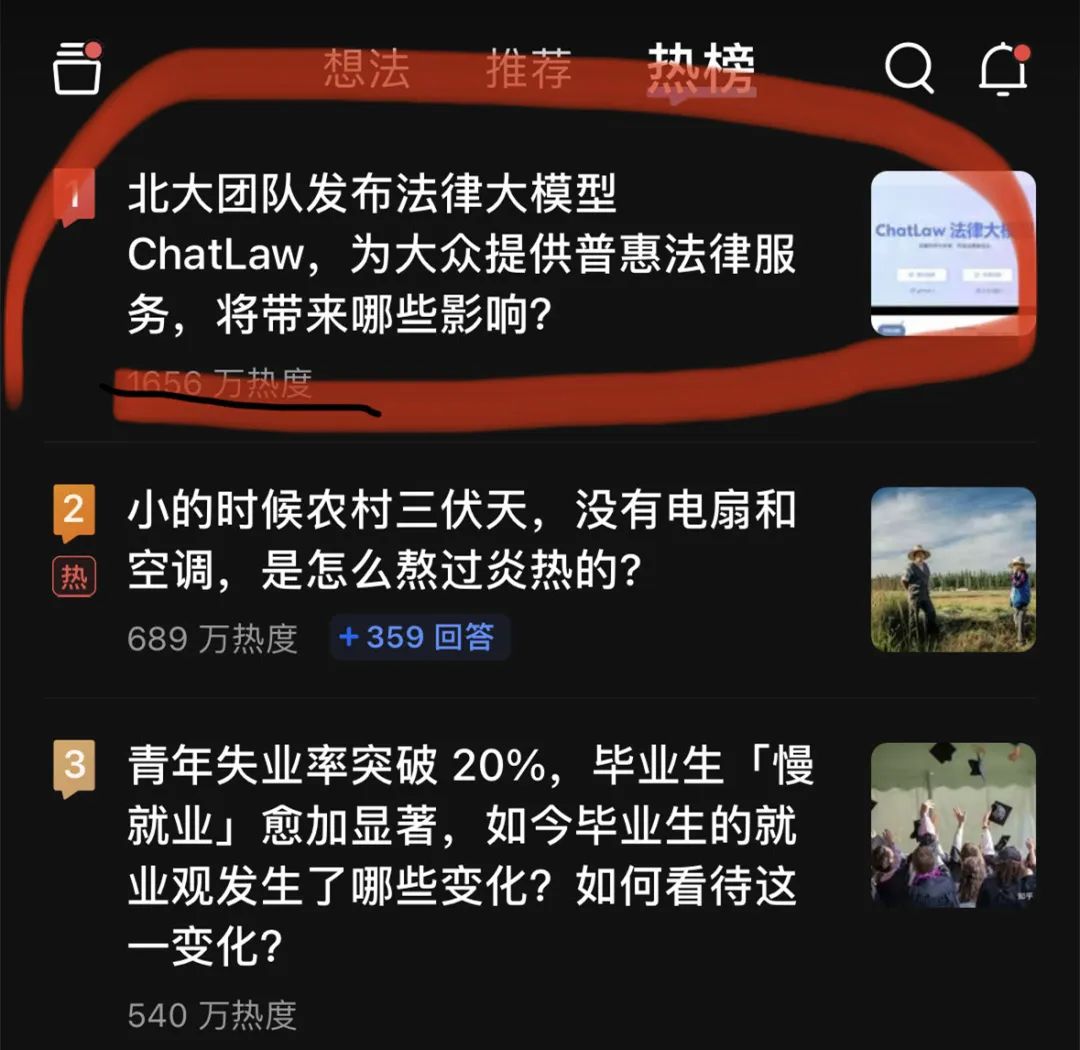

Malam tadi, model besar undang-undang, ChatLaw, mendahului senarai carian hangat Zhihu. Pada kemuncaknya, popularitinya mencapai sekitar 20 juta.

ChatLaw ini diterbitkan oleh pasukan Universiti Peking dan komited untuk menyediakan perkhidmatan undang-undang yang inklusif. Di satu pihak, pada masa ini terdapat kekurangan peguam yang mengamalkan di seluruh negara, dan bekalan adalah jauh lebih rendah daripada permintaan undang-undang sebaliknya, orang biasa mempunyai jurang semula jadi dalam pengetahuan dan peruntukan undang-undang, dan tidak dapat digunakan; senjata undang-undang untuk melindungi diri mereka.

Peningkatan model bahasa besar baru-baru ini memberikan peluang yang sangat baik kepada orang biasa untuk berunding tentang isu berkaitan undang-undang secara perbualan.

Pada masa ini, terdapat tiga versi ChatLaw, seperti berikut:

- ChatLaw-13B, yang merupakan versi demo akademik dan dilatih berdasarkan Jiang Ziya-It berprestasi sangat baik dalam bahasa Cina. Walau bagaimanapun, soalan dan jawapan undang-undang yang kompleks secara logik tidak berkesan dan perlu diselesaikan dengan model dengan parameter yang lebih besar

- ChatLaw-33B, juga versi demo akademik, dilatih berdasarkan Anima-33B, dan keupayaan penaakulan logiknya; bertambah baik. Walau bagaimanapun, kerana Anima mempunyai korpus Cina yang terlalu sedikit, data bahasa Inggeris sering muncul semasa Soal Jawab

- ChatLaw-Text2Vec, menggunakan set data yang diperbuat daripada 930,000 kes penghakiman, melatih model pemadanan persamaan berdasarkan BERT, yang boleh bertanya kepada pengguna. maklumat sepadan dengan peruntukan undang-undang yang sepadan.

Menurut demonstrasi rasmi, ChatLaw menyokong pengguna untuk memuat naik dokumen, rakaman dan bahan undang-undang lain, membantu mereka meringkaskan dan menganalisis serta menjana peta visual, carta, dsb. Selain itu, ChatLaw boleh menjana nasihat undang-undang dan dokumen undang-undang berdasarkan fakta. Projek ini mempunyai 1.1k bintang di GitHub.

Gambar

Gambar

Alamat laman web rasmi: https://www.chatlaw.cloud/

Alamat kertas: https://arxiv.org/pdf/2306.16092.pdf kami pautan projek GitHub: https://github.com/PKU-YuanGroup/ChatLaw

Pada masa ini, disebabkan populariti projek ChatLaw, pelayan ranap buat sementara waktu dan kuasa pengkomputeran telah mencapai had atas. Pasukan sedang berusaha untuk membetulkan dan pembaca yang berminat boleh menggunakan model beta pada GitHub.

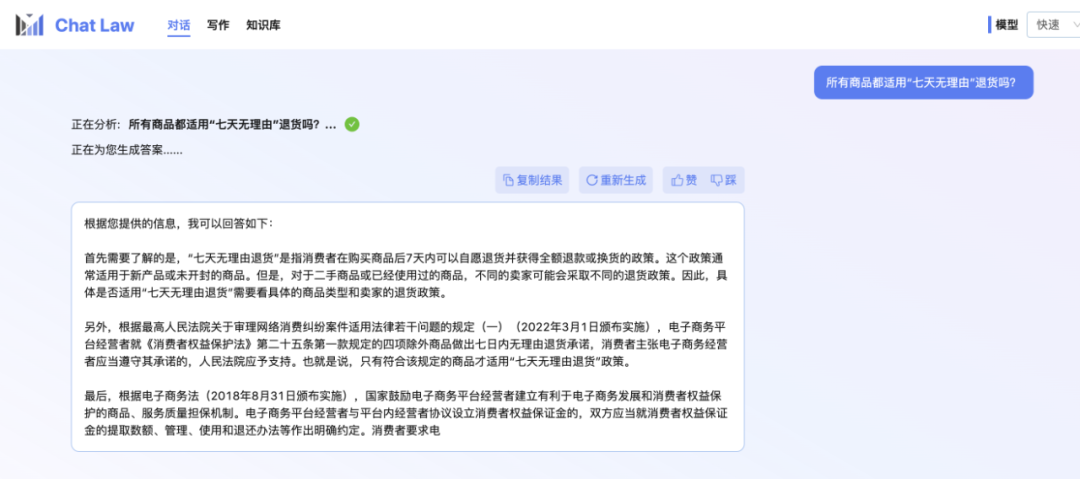

Editor sendiri masih dalam baris gilir untuk ujian beta tertutup. Jadi berikut ialah contoh perbualan rasmi yang disediakan oleh pasukan ChatLaw, tentang masalah "tujuh hari tanpa sebab pulangan" yang mungkin anda hadapi semasa membeli-belah dalam talian. Saya harus mengatakan bahawa jawapan ChatLaw agak komprehensif.

Pictures

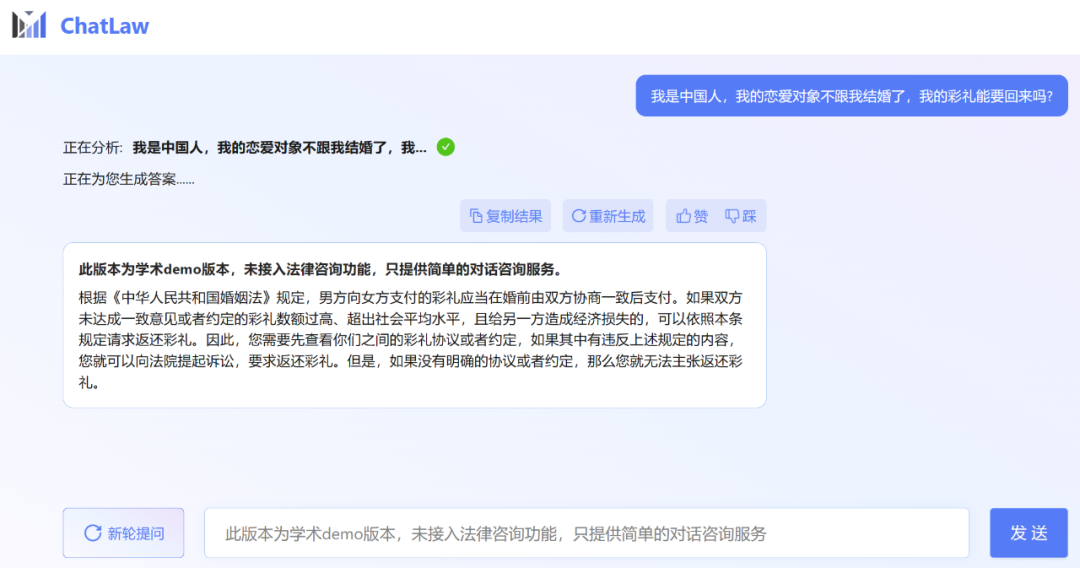

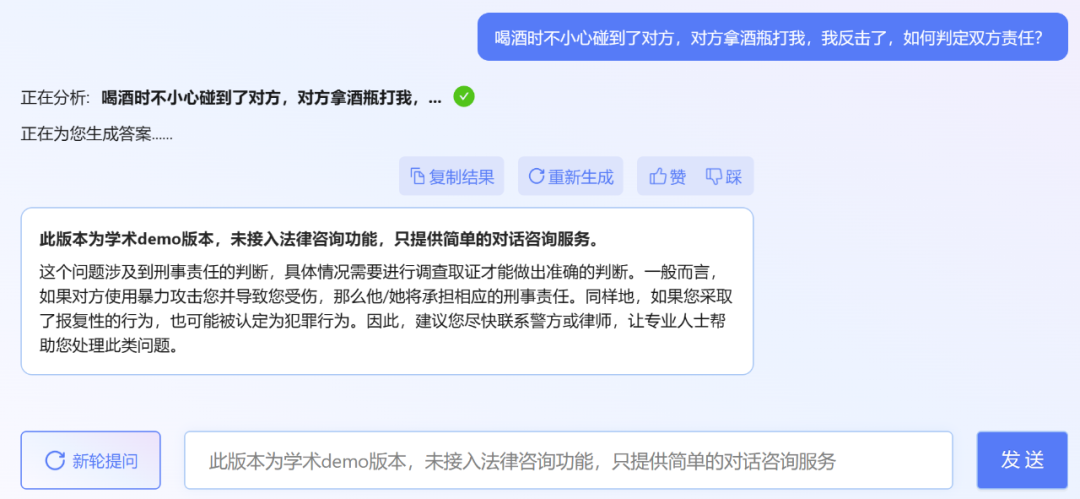

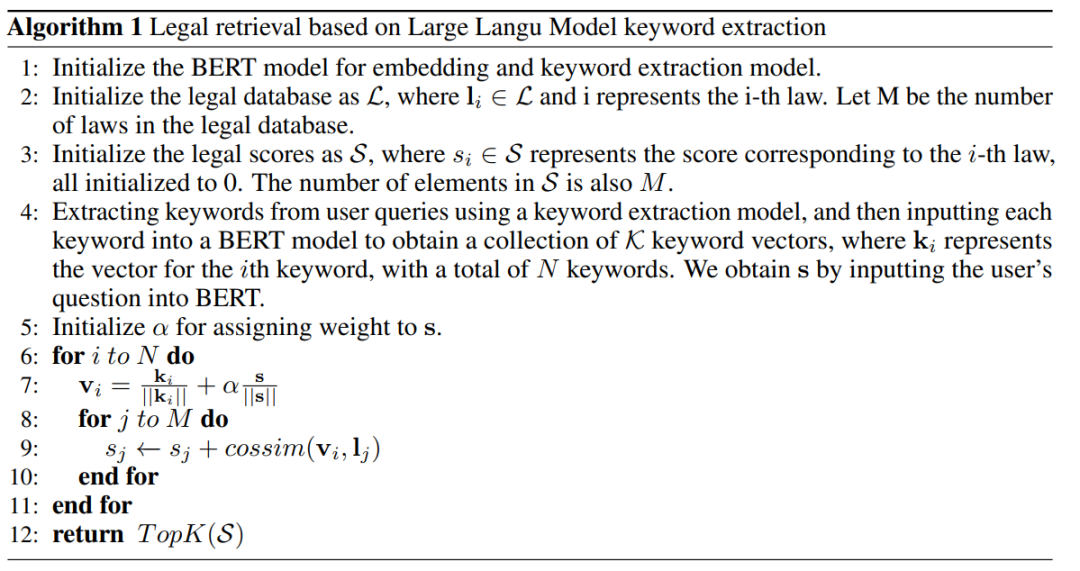

Walau bagaimanapun, editor mendapati bahawa versi demo akademik ChatLaw boleh dicuba, malangnya, ia tidak mempunyai akses kepada fungsi perundingan undang-undang dan hanya menyediakan perkhidmatan perundingan dialog yang mudah. Berikut adalah beberapa soalan untuk dicuba.

Walau bagaimanapun, editor mendapati bahawa versi demo akademik ChatLaw boleh dicuba, malangnya, ia tidak mempunyai akses kepada fungsi perundingan undang-undang dan hanya menyediakan perkhidmatan perundingan dialog yang mudah. Berikut adalah beberapa soalan untuk dicuba.

Pictures

Malah, Universiti Peking bukan satu-satunya yang mengeluarkan model undang-undang besar baru-baru ini. Pada penghujung bulan lepas, Power Law Intelligence dan Zhipu AI mengeluarkan model menegak undang-undang peringkat 100 bilion PowerLawGLM. Dilaporkan bahawa model itu telah menunjukkan kelebihan unik dalam kesan aplikasinya dalam senario undang-undang China.

Sumber data ChatLaw dan rangka kerja latihan

Yang pertama ialah komposisi data

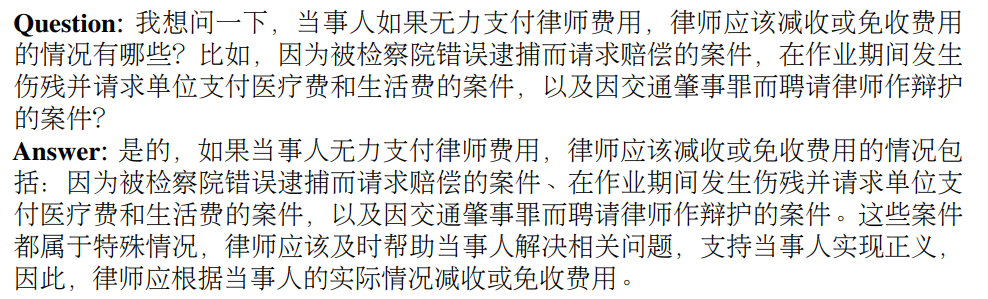

. Data ChatLaw terutamanya terdiri daripada forum, berita, peruntukan undang-undang, tafsiran kehakiman, perundingan undang-undang, soalan peperiksaan undang-undang, dan dokumen penghakiman Ia kemudiannya digunakan untuk membina data dialog melalui pembersihan, peningkatan data, dsb. Pada masa yang sama, dengan bekerjasama dengan Sekolah Undang-undang Antarabangsa Universiti Peking dan firma undang-undang industri yang terkenal, pasukan ChatLaw boleh memastikan bahawa pangkalan pengetahuan boleh dikemas kini tepat pada masanya sambil memastikan profesionalisme dan kebolehpercayaan data. Mari lihat contoh khusus di bawah.Contoh pembinaan berdasarkan undang-undang, peraturan dan tafsiran kehakiman:

Contoh merebut data perundingan undang-undang sebenar:

Contoh membina soalan aneka pilihan untuk peperiksaan bar:

Gambar tahapnya

Gambar tahapnya

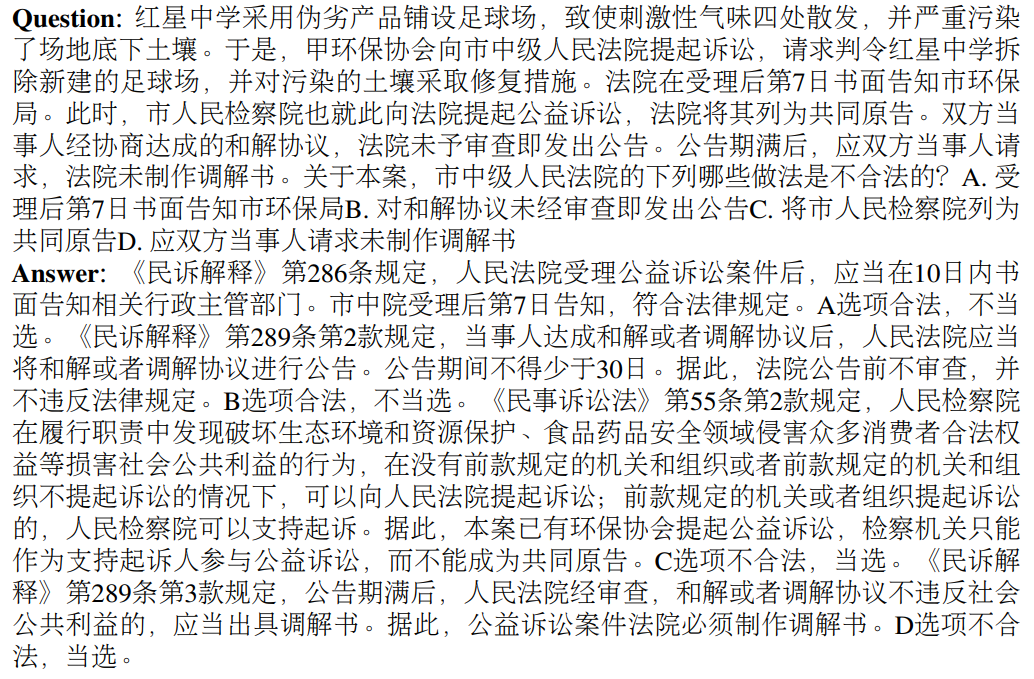

Angka berikut ialah gambar rajah seni bina ChatLAW Penyelidikan ini menyuntik data undang-undang ke dalam model dan melakukan pemprosesan khas dan peningkatan pengetahuan ini Pada masa yang sama, mereka juga memperkenalkan beberapa modul semasa penaakulan untuk menggabungkan model umum dan profesional model disepadukan dengan asas pengetahuan.

Kajian ini juga mengekang model semasa inferens, untuk memastikan model tersebut menghasilkan undang-undang dan peraturan yang betul dan mengurangkan ilusi model sebanyak mungkin.

Pictures

Pendekatan ini selalunya menghasilkan hasil yang tidak optimum apabila masalah pengguna tidak jelas. Oleh itu, penyelidik mengekstrak maklumat penting daripada pertanyaan pengguna dan algoritma reka bentuk menggunakan pembenaman vektor maklumat ini untuk meningkatkan ketepatan padanan.

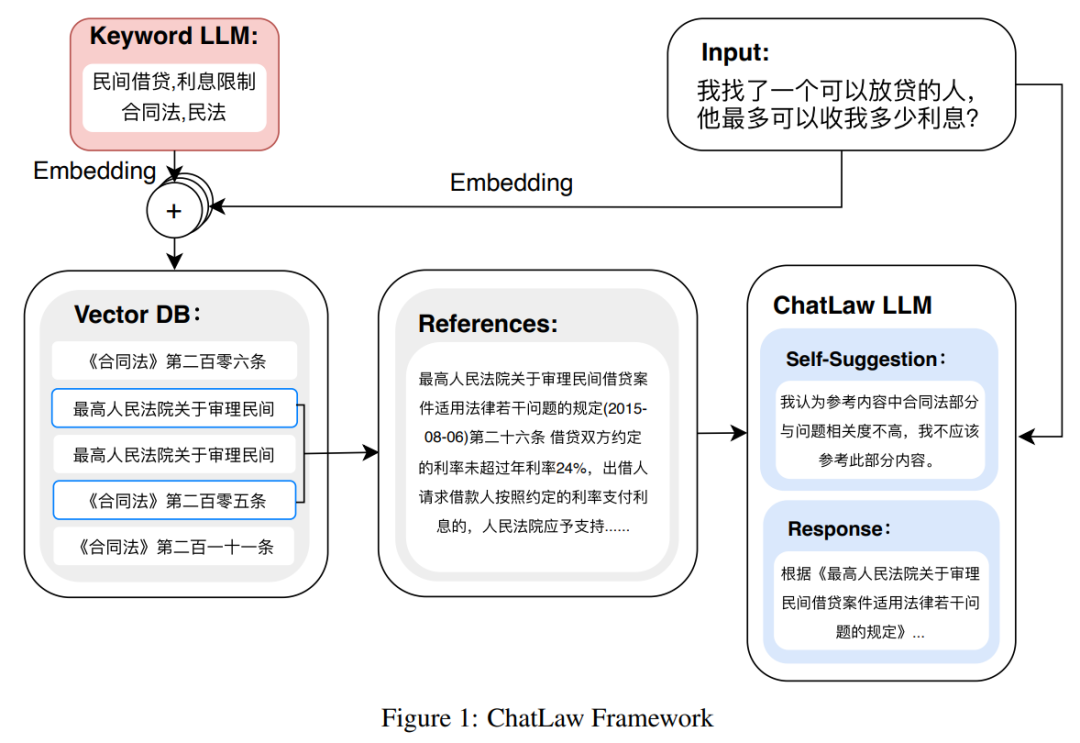

Memandangkan model besar mempunyai kelebihan yang ketara dalam memahami pertanyaan pengguna, kajian ini memperhalusi LLM untuk mengekstrak kata kunci daripada pertanyaan pengguna. Selepas memperoleh berbilang kata kunci, kajian menggunakan Algoritma 1 untuk mendapatkan semula peruntukan undang-undang yang berkaitan.

Gambar

Kajian ini mengumpul soalan peperiksaan kehakiman negara selama lebih daripada sepuluh tahun dan menyusun set data ujian yang mengandungi 2000 soalan dan jawapan standard pilihan mereka. soalan undang-undang.

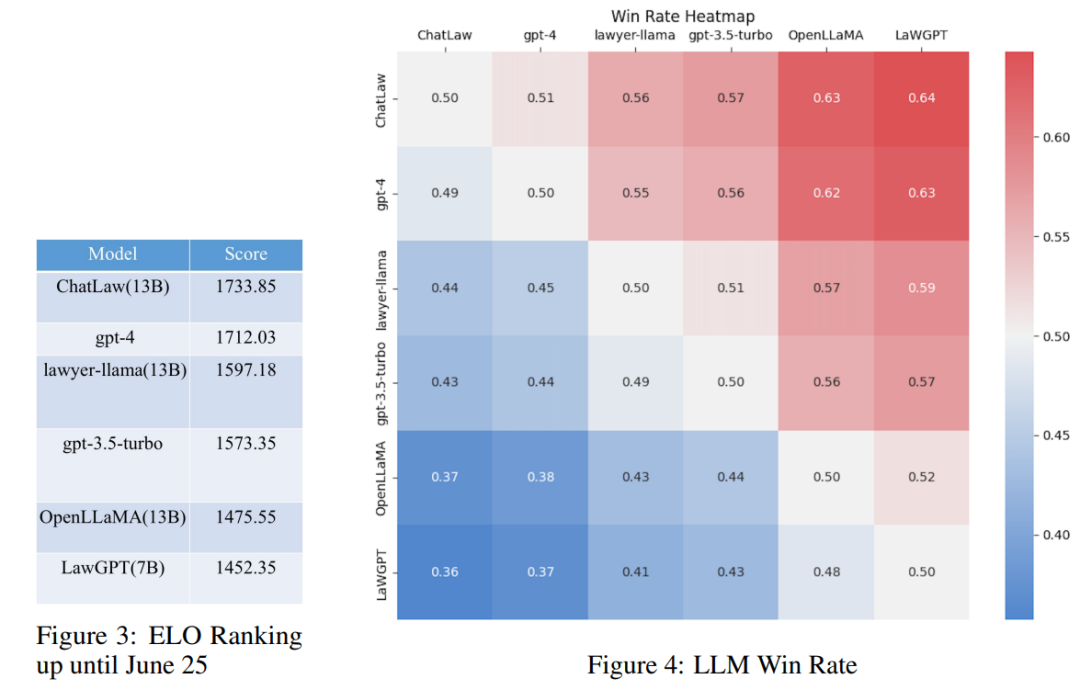

Walau bagaimanapun, kajian mendapati ketepatan setiap model secara amnya adalah rendah. Dalam kes ini, membandingkan ketepatan sahaja tidak bermakna. Oleh itu, kajian ini menggunakan mekanisme pemadanan ELO League of Legends dan mencipta mekanisme ELO konfrontasi model untuk menilai dengan lebih berkesan keupayaan setiap model untuk mengendalikan soalan aneka pilihan undang-undang. Berikut ialah markah ELO dan carta kadar kemenangan masing-masing:

Gambar

(1) soalan berkaitan undang-undang dan pengenalan dan peruntukan kawal selia Data boleh meningkatkan prestasi model pada soalan aneka pilihan pada tahap tertentu

(2) Menambah data daripada jenis tugasan khusus untuk latihan, dan prestasi model pada jenis tugasan ini akan dipertingkatkan dengan ketara; . Sebagai contoh, sebab model ChatLaw lebih baik daripada GPT-4 ialah sejumlah besar soalan aneka pilihan digunakan sebagai data latihan dalam artikel

(3) Soalan aneka pilihan undang-undang memerlukan penaakulan logik yang kompleks; , jadi model dengan parameter yang lebih besar biasanya berprestasi lebih baik Lebih baik.

Rujukan pautan Zhihu:

https://www.zhihu.com/question/610072848

Pautan rujukan lain:

/bXAFALFY6GQkL30j1sYCEQ

Atas ialah kandungan terperinci Pelayan penuh sesak, model undang-undang besar Universiti Peking ChatLaw popular: memberitahu anda secara langsung bagaimana Zhang San dijatuhkan hukuman. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI