Rumah >Peranti teknologi >AI >Model besar keluarga alpaca berkembang secara kolektif! Konteks 32k bersamaan dengan GPT-4, dihasilkan oleh pasukan Tian Yuandong

Model besar keluarga alpaca berkembang secara kolektif! Konteks 32k bersamaan dengan GPT-4, dihasilkan oleh pasukan Tian Yuandong

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-06-28 22:06:521827semak imbas

Konteks LLaMA model besar alpaca sumber terbuka adalah sama dengan GPT-4, dengan hanya satu perubahan mudah!

Kertas kerja yang baru diserahkan oleh Meta AI ini menunjukkan bahawa kurang daripada 1000 langkah penalaan halus diperlukan selepas tetingkap konteks LLaMA dikembangkan daripada 2k kepada 32k.

Kosnya boleh diabaikan berbanding dengan pra-latihan. . data boleh menyelesaikan tugas yang lebih kompleks, seperti memproses dokumen yang lebih panjang atau berbilang dokumen pada satu masa

Kepentingan yang lebih penting ialah semua keluarga model alpaka besar berdasarkan LLaMA boleh menggunakan kaedah ini pada kos yang rendah dan berkembang secara kolektif?

Kepentingan yang lebih penting ialah semua keluarga model alpaka besar berdasarkan LLaMA boleh menggunakan kaedah ini pada kos yang rendah dan berkembang secara kolektif?

Alpaca kini merupakan model asas sumber terbuka yang paling komprehensif, dan telah menghasilkan banyak model besar dan model industri menegak sumber terbuka sepenuhnya yang tersedia secara komersial.

- Tian Yuandong, pengarang kertas yang sepadan, turut teruja berkongsi perkembangan baharu ini dalam kalangan rakan-rakannya.

Semua model besar berdasarkan RoPE boleh digunakan

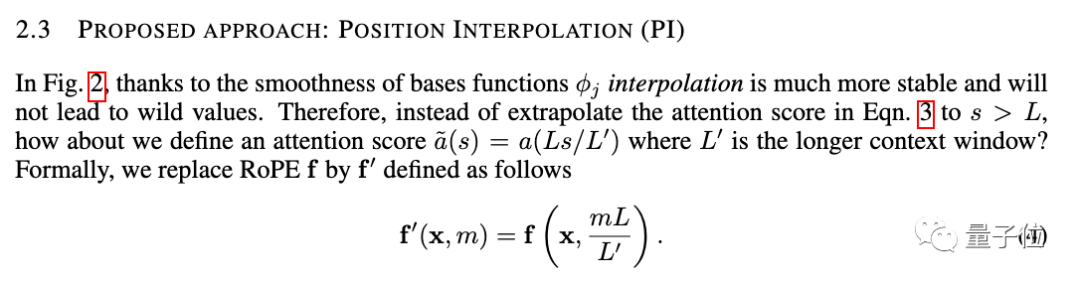

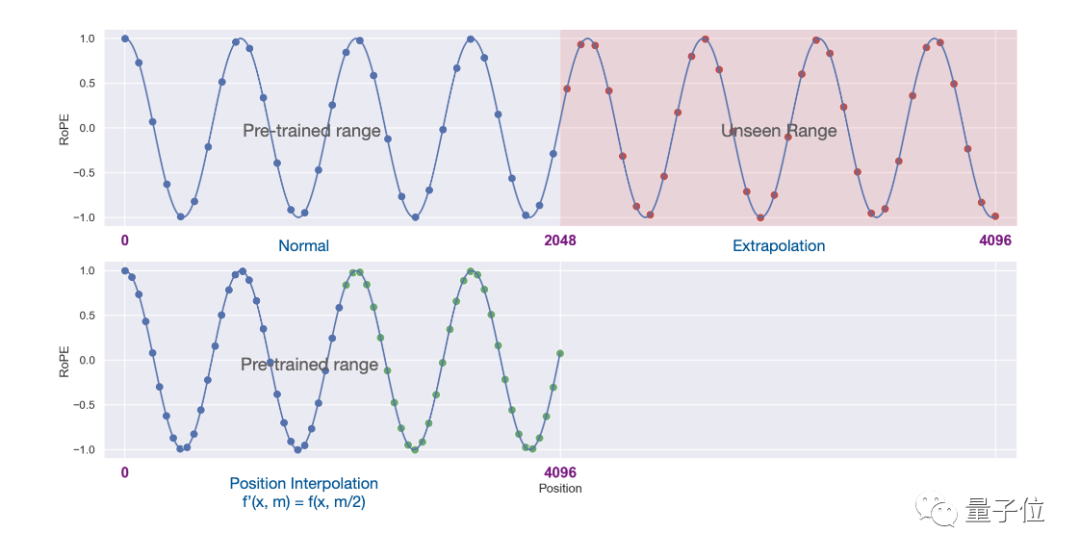

Kaedah baru dipanggil Interpolasi Kedudukan, dan ia sesuai untuk model besar menggunakan RoPE (pengekodan kedudukan putaran).

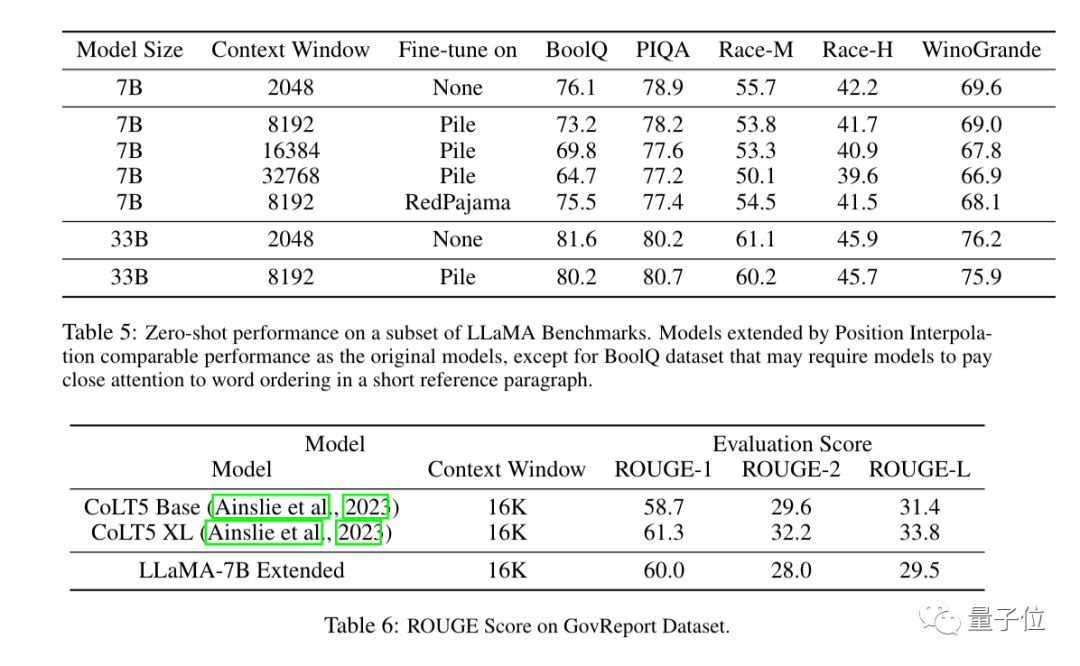

Hasil eksperimen menunjukkan kaedah baharu itu berkesan untuk model besar LLaMA dari 7B hingga 65B.

Tiada kemerosotan prestasi yang ketara dalam Pemodelan Bahasa Urutan Panjang, Pengambilan Kunci Laluan dan Ringkasan Dokumen Panjang.

Selain eksperimen, bukti terperinci kaedah baharu juga diberikan dalam lampiran kertas.

Three More Thing

Tetingkap konteks pernah menjadi jurang penting antara model besar sumber terbuka dan model besar komersial.

Kini, keputusan baharu Meta AI telah secara langsung menutup jurang ini.

Kini, keputusan baharu Meta AI telah secara langsung menutup jurang ini.

Meluaskan tetingkap konteks juga merupakan salah satu fokus penyelidikan model besar baru-baru ini Selain kaedah interpolasi kedudukan, terdapat banyak percubaan untuk menarik perhatian industri.

1. Pembangun kaiokendev meneroka kaedah untuk memanjangkan tetingkap konteks LLaMa kepada 8k dalam blog teknikal.

2 Galina Alperovich, ketua pembelajaran mesin di syarikat keselamatan data Soveren, meringkaskan 6 petua untuk mengembangkan tetingkap konteks dalam artikel.3 Pasukan dari Mila, IBM dan institusi lain juga cuba mengalih keluar pengekodan kedudukan sepenuhnya dalam Transformer dalam kertas.伴 Jika anda memerlukannya, anda boleh klik pada pautan di bawah untuk melihat ~

Tesis meta:  Https://www.php.cn/link/0BDF2C1F05365071F0C725D754B96

Https://www.php.cn/link/0BDF2C1F05365071F0C725D754B96

TPS:/ /www.php.cn/link/9659078925b57e621eb3f9ef19773ac3

Sos Rahsia di sebalik tetingkap konteks 100K dalam LLMshttps://www.php.cn/link/09a630e9edddcaf Tiada Kertas pengekodan Kedudukan

https:/ /www. php.cn/link/fb6c84779f12283a81d739d8f088fc12Atas ialah kandungan terperinci Model besar keluarga alpaca berkembang secara kolektif! Konteks 32k bersamaan dengan GPT-4, dihasilkan oleh pasukan Tian Yuandong. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI