Rumah >Peranti teknologi >AI >OlaGPT, rangka kerja pemikiran pertama yang mensimulasikan kognisi manusia: enam modul meningkatkan model bahasa dan meningkatkan keupayaan penaakulan sehingga 85%

OlaGPT, rangka kerja pemikiran pertama yang mensimulasikan kognisi manusia: enam modul meningkatkan model bahasa dan meningkatkan keupayaan penaakulan sehingga 85%

- 王林ke hadapan

- 2023-06-05 16:17:491444semak imbas

Apabila ChatGPT mula-mula dikeluarkan, ia memberikan kami terlalu banyak kejutan Prestasi model dalam dialog adalah seperti manusia sehingga mencipta ilusi bahawa model bahasa itu mempunyai "keupayaan berfikir".

Namun, selepas pemahaman mendalam tentang model bahasa, penyelidik secara beransur-ansur mendapati bahawa pembiakan berdasarkan corak bahasa berkemungkinan tinggi masih jauh daripada jangkaan "kecerdasan buatan umum".

Dalam kebanyakan penyelidikan semasa, model bahasa berskala besar terutamanya menjana rantaian pemikiran di bawah bimbingan gesaan khusus untuk melaksanakan tugas penaakulan, tanpa mengambil kira rangka kerja kognitif manusia, yang menjadikan model bahasa tidak dapat menyelesaikan masalah penaakulan yang kompleks. Masih terdapat jurang yang ketara dengan manusia.

Apabila manusia menghadapi masalah penaakulan yang kompleks, mereka biasanya menggunakan pelbagai kebolehan kognitif dan perlu berinteraksi dengan semua aspek alat, pengetahuan dan maklumat persekitaran luaran Bolehkah model bahasa mensimulasikan pemikiran manusia. Bagaimana dengan proses untuk menyelesaikan masalah yang kompleks ?

Jawapannya sudah tentu ya! Model pertama OlaGPT yang menyerupai rangka kerja pemprosesan kognitif manusia ada di sini!

Pautan kertas: https://arxiv.org/abs/2305.16334

Pautan kod: https://www.php.cn/link/ 73a1c863a54653d5e184b790fee14754

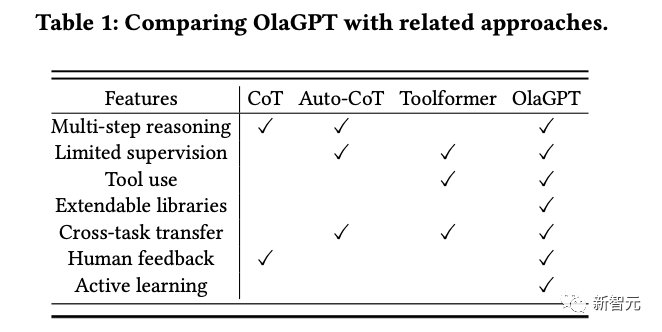

OlaGPT merangkumi berbilang modul kognitif, termasuk perhatian, ingatan, penaakulan, pembelajaran dan mekanisme penjadualan dan membuat keputusan yang sepadan yang diilhamkan oleh pembelajaran aktif manusia, dan rangka kerja untuk merekod ralat sebelumnya; pendapat, dan rujukan dinamik untuk meningkatkan keupayaan menyelesaikan masalah yang serupa.

Artikel ini juga menggariskan rangka kerja penaakulan yang biasa dan berkesan untuk penyelesaian masalah manusia, dan mereka bentuk templat Rantaian Pemikiran (CoT) dengan sewajarnya; mekanisme yang boleh Memaksimumkan ketepatan model.

Keputusan eksperimen yang diperolehi selepas penilaian rapi pada set data inferens berbilang menunjukkan bahawa OlaGPT mengatasi penanda aras terkini yang terkini dan membuktikan keberkesanannya.

Simulasi kognisi manusia

Masih terdapat jurang yang besar antara model bahasa semasa dan kecerdasan buatan umum yang dijangkakan Manifestasi utama ialah:

1 kandungan yang dijana tidak bermakna, atau menyimpang daripada keutamaan nilai manusia, atau malah memberikan beberapa cadangan yang sangat berbahaya Penyelesaian semasa ialah memperkenalkan pembelajaran pengukuhan dengan maklum balas manusia (RLHF) untuk mengisih keluaran model.

2. Pengetahuan model bahasa adalah terhad kepada konsep dan fakta yang dinyatakan secara eksplisit dalam data latihan.

Apabila berhadapan dengan masalah yang rumit, model bahasa tidak dapat menyesuaikan diri dengan persekitaran yang berubah-ubah, menggunakan pengetahuan atau alatan sedia ada, merenung pelajaran sejarah, menguraikan masalah dan menggunakan cerapan yang diringkaskan oleh manusia dalam evolusi jangka panjang seperti manusia. Corak pemikiran (seperti analogi, penaakulan induktif, penaakulan deduktif, dll.) untuk menyelesaikan masalah.

Walau bagaimanapun, masih terdapat banyak masalah sistem dalam membenarkan model bahasa mensimulasikan proses masalah pemprosesan otak manusia:

1 Cara meniru dan mengekod modul utama dalam rangka kerja kognitif manusia secara sistematik sambil memungkinkan untuk Dilaksanakan dengan cara yang menjadualkan mengikut corak penaakulan manusia biasa?

2. Bagaimana untuk membimbing model bahasa untuk belajar secara aktif seperti manusia, iaitu, belajar dan berkembang daripada kesilapan sejarah atau penyelesaian pakar kepada masalah yang sukar?

Walaupun mungkin untuk melatih semula model untuk mengekodkan jawapan yang diperbetulkan, ia jelas sangat mahal dan tidak fleksibel.

3. Bagaimana untuk menjadikan model bahasa menggunakan pelbagai mod pemikiran yang dikembangkan oleh manusia secara fleksibel untuk meningkatkan prestasi penaakulan mereka?

Model pemikiran yang tetap dan universal sukar disesuaikan dengan masalah yang berbeza Sama seperti apabila manusia menghadapi pelbagai jenis masalah, mereka biasanya fleksibel memilih cara berfikir yang berbeza, seperti penaakulan analogi, penaakulan deduktif, dsb.

OlaGPT

OlaGPT ialah rangka kerja penyelesaian masalah yang menyerupai pemikiran manusia dan boleh meningkatkan keupayaan model bahasa yang besar.

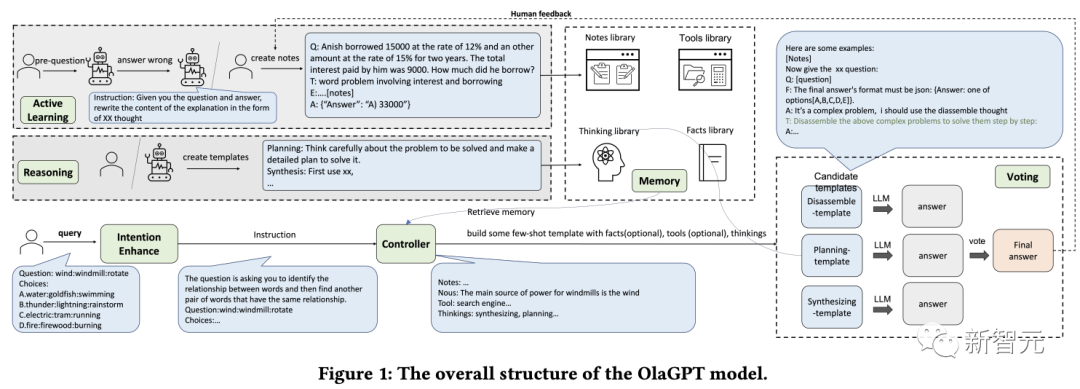

OlaGPT menggunakan teori seni bina kognitif dan memodelkan keupayaan teras rangka kerja kognitif sebagai perhatian, ingatan, pembelajaran, penaakulan dan pemilihan Tindakan.

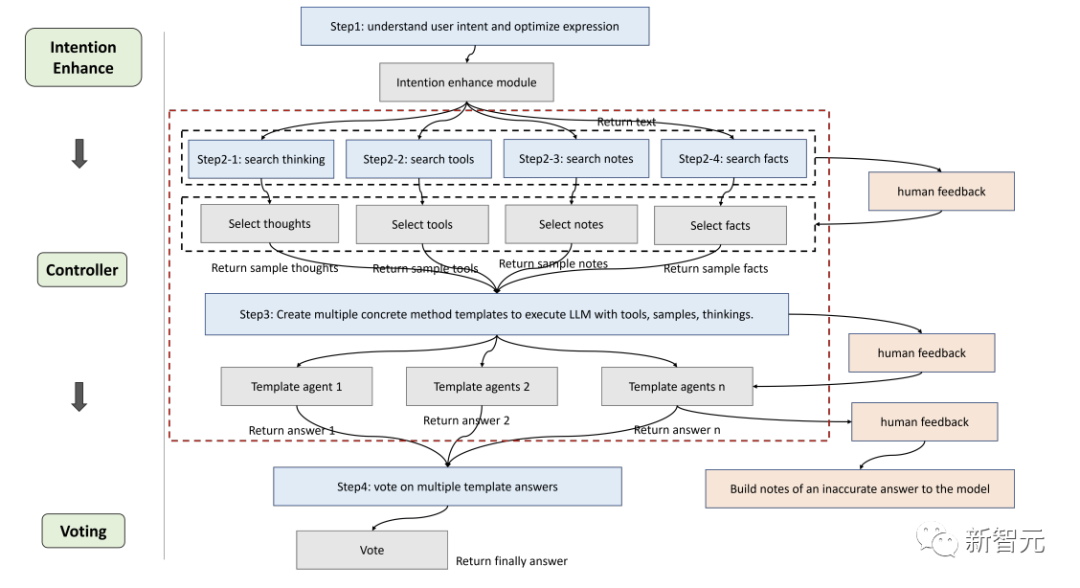

Para penyelidik memperhalusi rangka kerja mengikut keperluan pelaksanaan khusus dan mencadangkan proses yang sesuai untuk model bahasa untuk menyelesaikan masalah yang kompleks, yang secara khusus merangkumi enam modul: modul peningkatan niat (perhatian), modul memori ( ingatan), modul pembelajaran aktif (pembelajaran), modul inferens (penaakulan), modul pengawal (pemilihan tindakan) dan modul undian.

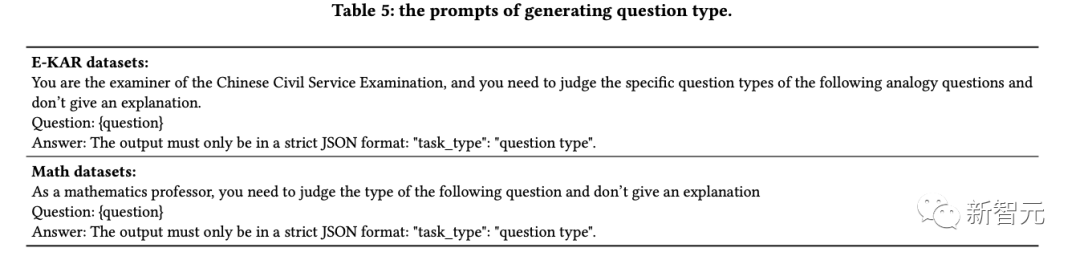

Peningkatan Niat

Perhatian ialah bahagian penting dalam kognisi manusia, mengenal pasti maklumat yang berkaitan dan menapis data yang tidak berkaitan.

Begitu juga, penyelidik mereka bentuk modul perhatian yang sepadan untuk model bahasa, iaitu peningkatan niat, yang bertujuan untuk mengekstrak maklumat yang paling relevan dan mewujudkan korelasi yang lebih kukuh antara input pengguna dan corak bahasa model, yang boleh dianggap sebagai sebagai penukar yang dioptimumkan daripada tabiat ekspresi pengguna kepada tabiat ekspresi model.

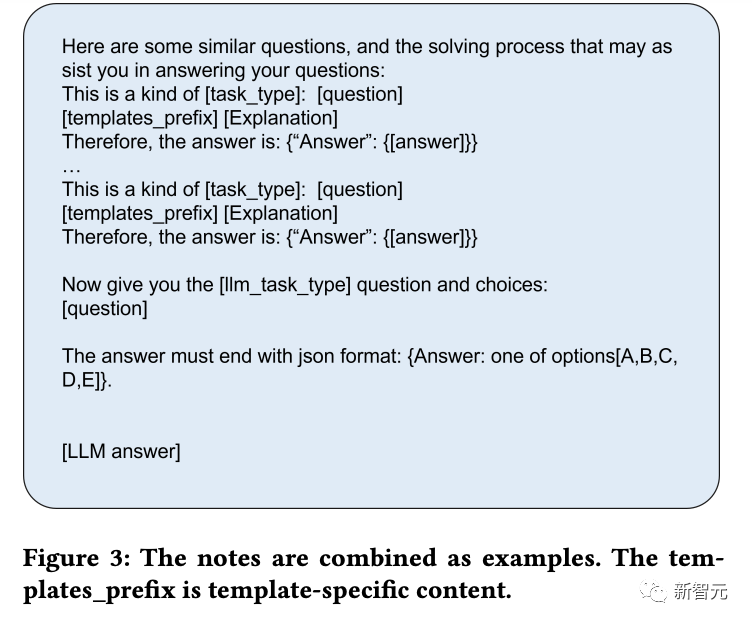

Mula-mula, dapatkan jenis soalan LLM terlebih dahulu melalui kata gesaan tertentu, dan kemudian bina semula cara bertanya soalan.

Sebagai contoh, tambahkan "Sekarang berikan anda XX (jenis soalan), soalan dan pilihan:" pada permulaan soalan untuk memudahkan analisis, anda juga perlu tambah " Jawapan mesti berakhir dengan format JSON: Jawapan: salah satu pilihan[A,B,C,D,E].》

Memori

Modul memori memainkan peranan penting dalam menyimpan pelbagai maklumat asas pengetahuan Kajian telah membuktikan keterbatasan model bahasa semasa dalam memahami data fakta terkini, dan modul memori memfokuskan pada penyatuan pengetahuan yang belum dihayati oleh model menyimpannya dalam perpustakaan luaran sebagai ingatan jangka panjang.

Para penyelidik menggunakan fungsi ingatan langchain untuk ingatan jangka pendek, dan kemudian menggunakan pangkalan data vektor berasaskan Faiss untuk mencapai ingatan jangka panjang.

Semasa proses pertanyaan, fungsi cariannya boleh mengekstrak pengetahuan yang berkaitan daripada perpustakaan, meliputi empat jenis perpustakaan memori: fakta, alatan, nota dan pemikiran, di mana fakta adalah maklumat dunia sebenar, Seperti akal sehat, dan lain-lain; alat termasuk enjin carian, kalkulator dan Wikipedia, yang boleh membantu model bahasa dalam menyelesaikan beberapa kerja yang tidak memerlukan penyuntingan terutamanya merekodkan beberapa kes yang sukar dan langkah-langkah untuk menyelesaikan masalah terutamanya menyimpan penyelesaian masalah manusia; templat pemikiran pakar, pakar boleh menjadi manusia atau model.

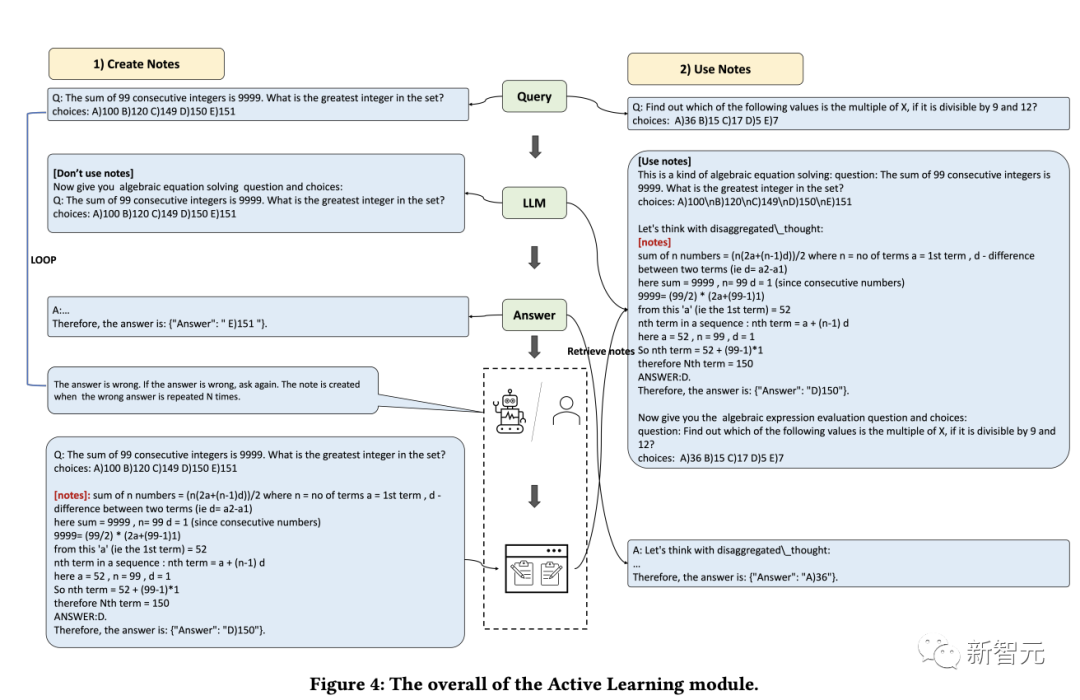

Pembelajaran

Keupayaan untuk belajar adalah penting bagi manusia untuk terus meningkatkan prestasi diri mereka Pada dasarnya, semua bentuk pembelajaran bergantung pada pengalaman, dan model bahasa boleh belajar daripada Belajar daripada anda kesilapan untuk meningkatkan kebolehan penaakulan anda dengan cepat.

Pertama, penyelidik mengenal pasti masalah yang tidak dapat diselesaikan oleh model bahasa, kemudian merekodkan pandangan dan penjelasan yang diberikan oleh pakar dalam perpustakaan nota dan akhirnya memilih nota yang berkaitan untuk mempromosikan bahasa; model pembelajaran supaya masalah yang sama dapat ditangani dengan lebih berkesan.

Penaakulan

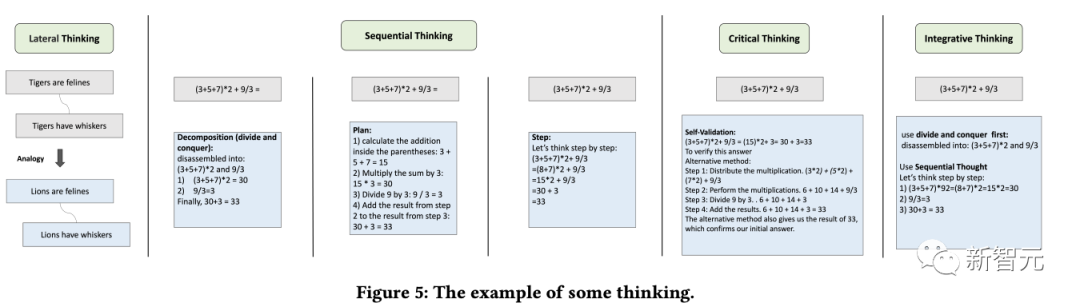

Tujuan modul penaakulan adalah untuk mencipta pelbagai agen berdasarkan proses penaakulan manusia, dengan itu merangsang potensi keupayaan pemikiran model bahasa dan menyelesaikan masalah penaakulan.

Modul ini menggabungkan pelbagai templat pemikiran dengan merujuk kepada jenis pemikiran tertentu seperti pemikiran lateral, pemikiran berurutan, pemikiran kritis dan pemikiran integratif untuk memudahkan tugas penaakulan.

Pengawal

Modul pengawal digunakan terutamanya untuk mengendalikan pemilihan tindakan yang berkaitan, termasuk tugas perancangan dalaman model (seperti memilih modul tertentu untuk pelaksanaan) dan daripada fakta dan alatan Pilih daripada , nota dan bank pemikiran.

Perpustakaan yang berkaitan mula-mula diambil dan dipadankan Kandungan yang diambil kemudiannya disepadukan ke dalam ejen templat, yang memerlukan model bahasa untuk memberikan respons di bawah templat secara tidak segerak. sama seperti mungkin sukar bagi manusia untuk mengenal pasti semua maklumat yang relevan pada permulaan penaakulan, adalah juga sukar untuk mengharapkan model bahasa untuk melakukan ini dari awal.

Oleh itu, pengambilan semula dinamik dilaksanakan berdasarkan soalan pengguna dan kemajuan penaakulan pertengahan, menggunakan kaedah Faiss untuk mencipta indeks terbenam untuk empat perpustakaan di atas, di mana strategi mendapatkan semula setiap perpustakaan adalah berbeza sedikit.

Pengundian

Memandangkan templat pemikiran yang berbeza mungkin lebih sesuai untuk pelbagai jenis masalah, penyelidik mereka bentuk modul pengundian untuk meningkatkan keupayaan penentukuran bersepadu antara templat pemikiran berbilang dan menyediakan lebih banyak Strategi pengundian untuk menjana jawapan terbaik untuk meningkatkan prestasi.

Kaedah pengundian khusus termasuk:

1 Undian model bahasa: Bimbing model bahasa untuk memilih jawapan yang paling konsisten antara berbilang pilihan yang diberikan dan berikan sebab.

2. Pengundian regex: Gunakan padanan tepat ungkapan biasa untuk mengeluarkan jawapan untuk mendapatkan keputusan undian.

Hasil eksperimen

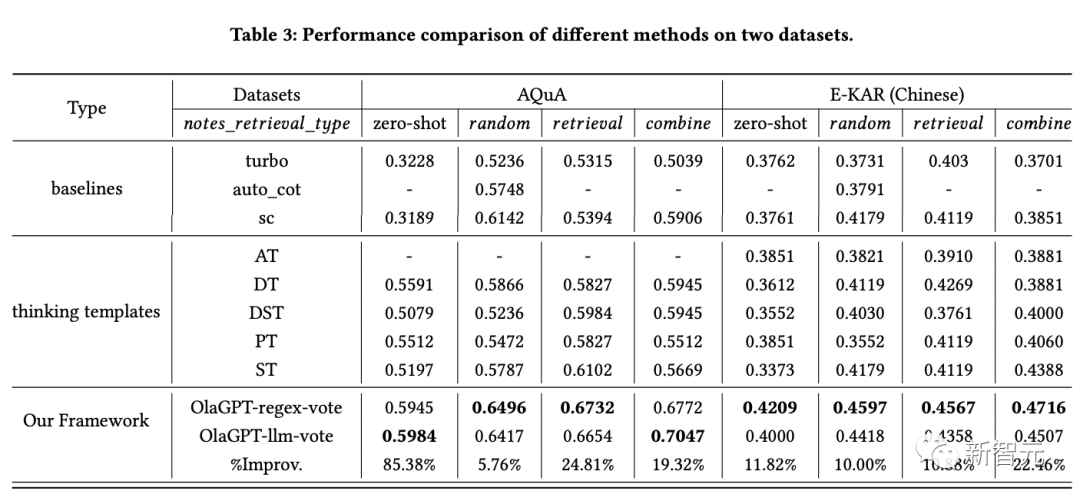

Untuk menilai keberkesanan rangka kerja model bahasa yang dipertingkatkan ini dalam tugasan penaakulan, penyelidik menjalankan perbandingan eksperimen yang komprehensif pada dua jenis set data penaakulan.

Seperti yang dapat dilihat daripada keputusan:

1 SC (konsistensi kendiri) berprestasi lebih baik daripada GPT-3.5-turbo, menunjukkan bahawa integrasi diterima pakai kepada suatu. kaedah tahap tertentu benar-benar membantu meningkatkan keberkesanan model berskala besar.

2. Prestasi kaedah yang dicadangkan dalam artikel melebihi SC, yang membuktikan keberkesanan strategi templat pemikiran pada tahap tertentu.

Jawapan kepada templat pemikiran yang berbeza menunjukkan perbezaan yang besar, dan pengundian di bawah templat pemikiran yang berbeza akhirnya akan menghasilkan keputusan yang lebih baik daripada hanya menjalankan beberapa pusingan pengundian.

3. Templat pemikiran yang berbeza mempunyai kesan yang berbeza, dan penyelesaian langkah demi langkah mungkin lebih sesuai untuk masalah penaakulan.

4. Prestasi modul pembelajaran aktif adalah jauh lebih baik daripada kaedah sampel sifar.

Memasukkan kes yang mencabar sebagai sebahagian daripada pustaka nota, menggunakan senarai rawak, perolehan semula dan gabungan untuk meningkatkan prestasi ialah strategi yang boleh dilaksanakan.

5. Skim pengambilan yang berbeza mempunyai kesan yang berbeza pada set data yang berbeza Secara umum, strategi gabungan mempunyai hasil yang lebih baik.

6. Kaedah dalam artikel ini jelas lebih baik daripada penyelesaian lain Ini disebabkan oleh reka bentuk keseluruhan rangka kerja yang munasabah, termasuk reka bentuk modul pembelajaran aktif yang merealisasikan penyesuaian kepada yang berbeza model, dan keputusan di bawah templat pemikiran yang berbeza adalah berbeza; modul pengawal memainkan peranan kawalan yang sangat baik dan memilih kandungan yang sepadan dengan kandungan yang diperlukan kaedah penyepaduan templat pemikiran berbeza yang direka oleh modul pengundian adalah berkesan.

Rujukan:

https://www.php.cn/link/73a1c863a54653d5e184b790fee14754

Atas ialah kandungan terperinci OlaGPT, rangka kerja pemikiran pertama yang mensimulasikan kognisi manusia: enam modul meningkatkan model bahasa dan meningkatkan keupayaan penaakulan sehingga 85%. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI