Rumah >Peranti teknologi >AI >OpenAI dan Google bermain-main dengan standard dwi mereka: melatih model besar menggunakan data orang lain, tetapi tidak pernah membenarkan data mereka sendiri bocor keluar

OpenAI dan Google bermain-main dengan standard dwi mereka: melatih model besar menggunakan data orang lain, tetapi tidak pernah membenarkan data mereka sendiri bocor keluar

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-06-05 15:03:391118semak imbas

Dalam era baharu AI generatif, syarikat teknologi besar sedang melaksanakan strategi "buat seperti yang saya katakan, bukan buat seperti yang saya lakukan" apabila ia melibatkan penggunaan kandungan dalam talian. Sedikit sebanyak, strategi ini boleh dikatakan sebagai double standard dan penyalahgunaan hak bersuara.

Pada masa yang sama, memandangkan model bahasa besar (LLM) menjadi trend arus perdana dalam pembangunan AI, kedua-dua syarikat besar dan syarikat baharu tidak berusaha untuk membangunkan model besar mereka sendiri. Antaranya, data latihan adalah prasyarat penting untuk keupayaan model besar.

Baru-baru ini, menurut laporan Insider, OpenAI yang disokong Microsoft, Google dan Anthropic yang disokongnya telah menggunakan kandungan dalam talian dari tapak web atau syarikat lain untuk latihan selama bertahun-tahun. model AI generatif. Ini semua dilakukan tanpa meminta kebenaran khusus dan akan membentuk sebahagian daripada pertarungan undang-undang untuk menentukan masa depan web dan cara undang-undang hak cipta digunakan dalam era baharu ini.

Syarikat teknologi besar ini mungkin berhujah bahawa mereka digunakan secara adil, sama ada perkara itu benar-benar berlaku untuk dibahaskan. Tetapi mereka tidak akan membiarkan kandungan mereka digunakan untuk melatih model AI yang lain. Oleh itu, kami tidak boleh tidak bertanya, mengapa syarikat teknologi besar ini boleh menggunakan kandungan dalam talian syarikat lain apabila melatih model besar?

Syarikat ini bijak, tetapi juga sangat hipokrit

Adakah terdapat bukti kukuh untuk dakwaan bahawa syarikat teknologi besar menggunakan kandungan dalam talian orang lain tetapi tidak membenarkan orang lain untuk menggunakan mereka sendiri? Ini boleh dilihat dari segi perkhidmatan dan penggunaan beberapa produk mereka.

Pertama, mari kita lihat Claude, pembantu AI yang serupa dengan ChatGPT yang dilancarkan oleh Anthropic. Sistem boleh menyelesaikan tugas seperti ringkasan ringkasan, carian, bantuan dalam penciptaan, soal jawab, dan pengekodan. Ia telah dinaik taraf semula beberapa ketika dahulu dan token konteks telah dikembangkan kepada 100k, yang telah mempercepatkan kelajuan pemprosesan.

Syarat perkhidmatan Claude adalah seperti berikut. Anda tidak boleh mengakses atau menggunakan Perkhidmatan dengan cara berikut (sebahagian daripadanya disenaraikan di sini Jika mana-mana sekatan ini tidak konsisten atau tidak jelas dengan Polisi Penggunaan Boleh Diterima, yang kedua akan diguna pakai:

- Membangunkan mana-mana produk atau perkhidmatan yang bersaing dengan Perkhidmatan kami, termasuk membangunkan atau melatih mana-mana AI atau algoritma atau model pembelajaran mesin

- Dari Perangkak kami, merangkak atau sebaliknya dapatkan data atau maklumat dalam Perkhidmatan

Syarat Perkhidmatan Claude Alamat: https://vault.pactsafe.io/s /9f502c93-cb5c-4571-b205-1e479da61794 /legal.html#terms

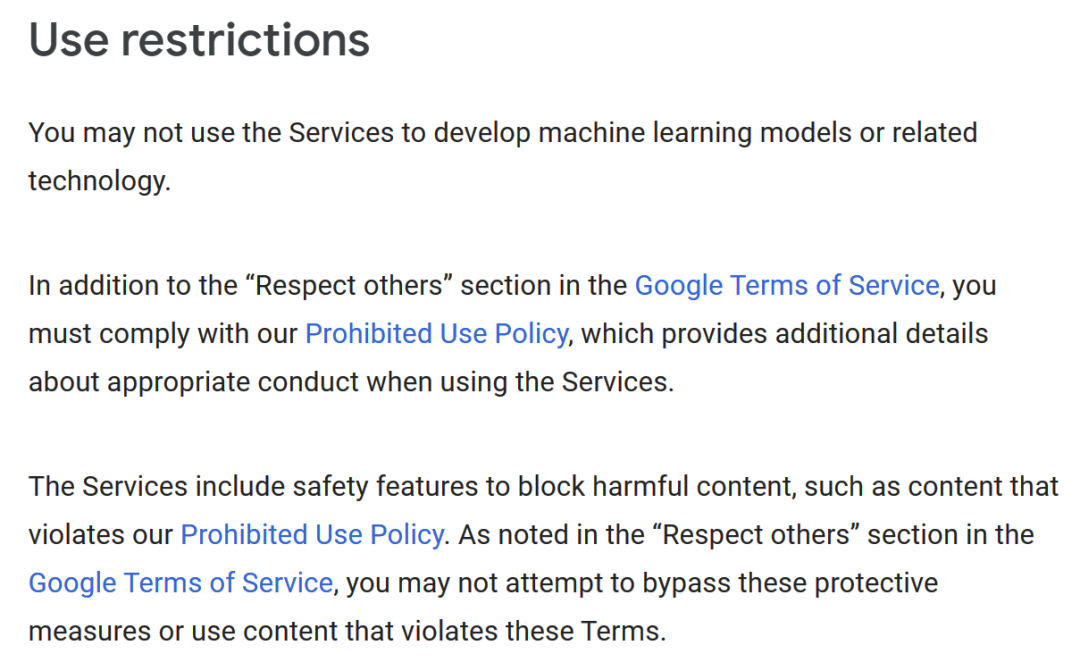

Begitu juga, Syarat Penggunaan AI Generatif Google menyatakan, “Anda tidak boleh menggunakan Perkhidmatan Untuk membangunkan model pembelajaran mesin atau teknologi berkaitan 》

Alamat Penggunaan Google Generative AI: https: //policies.google.com/terms/generative-ai

Bagaimana pula dengan syarat penggunaan OpenAI? Sama seperti Google, "Anda tidak boleh menggunakan output daripada Perkhidmatan untuk membangunkan model yang bersaing dengan OpenAI." >Alamat penggunaan OpenAI: https://openai.com/policies/terms-of-use

Syarikat ini bijak dan mereka tahu bahawa kandungan berkualiti tinggi adalah penting untuk melatih model AI baharu, jadi wajar untuk tidak membenarkan orang lain menggunakan output mereka dengan cara ini. Tetapi mereka tidak ragu-ragu dalam menggunakan data orang lain untuk melatih model mereka sendiri. Bagaimana untuk menjelaskan perkara ini?

OpenAI, Google dan Anthropic menolak permintaan Insider untuk komen dan tidak membalas.

Reddit, Twitter dan Lain-Lain: Cukuplah

Sebenarnya, syarikat lain tidak gembira apabila menyedari apa yang berlaku. Pada bulan April, Reddit, yang telah digunakan selama bertahun-tahun untuk melatih model AI, merancang untuk mula mengecas untuk akses kepada datanya.

Ketua Pegawai Eksekutif Reddit Steve Huffman berkata, "Korpus data Reddit terlalu berharga untuk memberikan nilai itu kepada syarikat terbesar di dunia secara percuma

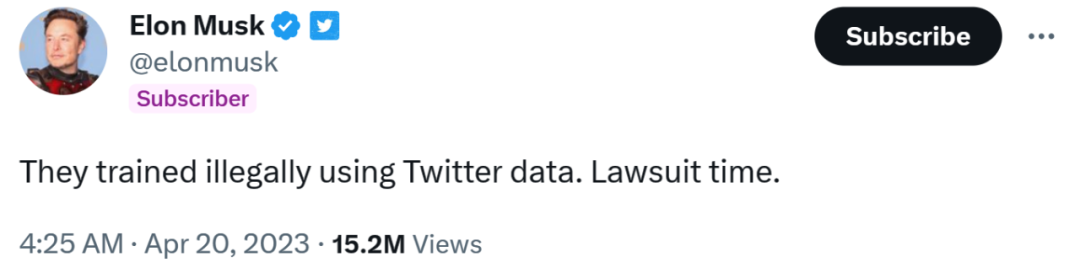

Juga pada April tahun ini, Musk menuduh Microsoft, penyokong utama OpenAI, secara haram menggunakan data Twitter untuk melatih model AI. "Masa untuk litigasi," tulisnya di Twitter.

Namun, sebagai tindak balas kepada komen Insider, Microsoft berkata, “Terdapat banyak perkara yang salah dengan premis ini sehingga saya tidak tahu di mana untuk memulakan. 》

Ketua Pegawai Eksekutif OpenAI Sam Altman cuba mendalami masalah ini dengan meneroka model AI baharu yang menghormati hak cipta. Menurut Axios, dia baru-baru ini berkata, "Kami sedang cuba membangunkan model baharu. Jika sistem AI menggunakan kandungan anda atau menggunakan gaya anda, anda akan dibayar untuknya." 🎜>

Sam Altman

Sam Altman

Penerbit (termasuk Orang Dalam) semuanya adalah kepentingan peribadi. Selain itu, beberapa penerbit, termasuk U.S. News Corp., sudah pun mendesak syarikat teknologi membayar untuk menggunakan kandungan mereka untuk melatih model AI.

Kaedah latihan semasa model AI "memecahkan" rangkaian

Seorang bekas eksekutif Microsoft berkata mesti ada masalah dengan perkara ini. Veteran Microsoft dan pembangun perisian terkenal Steven Sinofsky percaya bahawa kaedah latihan semasa model AI "memecahkan" rangkaian.

Dia menolak Dia menulis, "Pada masa lalu, data yang dirangkak digunakan sebagai pertukaran untuk kadar klik lalu. Tetapi kini ia hanya digunakan untuk melatih model dan tidak membawa apa-apa nilai kepada pencipta dan pemilik hak cipta." >Mungkin, apabila lebih banyak syarikat bangun, penggunaan data yang tidak sekata dalam era AI generatif ini akan diubah tidak lama lagi.

Atas ialah kandungan terperinci OpenAI dan Google bermain-main dengan standard dwi mereka: melatih model besar menggunakan data orang lain, tetapi tidak pernah membenarkan data mereka sendiri bocor keluar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI