Rumah >Peranti teknologi >AI >Temu bual terkini dengan pengasas OpenAI Sam Altman: GPT-3 atau sumber terbuka, peraturan penskalaan mempercepatkan pembinaan AGI

Temu bual terkini dengan pengasas OpenAI Sam Altman: GPT-3 atau sumber terbuka, peraturan penskalaan mempercepatkan pembinaan AGI

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-06-04 22:22:181251semak imbas

Dihasilkan oleh Big Data Digest

“Kami sangat kekurangan GPU”

Dalam temu bual baru-baru ini, Sam Altman, ketua OpenAI, menjawab soalan hos tentang “ketidakpuasan hati adalah dengan kebolehpercayaan dan kelajuan API".

Temu bual ini datang daripada Raza Habib, Ketua Pegawai Eksekutif pemula kecerdasan buatan Humanloop Dia menyusun sorotan wawancara itu di Twitter.

Alamat Twitter:

https://twitter.com/dr_cintas/status/1664281914948337664

temu bual ini, Altman juga mengumumkan rancangan GPT untuk dua tahun yang lalu, contohnya, rancangan untuk 2023 adalah untuk mengurangkan kos GPT-4 dan meningkatkan kelajuan tindak balas yang lain termasuk:

1 boleh menyokong 1 juta token;

2 Memperhalusi API untuk membantu pembangun membangun dengan lebih baik;

Pelan 2024 menyebut bahawa GPT-4 menyokong multi-modaliti Sebab mengapa ia ditangguhkan ke 2024 adalah kerana GPU terlalu sedikit.

Raza Habib pada asalnya menerbitkan maklumat yang lebih terperinci tentang temu bual ini kepada Humanloop, tetapi apabila Digest menyemak pagi ini, halaman itu sudah 404. Menurut terjemahan @宝玉xp di Weibo domestik, beliau turut menyebut peraturan penskalaan untuk pembangunan model besar masa hadapan:

Data dalaman OpenAI menunjukkan bahawa peraturan penskalaan untuk prestasi model diteruskan untuk menjadi berkesan, menjadikan model Lebih Besar akan terus menghasilkan prestasi. OpenAI telah menskalakan modelnya berjuta-juta kali, jadi ia tidak boleh meneruskan skala pada kadar yang tidak akan mampan pada masa hadapan. Ini tidak bermakna OpenAI tidak akan terus mencuba untuk menjadikan model lebih besar, ia hanya bermakna mereka mungkin hanya akan berganda atau tiga kali ganda setiap tahun dan bukannya meningkat dengan banyak pesanan magnitud.

Fakta bahawa penskalaan terus berkesan mempunyai implikasi penting untuk garis masa pembangunan AGI. Andaian penskalaan ialah kami mungkin sudah mempunyai kebanyakan bahagian yang diperlukan untuk membina AGI, dan kebanyakan kerja yang tinggal akan menskalakan kaedah sedia ada kepada model yang lebih besar dan set data yang lebih besar. Sekiranya era penskalaan sudah berakhir, maka kita mungkin perlu mengharapkan AGI berada lebih jauh. Bahawa Undang-undang Penskalaan terus berkuat kuasa menunjukkan garis masa yang lebih pendek.

Jelas sekali, penskalaan undang-undang ialah laluan terpantas ke AGI.

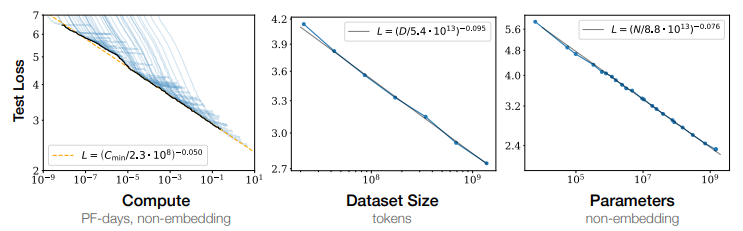

Apakah peraturan penskalaan?

Dengan kata lain, apabila bilangan parameter model (Parameter), jumlah data yang terlibat dalam latihan (Token), dan jumlah pengiraan terkumpul (FLOPS) proses latihan meningkat secara eksponen, prestasi model pada set ujian meningkat secara eksponen Kerugian menurun secara linear, yang bermaksud model berprestasi lebih baik.

Pada tahun 2022, DeepMind menjalankan analisis lanjut dalam ScalingLaw. Penyelidikan telah mengesahkan melalui eksperimen kuantitatif bahawa saiz data latihan model bahasa harus diperbesarkan mengikut kadar saiz parameter model. Apabila jumlah pengiraan kekal tidak berubah, kesan latihan model mempunyai titik keseimbangan optimum antara saiz parameter dan jumlah data latihan Titik terendah di bawah lengkung adalah kompromi yang sangat baik antara saiz parameter dan jumlah data latihan. titik.

Kejayaan OpeaAI dan GPT-4

OpenAI pada asalnya ialah makmal penyelidikan kecerdasan buatan bukan untung yang menerima pembiayaan daripada Sam Altman dan Elon Musk pada 201610 bilion dalam pembiayaan.

Pada 2019, OpenAI berubah menjadi makmal penyelidikan kecerdasan buatan untuk keuntungan untuk menyerap dana pelabur.

Apabila makmal kehabisan dana untuk menyokong penyelidikannya, Microsoft mengumumkan bahawa ia akan melabur AS$1 bilion lagi dalam makmal.

Setiap versi siri GPT yang dilancarkan oleh OpenAI boleh menyebabkan karnival dalam industri Pada Persidangan Pembangun Microsoft Build 2023, pengasas OpenAI Andrej Karpthy memberi ucapan: Keadaan GPT (status semasa GPT), berkata. Mereka telah melatih model besar sebagai "otak manusia".

Andrej menyebut bahawa model bahasa besar LLM semasa boleh dibandingkan dengan Sistem 1 (sistem pantas) mod pemikiran manusia, yang dibandingkan dengan Sistem 2 (sistem perlahan) yang bertindak balas dengan perlahan tetapi mempunyai penaakulan jangka panjang. .

“Sistem satu ialah proses automatik yang pantas yang saya rasa sepadan dengan LLM, hanya pensampelan token

Sistem dua ialah bahagian otak yang lebih perlahan dan disengajakan

Projek segera itu pada asasnya berharap dapat memulihkan beberapa keupayaan otak kita kepada LLM ”Andrej Karpthy juga menyebut bahawa GPT-4 adalah artifak yang menakjubkan, dan dia sangat pandai bahawa ia wujud. Ia mempunyai banyak pengetahuan dalam banyak bidang, ia boleh melakukan matematik, kod dan banyak lagi, semuanya di hujung jari anda. Ketua Pegawai Eksekutif Altman berkata bahawa pada masa awal, GPT-4 sangat perlahan, mempunyai pepijat dan melakukan banyak perkara dengan buruk. Tetapi begitu juga komputer terawal, yang masih menunjukkan jalan kepada sesuatu yang akan menjadi sangat penting dalam kehidupan kita, walaupun ia mengambil masa beberapa dekad untuk berkembang. Dari sudut pandangan ini, OpenAI ialah sebuah organisasi yang menegaskan impian dan mahu melakukan perkara yang melampau. Seperti Zhou Ming, bekas naib presiden Microsoft Research Asia dan pengasas Teknologi Lanzhou, menyebut dalam temu bual:OpenAI's pencapaian terbesar ialah mencapai kesempurnaan dalam semua aspek dan merupakan model inovasi bersepadu. Terdapat beberapa jenis orang di dunia ini. Sesetengah orang hanya ingin mengkaji inovasi asas. Sesetengahnya adalah aplikasi berdasarkan inovasi asas, manakala aplikasi umum adalah untuk menyelesaikan satu tugasan. Ia boleh ditulis semula sebagai: Pendekatan lain adalah untuk mencapai inovasi bersepadu, menumpukan semua kerja, aplikasi dan algoritma pada platform yang besar untuk mencipta pencapaian. OpenAI kebetulan melakukan kerja yang sangat baik untuk menyepadukan inovasi.Rujukan: https://mp.weixin.qq.com/s/p42pBVyjZws8XsstDoR2Jw https://mp.weixin.qq.com/s/zmEGzm1cdXupNoqZ65h7yg https://weibo.com/1727858283/4907695679472174?wm=3333_2001&from=10D5293010&20type=trans4010&2 95679472174&s_channel=4 https://humanloop.com/blog/openai - plans?cnotallow=bd9e76a5f41a6d847de52fa275480e22

Atas ialah kandungan terperinci Temu bual terkini dengan pengasas OpenAI Sam Altman: GPT-3 atau sumber terbuka, peraturan penskalaan mempercepatkan pembinaan AGI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI