Rumah >Peranti teknologi >AI >Meta terus melempar AI untuk mempercepatkan langkah muktamad! Cip inferens AI pertama, superkomputer AI yang direka khas untuk latihan model besar

Meta terus melempar AI untuk mempercepatkan langkah muktamad! Cip inferens AI pertama, superkomputer AI yang direka khas untuk latihan model besar

- 王林ke hadapan

- 2023-05-25 22:04:041742semak imbas

Disusun |. Li Shuiqing

Edit |. Hati

Zhixixi News pada 19 Mei Pada 18 Mei waktu tempatan, Meta mengumumkan di laman web rasminya bahawa untuk menampung pertumbuhan mendadak dalam permintaan untuk kuasa pengkomputeran AI dalam sepuluh tahun akan datang, Meta sedang melaksanakan rancangan besar - untuk. membina persekitaran baharu khusus untuk infrastruktur Penjanaan AI.

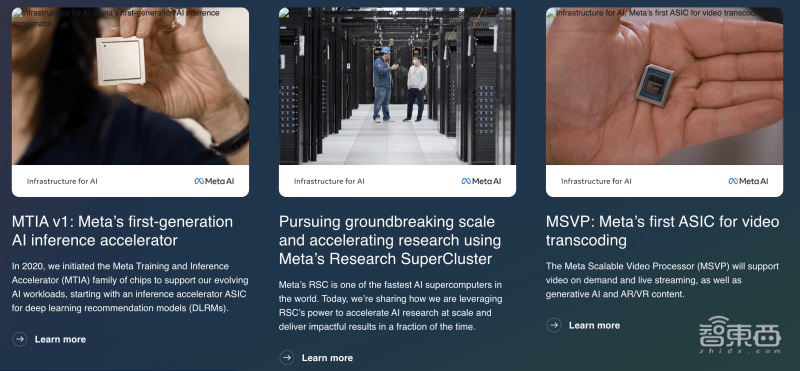

Meta mengumumkan kemajuan terbaharunya dalam membina infrastruktur generasi akan datang untuk AI, termasuk cip tersuai pertama untuk menjalankan model AI, reka bentuk pusat data yang dioptimumkan AI baharu, ASIC transkod video pertama dan penyepaduan 16,000 GPU, AI RSC superkomputer digunakan untuk mempercepatkan latihan AI, dsb.

▲Pendedahan tapak web rasmi meta tentang butiran infrastruktur AI

Meta menganggap AI sebagai infrastruktur teras syarikat. Sejak Meta mencecah pusat data pertamanya pada tahun 2010, AI telah menjadi enjin kepada lebih 3 bilion orang yang menggunakan keluarga aplikasi Meta setiap hari. Daripada perkakasan Big Sur pada tahun 2015 kepada pembangunan PyTorch, kepada penggunaan awal superkomputer AI Meta tahun lepas, Meta kini sedang meningkatkan dan mengembangkan infrastruktur ini.

1. Pemecut inferens AI generasi pertama Meta, proses 7nm, kuasa pengkomputeran 102.4TOPS

MTIA (Meta Training and Inference Accelerator) ialah siri cip pemecut tersuai dalaman pertama Meta untuk beban kerja inferens.

Beban kerja AI ada di mana-mana dalam perniagaan Meta dan merupakan asas untuk pelbagai projek aplikasi, termasuk pemahaman kandungan, aliran maklumat, AI generatif dan kedudukan iklan. Apabila model AI meningkat dalam saiz dan kerumitan, sistem perkakasan asas perlu menyediakan peningkatan eksponen dalam ingatan dan pengiraan sambil mengekalkan kecekapan. Walau bagaimanapun, Meta mendapati sukar bagi CPU untuk memenuhi keperluan tahap kecekapan yang diperlukan oleh skalanya, jadi ia mereka bentuk latihan yang dibangunkan sendiri dan siri MTIA ASIC pemecut inferens Meta untuk menangani cabaran ini.

Sejak 2020, Meta telah mereka bentuk MTIA ASIC generasi pertama untuk beban kerja dalamannya. Pemecut menggunakan proses 7nm TSMC, berjalan pada 800MHz, dan menyediakan kuasa pengkomputeran 102.4TOPS pada ketepatan INT8 dan kuasa pengkomputeran 51.2TFLOPS pada ketepatan FP16. Kuasa reka bentuk terma (TDP) ialah 25W.

Menurut laporan, MTIA menyediakan kuasa dan kecekapan pengkomputeran yang lebih tinggi daripada CPU Dengan menggunakan cip MTIA dan GPU pada masa yang sama, ia akan memberikan prestasi yang lebih baik, kependaman yang lebih rendah dan kecekapan yang lebih tinggi untuk setiap beban kerja.

2 Susun atur pusat data generasi seterusnya dan bangunkan transkod video pertama ASIC

Reka bentuk pusat data generasi seterusnya Meta akan menyokong produk semasanya sambil menyokong latihan dan inferens untuk perkakasan AI generasi akan datang. Pusat data baharu ini akan dioptimumkan untuk AI, menyokong perkakasan AI yang disejukkan cecair dan rangkaian AI berprestasi tinggi yang menghubungkan beribu-ribu cip AI untuk kelompok latihan AI skala pusat data.

Menurut laman web rasmi, pusat data generasi seterusnya Meta juga akan dibina dengan lebih pantas dan lebih menjimatkan kos, dan akan dilengkapkan dengan perkakasan baharu yang lain, seperti penyelesaian ASIC yang dibangunkan secara dalaman pertama Meta, MSVP, yang direka untuk menyediakan perkhidmatan Meta berkembang Dikuasakan oleh beban kerja video.

Dengan kemunculan kandungan teknologi baharu seperti AI generatif, permintaan orang ramai terhadap infrastruktur video semakin meningkat, yang mendorong Meta melancarkan pemproses video berskala MSVP.

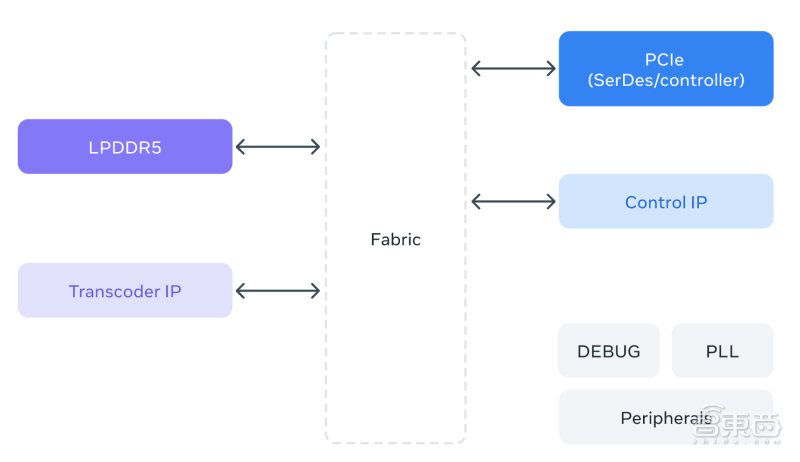

MSVP ialah ASIC dibangunkan dalaman pertama Meta untuk transkod video. MSVP boleh diprogramkan dan berskala, dan boleh dikonfigurasikan untuk menyokong transcoding berkualiti tinggi yang diperlukan untuk permintaan atas permintaan dengan cekap, serta kependaman rendah dan masa pemprosesan yang lebih pantas yang diperlukan untuk penstriman langsung. Pada masa hadapan, MSVP juga akan membantu membawa bentuk kandungan video baharu kepada setiap ahli keluarga aplikasi Meta - termasuk kandungan yang dijana AI serta kandungan VR (realiti maya) dan AR (realiti tambahan).

▲Rajah seni bina MSVP

3. Superkomputer AI menyepadukan 16,000 GPU dan menyokong model besar LLaMA untuk mempercepatkan lelaran latihan

Menurut pengumuman Meta, AI Super Computer (RSC)nya ialah salah satu superkomputer kecerdasan buatan terpantas di dunia Ia direka untuk melatih model AI berskala besar generasi akan datang untuk alat AR baharu, sistem pemahaman kandungan. teknologi terjemahan masa nyata, dsb. Memberi motivasi.

Meta RSC menampilkan 16,000 GPU, semuanya boleh diakses melalui struktur rangkaian Clos tiga peringkat, memberikan lebar jalur penuh kepada setiap 2,000 sistem latihan. Sepanjang tahun lalu, RSC telah mempromosikan projek penyelidikan seperti LLaMA.

LLaMA ialah model bahasa berskala besar yang dibina dan sumber terbuka oleh Meta awal tahun ini, dengan skala 65 bilion parameter. Meta mengatakan matlamatnya adalah untuk menyediakan model yang lebih kecil dan berprestasi tinggi yang boleh dikaji oleh penyelidik dan memperhalusi untuk tugasan tertentu tanpa memerlukan perkakasan yang penting.

Meta melatih LLaMA 65B dan LLaMA 33B yang lebih kecil berdasarkan 1.4 trilion Token. Model terkecilnya, LLaMA 7B, juga menggunakan satu trilion Token untuk latihan. Keupayaan untuk berjalan pada skala membolehkan Meta mempercepatkan latihan dan penalaan lelaran, mengeluarkan model lebih pantas daripada perniagaan lain.

Kesimpulan: Aplikasi teknologi model berskala besar telah memaksa pengeluar utama untuk mempercepatkan penggunaan infrastruktur

Meta reka bentuk tersuai kebanyakan infrastrukturnya terutamanya kerana ini membolehkannya mengoptimumkan pengalaman hujung ke hujung, termasuk dari lapisan fizikal ke lapisan perisian kepada pengalaman pengguna sebenar. Oleh kerana tindanan dikawal dari atas ke bawah, ia boleh disesuaikan mengikut keperluan khusus anda. Infrastruktur ini akan menyokong Meta dalam membangunkan dan menggunakan model AI yang lebih besar dan lebih kompleks.

Dalam beberapa tahun akan datang, kita akan melihat peningkatan pengkhususan dan penyesuaian dalam reka bentuk cip, infrastruktur AI khusus dan beban kerja, sistem dan alatan baharu serta peningkatan kecekapan dalam sokongan produk dan reka bentuk. Ini akan memberikan model dan produk yang semakin canggih yang dibina berdasarkan penyelidikan terkini, membolehkan orang ramai di seluruh dunia menggunakan teknologi baru muncul ini.

Sumber: laman web rasmi Meta

Atas ialah kandungan terperinci Meta terus melempar AI untuk mempercepatkan langkah muktamad! Cip inferens AI pertama, superkomputer AI yang direka khas untuk latihan model besar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI