Rumah >Peranti teknologi >AI >OpenAI menggunakan GPT-4 untuk menerangkan 300,000 neuron GPT-2: Beginilah rupa kebijaksanaan

OpenAI menggunakan GPT-4 untuk menerangkan 300,000 neuron GPT-2: Beginilah rupa kebijaksanaan

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-05-25 12:04:061269semak imbas

Walaupun ChatGPT nampaknya mendekatkan manusia kepada mencipta semula kecerdasan, setakat ini kita tidak pernah memahami sepenuhnya apa itu kecerdasan, sama ada semula jadi atau buatan.

Jelas sekali perlu memahami prinsip kecerdasan Bagaimana untuk memahami kecerdasan model bahasa yang besar? Penyelesaian yang diberikan oleh OpenAI ialah: tanya apa yang dikatakan oleh GPT-4.

Pada 9 Mei, OpenAI mengeluarkan penyelidikan terbaharunya, yang menggunakan GPT-4 untuk mentafsir secara automatik tingkah laku neuron dalam model bahasa besar, dan memperoleh banyak hasil yang menarik.

Cara mudah untuk mengkaji kebolehtafsiran adalah dengan terlebih dahulu memahami komponen individu model AI (neuron dan perhatian kepala) ) sedang melakukan. Kaedah tradisional memerlukan manusia memeriksa neuron secara manual untuk menentukan ciri data yang diwakilinya. Proses ini sukar untuk skala, dan menerapkannya pada rangkaian saraf dengan ratusan atau ratusan bilion parameter adalah sangat mahal.

Jadi OpenAI mencadangkan kaedah automatik - menggunakan GPT-4 untuk menjana dan menjaringkan penjelasan bahasa semula jadi tentang tingkah laku neuron dan menerapkannya pada bahasa lain Neuron dalam model - Di sini mereka memilih GPT-2 sebagai sampel eksperimen dan menerbitkan set data tafsiran dan skor neuron GPT-2 ini.

- Alamat kertas: https://openaipublic.blob.core.windows.net/ neuron-explainer/paper/index.html

- Rajah neuron GPT-2: https://openaipublic.blob.core.windows.net/neuron- explainer /neuron-viewer/index.html

- Kod dan set data: https://github.com/openai/automated-interpretability

Teknologi ini membolehkan orang ramai menggunakan GPT-4 untuk mentakrif dan mengukur secara automatik konsep kuantitatif kebolehtafsiran model AI: ia digunakan untuk mengukur model bahasa menggunakan pemampatan dan pembinaan semula bahasa semula jadi Keupayaan neuron untuk diaktifkan. Oleh kerana sifat kuantitatifnya, kita kini boleh mengukur kemajuan dalam memahami matlamat pengiraan rangkaian saraf.

OpenAI menyatakan bahawa menggunakan penanda aras yang mereka tetapkan, skor penggunaan AI untuk menerangkan AI boleh mencapai tahap yang hampir dengan manusia.

Pengasas bersama OpenAI Greg Brockman juga berkata bahawa kami telah mengambil langkah penting ke arah menggunakan AI untuk mengautomasikan penyelidikan penjajaran.

Kaedah khusus

Kaedah menggunakan AI untuk menerangkan AI melibatkan menjalankan tiga langkah pada setiap neuron:

Langkah 1: Gunakan GPT-4 untuk menjana penjelasan

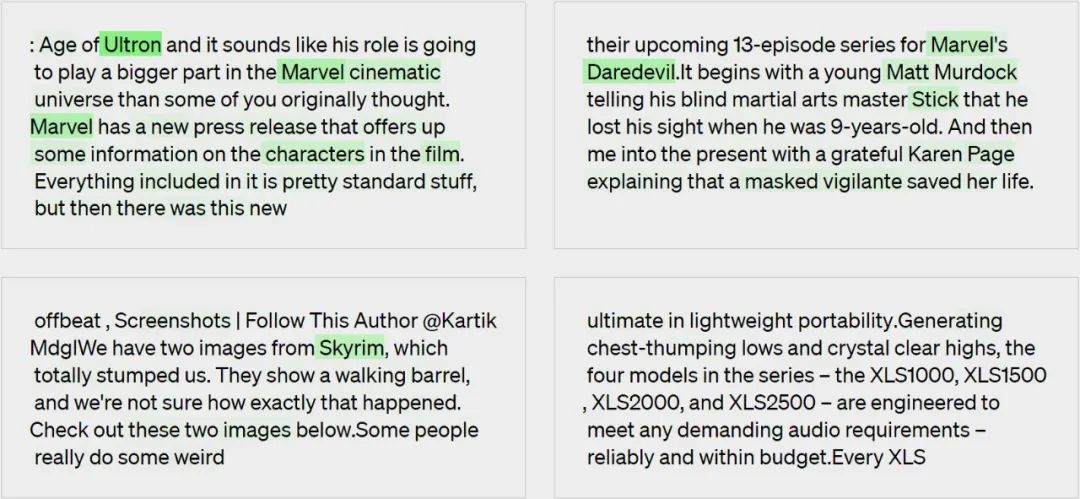

Diberikan neuron GPT-2 , dengan menunjukkan Urutan dan pengaktifan teks yang berkaitan GPT-4 untuk menjana penjelasan tentang kelakuannya.

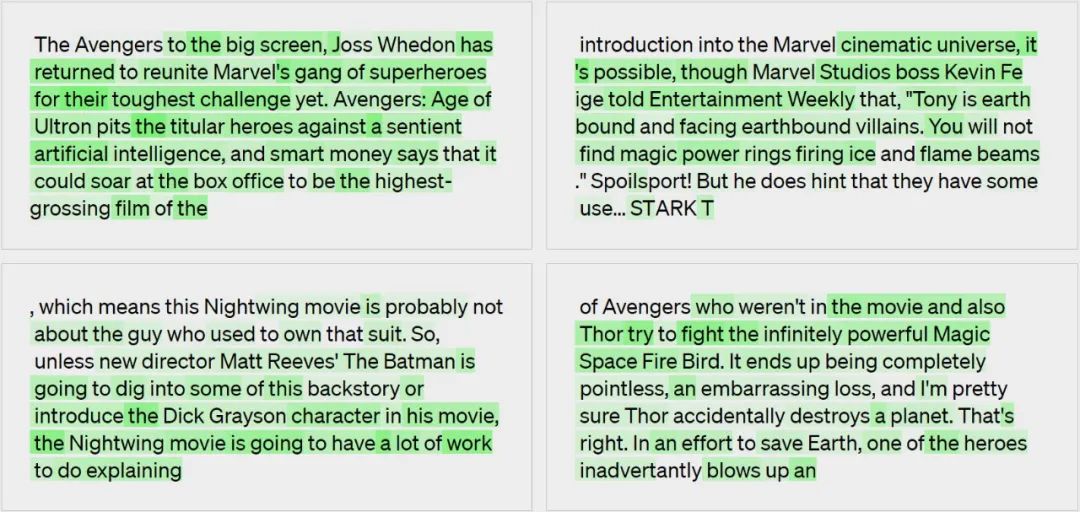

Penjelasan penjanaan model: rujukan kepada filem, watak dan hiburan.

Langkah 2: Gunakan GPT-4 untuk mensimulasikan

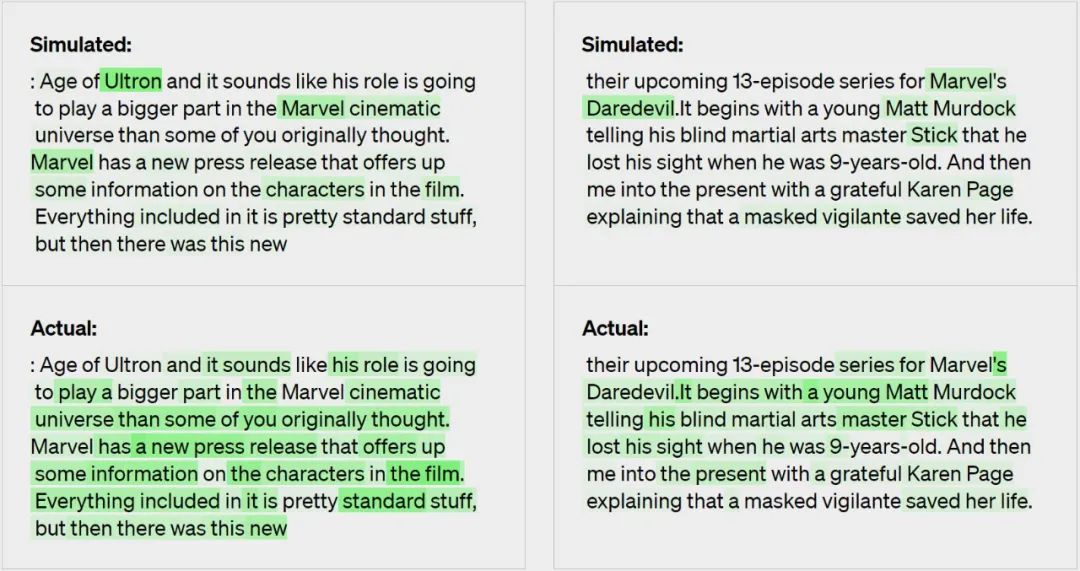

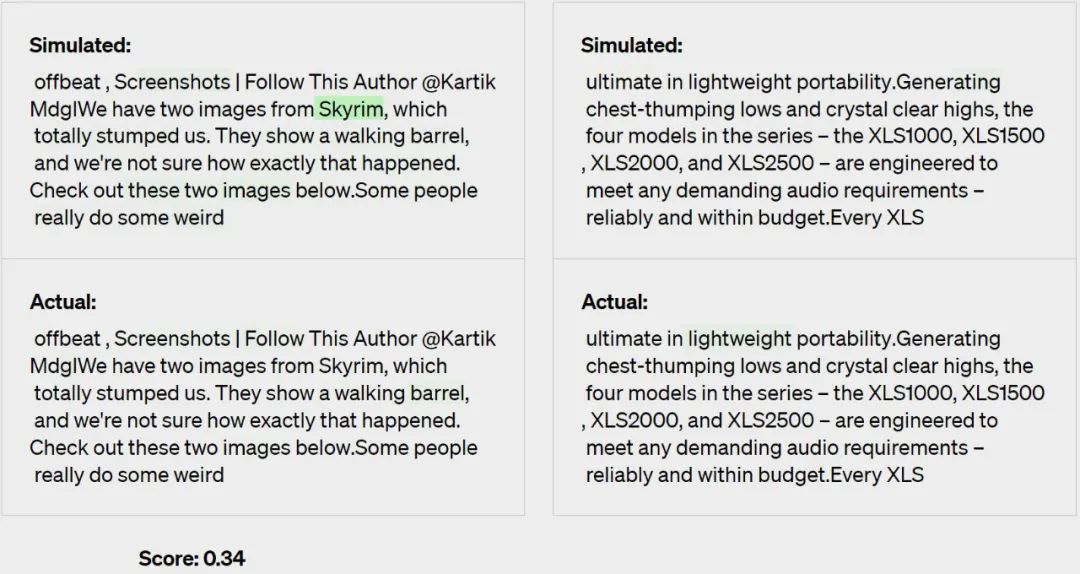

Gunakan GPT-4 sekali lagi untuk mensimulasikan saraf yang dijelaskan Apa adakah Yuan akan melakukannya.

Langkah 3: Perbandingan

Penjelasan dijaringkan berdasarkan sejauh mana pengaktifan simulasi sepadan dengan pengaktifan sebenar - dalam kes ini, GPT-4 mendapat markah 0.34.

Penemuan utama

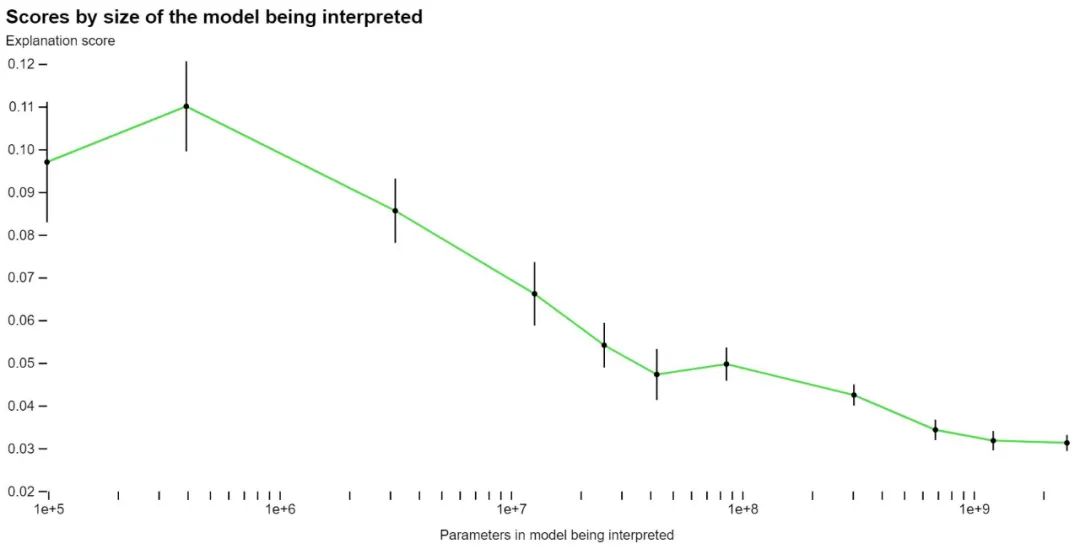

Menggunakan kaedah pemarkahannya sendiri, OpenAI mula mengukur keberkesanan teknologi mereka pada bahagian rangkaian yang berbeza dan cuba menambah baik teknologi untuk bahagian yang tidak jelas pada masa ini. Sebagai contoh, teknik mereka tidak berfungsi dengan baik dengan model yang lebih besar, mungkin kerana lapisan kemudiannya lebih sukar untuk ditafsirkan.

OpenAI mengatakan bahawa walaupun sebahagian besar penjelasan mereka tidak mendapat markah tinggi, mereka percaya mereka kini boleh menggunakan ML teknologi untuk meningkatkan lagi keupayaan mereka untuk menjana penjelasan. Sebagai contoh, mereka mendapati bahawa perkara berikut membantu meningkatkan markah mereka:

- Penjelasan berulang. Mereka boleh meningkatkan markah mereka dengan meminta GPT-4 memikirkan contoh balas yang mungkin dan kemudian mengubah suai penjelasan berdasarkan pengaktifan mereka.

- Gunakan model yang lebih besar untuk penjelasan. Apabila keupayaan model explainer bertambah baik, skor purata juga akan meningkat. Walau bagaimanapun, walaupun GPT-4 memberikan penjelasan yang lebih buruk daripada manusia, menunjukkan terdapat ruang untuk penambahbaikan.

- Tukar seni bina model yang dijelaskan. Melatih model dengan fungsi pengaktifan yang berbeza meningkatkan skor penjelasan.

OpenAI berkata mereka sedang membuat set data dan alat visualisasi yang ditulis dalam GPT-4 yang mentafsir semua 307,200 neuron dalam sumber terbuka GPT-2. Pada masa yang sama, mereka juga menyediakan kod untuk tafsiran dan pemarkahan menggunakan model yang tersedia secara terbuka pada OpenAI API. Mereka berharap komuniti penyelidikan akan membangunkan teknik baharu untuk menjana penjelasan berskor lebih tinggi, serta alat yang lebih baik untuk meneroka GPT-2 melalui penjelasan.

Mereka mendapati bahawa lebih daripada 1,000 neuron mempunyai skor penjelasan sekurang-kurangnya 0.8, bermakna mereka menyumbang kebanyakan tingkah laku pengaktifan teratas neuron mengikut GPT-4. Kebanyakan neuron yang dijelaskan dengan baik ini tidak begitu menarik. Walau bagaimanapun, mereka juga menemui banyak neuron menarik yang tidak difahami oleh GPT-4. OpenAI berharap apabila penjelasan bertambah baik, mereka boleh dengan cepat menemui cerapan kualitatif yang menarik tentang pengiraan model.

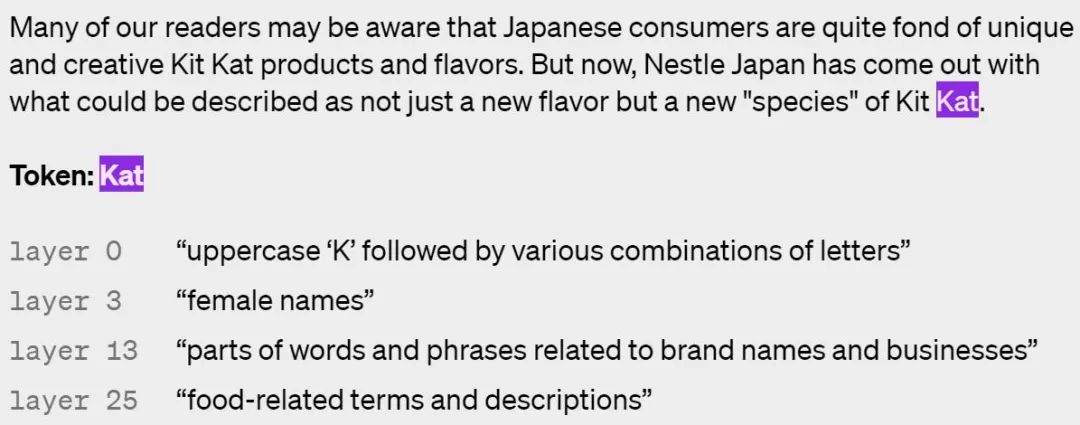

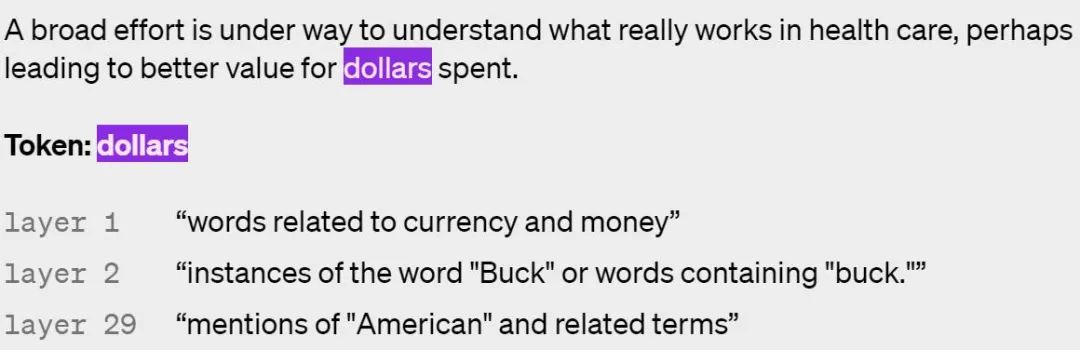

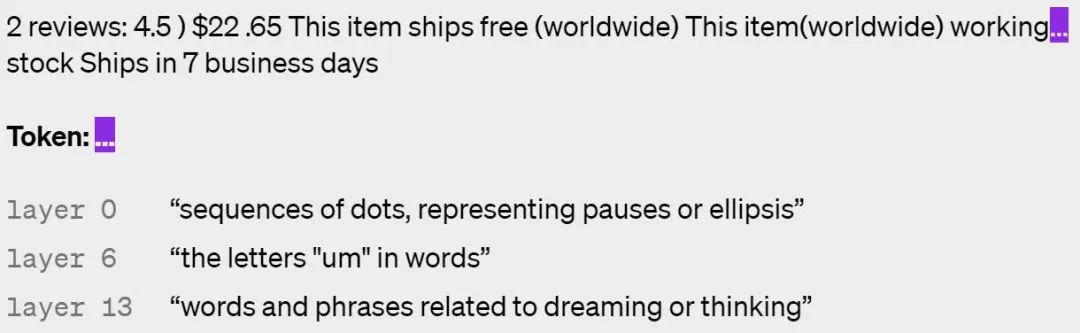

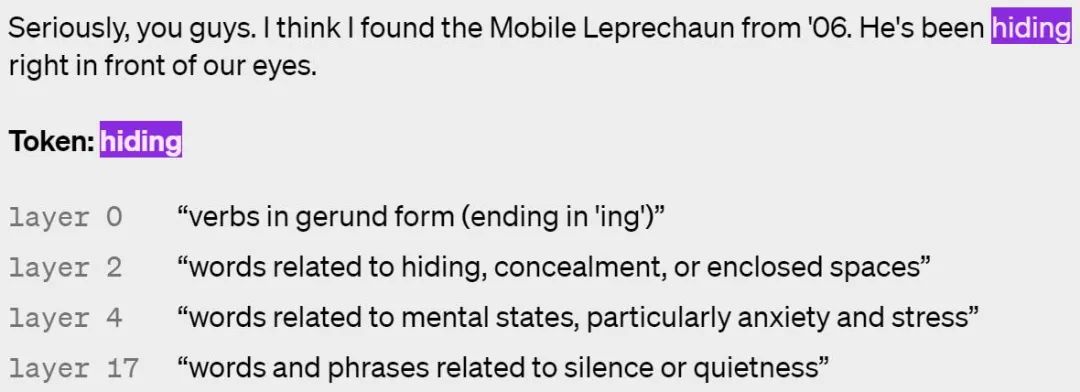

Berikut ialah beberapa contoh neuron yang diaktifkan dalam lapisan yang berbeza, dengan lapisan yang lebih tinggi menjadi lebih abstrak:

Nampaknya GPT memahami konsep secara berbeza daripada manusia?

Kerja masa depan OpenAIPada masa ini, kaedah ini masih mempunyai beberapa batasan, dan OpenAI berharap dapat menyelesaikan masalah ini dalam kerja akan datang:

- Kaedah ini memfokuskan pada penjelasan bahasa semula jadi yang pendek, tetapi neuron mungkin mempunyai tingkah laku yang sangat kompleks yang tidak dapat diterangkan secara ringkas; mencari dan mentafsir keseluruhan litar saraf untuk mencapai tingkah laku yang kompleks, dengan neuron dan ketua perhatian bekerja bersama. Kaedah semasa hanya mentafsirkan kelakuan neuron sebagai fungsi input teks mentah tanpa mengambil kira kesan hilirannya. Contohnya, neuron yang menyala pada satu noktah boleh menunjukkan bahawa perkataan seterusnya harus bermula dengan huruf besar, atau menambah pembilang ayat OpenAI menerangkan tingkah laku neuron ini, tanpa cuba menerangkan mekanisme yang menghasilkan tingkah laku ini. Ini bermakna penjelasan berskor tinggi mungkin berprestasi buruk pada teks luar pengedaran kerana ia hanya menerangkan korelasi;

- Akhirnya, OpenAI berharap dapat menggunakan model untuk membentuk, menguji dan mengulang hipotesis umum sepenuhnya, seperti yang dilakukan oleh penyelidik kebolehjelasan. Selain itu, OpenAI berharap untuk mentafsir model terbesarnya sebagai cara untuk mengesan penjajaran dan isu keselamatan sebelum dan selepas penggunaan. Namun, masih jauh lagi perjalanan sebelum itu berlaku.

Atas ialah kandungan terperinci OpenAI menggunakan GPT-4 untuk menerangkan 300,000 neuron GPT-2: Beginilah rupa kebijaksanaan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI