Rumah >Peranti teknologi >AI >Kawalan kendiri kini menjadi standard kawalan untuk kecerdasan buatan

Kawalan kendiri kini menjadi standard kawalan untuk kecerdasan buatan

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-05-21 13:31:061372semak imbas

Adakah anda bimbang bahawa kecerdasan buatan berkembang terlalu cepat dan mungkin mempunyai akibat negatif? Adakah anda ingin ada undang-undang negara yang mengawalnya? Hari ini, tiada undang-undang baharu untuk menyekat penggunaan AI, dan selalunya kawal selia kendiri menjadi pilihan terbaik untuk syarikat yang mengguna pakai AI - sekurang-kurangnya buat masa ini.

Walaupun "kecerdasan buatan" telah menggantikan "data besar" sebagai kata kunci terhangat dalam dunia teknologi selama bertahun-tahun, pada akhir November 2022 ChatGPT The pelancaran AI memulakan larian emas AI yang mengejutkan ramai pemerhati AI, termasuk kami. Dalam beberapa bulan sahaja, pelbagai model AI generatif yang berkuasa telah menarik perhatian dunia, berkat keupayaan luar biasa mereka untuk meniru bahasa dan pemahaman manusia.

Peningkatan luar biasa model generatif dalam budaya arus perdana, didorong oleh kemunculan ChatGPT, menimbulkan banyak persoalan tentang ke mana hala tuju semua ini. Fenomena menakjubkan kecerdasan buatan yang mampu menghasilkan puisi yang menarik dan seni aneh memberi laluan kepada kebimbangan tentang akibat negatif kecerdasan buatan, daripada bahaya pengguna dan kehilangan pekerjaan, sehingga ke penjara palsu dan juga kemusnahan manusia.

Ini menyebabkan sesetengah orang sangat bimbang. Bulan lalu, gabungan penyelidik AI meminta moratorium enam bulan ke atas pembangunan model generatif baharu yang lebih besar daripada GPT-4 (Bacaan lanjut: Surat terbuka menggesa moratorium penyelidikan AI), GPT-4, model besar OpenAI yang dilancarkan bulan lepas Model Bahasa (LLM).

Surat terbuka yang ditandatangani oleh pemenang Anugerah Turing Yoshua Bengio dan pengasas bersama OpenAI Elon Musk dan yang lain menyatakan: "Kecerdasan buatan lanjutan mungkin mewakili perubahan mendalam dalam sejarah kehidupan di Bumi dan harus Rancang dan urus dengan teliti dan sumber "Malangnya, tahap perancangan dan pengurusan ini tidak tercapai." Tinjauan pendapat menunjukkan rakyat Amerika tidak fikir kecerdasan buatan boleh dipercayai dan mahu ia dikawal, terutamanya pada perkara yang memberi kesan seperti kereta pandu sendiri dan akses kepada faedah kerajaan.

Namun walaupun beberapa undang-undang tempatan baharu menyasarkan AI — seperti di New York City yang menumpukan kepada penggunaan AI dalam pengambilan pekerja — usaha penguatkuasaan telah ditangguhkan Sehingga bulan ini—Kongres tidak mempunyai peraturan persekutuan baharu yang secara khusus menyasarkan AI yang menghampiri garisan penamat (walaupun AI telah memasuki bidang undang-undang industri yang sangat dikawal selia seperti perkhidmatan kewangan dan penjagaan kesihatan).

Didorong oleh kecerdasan buatan, apakah yang perlu dilakukan oleh syarikat? Tidak menghairankan bahawa syarikat ingin berkongsi faedah kecerdasan buatan. Lagipun, keinginan untuk menjadi "didorong data" dilihat sebagai satu keperluan untuk terus hidup dalam era digital. Walau bagaimanapun, syarikat juga ingin mengelakkan akibat negatif, nyata atau yang dilihat, yang boleh disebabkan oleh penggunaan AI yang tidak sesuai.

Kecerdasan buatan adalah liar "

Westworld". Andrew Burt, pengasas firma undang-undang kecerdasan buatan BNH.AI, pernah berkata, "Tiada siapa yang tahu cara menguruskan risiko. Semua orang melakukannya secara berbeza Maksudnya, syarikat boleh menggunakan Beberapa rangka kerja untuk." membantu menguruskan risiko AI. Burt mengesyorkan menggunakan Rangka Kerja Pengurusan Risiko Kecerdasan Buatan (

RMF: Rangka Kerja Pengurusan Risiko), yang berasal dari Institut Piawaian dan Teknologi Kebangsaan (NIST) dan telah dimuktamadkan awal tahun ini. RMF membantu syarikat memikirkan cara AI mereka berfungsi dan kemungkinan akibat negatif yang mungkin ditimbulkannya. Ia menggunakan pendekatan "peta, ukur, urus dan tadbir" untuk memahami dan akhirnya mengurangkan risiko menggunakan AI merentas pelbagai tawaran perkhidmatan.

Satu lagi rangka kerja pengurusan risiko AI datang daripada Cathy O'Neil, Ketua Pegawai Eksekutif O'Neil Risk Advisory & Algorithmic Audit (ORCAA). ORCAA mencadangkan rangka kerja yang dipanggil "

Keadilan Boleh Dijelaskan". Keadilan yang boleh dijelaskan memberi organisasi cara untuk bukan sahaja menguji algoritma mereka untuk berat sebelah, tetapi juga mengkaji perkara yang berlaku apabila perbezaan dalam hasil dikesan. Sebagai contoh, jika bank menentukan kelayakan untuk pinjaman pelajar, apakah faktor yang boleh digunakan secara sah untuk meluluskan atau menolak pinjaman atau mengenakan faedah yang lebih tinggi atau lebih rendah?

Jelas sekali, bank mesti menggunakan data untuk menjawab soalan ini. Tetapi apakah data yang boleh mereka gunakan—iaitu, faktor apakah yang mencerminkan pemohon pinjaman? Faktor manakah yang harus dibenarkan secara sah untuk digunakan dan faktor manakah yang tidak boleh digunakan? Menjawab soalan-soalan ini bukanlah mudah dan tidak mudah, kata O'Neil.

"Itulah maksud rangka kerja ini, ialah faktor undang-undang ini harus sah," kata O'Neil semasa perbincangan di Persidangan Teknologi GPU Nvidia (GTC) bulan lepas . "

Triveni Gandhi, ketua analisis data dan penyedia perisian AI Dataiku AI, berkata walaupun tanpa undang-undang AI baharu, syarikat harus mula bertanya kepada diri mereka sendiri bagaimana untuk bersikap adil dan patuh. beretika untuk mematuhi undang-undang sedia ada.

“Orang ramai perlu mula berfikir, okey, bagaimana kita mengambil undang-undang sedia ada dan menerapkannya pada kes penggunaan AI yang wujud pada masa ini?” “Ada beberapa peraturan, tetapi terdapat juga ramai Orang berfikir tentang cara beretika dan berorientasikan nilai yang kita mahu membina AI. Ini sebenarnya soalan yang mula ditanya oleh syarikat kepada diri mereka sendiri, walaupun tiada peraturan menyeluruh >

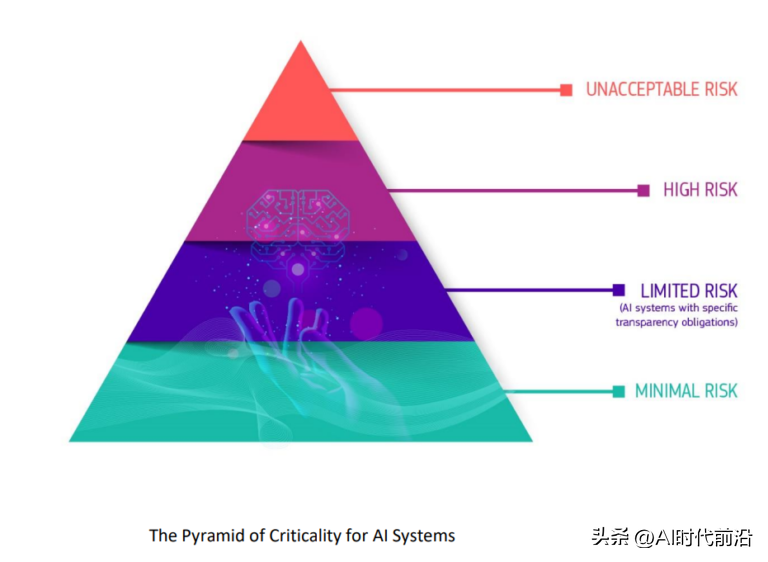

EU mengklasifikasikan potensi bahaya kecerdasan buatan kepada 'piramid kritikal'

EU sedang bergerak ke hadapan dengan peraturannya sendiri, Akta Kepintaran Buatan , rang undang-undang itu boleh berkuat kuasa akhir tahun ini .

Rang Undang-undang Kepintaran Buatan akan mewujudkan rangka kerja kawal selia dan undang-undang yang sama untuk penggunaan kecerdasan buatan yang menjejaskan penduduk EU, termasuk cara AI dibangunkan dan syarikat yang boleh menggunakannya untuk tujuan, dan akibat undang-undang kegagalan untuk mematuhi keperluan. Undang-undang boleh menghendaki syarikat mendapatkan kelulusan sebelum mengguna pakai AI dalam kes penggunaan tertentu dan mengharamkan penggunaan AI lain tertentu yang dianggap terlalu berisiko.Atas ialah kandungan terperinci Kawalan kendiri kini menjadi standard kawalan untuk kecerdasan buatan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI