Rumah >Peranti teknologi >AI >Dengan 3.6 trilion token dan 340 bilion parameter, butiran model besar Google PaLM 2 telah didedahkan

Dengan 3.6 trilion token dan 340 bilion parameter, butiran model besar Google PaLM 2 telah didedahkan

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-05-21 08:07:20965semak imbas

Khamis lalu, pada persidangan Google I/O 2023, Ketua Pegawai Eksekutif Google Pichai mengumumkan pelancaran PaLM 2, model besar yang menanda aras GPT-4, dan secara rasmi mengeluarkan versi pratonton, meningkatkan matematik, kod dan penaakulan , terjemahan pelbagai bahasa dan keupayaan penjanaan bahasa semula jadi.

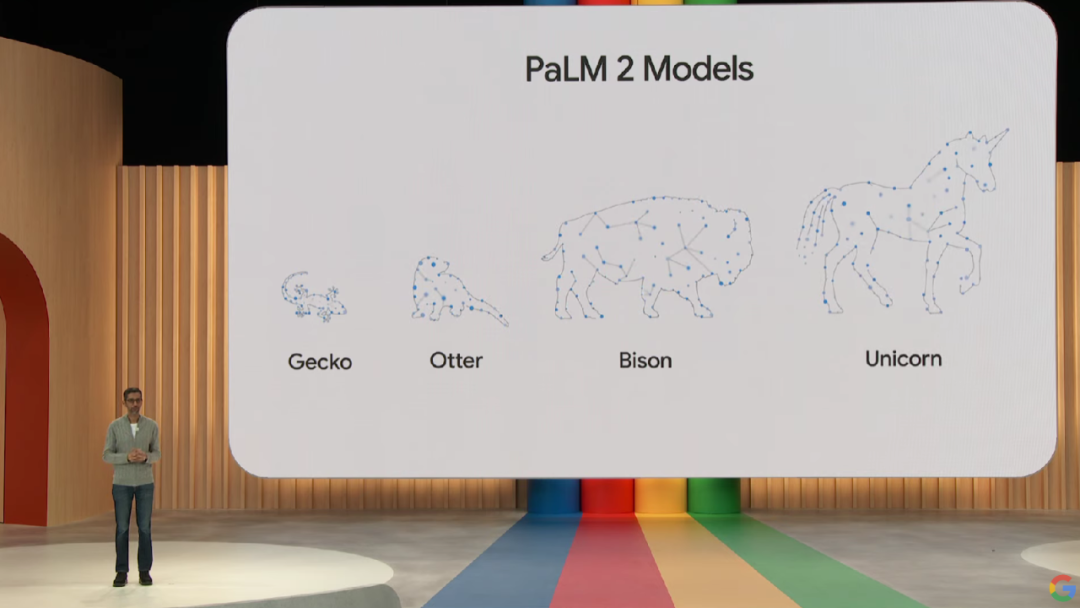

Model PaLM 2 menyediakan empat versi saiz yang berbeza, daripada kecil hingga lebih mudah untuk menggunakan pelbagai kes penggunaan untuk Gecko, Otter, Bison dan Unicorn. Antaranya, model Gecko yang ringan boleh dijalankan pada peranti mudah alih dengan cepat, dan aplikasi interaktif yang sangat baik boleh dijalankan pada peranti tanpa disambungkan ke Internet.

Walau bagaimanapun, pada mesyuarat itu, Google tidak memberikan butiran teknikal khusus tentang PaLM 2, hanya menyatakan bahawa ia dibina pada JAX dan TPU v4 terbaharu Google.

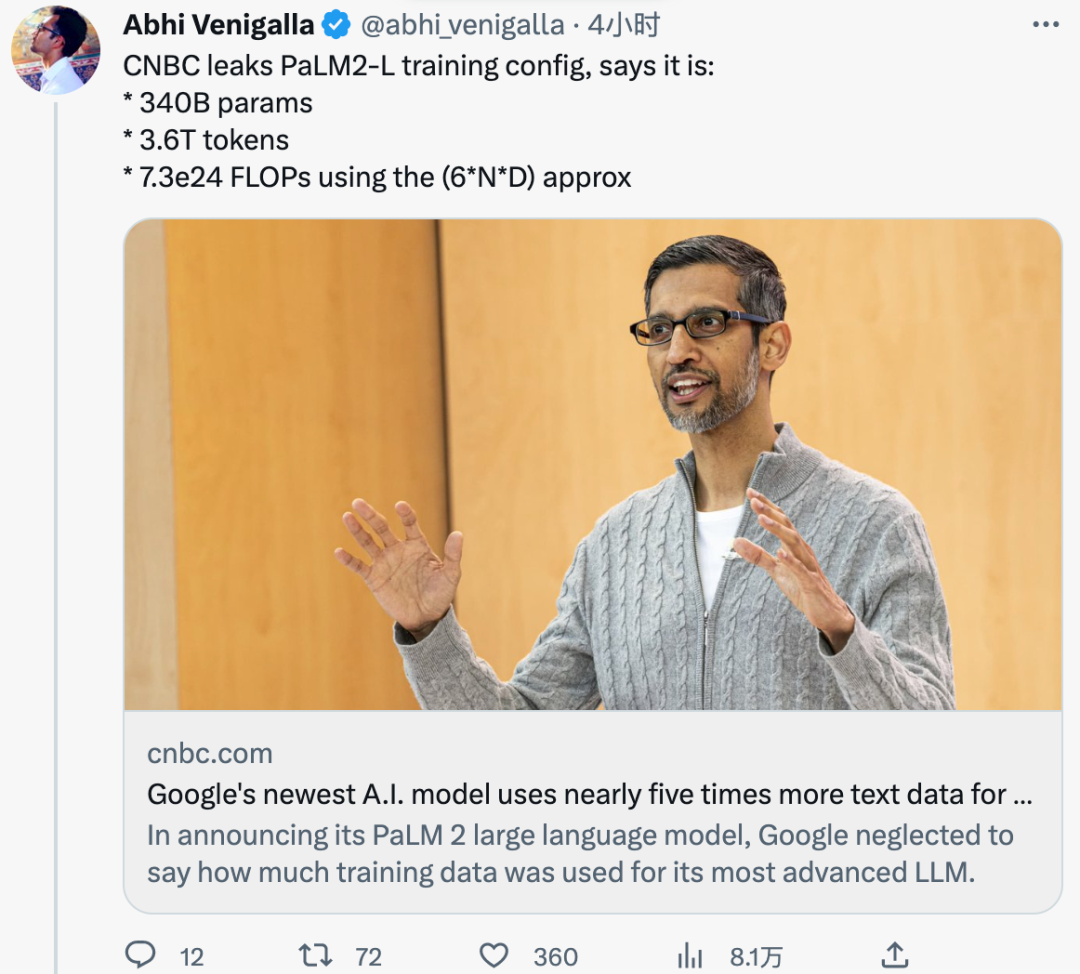

Semalam, menurut dokumen dalaman yang dilihat oleh media asing CNBC, PaLM 2 sedang Latihan mengenai 3.6 trilion token . Sebagai perbandingan, PaLM generasi sebelumnya telah dilatih pada 780 bilion token.

Selain itu, Google sebelum ini telah menyatakan bahawa PaLM 2 adalah lebih kecil daripada LLM sebelumnya, yang bermaksud ia boleh menjadi lebih cekap sambil menyelesaikan tugasan yang lebih kompleks. Ini juga telah disahkan dalam dokumen dalaman Saiz parameter latihan PaLM 2 ialah 340 bilion , yang jauh lebih kecil daripada 540 bilion PaLM.

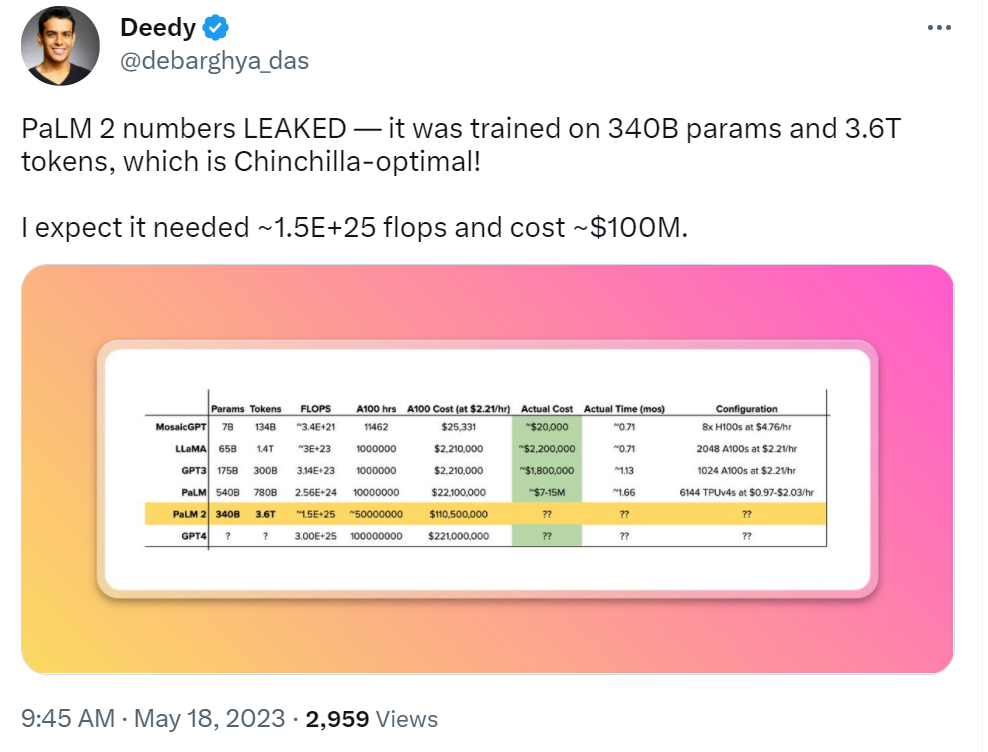

Bagaimanakah token latihan dan parameter PaLM 2 dibandingkan dengan LLM lain? Sebagai perbandingan, LLaMA, yang dikeluarkan oleh Meta pada bulan Februari, telah dilatih pada 1.4 trilion token. 175 bilion parameter OpenAI GPT-3 telah dilatih pada 300 bilion token.

Walaupun Google tidak sabar-sabar untuk menunjukkan kuasa teknologi AInya dan cara ia boleh dibenamkan dalam carian, e-mel, pemprosesan dokumen dan hamparan, ia juga enggan mendedahkan saiz data latihannya atau butiran lain. Malah, Google bukan satu-satunya yang melakukan ini, OpenAI juga senyap mengenai butiran model besar berbilang modal terbarunya GPT-4. Mereka semua berkata ketidakdedahan butiran berpunca daripada sifat kompetitif perniagaan.

Walau bagaimanapun, apabila perlumbaan senjata AI terus memanas, komuniti penyelidik semakin menuntut lebih ketelusan. Dan dalam dokumen dalaman Google yang dibocorkan beberapa waktu lalu, penyelidik dalaman Google menyatakan pandangan ini: Walaupun pada permukaan nampaknya OpenAI dan Google mengejar antara satu sama lain pada model AI yang besar, pemenang sebenar mungkin tidak semestinya datang dari kedua-duanya rumah, kerana kuasa pihak ketiga "sumber terbuka" secara senyap-senyap meningkat.

Pada masa ini, ketulenan dokumen dalaman ini belum disahkan dan Google belum mengulas mengenai kandungan yang berkaitan.

Komen netizen

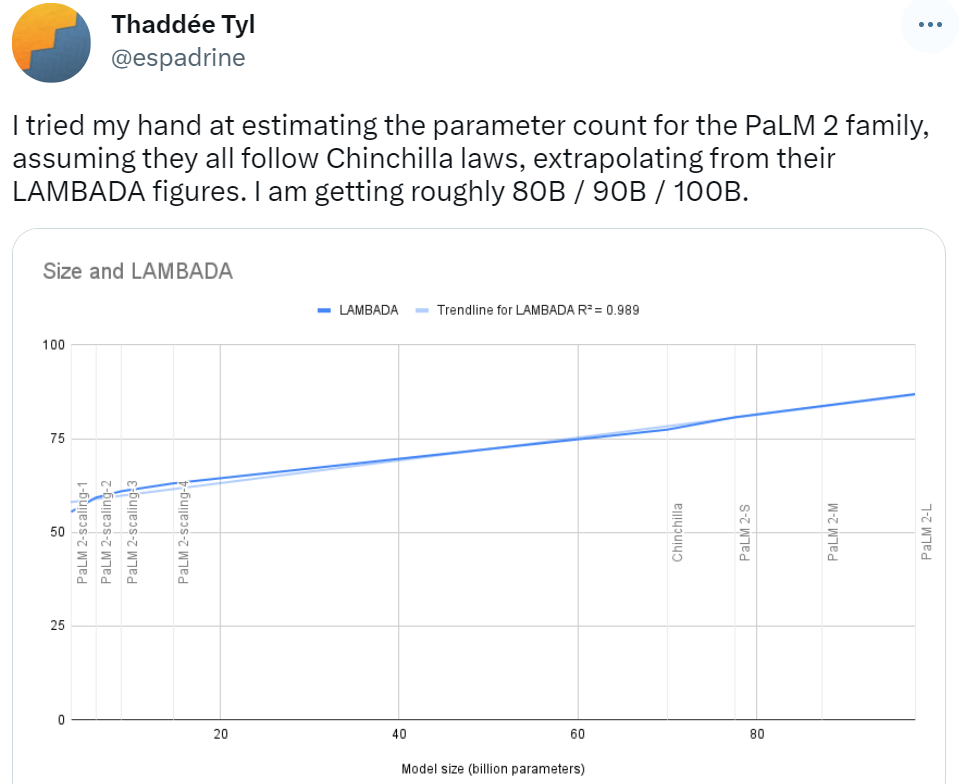

Pada awal pengumuman rasmi PaLM 2, beberapa netizen meramalkan bilangan parameter berdasarkan undang-undang Chinchilla, dan ta meramalkan bahawa keputusan parameter daripada keluarga model PaLM 2 ialah 80B / 90B / 100B, yang masih sangat berbeza daripada 340B yang dilaporkan kali ini.

Sesetengah orang telah membuat gelombang ramalan tentang kos latihan PaLM 2. Berdasarkan pembangunan model besar pada masa lalu, netizen ini berkata bahawa ia akan menelan belanja AS$100 juta untuk membina PaLM 2.

Parameter PaLM 2 telah bocor, anda boleh cuba teka Bard, netizen ini berkata:

Dengan kebocoran bilangan token PaLM 2, netizen tidak dapat mengelak daripada tertanya-tanya, berapa banyak token yang diperlukan untuk titik perubahan besar sebelum ketibaan AGI?

Atas ialah kandungan terperinci Dengan 3.6 trilion token dan 340 bilion parameter, butiran model besar Google PaLM 2 telah didedahkan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI