Rumah >Peranti teknologi >AI >Cara mudah dan objektif untuk memperkenalkan model besar untuk mengelakkan tafsiran yang berlebihan

Cara mudah dan objektif untuk memperkenalkan model besar untuk mengelakkan tafsiran yang berlebihan

- 王林ke hadapan

- 2023-05-12 18:13:061224semak imbas

1. Kata Pengantar

Artikel ini bertujuan untuk memberikan pembaca tanpa latar belakang sains komputer dengan beberapa maklumat tentang ChatGPT dan sistem kecerdasan buatannya yang serupa (seperti GPT-3, GPT-4, Bing Chat, Bard, dsb. . ) prinsip bagaimana ia berfungsi. ChatGPT ialah chatbot yang dibina pada model bahasa yang besar untuk interaksi perbualan. Istilah ini boleh menjadi kabur, jadi saya akan menerangkannya. Pada masa yang sama, kami akan membincangkan konsep teras di belakangnya, dan artikel ini tidak memerlukan pembaca mempunyai pengetahuan latar belakang teknikal atau matematik. Kami akan menggunakan banyak metafora untuk menerangkan konsep yang berkaitan untuk memahaminya dengan lebih baik. Kami juga akan membincangkan implikasi teknik ini dan perkara yang patut atau tidak boleh kami jangkakan untuk dapat dilakukan dengan model bahasa yang besar seperti ChatGPT.

Seterusnya kita akan mulakan dengan asas "Apakah itu kecerdasan buatan" dengan cara yang tidak menggunakan jargon profesional sebanyak mungkin, dan secara beransur-ansur membincangkan secara mendalam istilah dan konsep yang berkaitan dengan model bahasa besar dan ChatGPT, dan akan menggunakan metafora untuk menerangkannya. Pada masa yang sama, kita juga akan bercakap tentang maksud teknologi ini dan perkara yang kita patut atau tidak harapkan boleh lakukan.

2. Apakah Kepintaran Buatan

Pertama, mari mulakan dengan beberapa istilah asas yang mungkin anda sering dengar. Jadi apakah kecerdasan buatan?

Kecerdasan buatan: merujuk kepada entiti yang boleh mempamerkan tingkah laku yang serupa dengan perkara yang dianggap oleh manusia sebagai pintar. Terdapat beberapa masalah dengan menggunakan "kepintaran" untuk mentakrifkan kecerdasan buatan, kerana "kepintaran" itu sendiri tidak mempunyai definisi yang jelas. Walau bagaimanapun, definisi ini masih sesuai. Ia pada asasnya bermaksud bahawa jika kita melihat sesuatu buatan manusia yang melakukan tingkah laku yang menarik, berguna dan kelihatan sukar, maka kita mungkin mengatakan bahawa ia adalah bijak. Sebagai contoh, dalam permainan komputer, kita sering merujuk kepada aksara kawalan komputer sebagai "AI". Kebanyakan peranan ini ialah atur cara mudah berdasarkan kod if-then-else (cth., "Jika pemain berada dalam julat, tembak, jika tidak, pindah ke batu terdekat dan sembunyi"). Tetapi jika watak-watak itu boleh membuatkan kita terlibat dan terhibur sambil tidak melakukan sesuatu yang benar-benar bodoh, maka kita mungkin fikir ia lebih kompleks daripada yang sebenarnya.

Apabila kita memahami cara sesuatu berfungsi, kita mungkin tidak menganggapnya sebagai ajaib, tetapi mengharapkan sesuatu yang lebih kompleks di sebalik tabir. Semuanya bergantung pada sejauh mana kita tahu apa yang berlaku di sebalik tabir.

Perkara penting ialah kecerdasan buatan bukanlah sihir. Kerana ia bukan sihir, ia boleh dijelaskan.

3. Apakah itu pembelajaran mesin

Istilah lain yang sering dikaitkan dengan kecerdasan buatan ialah pembelajaran mesin.

Pembelajaran mesin: Kaedah mencipta gelagat dengan mengumpul data, membentuk model dan kemudian melaksanakan model. Kadangkala sukar untuk mencipta sekumpulan pernyataan if-then-else secara manual untuk menangkap beberapa fenomena kompleks (seperti bahasa). Dalam kes ini, kami cuba mencari sejumlah besar data dan memodelkannya menggunakan algoritma yang boleh mencari corak dalam data.

Jadi apakah model? Model ialah versi ringkas daripada fenomena kompleks. Sebagai contoh, model kereta ialah versi kereta sebenar yang lebih kecil dan ringkas yang berkongsi banyak sifat kereta sebenar, tetapi sudah tentu tidak bertujuan untuk menggantikan sepenuhnya versi asal. Model kereta mungkin kelihatan realistik dan berguna semasa bereksperimen.

Sama seperti kita boleh membuat kereta yang lebih kecil dan ringkas, kita juga boleh membuat model bahasa manusia yang lebih kecil dan ringkas. Kami menggunakan istilah "model bahasa besar" kerana model ini sangat besar dari perspektif jumlah memori (memori video) yang perlu mereka gunakan. Model terbesar yang sedang dalam pengeluaran, seperti ChatGPT, GPT-3 dan GPT-4, adalah sangat besar sehingga memerlukan superkomputer yang dijalankan pada pelayan pusat data untuk mencipta dan menjalankan.

4. Apakah itu rangkaian saraf?

Terdapat banyak cara untuk mempelajari model melalui data, dan rangkaian saraf adalah salah satu daripadanya. Teknologi ini secara longgar berdasarkan struktur otak manusia, yang terdiri daripada satu siri neuron yang saling berkaitan yang menghantar isyarat elektrik di antara mereka, membolehkan kita menyelesaikan pelbagai tugas. Konsep asas rangkaian saraf dicipta pada tahun 1940-an, dan konsep asas bagaimana untuk melatih rangkaian saraf telah dicipta pada tahun 1980-an, rangkaian saraf sangat tidak cekap Mereka boleh digunakan secara besar-besaran.

Walau bagaimanapun, saya secara peribadi lebih suka menggunakan metafora litar untuk mensimulasikan rangkaian saraf. Melalui rintangan, aliran arus melalui wayar, kita boleh mensimulasikan kerja rangkaian saraf.

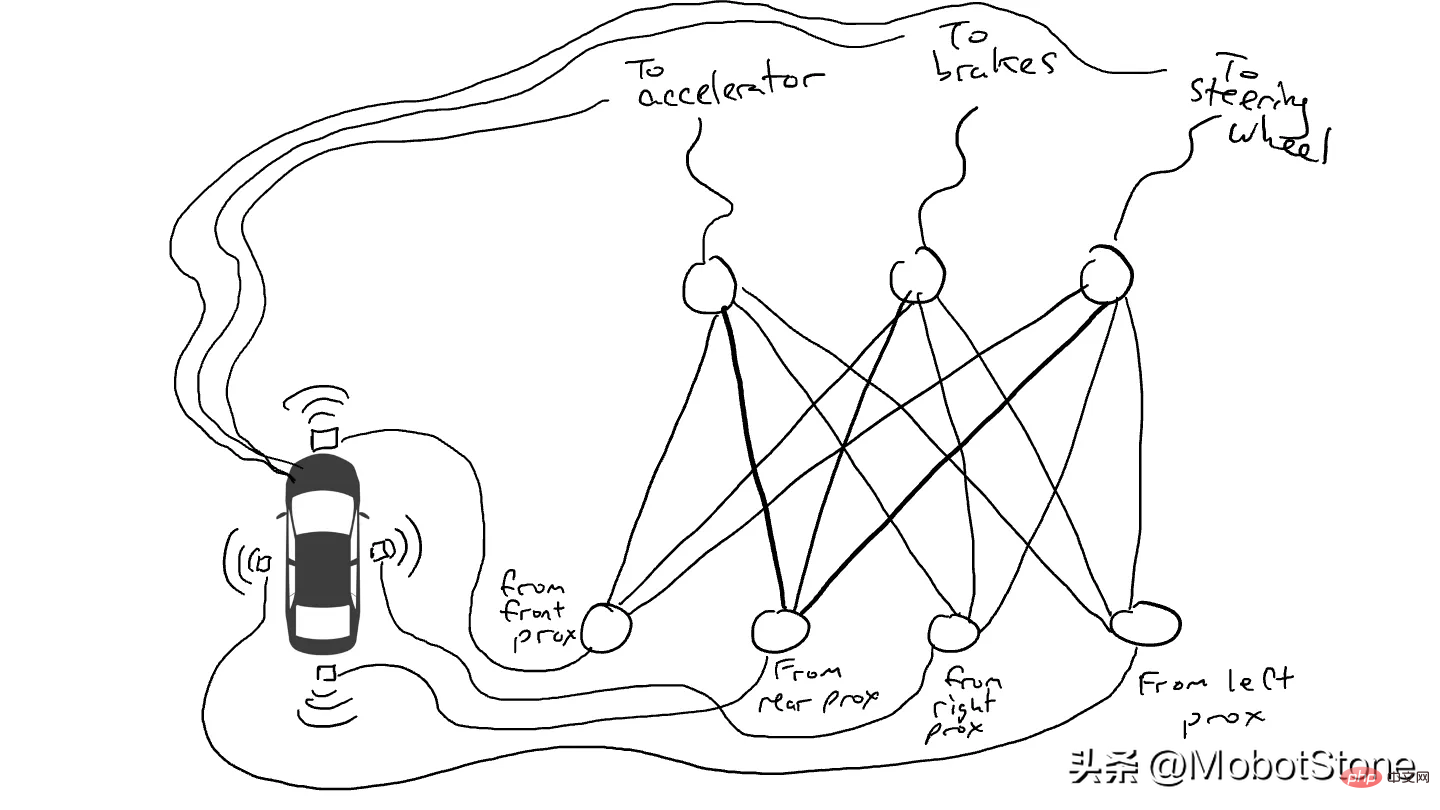

Bayangkan kita nak buat kereta pandu sendiri yang boleh memandu di lebuh raya. Kami memasang penderia jarak pada bahagian hadapan, belakang dan sisi kereta. Penderia jarak melaporkan nilai 1 apabila objek menghampiri dan nilai 0 apabila tiada objek yang boleh dikesan berdekatan.

Kami juga memasang robot untuk mengendalikan stereng, brek dan memecut. Apabila pendikit menerima nilai 1, ia menggunakan pecutan maksimum, manakala nilai 0 bermakna tiada pecutan. Begitu juga, nilai 1 yang dihantar ke mekanisme brek bermakna brek kecemasan, manakala 0 bermakna tiada brek. Mekanisme stereng menerima nilai antara -1 dan +1, dengan nombor negatif menunjukkan belok kiri, nombor positif menunjukkan belok kanan dan 0 menunjukkan garis lurus.

Sudah tentu kita perlu merekod data pemanduan. Apabila laluan di hadapan jelas, anda mempercepatkan. Apabila ada kereta di hadapan anda, anda perlahan. Apabila kereta datang terlalu dekat dari kiri, anda melencong ke kanan dan menukar lorong, dengan andaian sudah tentu tiada kereta di sebelah kanan. Proses ini sangat kompleks dan memerlukan operasi yang berbeza (belok kiri atau kanan, pecutan atau nyahpecutan, brek) berdasarkan gabungan maklumat sensor yang berbeza, jadi setiap sensor perlu disambungkan kepada setiap mekanisme robot.

Apa yang berlaku apabila anda memandu di jalan raya? Arus elektrik mengalir dari semua penderia ke semua penggerak robot, dan kenderaan membelok ke kiri, kanan, memecut dan brek serentak. Ia akan menimbulkan kekacauan.

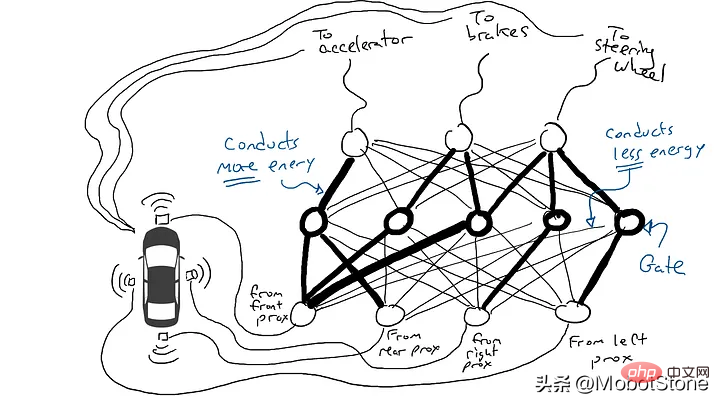

Keluarkan perintang dan mula letakkannya di bahagian litar yang berlainan supaya arus boleh mengalir dengan lebih bebas antara penderia tertentu dan lengan robotik tertentu. Sebagai contoh, kami ingin arus mengalir lebih bebas dari sensor jarak hadapan ke brek dan bukannya mekanisme stereng. Kami juga memasang elemen yang dipanggil pagar yang sama ada akan menghentikan arus daripada mengalir sehingga cas yang mencukupi telah terkumpul untuk mencetuskan suis (hanya membenarkan arus mengalir apabila kedua-dua penderia jarak hadapan dan belakang melaporkan bilangan yang tinggi), atau hanya membenarkan arus mengalir apabila kuasa input Menghantar kuasa ke hadapan apabila keamatan rendah (menghantar lebih banyak kuasa kepada pemecut apabila sensor jarak ke hadapan melaporkan nilai yang rendah).

Tetapi di manakah kita harus meletakkan perintang dan pagar ini? saya pun tak tahu. Letakkannya secara rawak di pelbagai lokasi. Kemudian cuba lagi. Mungkin kereta memandu dengan lebih baik kali ini, yang bermaksud ia kadang-kadang brek dan mengemudi apabila data mengatakan yang terbaik untuk brek dan memandu, dll., tetapi ia tidak betul setiap kali. Dan terdapat beberapa perkara yang lebih teruk (ia memecut apabila data mencadangkan ia kadang-kadang perlu brek). Jadi kami terus mencuba secara rawak kombinasi perintang dan pintu yang berbeza. Akhirnya, kami akan terjumpa kombinasi yang cukup bagus, dan kami akan mengisytiharkan kejayaan. Sebagai contoh, gabungan ini:

(Sebenarnya, kami tidak akan menambah atau mengalih keluar pintu, tetapi kami akan mengubah suainya supaya ia boleh diaktifkan dari bawah dengan tenaga yang lebih rendah, Sama ada lebih banyak tenaga perlu keluar dari bawah, atau banyak tenaga dikeluarkan hanya apabila terdapat sangat sedikit tenaga di bawah pembelajaran mesin mungkin berasa tidak selesa dengan penerangan ini, ini dilakukan dengan berat sebelah pintu pagar, ini biasanya tidak ditunjukkan dalam rajah sedemikian, tetapi dari perspektif metafora litar ia boleh dianggap sebagai kabel yang dipalamkan terus ke bekalan kuasa dan boleh bertindak seperti semua wayar lain Ubah suai ia seperti kabel)

Tak baik mencuba secara rawak. Algoritma yang dipanggil backpropagation membuat tekaan yang cukup baik untuk menukar konfigurasi litar. Butiran algoritma tidak penting, cuma ketahui bahawa ia memperhalusi litar untuk menjadikannya lebih dekat dengan apa yang dicadangkan oleh data, dan selepas beribu-ribu penalaan halus, anda akhirnya boleh mendapatkan hasil yang sepadan dengan data.

Kami memanggil parameter perintang dan get kerana ia sebenarnya ada di mana-mana, dan apa yang dilakukan oleh algoritma perambatan belakang ialah mengisytiharkan setiap perintang menjadi lebih kuat atau lebih lemah. Oleh itu, jika kita mengetahui susun atur dan nilai parameter litar, keseluruhan litar boleh direplikasi pada kereta lain.

Atas ialah kandungan terperinci Cara mudah dan objektif untuk memperkenalkan model besar untuk mengelakkan tafsiran yang berlebihan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI