Peranti teknologi

Peranti teknologi AI

AI Penyelidikan terkini, GPT-4 mendedahkan kekurangan! Tidak dapat memahami kekaburan bahasa!

Penyelidikan terkini, GPT-4 mendedahkan kekurangan! Tidak dapat memahami kekaburan bahasa!Penyelidikan terkini, GPT-4 mendedahkan kekurangan! Tidak dapat memahami kekaburan bahasa!

Inferens Bahasa Asli (NLI) ialah tugas penting dalam pemprosesan bahasa semula jadi Matlamatnya adalah untuk menentukan sama ada hipotesis boleh disimpulkan daripada premis berdasarkan premis dan andaian yang diberikan. Walau bagaimanapun, oleh kerana kekaburan adalah ciri intrinsik bahasa semula jadi, menangani kekaburan juga merupakan bahagian penting dalam pemahaman bahasa manusia. Oleh kerana kepelbagaian ungkapan bahasa manusia, pemprosesan kekaburan telah menjadi salah satu kesukaran dalam menyelesaikan masalah penaakulan bahasa semula jadi. Pada masa ini, pelbagai algoritma pemprosesan bahasa semula jadi digunakan dalam senario seperti sistem soal jawab, pengecaman pertuturan, terjemahan pintar dan penjanaan bahasa semula jadi, tetapi walaupun dengan teknologi ini, menyelesaikan kekaburan sepenuhnya masih merupakan tugas yang sangat mencabar.

Untuk tugasan NLI, model pemprosesan bahasa semula jadi yang besar seperti GPT-4 menghadapi cabaran. Satu masalah ialah kekaburan bahasa menyukarkan model untuk memahami maksud sebenar ayat dengan tepat. Di samping itu, disebabkan oleh fleksibiliti dan kepelbagaian bahasa semula jadi, pelbagai hubungan mungkin wujud antara teks yang berbeza, yang menjadikan set data dalam tugas NLI sangat kompleks. Ia juga mempengaruhi kesejagatan dan kepelbagaian model pemprosesan bahasa semula jadi cabaran yang ketara. Oleh itu, dalam menangani bahasa yang samar-samar, adalah penting jika model besar berjaya pada masa hadapan, dan model besar telah digunakan secara meluas dalam bidang seperti antara muka perbualan dan alat bantu menulis. Menangani kekaburan akan membantu menyesuaikan diri dengan konteks yang berbeza, meningkatkan kejelasan komunikasi dan keupayaan untuk mengenal pasti ucapan yang mengelirukan atau memperdaya.

Tajuk kertas kerja ini membincangkan kekaburan dalam model besar menggunakan kata kata, "Kami Takut...", yang bukan sahaja menyatakan kebimbangan semasa tentang kesukaran model bahasa dalam memodelkan kekaburan dengan tepat, tetapi juga petunjuk di kertas Struktur bahasa yang diterangkan. Artikel ini juga menunjukkan bahawa orang ramai bekerja keras untuk membangunkan penanda aras baharu untuk benar-benar mencabar model besar baharu yang berkuasa untuk memahami dan menjana bahasa semula jadi dengan lebih tepat serta mencapai kejayaan baharu dalam model.

Tajuk kertas: We're Afraid Language Models Aren't Modelling Ambiguity

Pautan kertas: https://arxiv.org/abs/2304.14399

Kod dan alamat data : https://github.com/alisawuffles/ambient

Pengarang artikel ini merancang untuk mengkaji sama ada model besar yang telah dilatih mempunyai keupayaan untuk mengenali dan membezakan ayat dengan pelbagai tafsiran yang mungkin, dan menilai bagaimana model membezakan bacaan dan tafsiran yang berbeza. Walau bagaimanapun, data penanda aras sedia ada biasanya tidak mengandungi contoh yang samar-samar, jadi seseorang itu perlu membina percubaan sendiri untuk meneroka isu ini.

Skim anotasi tiga hala NLI tradisional merujuk kepada kaedah anotasi yang digunakan untuk tugasan inferens bahasa semula jadi (NLI). antara. Tiga label biasanya "entailment", "neutral" dan "contradiction".

Pengarang menggunakan format tugasan NLI untuk menjalankan eksperimen, menggunakan pendekatan berfungsi untuk mencirikan kekaburan melalui kesan kekaburan dalam premis atau andaian ke atas hubungan implikasi. Pengarang mencadangkan penanda aras yang dipanggil AMBIENT (Ambiguity in Entailment) yang merangkumi pelbagai kekaburan leksikal, sintaksis dan pragmatik, dan secara lebih meluas meliputi ayat yang mungkin menyampaikan pelbagai mesej yang berbeza.

Seperti yang ditunjukkan dalam Rajah 1, kekaburan boleh menjadi salah faham tidak sedarkan diri (atas Rajah 1) atau ia boleh digunakan secara sengaja untuk mengelirukan penonton (bawah Rajah 1). Sebagai contoh, jika kucing tersesat selepas meninggalkan rumah, maka ia sesat dalam erti kata bahawa ia tidak dapat mencari jalan pulang (tepi implikasi jika ia tidak pulang ke rumah selama beberapa hari, maka ia hilang dalam erti kata yang lain). tidak dapat menjumpainya dalam erti kata, ia juga hilang (sisi neutral).

▲Rajah 1 Contoh kekaburan dijelaskan oleh Cat Lost

Pengenalan dataset AMBIENT

Contoh terpilih

Pengarang menyediakan 1645 contoh ayat yang merangkumi pelbagai jenis kekaburan, termasuk sampel tulisan tangan dan daripada set data NLI dan buku teks linguistik sedia ada. Setiap contoh dalam AMBIENT mengandungi set label yang sepadan dengan pelbagai kemungkinan pemahaman, dan nyahkekaburan penulisan semula untuk setiap pemahaman, seperti yang ditunjukkan dalam Jadual 1.

▲Jadual 1 Pasangan Premis dan Andaian dalam Contoh Terpilih

Contoh Dijana

Para penyelidik juga menggunakan pendekatan penjanaan dan penapisan berlebihan untuk membina korpus besar contoh NLI tidak berlabel untuk lebih komprehensif merangkumi situasi kekaburan yang berbeza. Diilhamkan oleh kerja terdahulu, mereka secara automatik mengenal pasti pasangan andaian yang berkongsi corak penaakulan dan meningkatkan kualiti korpus dengan menggalakkan penciptaan contoh baharu dengan corak yang sama.

Anotasi dan Pengesahan

Anotasi dan anotasi diperlukan untuk contoh yang diperoleh dalam langkah sebelumnya. Proses ini melibatkan anotasi oleh dua pakar, pengesahan dan ringkasan oleh seorang pakar, dan pengesahan oleh beberapa pengarang. Sementara itu, 37 pelajar linguistik memilih set label untuk setiap contoh dan menyediakan penulisan semula nyahkekaburan. Semua contoh beranotasi ini telah ditapis dan disahkan, menghasilkan 1503 contoh akhir.

Proses khusus ditunjukkan dalam Rajah 2: Mula-mula, gunakan InstructGPT untuk mencipta contoh tidak berlabel, dan kemudian jelaskan secara bebas oleh dua ahli bahasa. Akhirnya, melalui penyepaduan oleh seorang pengarang, anotasi dan anotasi akhir diperolehi.

▲ Rajah 2 Proses anotasi contoh yang dihasilkan dalam AMBIENT

Selain itu, isu ketekalan hasil anotasi antara anotasi yang berbeza turut dibincangkan di sini, sebagai serta AMBIENT Jenis kekaburan yang terdapat dalam set data. Penulis secara rawak memilih 100 sampel dalam set data ini sebagai set pembangunan, dan sampel selebihnya digunakan sebagai set ujian Rajah 3 menunjukkan taburan label set, dan setiap sampel mempunyai label hubungan inferens yang sepadan. Penyelidikan menunjukkan bahawa dalam kes kekaburan, hasil anotasi berbilang anotasi adalah konsisten dan menggunakan hasil gabungan berbilang anotasi boleh meningkatkan ketepatan anotasi.

▲ Rajah 3 Taburan label set dalam AMBIENT

Adakah kekaburan menggambarkan "tidak bersetuju"?

Kajian ini menganalisis gelagat pencatat apabila menganotasi input samar-samar di bawah skema anotasi tiga hala NLI tradisional. Kajian itu mendapati bahawa anotasi boleh menyedari tentang kekaburan dan kekaburan itu adalah punca utama perbezaan pelabelan, sekali gus mencabar andaian popular bahawa "percanggahan pendapat" adalah punca ketidakpastian dalam contoh simulasi.

Dalam kajian, set data AMBIENT telah digunakan dan 9 pekerja penyumberan ramai telah diupah untuk menganotasi setiap contoh yang tidak jelas.

Tugas dibahagikan kepada tiga langkah:

- Beri anotasi contoh samar-samar

- Kenal pasti tafsiran yang mungkin berbeza

- Anotasi contoh yang tidak jelas

Antaranya, dalam langkah 2, tiga penjelasan yang mungkin termasuk dua makna yang mungkin dan ayat yang serupa tetapi tidak serupa. Akhir sekali, bagi setiap penjelasan yang mungkin, ia digantikan ke dalam contoh asal untuk mendapatkan tiga contoh NLI baharu, dan anotasi diminta untuk memilih label masing-masing.

Hasil eksperimen ini menyokong hipotesis: di bawah sistem pelabelan tunggal, contoh kabur asal akan menghasilkan keputusan yang sangat tidak konsisten, iaitu, dalam proses pelabelan ayat, orang cenderung untuk menghasilkan ayat yang tidak jelas penghakiman membawa kepada keputusan yang tidak konsisten. Walau bagaimanapun, apabila langkah nyahkekaburan ditambahkan pada tugasan, penganotasi secara amnya dapat mengenal pasti dan mengesahkan berbilang kemungkinan untuk ayat, dan ketidakkonsistenan dalam keputusan sebahagian besarnya telah diselesaikan. Oleh itu, nyahkekaburan ialah cara yang berkesan untuk mengurangkan kesan subjektiviti anotasi ke atas keputusan.

Nilai prestasi pada model besar

S1 Bolehkah kandungan yang berkaitan dengan nyahkekaburan dijana secara langsung

Fokus bahagian ini adalah untuk menguji model bahasa untuk menjana nyahkekaburan secara langsung? dalam konteks dan keupayaan pembelajaran label yang sepadan. Untuk tujuan ini, penulis membina isyarat semula jadi dan mengesahkan prestasi model menggunakan penilaian automatik dan manual, seperti yang ditunjukkan dalam Jadual 2.

▲Jadual 2 Templat beberapa pukulan untuk menjana tugas nyahkekaburan apabila premis tidak jelas

Dalam ujian, setiap contoh mempunyai 4 contoh ujian lain yang berfungsi sebagai konteks , dan markah serta ketepatan dikira menggunakan metrik EDIT-F1 dan penilaian manusia. Keputusan eksperimen yang ditunjukkan dalam Jadual 3 menunjukkan bahawa GPT-4 menunjukkan prestasi terbaik dalam ujian, mencapai skor EDIT-F1 sebanyak 18.0% dan ketepatan penilaian manusia sebanyak 32.0%. Di samping itu, telah diperhatikan bahawa model besar sering menggunakan strategi menambah konteks tambahan semasa nyahkekaburan untuk mengesahkan atau menafikan hipotesis secara langsung. Walau bagaimanapun, adalah penting untuk ambil perhatian bahawa penilaian manusia mungkin melebihkan keupayaan model untuk melaporkan sumber kekaburan dengan tepat.

▲Jadual 3 Prestasi model besar pada AMBIENT

S2. Bolehkah kesahihan penjelasan yang munasabah dikenal pasti

Bahagian ini terutamanya mengkaji prestasi model besar dalam mengenal pasti ayat yang tidak jelas. Dengan mencipta satu siri templat pernyataan benar dan salah dan ujian sifar tembakan model, para penyelidik menilai sejauh mana prestasi model besar dalam memilih ramalan antara benar dan palsu. Keputusan eksperimen menunjukkan bahawa model terbaik ialah GPT-4, namun, apabila kekaburan diambil kira, GPT-4 berprestasi lebih teruk daripada meneka rawak dalam menjawab tafsiran samar-samar bagi keempat-empat templat. Selain itu, model besar mempunyai masalah ketekalan dari segi soalan Untuk pasangan tafsiran yang berbeza bagi ayat samar yang sama, model tersebut mungkin mempunyai percanggahan dalaman.

Penemuan ini mencadangkan bahawa kita perlu mengkaji lebih lanjut cara meningkatkan pemahaman ayat samar oleh model besar dan menilai prestasi model besar dengan lebih baik.

S3. Simulasikan penjanaan berterusan terbuka melalui tafsiran yang berbeza

Bahagian ini terutamanya mengkaji keupayaan pemahaman kekaburan berdasarkan model bahasa. Model bahasa diuji berdasarkan konteks dan membandingkan ramalan mereka tentang kesinambungan teks di bawah tafsiran yang mungkin berbeza. Untuk mengukur keupayaan model untuk mengendalikan kekaburan, penyelidik menggunakan perbezaan KL untuk mengukur "kejutan" model dengan membandingkan kebarangkalian dan perbezaan jangkaan yang dihasilkan oleh model di bawah kekaburan tertentu dan konteks betul yang diberikan dalam konteks yang sepadan. , dan memperkenalkan "ayat gangguan" yang menggantikan kata nama secara rawak untuk menguji lagi keupayaan model.

Hasil eksperimen menunjukkan bahawa FLAN-T5 mempunyai ketepatan yang paling tinggi, tetapi hasil prestasi set ujian yang berbeza (LS melibatkan penggantian sinonim, PC melibatkan pembetulan ralat ejaan dan SSD melibatkan pembetulan struktur tatabahasa) dan model yang berbeza adalah tidak konsisten, menunjukkan bahawa Kekaburan kekal sebagai cabaran yang serius untuk model.

Percubaan model NLI berbilang label

Seperti yang ditunjukkan dalam Jadual 4, masih terdapat banyak ruang untuk penambahbaikan dalam memperhalusi model NLI pada data sedia ada dengan perubahan label, terutamanya dalam berbilang label tugasan NLI.

▲Jadual 4 Prestasi model NLI berbilang label pada AMBIENT

Mengesan ucapan politik yang mengelirukan

Eksperimen ini mengkaji Cara pemahaman yang berbeza ucapan politik menunjukkan bahawa model yang sensitif terhadap cara pemahaman yang berbeza boleh dieksploitasi dengan berkesan. Hasil kajian ditunjukkan dalam Jadual 5. Bagi ayat yang samar-samar, beberapa tafsiran penjelasan secara semula jadi boleh menghapuskan kekaburan, kerana tafsiran ini hanya dapat mengekalkan kekaburan atau dengan jelas menyatakan maksud tertentu.

▲ Jadual 5 Kaedah pengesanan artikel ini menandakan ucapan politik sebagai samar-samar

Selain itu, tafsiran ramalan ini boleh mendedahkan punca kekaburan. Dengan menganalisis lebih lanjut hasil positif palsu, penulis juga mendapati banyak kekaburan yang tidak disebut dalam semakan fakta, menggambarkan potensi besar alat ini dalam mencegah salah faham.

Ringkasan

Seperti yang dinyatakan dalam artikel ini, kekaburan bahasa semula jadi akan menjadi cabaran utama dalam pengoptimuman model. Kami menjangkakan bahawa dalam pembangunan teknologi masa hadapan, model pemahaman bahasa semula jadi akan dapat mengenal pasti konteks dan perkara utama dalam teks dengan lebih tepat, dan menunjukkan kepekaan yang lebih tinggi apabila berurusan dengan teks yang samar-samar. Walaupun kami telah menetapkan penanda aras untuk menilai model pemprosesan bahasa semula jadi untuk mengenal pasti kekaburan dan dapat memahami dengan lebih baik batasan model dalam domain ini, ini tetap menjadi tugas yang sangat mencabar.

Xi Xiaoyao Technology Talk Original

Pengarang | IQ jatuh di mana-mana, Python

Atas ialah kandungan terperinci Penyelidikan terkini, GPT-4 mendedahkan kekurangan! Tidak dapat memahami kekaburan bahasa!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Mengubah Pelaporan Kewangan dengan AI dan NLG - Analytics VidhyaApr 15, 2025 am 10:35 AM

Mengubah Pelaporan Kewangan dengan AI dan NLG - Analytics VidhyaApr 15, 2025 am 10:35 AMPelaporan Kewangan berkuasa AI: merevolusikan pandangan melalui generasi bahasa semula jadi Dalam persekitaran perniagaan dinamik hari ini, analisis kewangan yang tepat dan tepat pada masanya adalah penting untuk membuat keputusan strategik. Pelaporan kewangan tradisional

Adakah robot Google Deepmind ini akan bermain di Sukan Olimpik 2028?Apr 15, 2025 am 10:16 AM

Adakah robot Google Deepmind ini akan bermain di Sukan Olimpik 2028?Apr 15, 2025 am 10:16 AMRobot Tenis Jadual Google Deepmind: Era Baru dalam Sukan dan Robotik Sukan Olimpik Paris 2024 mungkin berakhir, tetapi era baru dalam sukan dan robotik adalah berkemungkinan, terima kasih kepada Google Deepmind. Penyelidikan terobosan mereka ("Mencapai Kompet Tahap Manusia

Membina WebApp Wawasan Makanan dengan Model Gemini Flash 1.5Apr 15, 2025 am 10:15 AM

Membina WebApp Wawasan Makanan dengan Model Gemini Flash 1.5Apr 15, 2025 am 10:15 AMMembuka Kecekapan dan Skala dengan Gemini Flash 1.5: WebApp Wawasan Makanan Flask Dalam landskap AI yang pesat berkembang, kecekapan dan skalabiliti adalah yang paling utama. Pemaju semakin mencari model berprestasi tinggi yang meminimumkan kos dan latenc

Melaksanakan ejen AI menggunakan llamaindexApr 15, 2025 am 10:11 AM

Melaksanakan ejen AI menggunakan llamaindexApr 15, 2025 am 10:11 AMMemanfaatkan kuasa agen AI dengan llamaindex: panduan langkah demi langkah Bayangkan pembantu peribadi yang memahami permintaan anda dan melaksanakannya dengan sempurna, sama ada pengiraan cepat atau mengambil berita pasaran terkini. Artikel ini meneroka

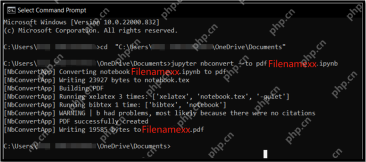

5 kaedah untuk menukar fail .ipynb ke pdf- analitik vidhyaApr 15, 2025 am 10:06 AM

5 kaedah untuk menukar fail .ipynb ke pdf- analitik vidhyaApr 15, 2025 am 10:06 AMFail Notebook Jupyter (.iPynb) digunakan secara meluas dalam analisis data, pengkomputeran saintifik, dan pengekodan interaktif. Walaupun buku nota ini bagus untuk membangun dan berkongsi kod dengan saintis data lain, kadang -kadang anda perlu mengubahnya menjadi format yang lebih umum, seperti PDF. Panduan ini akan membimbing anda melalui pelbagai cara untuk menukar fail .ipynb ke PDF, serta petua, amalan terbaik, dan cadangan penyelesaian masalah. Jadual Kandungan Mengapa menukar .ipynb ke pdf? Cara menukar fail .ipynb ke pdf Menggunakan UI Notebook Jupyter Menggunakan NBConve

Panduan Komprehensif mengenai Kes Kuantisasi dan Penggunaan LLMApr 15, 2025 am 10:02 AM

Panduan Komprehensif mengenai Kes Kuantisasi dan Penggunaan LLMApr 15, 2025 am 10:02 AMPengenalan Model bahasa yang besar (LLMs) merevolusi pemprosesan bahasa semulajadi, tetapi saiz besar dan tuntutan pengiraannya membatasi penggunaan. Kuantisasi, teknik untuk mengecilkan model dan kos pengiraan yang lebih rendah, adalah solu penting

Panduan komprehensif untuk selenium dengan pythonApr 15, 2025 am 09:57 AM

Panduan komprehensif untuk selenium dengan pythonApr 15, 2025 am 09:57 AMPengenalan Panduan ini meneroka gabungan kuat selenium dan python untuk automasi dan ujian web. Selenium mengautomasikan interaksi pelayar, meningkatkan kecekapan ujian untuk aplikasi web yang besar. Tutorial ini memberi tumpuan o

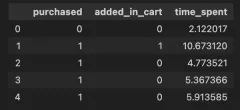

Panduan untuk Memahami Syarat InteraksiApr 15, 2025 am 09:56 AM

Panduan untuk Memahami Syarat InteraksiApr 15, 2025 am 09:56 AMPengenalan Istilah interaksi dimasukkan dalam pemodelan regresi untuk menangkap kesan dua atau lebih pembolehubah bebas dalam pemboleh ubah bergantung. Kadang -kadang, ia bukan hanya hubungan mudah antara kawalan

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

VSCode Windows 64-bit Muat Turun

Editor IDE percuma dan berkuasa yang dilancarkan oleh Microsoft

EditPlus versi Cina retak

Saiz kecil, penyerlahan sintaks, tidak menyokong fungsi gesaan kod

SublimeText3 Linux versi baharu

SublimeText3 Linux versi terkini

Dreamweaver CS6

Alat pembangunan web visual

DVWA

Damn Vulnerable Web App (DVWA) ialah aplikasi web PHP/MySQL yang sangat terdedah. Matlamat utamanya adalah untuk menjadi bantuan bagi profesional keselamatan untuk menguji kemahiran dan alatan mereka dalam persekitaran undang-undang, untuk membantu pembangun web lebih memahami proses mengamankan aplikasi web, dan untuk membantu guru/pelajar mengajar/belajar dalam persekitaran bilik darjah Aplikasi web keselamatan. Matlamat DVWA adalah untuk mempraktikkan beberapa kelemahan web yang paling biasa melalui antara muka yang mudah dan mudah, dengan pelbagai tahap kesukaran. Sila ambil perhatian bahawa perisian ini