Rumah >Peranti teknologi >AI >Pasukan You Yang memperoleh keputusan baharu dalam Anugerah Kertas Cemerlang AAI 2023, menggunakan satu V100 untuk melatih model 72 kali lebih pantas

Pasukan You Yang memperoleh keputusan baharu dalam Anugerah Kertas Cemerlang AAI 2023, menggunakan satu V100 untuk melatih model 72 kali lebih pantas

- 王林ke hadapan

- 2023-05-10 09:04:101112semak imbas

Artikel ini dicetak semula dengan kebenaran AI New Media Qubit (ID akaun awam: QbitAI Sila hubungi sumber untuk mencetak semula).

Tadi, UC Berkeley Ph.D. dan Profesor Muda Presiden Universiti Nasional Singapura mengeluarkan berita terkini -

memenangi AAI 2023Cemerlang Anugerah Kertas(Kertas Terbilang)!

Hasil penyelidikan meningkatkan kelajuan latihan model sebanyak 72 kali pada satu masa.

Malah netizen meluahkan perasaan selepas membaca kertas:

Dari 12 jam hingga 10 minit, lembu lembut (lembu kamu) ah!

Dr You Yang pernah mencipta rekod dunia untuk kelajuan latihan ImageNet dan BERT semasa pengajiannya.

Algoritma yang direka bentuknya juga digunakan secara meluas oleh gergasi teknologi seperti Google, Microsoft, Intel dan NVIDIA.

Kini, dia telah kembali ke China untuk memulakan perniagaan Teknologi Luchen Selepas setahun setengah, apakah jenis algoritma yang dia dan pasukannya buat untuk memenangi penghormatan sedemikian persidangan AI teratas?

Masa latihan adalah antara 12 jam hingga 10 minit

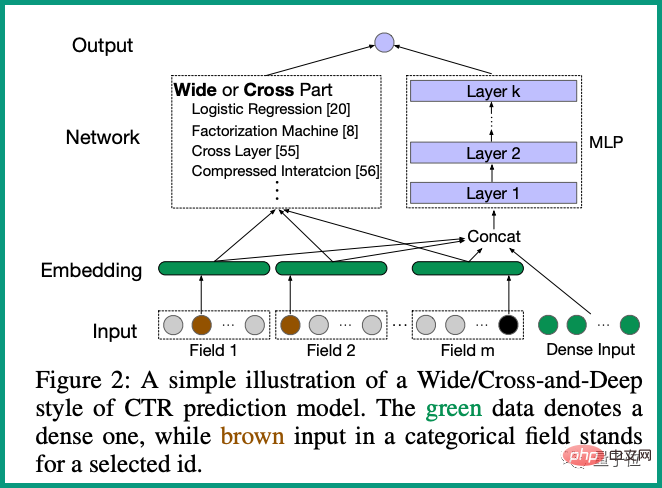

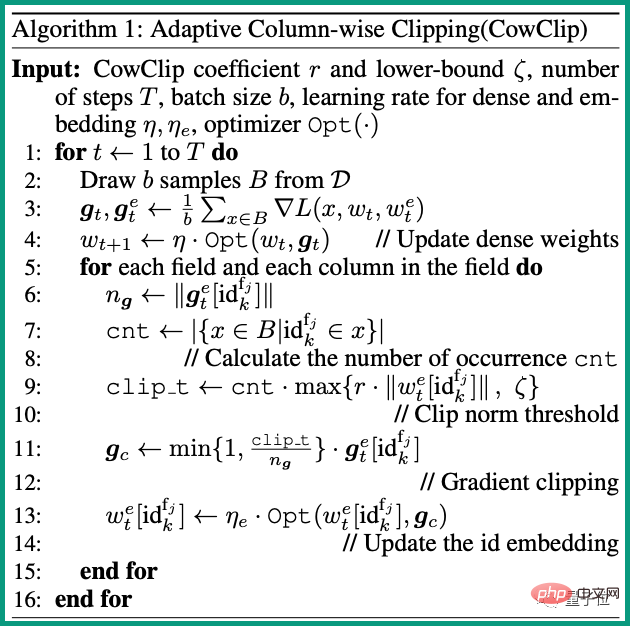

Dalam kajian ini, pasukan You Yang mencadangkan strategi pengoptimuman CowClip yang boleh mempercepatkan pembangunan Batch model ramalan CTR latihan.

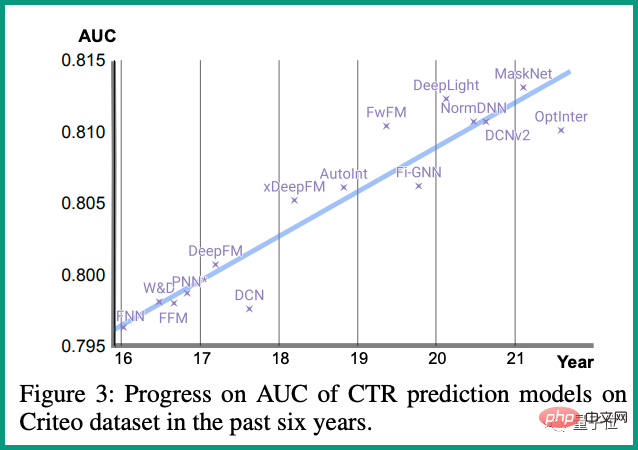

CTR(kadar klik lalu)Model ramalan ialah algoritma yang biasa digunakan dalam senario pengesyoran diperibadikan.

Ia biasanya perlu mempelajari maklum balas pengguna (klik, koleksi, pembelian, dll.) , dan jumlah data yang dijana dalam talian setiap hari adalah sangat besar.

Oleh itu, adalah penting untuk mempercepatkan latihan model ramalan CTR.

Secara amnya, untuk meningkatkan kelajuan latihan, latihan kelompok akan digunakan Namun, jika saiz kelompok terlalu besar, ketepatan model akan berkurangan.

Melalui analisis matematik, pasukan itu membuktikan bahawa kadar pembelajaran untuk ciri yang jarang berlaku tidak sepatutnya berskala apabila meningkatkan kelompok.

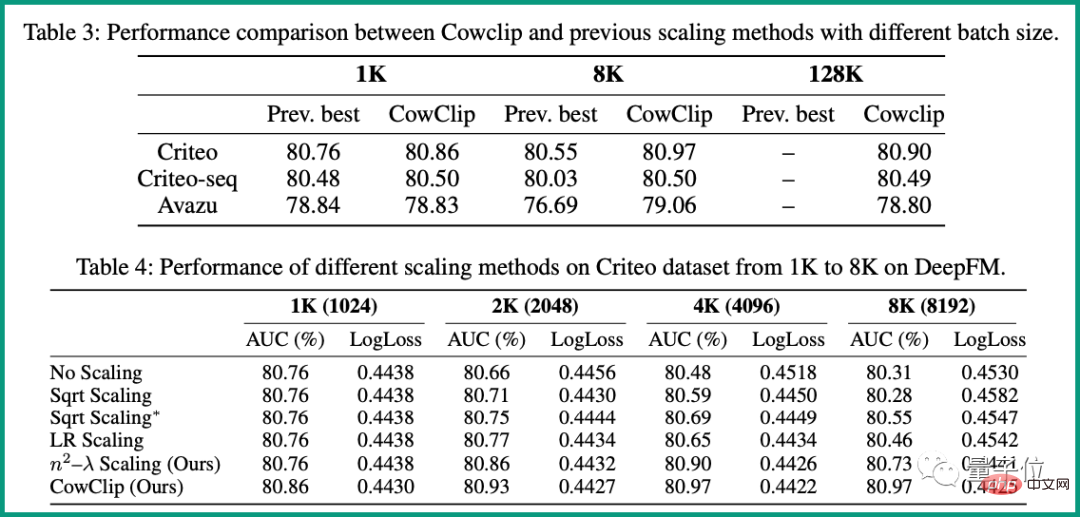

128 kali tanpa menyebabkan kehilangan ketepatan.

Terutama pada DeepFM, CowClip mencapai lebih daripada 0.1% peningkatan dalam AUC dengan mengembangkan saiz kelompok daripada 1K kepada 128K. Dan pada GPU V100 tunggal, masa latihan dipendekkan daripada 12 jam asal kepada hanya 10 minit dan kelajuan latihan ialah72 kali.

Zheng Zhengwei Beliau lulus dari Kelas Elit Komputer Universiti Nanjing dengan ijazah sarjana muda dan a Ph.D. dari Universiti Kebangsaan Singapura.

Minat penyelidikannya termasuk pembelajaran mesin, penglihatan komputer dan pengkomputeran berprestasi tinggi.Atas ialah kandungan terperinci Pasukan You Yang memperoleh keputusan baharu dalam Anugerah Kertas Cemerlang AAI 2023, menggunakan satu V100 untuk melatih model 72 kali lebih pantas. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI