Rumah >Peranti teknologi >AI >ChatGPT: Gabungan model berkuasa, mekanisme perhatian dan pembelajaran pengukuhan

ChatGPT: Gabungan model berkuasa, mekanisme perhatian dan pembelajaran pengukuhan

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-05-08 18:16:091320semak imbas

Artikel ini terutamanya memperkenalkan model pembelajaran mesin yang memperkasakan ChatGPT Ia akan bermula dengan pengenalan model bahasa berskala besar, menyelidiki mekanisme perhatian diri yang revolusioner yang membolehkan GPT-3 dilatih, dan kemudian menyelidiki peneguhan. belajar daripada maklum balas manusia ialah teknologi baharu yang menjadikan ChatGPT cemerlang.

Model Bahasa Besar

ChatGPT ialah sejenis model pemprosesan bahasa semula jadi pembelajaran mesin untuk inferens, dipanggil model bahasa besar (LLM). LLM mencerna sejumlah besar data teks dan membuat kesimpulan hubungan antara perkataan dalam teks. Sejak beberapa tahun kebelakangan ini, model ini terus berkembang seiring dengan kemajuan kuasa pengkomputeran. Apabila saiz set data input dan ruang parameter bertambah, keupayaan LLM juga meningkat.

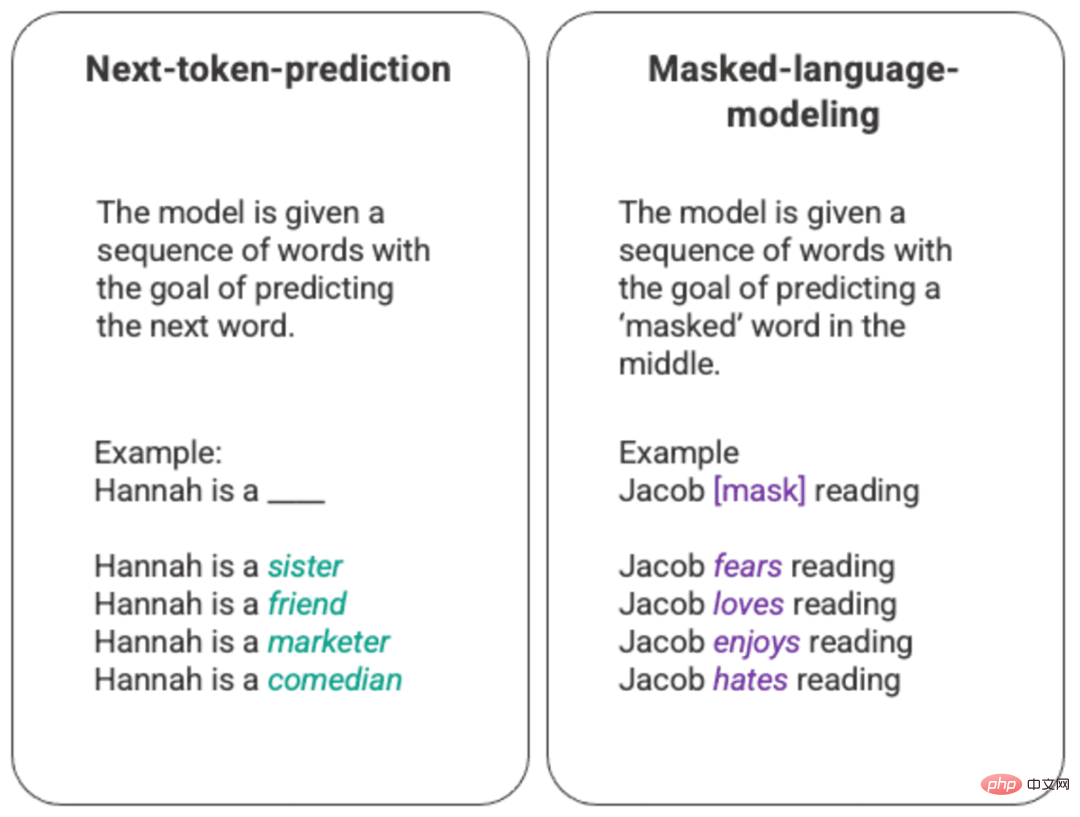

Latihan paling asas bagi model bahasa melibatkan meramalkan perkataan dalam urutan perkataan. Selalunya, ini diperhatikan untuk ramalan token seterusnya dan model bahasa penyamaran.

Contoh arbitrari ramalan token seterusnya yang dihasilkan dan model bahasa bertopeng

Dalam teknik pemeringkatan asas ini, biasanya melalui model long short memory (LSTM) ), yang mengisi kekosongan dengan perkataan yang berkemungkinan besar secara statistik memandangkan persekitaran dan konteks. Struktur pemodelan berjujukan ini mempunyai dua batasan utama.

- Model gagal memberi lebih berat kepada beberapa perkataan sekeliling daripada yang lain. Dalam contoh di atas, walaupun "membaca" mungkin paling kerap dikaitkan dengan "benci", dalam pangkalan data "Jacob" mungkin seorang pembaca yang gemar dan model harus menghargai "Jacob" lebih daripada "Jacob" Read" dan pilih "cinta" atas "kebencian".

- Data input diproses secara individu dan secara berurutan, bukannya secara keseluruhan korpus. Ini bermakna apabila melatih LSTM, tetingkap konteks ditetapkan dan hanya melangkaui satu input untuk beberapa langkah dalam jujukan. Ini mengehadkan kerumitan hubungan antara perkataan dan makna yang boleh dilukis.

Untuk menangani masalah ini, pada tahun 2017, pasukan di Google Brain memperkenalkan penukar. Tidak seperti LSTM, pengubah boleh memproses semua data input secara serentak. Dengan menggunakan mekanisme perhatian kendiri, model boleh menetapkan pemberat yang berbeza kepada bahagian data input yang berbeza berbanding mana-mana kedudukan dalam jujukan bahasa. Ciri ini membolehkan penambahbaikan berskala besar dalam menyuntik makna ke dalam LLM dan keupayaan untuk mengendalikan set data yang lebih besar.

GPT dan Perhatian Diri

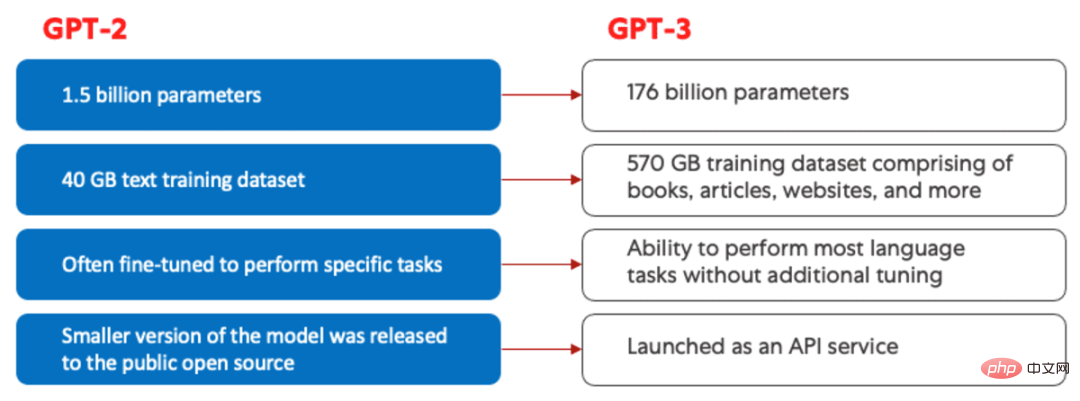

Model Generative Pretrained Transformer (GPT) pertama kali dilancarkan oleh OpenAI pada 2018 dan dinamakan GPT -1 . Model ini terus berkembang dalam GPT-2 pada 2019, GPT-3 pada 2020, dan yang terbaru, InstructGPT dan ChatGPT pada 2022. Sebelum memasukkan maklum balas manusia ke dalam sistem, kemajuan terbesar dalam evolusi model GPT didorong oleh pencapaian dalam kecekapan pengiraan, yang membolehkan GPT-3 melatih lebih banyak data daripada GPT-2, memberikannya lebih banyak pangkalan pengetahuan yang pelbagai dan keupayaan untuk melaksanakan pelbagai tugasan yang lebih luas.

Perbandingan GPT-2 (kiri) dan GPT-3 (kanan).

Semua model GPT menggunakan struktur pengubah, yang bermaksud mereka mempunyai pengekod untuk memproses urutan input dan penyahkod untuk menjana jujukan output. Kedua-dua pengekod dan penyahkod menampilkan mekanisme perhatian kendiri berbilang kepala, membolehkan model menimbang pelbagai bahagian jujukan secara berbeza untuk membuat kesimpulan makna dan konteks. Selain itu, pengekod menggunakan model bahasa bertopeng untuk memahami hubungan antara perkataan dan menghasilkan respons yang lebih mudah difahami.

Mekanisme perhatian diri yang mendorong GPT berfungsi dengan menukar token (serpihan teks, yang boleh menjadi perkataan, ayat atau kumpulan teks lain) kepada vektor yang mewakili kepentingan token dalam urutan input. Untuk melakukan ini, model ini:

- 1. Buat vektor

query,keydanvalueuntuk setiap token dalam jujukan input. - 2 Kira persamaan antara vektor

querydalam langkah 1 dankeyvektor antara satu sama lain dengan mengambil hasil darab titik kedua-dua vektor. - 3. Hasilkan pemberat normal dengan memasukkan output langkah 2 ke dalam fungsi

softmax. - 4 Dengan mendarab berat yang dihasilkan dalam langkah 3 dengan vektor

valuesetiap teg, vektor akhir dihasilkan yang mewakili kepentingan teg dalam jujukan.

Mekanisme perhatian "multi-head" yang digunakan oleh GPT ialah evolusi perhatian diri. Daripada melaksanakan langkah 1-4 sekaligus, model ini mengulangi mekanisme ini beberapa kali secara selari, setiap kali menghasilkan unjuran linear baharu bagi vektor query, key dan value. Dengan memanjangkan perhatian diri dengan cara ini, model ini dapat memahami sub-makna dan hubungan yang lebih kompleks dalam data input.

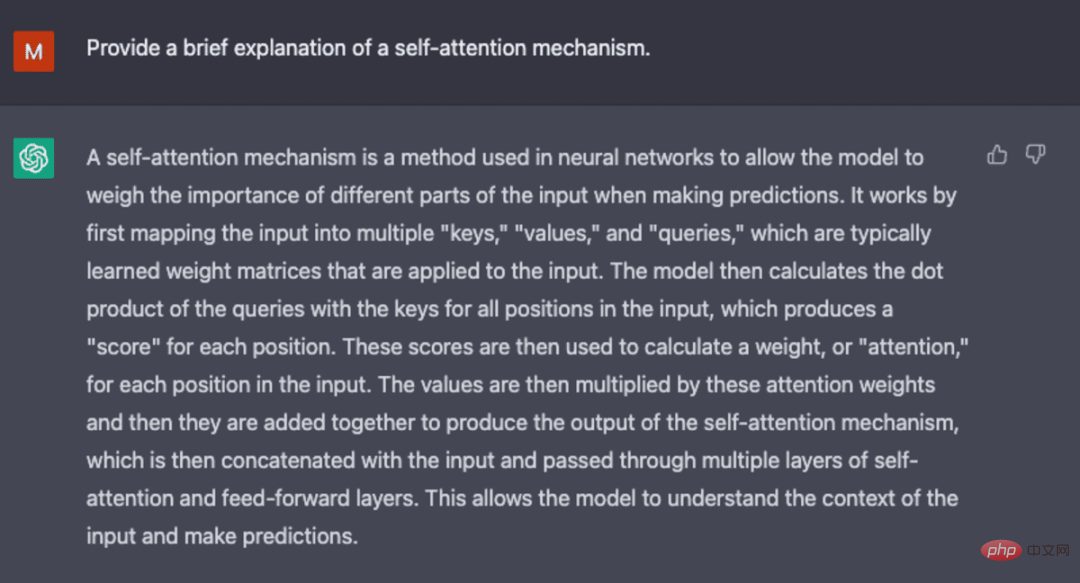

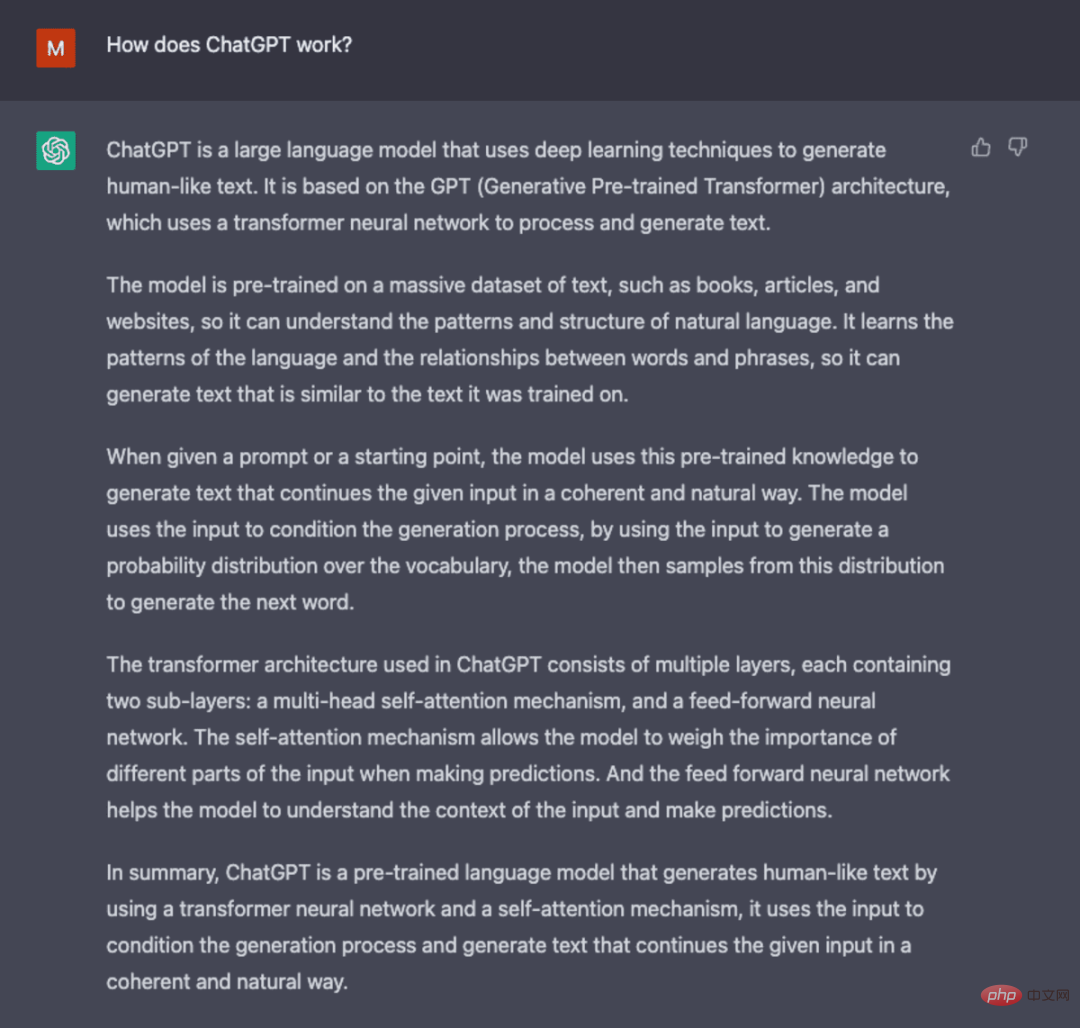

Tangkapan skrin dijana daripada ChatGPT.

Walaupun GPT-3 memperkenalkan kemajuan ketara dalam pemprosesan bahasa semula jadi, ia terhad dalam keupayaannya untuk menyelaraskan dengan niat pengguna. Sebagai contoh, GPT-3 mungkin menghasilkan output berikut:

- Tidak membantu, bermakna mereka tidak mengikut arahan eksplisit daripada pengguna.

- Mengandungi ilusi yang mencerminkan fakta yang tidak wujud atau tidak betul.

- Kekurangan kebolehtafsiran menyukarkan manusia untuk memahami cara model itu mencapai keputusan atau ramalan tertentu.

- Mengandungi kandungan berbahaya atau menyinggung perasaan dan kandungan berbahaya atau berat sebelah yang menyebarkan maklumat salah.

Kaedah latihan yang inovatif diperkenalkan dalam ChatGPT untuk mengimbangi beberapa masalah yang wujud dalam LLM standard.

ChatGPT

ChatGPT ialah terbitan InstructGPT yang memperkenalkan pendekatan baru untuk memasukkan maklum balas manusia ke dalam proses latihan untuk menjadikan model Output disepadukan dengan lebih baik dengan niat pengguna. Pembelajaran pengukuhan daripada maklum balas manusia (RLHF) diterangkan secara mendalam dalam kertas kerja openAI 2022 "Melatih model bahasa untuk mengikuti arahan dengan maklum balas manusia" dan diterangkan secara ringkas di bawah.

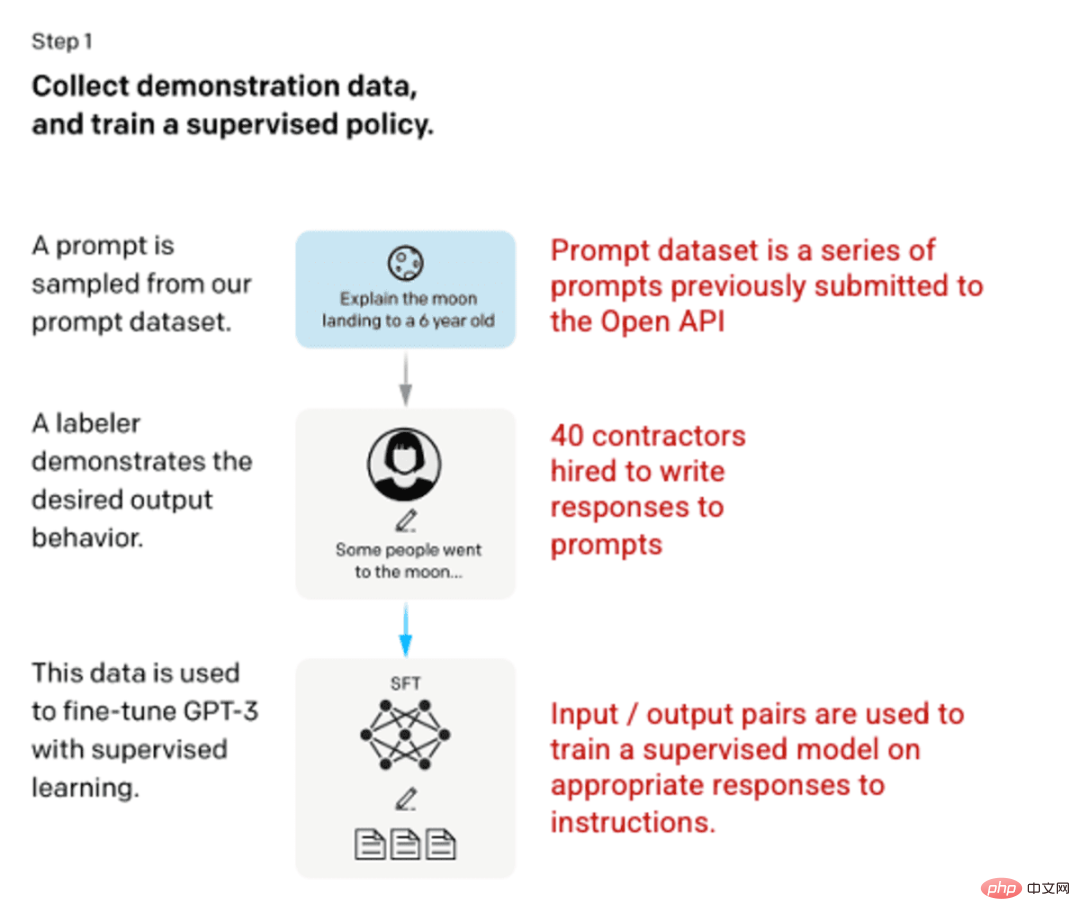

Langkah 1: Model Penyeliaan Penalaan Halus (SFT)

Pembangunan pertama melibatkan penalaan halus model GPT-3, menggunakan 40 kontraktor untuk mencipta set data latihan yang diselia di mana input mempunyai output yang diketahui untuk dipelajari oleh model. Input atau gesaan dikumpulkan daripada input pengguna sebenar kepada API terbuka. Penanda kemudian menulis respons yang sesuai kepada gesaan, mencipta output yang diketahui untuk setiap input. Model GPT-3 kemudiannya diperhalusi menggunakan set data diselia baharu ini untuk mencipta GPT-3.5, juga dikenali sebagai model SFT.

Untuk memaksimumkan kepelbagaian set data gesaan, hanya 200 gesaan boleh datang daripada mana-mana ID pengguna tertentu dan sebarang gesaan yang berkongsi awalan biasa yang panjang dialih keluar. Akhirnya, semua petua yang mengandungi maklumat pengenalan peribadi (PII) telah dialih keluar.

Selepas mengagregatkan maklumat segera daripada OpenAI API, pelabel juga diminta membuat sampel maklumat segera untuk mengisi kategori tersebut dengan data sampel sebenar yang sangat sedikit. Kategori untuk diikuti termasuk:

- Petua Umum: Sebarang pertanyaan rawak.

- Petua Kecil: Arahan yang mengandungi berbilang pasangan pertanyaan/jawapan.

- Petua berasaskan pengguna: sepadan dengan kes penggunaan khusus yang diminta untuk API OpenAI.

Apabila menjana respons, penanda dikehendaki melakukan yang terbaik untuk membuat kesimpulan tentang arahan pengguna. Dokumen ini menerangkan tiga cara utama di mana gesaan boleh meminta maklumat.

- Langsung: "Beritahu saya tentang..."

- Beberapa perkataan: Beri contoh dua cerita ini, tulis cerita lain tentang topik yang sama.

- Sambungan: Berikan permulaan cerita dan selesaikannya.

Kompilasi gesaan daripada OpenAI API dan gesaan tulisan tangan daripada pelabel, menghasilkan 13,000 sampel input/output untuk digunakan dalam model yang diselia.

Gambar (kiri) disisipkan daripada "Melatih model bahasa untuk mengikut arahan dengan maklum balas manusia" OpenAI et al., 2022 https://arxiv.org/pdf/2203.02155. pdf. (Kanan) Konteks tambahan ditambah dengan warna merah.

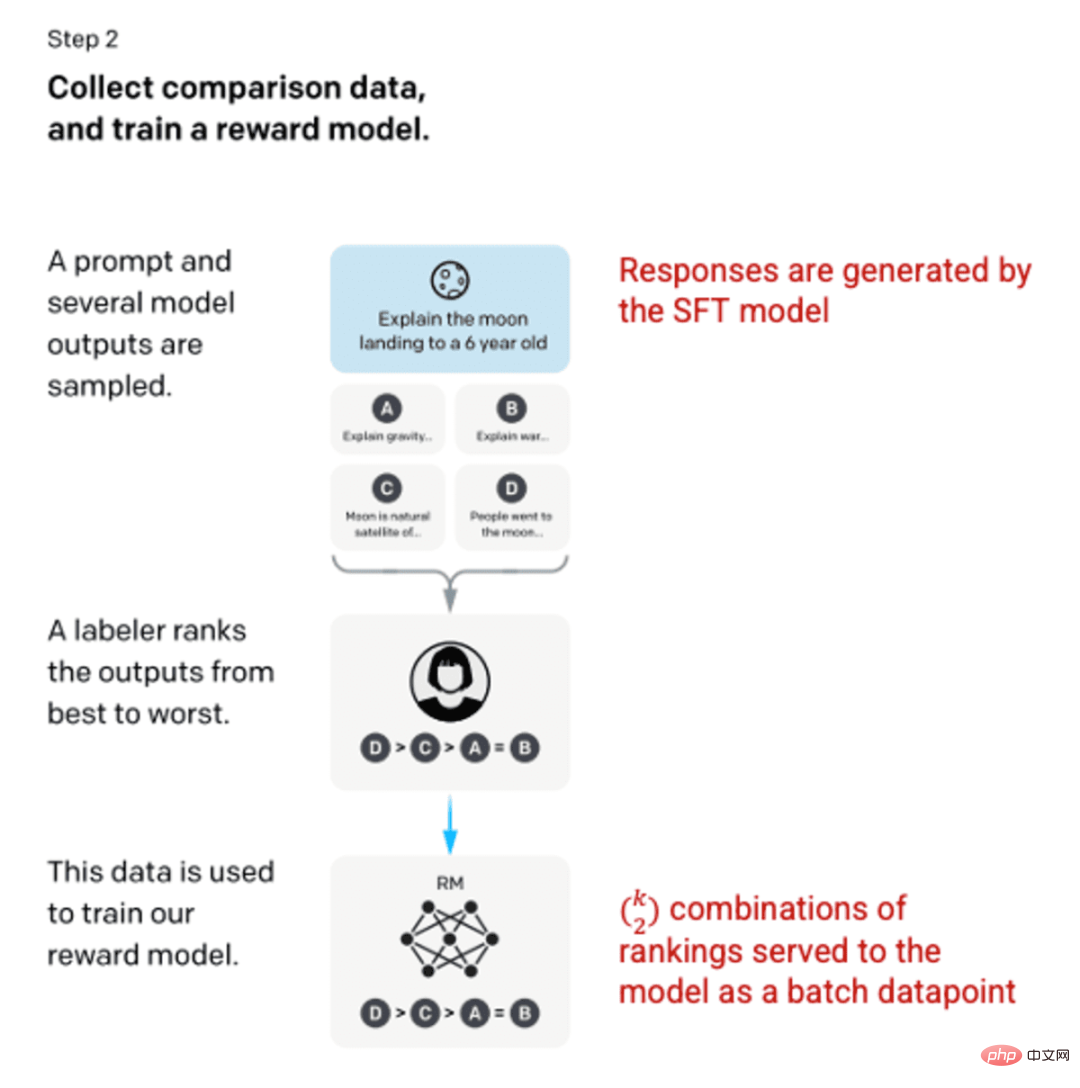

Langkah 2: Model Ganjaran

Selepas melatih model SFT dalam langkah 1, model menghasilkan gesaan yang lebih baik untuk pengguna , respons yang konsisten. Penambahbaikan seterusnya datang dalam bentuk model ganjaran latihan, di mana input kepada model adalah urutan isyarat dan tindak balas, dan output adalah nilai berskala yang dipanggil ganjaran. Model ganjaran diperlukan untuk memanfaatkan Pembelajaran Pengukuhan, di mana model belajar untuk menghasilkan output yang memaksimumkan ganjarannya (lihat langkah 3).

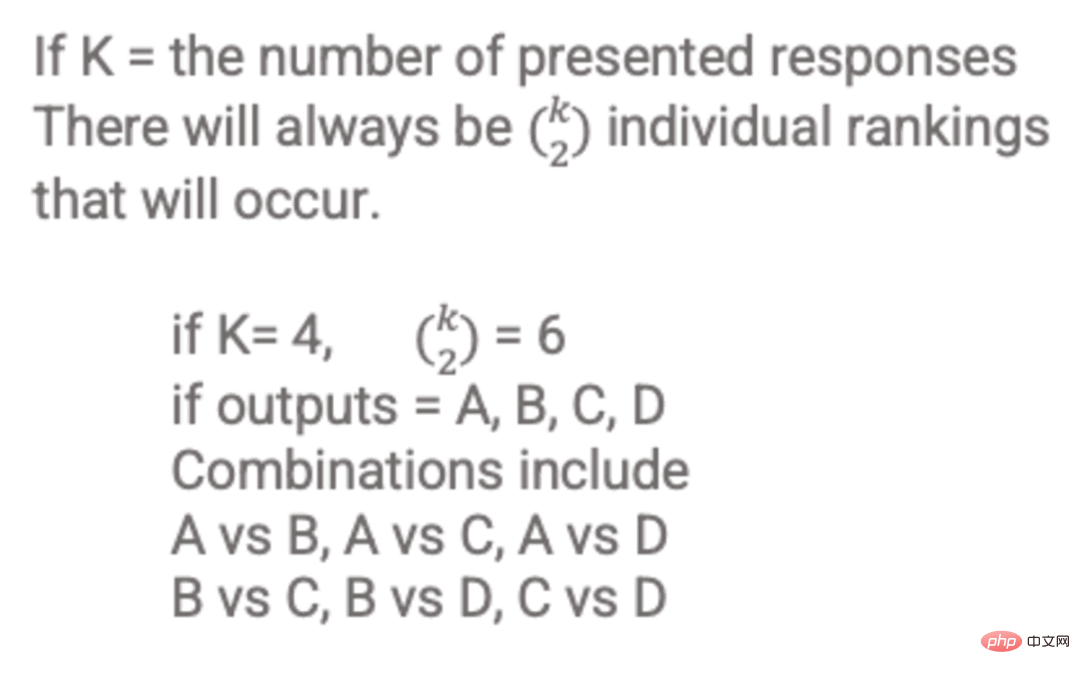

Untuk melatih model ganjaran, pelabel menyediakan 4 hingga 9 output model SFT kepada gesaan input tunggal. Mereka diminta untuk menilai keluaran ini daripada yang terbaik kepada yang terburuk, mencipta kombinasi berperingkat keluaran seperti ini:

Contoh gabungan berperingkat respons.

Memasukkan setiap gabungan dalam model sebagai titik data yang berasingan membawa kepada overfitting (ketidakupayaan untuk mengekstrapolasi melebihi data yang dilihat). Untuk menyelesaikan masalah ini, model dibina menggunakan setiap set kedudukan sebagai kumpulan titik data yang berasingan.

Gambar (kiri) disisipkan daripada "Melatih model bahasa untuk mengikut arahan dengan maklum balas manusia" OpenAI et al., 2022 https://arxiv.org/pdf/2203.02155. pdf. (Kanan) Konteks tambahan ditambah dengan warna merah.

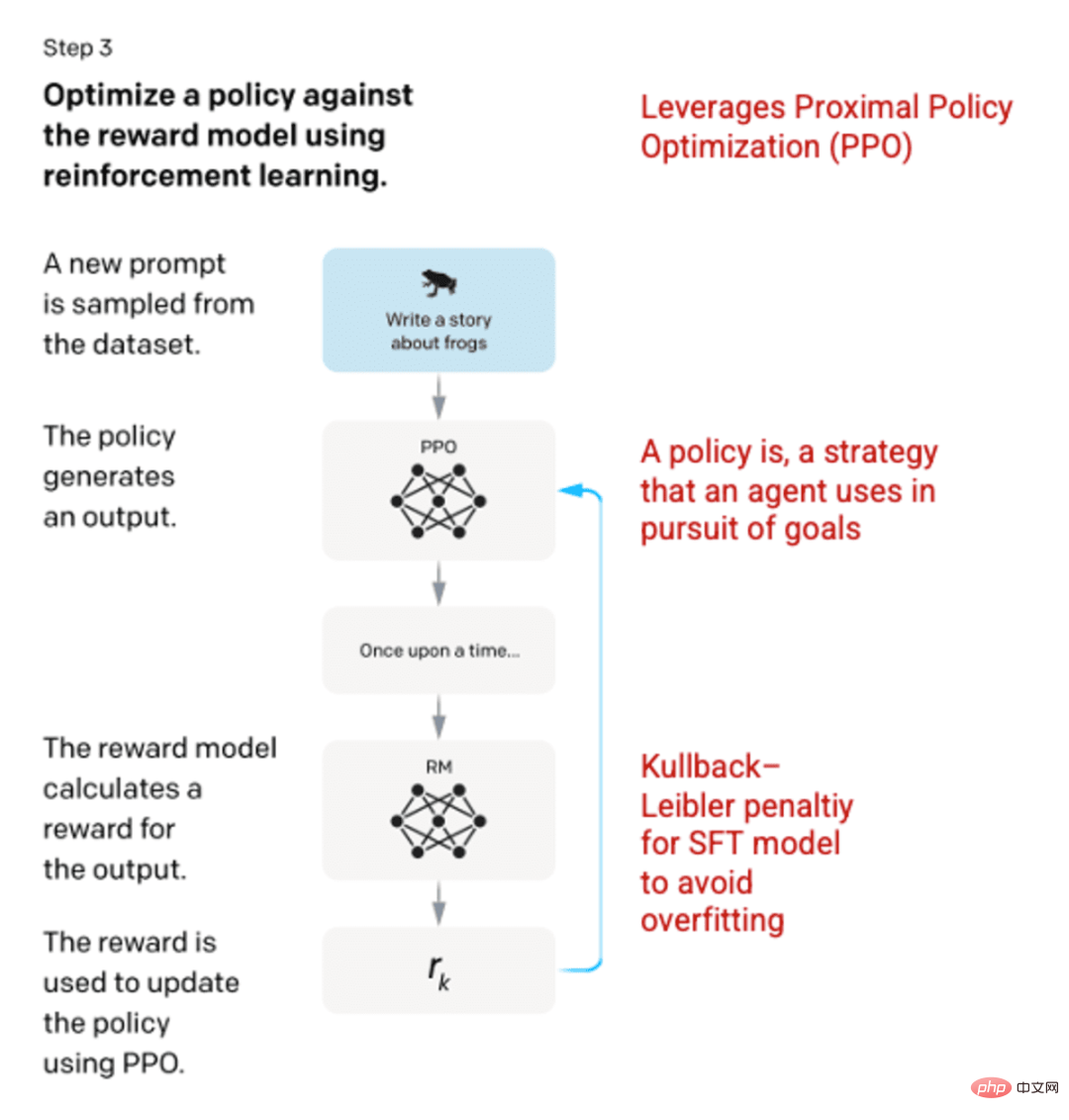

Langkah 3: Model Pembelajaran Pengukuhan

Pada peringkat akhir, gesaan rawak dibentangkan kepada model dan respons dikembalikan. Respons dijana menggunakan "dasar" yang dipelajari oleh model dalam langkah 2. Dasar ini mewakili strategi yang telah dipelajari oleh mesin untuk mencapai matlamatnya dalam kes ini, memaksimumkan ganjarannya. Berdasarkan model ganjaran yang dibangunkan dalam langkah 2, nilai ganjaran berskala kemudian ditentukan untuk pasangan isyarat dan tindak balas. Ganjaran kemudiannya dimasukkan semula ke dalam model untuk membangunkan strategi.

Pada 2017, Schulman et al memperkenalkan pengoptimuman dasar proksimal (PPO), kaedah untuk mengemas kini dasar model apabila setiap respons dijana. PPO menggabungkan penalti Kullback-Leibler (KL) dalam model SFT. Perbezaan KL mengukur persamaan dua fungsi pengedaran dan menghukum jarak yang melampau. Dalam kes ini, menggunakan penalti KL boleh mengurangkan jarak tindak balas daripada output model SFT yang dilatih dalam langkah 1 untuk mengelakkan terlalu mengoptimumkan model ganjaran dan menyimpang terlalu banyak daripada set data niat manusia.

Gambar (kiri) disisipkan daripada "Melatih model bahasa untuk mengikut arahan dengan maklum balas manusia" OpenAI et al., 2022 https://arxiv.org/pdf/2203.02155. pdf. (Kanan) Konteks tambahan ditambah dengan warna merah.

Langkah 2 dan 3 proses boleh diulang berulang kali, walaupun ini belum lagi dilakukan secara meluas dalam amalan.

Tangkapan skrin dijana daripada ChatGPT.

Penilaian model

Penilaian model dilakukan dengan menempah set ujian yang model tidak pernah lihat semasa latihan. Pada set ujian, satu siri penilaian dijalankan untuk menentukan sama ada model berprestasi lebih baik daripada pendahulunya, GPT-3.

Kebergunaan: Keupayaan model untuk membuat kesimpulan dan mengikut arahan pengguna. Pelabel lebih suka output InstructGPT daripada GPT-3 85±3% sepanjang masa.

Keaslian: Kecenderungan model untuk berhalusinasi. Apabila dinilai menggunakan set data TruthfulQA, output yang dihasilkan oleh model PPO menunjukkan peningkatan kecil dalam kedua-dua realisme dan bermaklumat.

Ketidakmudaratan: Keupayaan model untuk mengelakkan kandungan yang tidak sesuai, menghina dan memfitnah. Ketidakmudaratan diuji menggunakan set data RealToxicityPrompts. Ujian dijalankan di bawah tiga keadaan.

- Arahan memberikan respons yang hormat: membawa kepada pengurangan ketara dalam tindak balas berbahaya.

- Arahan memberikan reaksi tanpa sebarang tetapan berkenaan penghormatan: Tiada perubahan ketara dalam bahaya.

- Panduan menyediakan tindak balas yang berbahaya: tindak balas sebenarnya jauh lebih berbahaya daripada model GPT-3.

Untuk mendapatkan maklumat lanjut tentang kaedah yang digunakan untuk mencipta ChatGPT dan InstructGPT, sila baca kertas asal "Melatih model bahasa untuk mengikuti arahan dengan maklum balas manusia" yang diterbitkan oleh OpenAI, 2022 https:// arxiv .org/pdf/2203.02155.pdf.

Tangkapan skrin dijana daripada ChatGPT.

Atas ialah kandungan terperinci ChatGPT: Gabungan model berkuasa, mekanisme perhatian dan pembelajaran pengukuhan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI