Rumah >Peranti teknologi >AI >ChatGLM, model dialog asas Gigabit berasaskan Tsinghua, telah melancarkan ujian dalaman dan merupakan versi kad tunggal sumber terbuka model tersebut.

ChatGLM, model dialog asas Gigabit berasaskan Tsinghua, telah melancarkan ujian dalaman dan merupakan versi kad tunggal sumber terbuka model tersebut.

- 王林ke hadapan

- 2023-04-30 10:55:061395semak imbas

Pengeluaran ChatGPT telah menggerakkan seluruh bidang AI, dan syarikat teknologi utama, syarikat permulaan dan pasukan universiti mengikutinya. Baru-baru ini, Heart of the Machine telah melaporkan hasil penyelidikan banyak syarikat permulaan dan pasukan universiti.

Semalam, satu lagi model dialog AI domestik berskala besar membuat penampilan sulungnya: ChatGLM, AI spektrum pintar syarikat yang berubah daripada pencapaian teknologi Tsinghua dan berdasarkan model asas GLM-130B 100 bilion , kini dibuka untuk jemputan Ujian dalaman.

Perlu dinyatakan bahawa Zhipu AI juga telah menggunakan sumber terbuka model dialog dwibahasa Cina-Inggeris ChatGLM-6B, yang menyokong inferens pada satu kad grafik gred pengguna.

Tapak web aplikasi beta dalaman: chatglm.cn

Difahamkan bahawa peningkatan keupayaan versi semasa model ChatGLM terutamanya datang daripada model asas 100 bilion unik GLM-130B. Ia adalah seni bina yang berbeza daripada BERT, GPT-3 dan T5 Ia adalah model pra-latihan autoregresif yang mengandungi fungsi berbilang objektif.

Pada Ogos 2022, Universiti Tsinghua bersama-sama melancarkan model padat dwibahasa Cina-Inggeris GLM-130B dengan 130 bilion parameter kepada komuniti penyelidikan dan industri Model ini mempunyai beberapa ciri unik Kelebihan:

- Dwibahasa: menyokong kedua-dua bahasa Cina dan Inggeris

- Ketepatan tinggi (Bahasa Inggeris): dalam bahasa Inggeris awam Lebih baik daripada GPT- 3 175B (API: davinci, model asas), OPT-175B dan BLOOM-176B dalam senarai LAMBADA, MMLU dan Big-bench-lite; Jauh lebih baik daripada ERNIE TITAN 3.0 260B dan YUAN 1.0-245B pada 7 set data CLUE sampel sifar dan 5 set data FewCLUE sifar sampel

- Inferens Pantas: Model A 100 bilion Pertama; melaksanakan kuantifikasi INT4, menyokong inferens yang pantas dan pada asasnya tanpa kerugian dengan pelayan 3090 4 kad atau 8 kad 2080Ti

- Kebolehulangan: semua keputusan (lebih daripada 30 Setiap tugas) boleh dihasilkan semula melalui; kod sumber terbuka dan parameter model kami;

- Cross-platform: menyokong pemproses domestik Haiguang DCU, Huawei Ascend 910 dan Sunway serta Latihan dan inferens Amerika Syarikat pada cip NVIDIA.

- Kini, merujuk kepada idea reka bentuk ChatGPT, ChatGLM telah menyuntik kod pra-latihan ke dalam model asas GLM-130B, melalui penalaan halus yang diselia (Penalaan Halus Terpantau ) dan teknologi lain untuk mencapai penjajaran niat manusia.

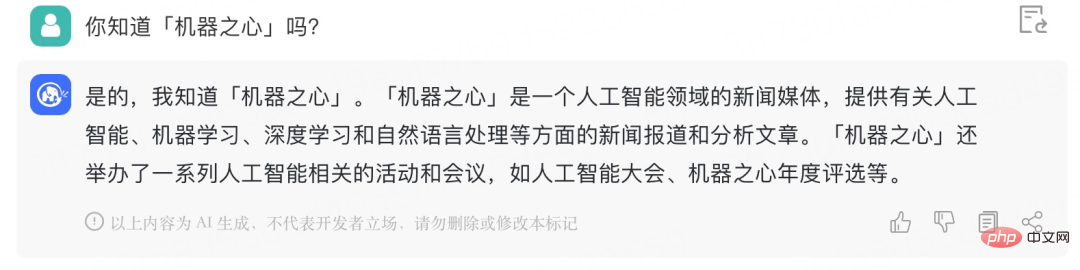

Heart of the Machine telah memperoleh kod jemputan untuk beta tertutup Berikut ialah perbualan ringkas dengan ChatGLM Kesannya adalah seperti berikut:

Ia boleh memahami maksud sebenar "station CP":

Ia boleh memahami maksud sebenar "station CP":

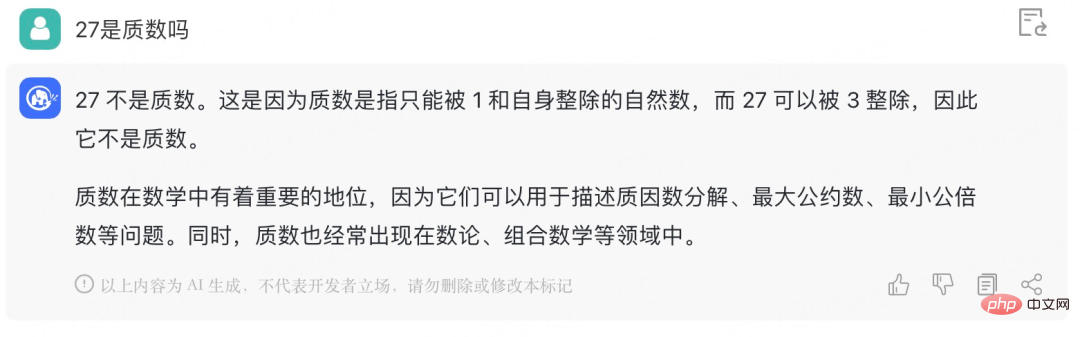

Beri ChatGLM masalah matematik untuk dicuba:

Sejak dia mempelajari persamaan linear dua pembolehubah, masalah asas "ayam dan arnab dalam sangkar yang sama" seperti ini boleh tidak lagi menyusahkan dia:

Sejak dia mempelajari persamaan linear dua pembolehubah, masalah asas "ayam dan arnab dalam sangkar yang sama" seperti ini boleh tidak lagi menyusahkan dia:

Open Source ChatGLM-6B

ChatGLM-6B ialah model bahasa perbualan sumber terbuka yang menyokong soalan dan jawapan dwibahasa Cina-Inggeris dan dioptimumkan untuk bahasa Cina. Model ini berdasarkan seni bina General Language Model (GLM) dan mempunyai 6.2 bilion parameter. Digabungkan dengan teknologi pengkuantitian model, pengguna boleh menggunakannya secara tempatan pada kad grafik gred pengguna (minimum 6GB memori video diperlukan pada tahap pengkuantitian INT4). ChatGLM-6B menggunakan teknologi yang sama seperti ChatGLM dan dioptimumkan untuk Soal Jawab dan dialog Cina. Selepas latihan dwibahasa dalam bahasa Cina dan Inggeris dengan kira-kira pengecam 1T, ditambah dengan penalaan halus yang diselia, layan diri maklum balas, pembelajaran pengukuhan maklum balas manusia dan teknologi lain, 6.2 bilion parameter ChatGLM-6B, walaupun tidak sebesar model 100 bilion, telah banyak mengurangkan kos inferens dan bertambah baik Ia telah meningkatkan kecekapan dan sudah boleh menjana jawapan yang agak konsisten dengan pilihan manusia.

Alamat sumber terbuka model: https://github.com/THUDM/ChatGLM-6B

Khususnya , ChatGLM-6B mempunyai ciri-ciri berikut:

- Pra-latihan dwibahasa yang mencukupi dalam bahasa Cina dan Inggeris: ChatGLM-6B telah melatih jumlah token 1T pada bahan Cina dan Inggeris dalam nisbah 1:1 , kedua-duanya dwibahasa.

- Seni bina dan saiz model yang dioptimumkan: Berdasarkan pengalaman latihan GLM-130B, pelaksanaan pengekodan kedudukan RoPE 2D disemak semula, menggunakan struktur FFN tradisional. Saiz parameter 6B (6.2 bilion) juga membolehkan penyelidik dan pembangun individu memperhalusi dan menggunakan ChatGLM-6B sendiri.

- Ambang penggunaan yang lebih rendah: Pada separuh ketepatan FP16, ChatGLM-6B memerlukan sekurang-kurangnya 13 GB memori video untuk inferens Digabungkan dengan teknologi pengkuantitian model, keperluan ini boleh dikurangkan lagi kepada 10GB (. INT8 ) dan 6GB (INT4), membolehkan ChatGLM-6B digunakan pada kad grafik gred pengguna.

- Panjang jujukan yang lebih panjang: Berbanding dengan GLM-10B (panjang jujukan 1024), ChatGLM-6B mempunyai panjang jujukan 2048, menyokong perbualan dan aplikasi yang lebih panjang.

- Latihan penjajaran niat manusia: Penalaan Halus yang Diawasi, Bootstrap Maklum Balas, Pembelajaran Peneguhan daripada Maklum Balas Manusia dan kaedah lain digunakan untuk membuat Model ini mula mempunyai keupayaan untuk memahami maksud arahan manusia. Format output ialah turunkan untuk paparan mudah.

Namun, disebabkan kapasiti model ChatGLM-6B yang kecil, sudah pasti terdapat beberapa batasan dan kekurangan, termasuk:

- Memori model dan keupayaan bahasa yang agak lemah. ChatGLM-6B mungkin menjana maklumat yang salah apabila berhadapan dengan banyak tugas pengetahuan fakta, dan ia tidak begitu baik dalam menyelesaikan masalah logik (seperti matematik, pengaturcaraan).

- Boleh menjana ilustrasi yang berbahaya atau kandungan berat sebelah: ChatGLM-6B hanyalah model bahasa yang pada mulanya sejajar dengan niat manusia dan mungkin menghasilkan kandungan yang berbahaya dan berat sebelah.

- Keupayaan dialog berbilang pusingan yang lemah: Keupayaan pemahaman konteks ChatGLM-6B tidak mencukupi, dan kehilangan konteks mungkin berlaku apabila berhadapan dengan penjanaan jawapan yang panjang dan senario dialog berbilang pusingan dan situasi salah faham .

Pasukan GLM menyatakan bahawa ChatGLM masih jauh di belakang penyelidikan dan produk model besar antarabangsa pada masa hadapan, ia akan terus membangunkan dan versi terkini ChatGLM sumber terbuka dan model yang berkaitan. Pasukan GLM juga mengalu-alukan semua orang untuk memuat turun ChatGLM-6B dan menjalankan penyelidikan dan pembangunan aplikasi (bukan komersial) berdasarkannya.

Atas ialah kandungan terperinci ChatGLM, model dialog asas Gigabit berasaskan Tsinghua, telah melancarkan ujian dalaman dan merupakan versi kad tunggal sumber terbuka model tersebut.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI