Rumah >Peranti teknologi >AI >'Lu Zhiwu, seorang penyelidik di Universiti Renmin China, mencadangkan kesan penting ChatGPT pada model generatif pelbagai mod'

'Lu Zhiwu, seorang penyelidik di Universiti Renmin China, mencadangkan kesan penting ChatGPT pada model generatif pelbagai mod'

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-24 18:25:091750semak imbas

Berikut ialah kandungan ucapan Profesor Lu Zhiwu di ChatGPT dan Persidangan Teknologi Model Besar yang diadakan oleh Heart of the Machine telah menyunting dan mengaturnya tanpa mengubahnya maksud asal:

Helo semua, saya Lu Zhiwu dari Universiti Renmin China. Tajuk laporan saya hari ini ialah "Pencerahan Penting ChatGPT pada Model Generatif Multimodal", yang terdiri daripada empat bahagian.

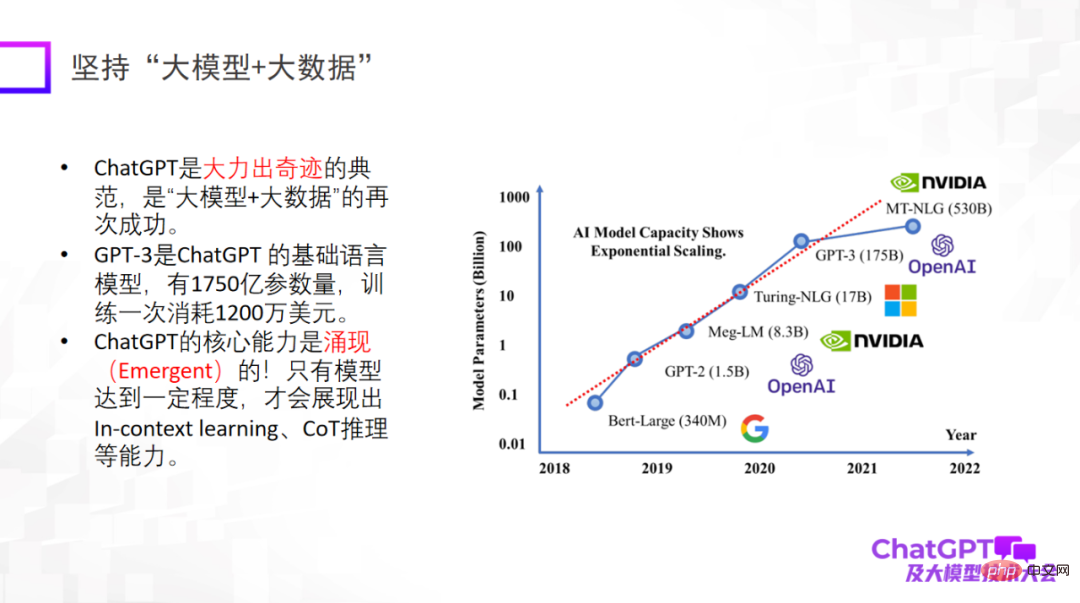

Pertama sekali, ChatGPT membawakan kita sedikit inspirasi tentang inovasi paradigma penyelidikan. Perkara pertama ialah menggunakan "model besar + data besar", yang merupakan paradigma penyelidikan yang telah berulang kali disahkan dan juga merupakan paradigma penyelidikan asas ChatGPT. Adalah penting untuk menekankan bahawa hanya apabila model besar mencapai tahap tertentu, ia akan mempunyai keupayaan yang muncul, seperti pembelajaran dalam konteks, penaakulan CoT dan keupayaan lain.

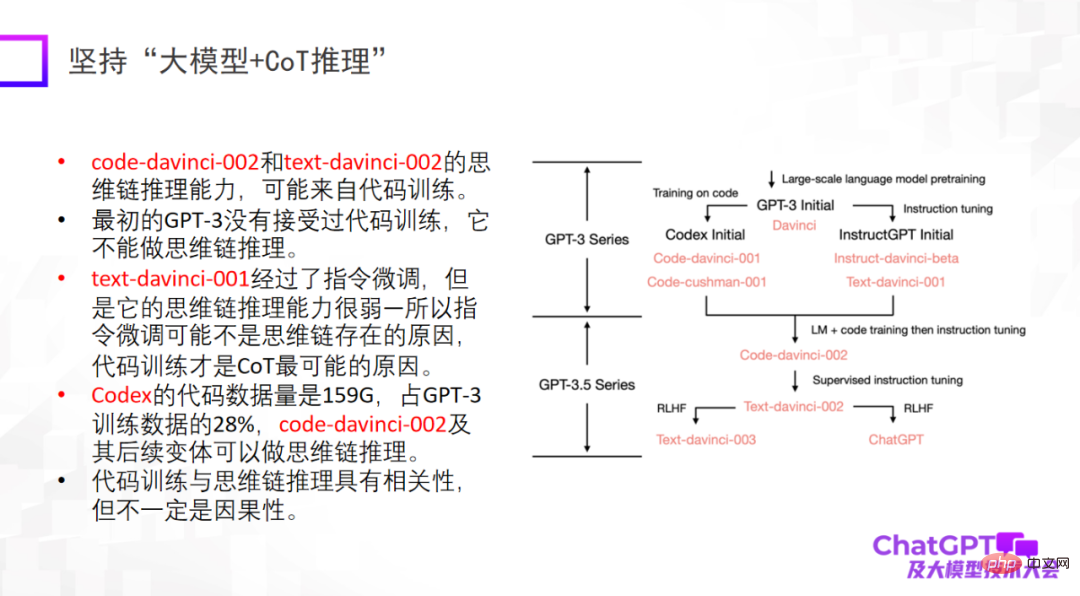

Perkara kedua ialah menegaskan "model besar + inferens". Kerana dalam bidang pembelajaran mesin atau kecerdasan buatan, penaakulan diiktiraf sebagai yang paling sukar, dan ChatGPT juga telah membuat penemuan dalam hal ini. Sudah tentu, keupayaan penaakulan ChatGPT mungkin berasal dari latihan kod, tetapi sama ada terdapat sambungan yang tidak dapat dielakkan masih belum pasti. Dari segi penaakulan, kita harus berusaha lebih untuk mencari tahu dari mana asalnya, atau sama ada terdapat kaedah latihan lain untuk meningkatkan lagi keupayaan penaakulannya.

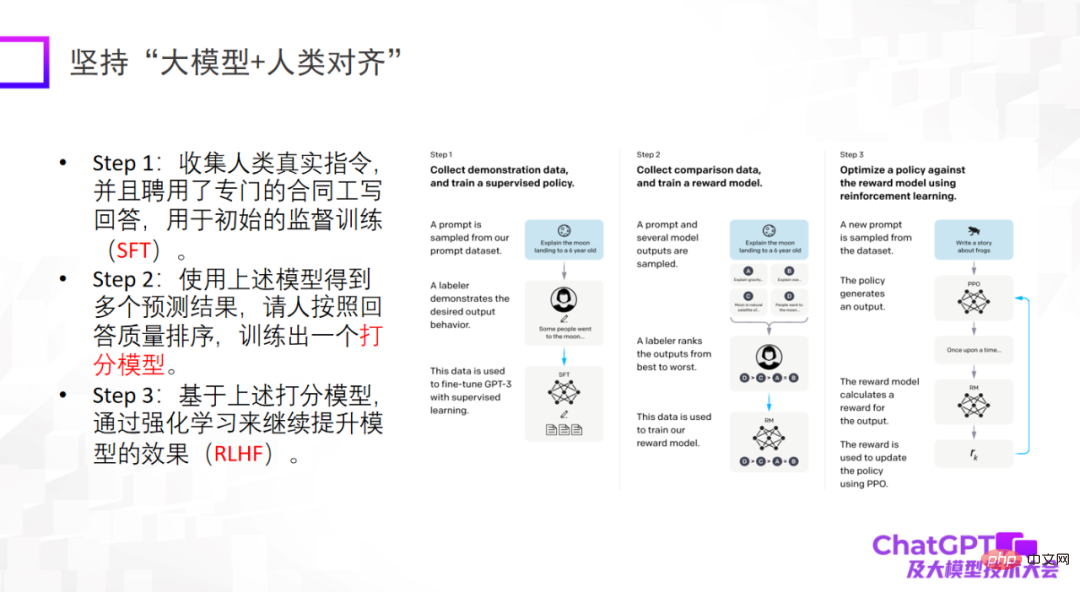

Perkara ketiga ialah model besar mesti sejajar dengan manusia Inilah yang ChatGPT berikan kepada kita dari perspektif kejuruteraan atau sudut pendaratan model. Pencerahan. Jika tidak sejajar dengan manusia, model itu akan menghasilkan banyak maklumat berbahaya, menjadikan model itu tidak boleh digunakan. Perkara ketiga bukanlah untuk menaikkan had atas model, tetapi kebolehpercayaan dan keselamatan model sememangnya sangat penting.

Kemunculan ChatGPT telah memberi impak yang besar dalam banyak bidang, termasuk saya sendiri. Kerana saya telah melakukan pelbagai mod selama beberapa tahun, saya akan mula memikirkan mengapa kami tidak membuat model yang begitu berkuasa.

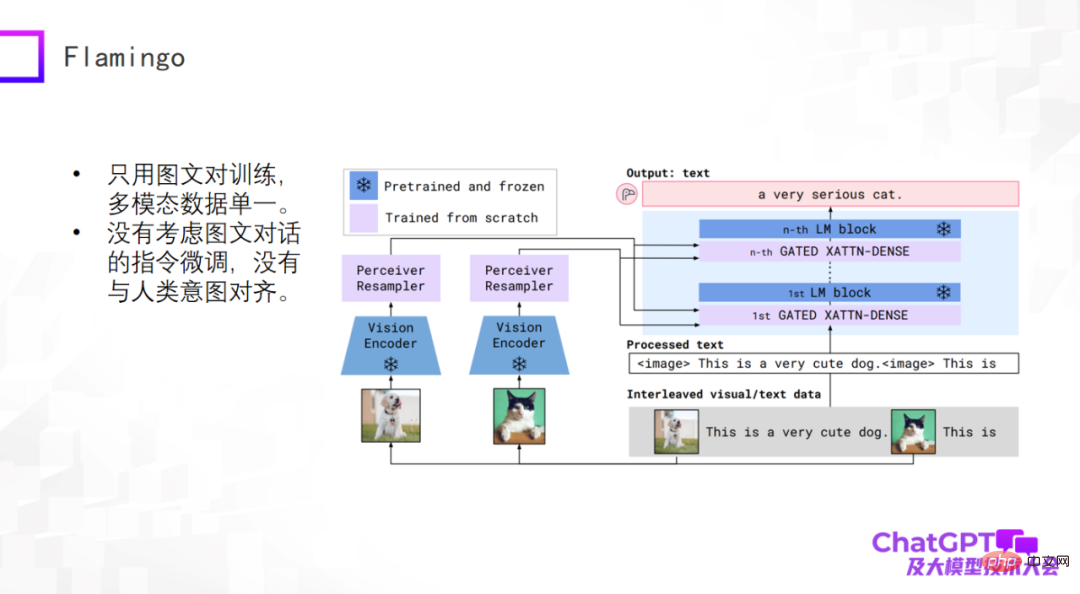

ChatGPT ialah generasi universal dalam bahasa atau teks. Mari kita lihat kemajuan terkini dalam bidang generasi universal berbilang modal. Model pra-latihan multimodal telah mula berubah menjadi model generatif am multimodal, dan terdapat beberapa penerokaan awal. Mula-mula, mari kita lihat model Flamingo yang dicadangkan oleh Google pada 2019. Angka berikut ialah struktur modelnya.

Badan utama seni bina model Flamingo ialah penyahkod (Dekoder) model bahasa besar, iaitu modul biru di sebelah kanan daripada gambar di atas dalam setiap biru Beberapa lapisan penyesuai ditambah antara modul warna, dan Pengekod Penglihatan dan Perceiver Resampler ditambahkan pada bahagian visual kiri. Reka bentuk keseluruhan model adalah untuk mengekod dan menukar perkara visual, melalui penyesuai, dan menyelaraskannya dengan bahasa, supaya model boleh menjana penerangan teks secara automatik untuk imej.

Apakah faedah reka bentuk seni bina seperti Flamingo? Pertama sekali, modul biru dalam gambar di atas adalah tetap (beku), termasuk Dekoder model bahasa manakala jumlah parameter modul merah jambu itu sendiri boleh dikawal, jadi bilangan parameter yang sebenarnya dilatih oleh model Flamingo adalah sangat kecil. Oleh itu, jangan fikir bahawa model generatif universal berbilang modal sukar untuk dibina. Model Flamingo terlatih boleh melakukan banyak tugas umum berdasarkan penjanaan teks Sudah tentu, input adalah berbilang modal, seperti penerangan video, soalan dan jawapan visual, dialog berbilang modal, dsb. Dari perspektif ini, Flamingo boleh dianggap sebagai model generatif umum.

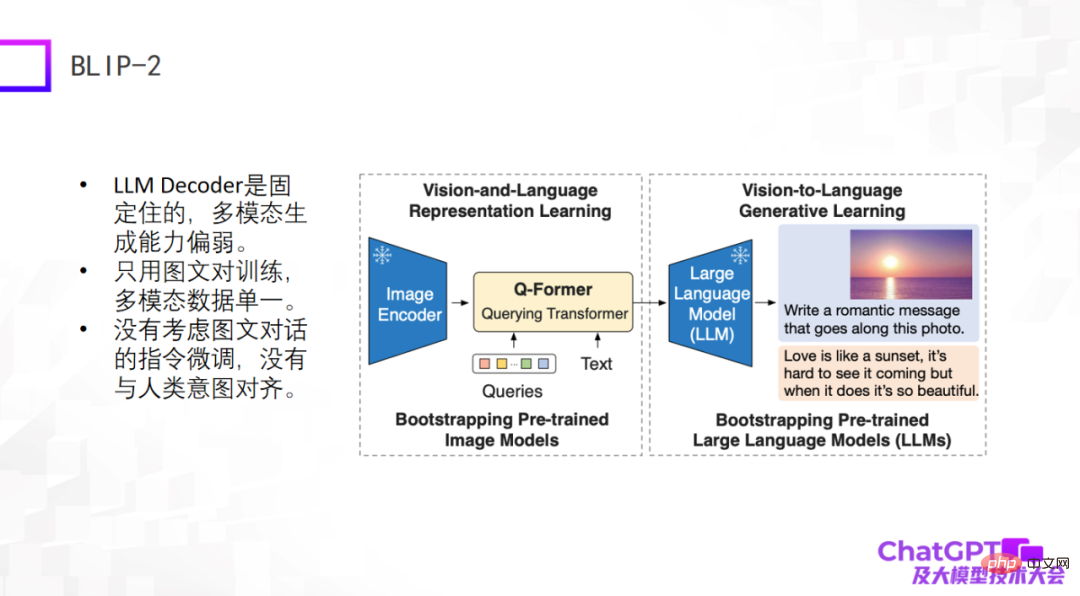

Contoh kedua ialah model BLIP-2 yang baru dikeluarkan beberapa ketika dahulu Ia dipertingkatkan berdasarkan BLIP-1 Seni bina modelnya sangat serupa dengan Flamingo, dan ia pada asasnya termasuk imej pengekodan. Penyahkod dan penyahkod model bahasa besar ditetapkan, dan kemudian Q-Former dengan fungsi penukar ditambah di tengah - daripada penukaran visual kepada bahasa. Jadi, bahagian BLIP-2 yang benar-benar memerlukan latihan ialah Q-Former.

Seperti yang ditunjukkan dalam rajah di bawah, mula-mula masukkan gambar (gambar di sebelah kanan) ke dalam Pengekod Imej Teks di tengah ialah soalan atau arahan yang dibangkitkan oleh pengguna, yang merupakan input selepas pengekodan Q-Former Pergi ke model bahasa yang besar dan akhirnya menghasilkan jawapan, yang mungkin merupakan proses penjanaan.

Kekurangan kedua-dua model ini jelas, kerana ia muncul agak awal atau baru muncul, dan kaedah kejuruteraan yang digunakan oleh ChatGPT tidak dipertimbangkan . Sekurang-kurangnya tiada arahan penalaan halus untuk dialog grafik atau dialog pelbagai mod, jadi kesan penjanaan keseluruhannya tidak memuaskan.

Yang ketiga ialah Kosmos-1 yang dikeluarkan baru-baru ini oleh Microsoft Ia mempunyai struktur yang sangat mudah dan hanya menggunakan pasangan imej dan teks untuk latihan. Perbezaan terbesar antara Kosmos-1 dan dua model di atas ialah model bahasa besar itu sendiri dalam dua model di atas adalah tetap, manakala model bahasa besar itu sendiri dalam Kosmos-1 perlu dilatih, jadi model Kosmos-1 Nombor daripada parameter hanya 1.6 bilion, dan model dengan 1.6 bilion parameter mungkin tidak mempunyai keupayaan untuk muncul. Sudah tentu, Kosmos-1 tidak mengambil kira penalaan halus arahan dalam dialog grafik, menyebabkan ia kadang-kadang bercakap karut.

Contoh seterusnya ialah model bahasa visual terkandung pelbagai mod Google PaLM-E. Model PaLM-E adalah serupa dengan tiga contoh pertama PaLM-E juga menggunakan model bahasa ViT + besar. Kejayaan terbesar PaLM-E ialah ia akhirnya meneroka kemungkinan melaksanakan model bahasa besar berbilang modal dalam bidang robotik. PaLM-E mencuba langkah pertama penerokaan, tetapi jenis tugas robot yang dianggapnya adalah sangat terhad dan tidak boleh benar-benar universal.

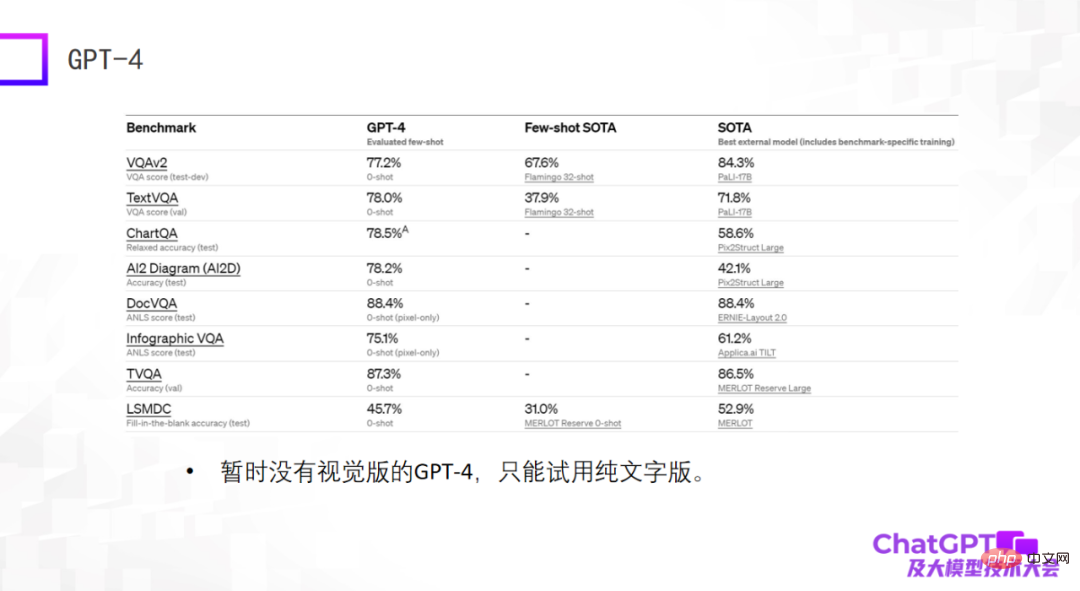

Contoh terakhir ialah GPT-4 - ia memberikan hasil yang sangat menakjubkan pada set data standard, dan banyak kali keputusannya lebih baik daripada Pada masa ini, model SOTA diperhalusi yang dilatih pada set data adalah lebih baik. Ini mungkin mengejutkan, tetapi ia sebenarnya tidak bermakna apa-apa. Semasa kami membina model besar berbilang modal dua tahun lalu, kami mendapati bahawa keupayaan model besar tidak boleh dinilai pada set data standard Prestasi yang baik pada set data standard tidak bermakna hasil yang baik dalam penggunaan sebenar dua. Atas sebab ini, saya sedikit kecewa dengan GPT-4 semasa, kerana ia hanya memberikan hasil pada set data standard. Selain itu, GPT-4 yang tersedia pada masa ini bukanlah versi visual, tetapi versi teks tulen.

Secara umumnya, model di atas digunakan untuk penjanaan bahasa umum, dan input adalah input berbilang modal Dua model berikut adalah berbeza. Kini - bukan sahaja penjanaan bahasa umum, tetapi juga penjanaan visual, yang boleh menjana kedua-dua bahasa dan imej.

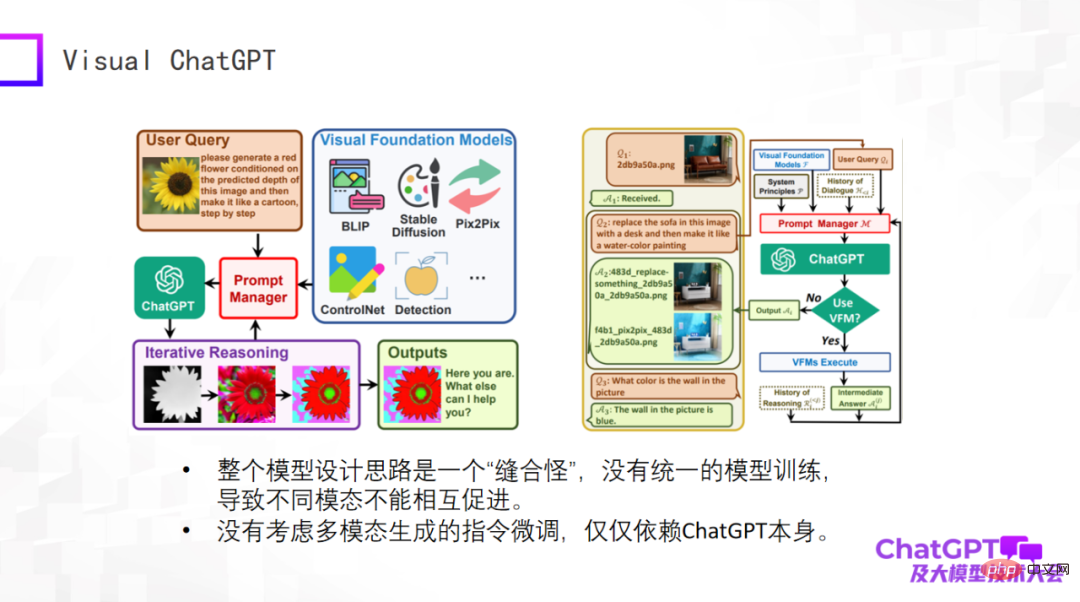

Yang pertama ialah Visual ChatGPT Microsoft, yang akan saya ulas secara ringkas. Idea model ini sangat mudah, dan ia lebih kepada pertimbangan reka bentuk produk. Terdapat banyak jenis penjanaan berkaitan penglihatan, serta beberapa model pengesanan visual Input dan arahan untuk tugasan yang berbeza ini berbeza secara meluas Masalahnya ialah cara menggunakan satu model untuk memasukkan semua tugasan ini, jadi Microsoft mereka bentuk pengurus Prompt. yang digunakan dalam bahagian teras OpenAI's ChatGPT adalah setara dengan menterjemah arahan untuk tugas penjanaan visual yang berbeza melalui ChatGPT. Soalan pengguna ialah arahan yang diterangkan dalam bahasa semula jadi, yang diterjemahkan ke dalam arahan yang boleh difahami oleh mesin melalui ChatGPT.

Visual ChatGPT melakukan perkara sedemikian. Jadi ia benar-benar bagus dari perspektif produk, tetapi tidak ada yang baru dari perspektif reka bentuk model. Oleh itu, model keseluruhan adalah "raksasa jahitan" dari perspektif model Tiada latihan model bersatu, menyebabkan tiada promosi bersama antara modaliti yang berbeza. Sebab kami melakukan pelbagai modaliti adalah kerana kami percaya bahawa data daripada modaliti yang berbeza mesti membantu antara satu sama lain. Dan Visual ChatGPT tidak menganggap arahan penjanaan pelbagai mod Penalaan halus arahannya hanya bergantung pada ChatGPT itu sendiri.

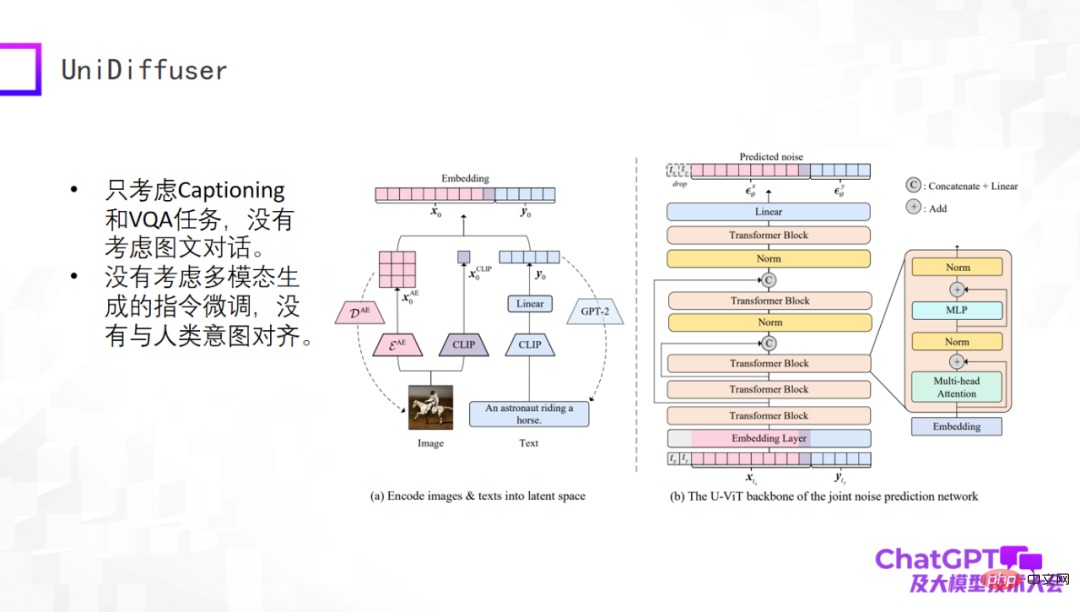

Contoh seterusnya ialah model UniDiffuser yang dikeluarkan oleh pasukan Profesor Zhu Jun di Universiti Tsinghua. Dari perspektif akademik, model ini benar-benar boleh menjana kandungan teks dan visual daripada input berbilang modal Ini disebabkan oleh seni bina rangkaian berasaskan pengubah U-ViT, yang serupa dengan U-Net, komponen teras Stable Diffusion, dan. kemudian menjana imej dan penjanaan teks disatukan dalam rangka kerja. Kerja ini sendiri sangat bermakna, tetapi ia masih agak awal Sebagai contoh, ia hanya mempertimbangkan tugasan Kapsyen dan VQA, tidak mempertimbangkan beberapa pusingan dialog dan tidak memperhalusi arahan untuk penjanaan berbilang modal.

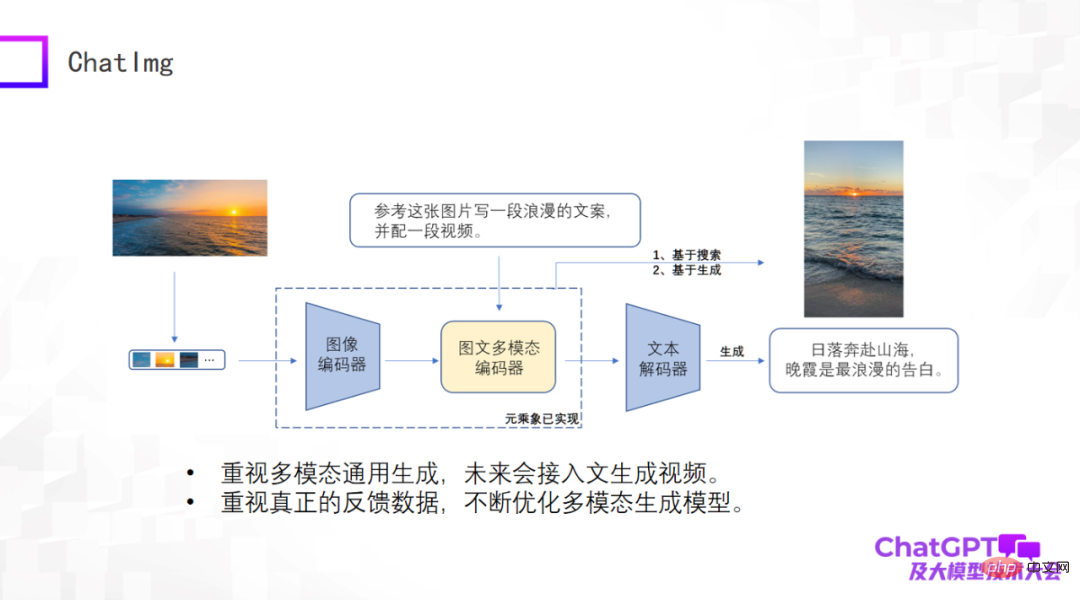

Setelah sekian banyak ulasan, kami juga membuat satu produk bernama ChatImg, seperti yang ditunjukkan dalam gambar di bawah. Secara umumnya, ChatImg termasuk pengekod imej, pengekod imej dan teks berbilang mod, dan penyahkod teks Ia serupa dengan Flamingo dan BLIP-2, tetapi kami mempertimbangkan lebih banyak, dan terdapat perbezaan terperinci dalam pelaksanaan khusus.

Salah satu kelebihan terbesar ChatImg ialah ia boleh menerima input video. Kami memberi perhatian khusus kepada penjanaan umum berbilang modal, termasuk penjanaan teks, penjanaan imej dan penjanaan video. Kami berharap dapat melaksanakan pelbagai tugas penjanaan dalam rangka kerja ini, dan akhirnya berharap dapat mengakses teks untuk menjana video.

Kedua, kami memberi perhatian khusus kepada data pengguna sebenar Kami berharap untuk terus mengoptimumkan model penjanaan itu sendiri dan meningkatkan keupayaannya selepas memperoleh data pengguna sebenar, jadi kami mengeluarkan aplikasi ChatImg.

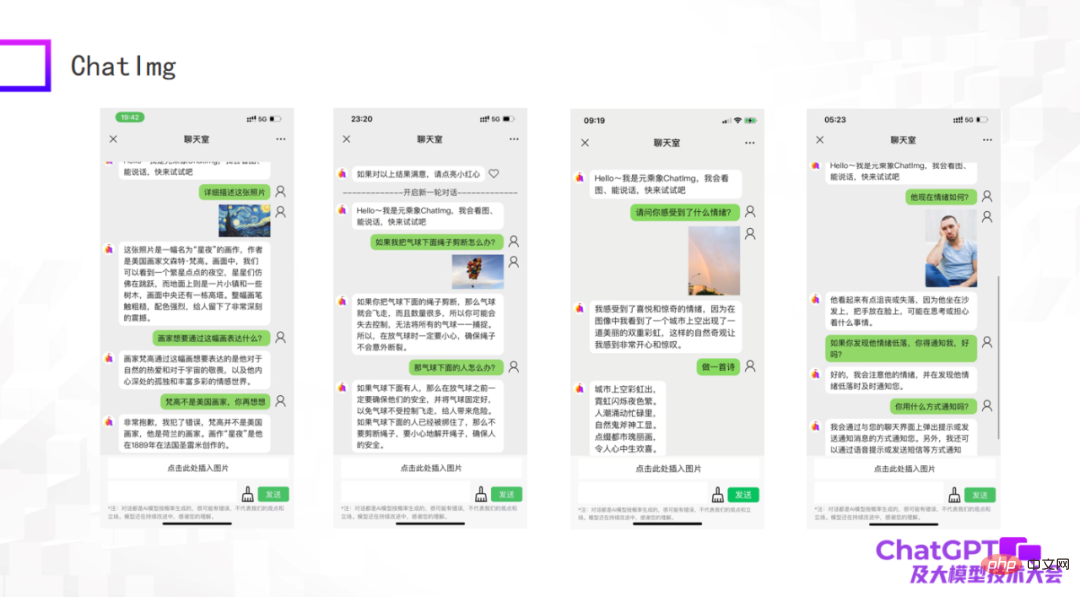

Gambar berikut adalah beberapa contoh ujian kami Sebagai model awal, walaupun masih terdapat beberapa perkara yang tidak dilakukan dengan baik, secara amnya ChatImg masih boleh memahami gambar tersebut. Contohnya, ChatImg boleh menjana penerangan lukisan dalam perbualan dan juga boleh melakukan beberapa pembelajaran dalam konteks.

Contoh pertama dalam gambar di atas menerangkan lukisan "Starry Night" Dalam keterangan, ChatImg mengatakan bahawa Van Gogh adalah seorang pelukis Amerika. Anda memberitahunya Salah, ia boleh dibetulkan serta-merta; contoh kedua ChatImg membuat kesimpulan fizikal tentang objek dalam gambar itu adalah foto yang saya ambil sendiri. Terdapat dua pelangi dalam foto ini, dan ia Dikenali dengan tepat.

Kami mendapati bahawa contoh ketiga dan keempat di atas melibatkan isu emosi. Ini sebenarnya berkaitan dengan kerja yang akan kami lakukan seterusnya Kami ingin menyambungkan ChatImg ke robot. Robot hari ini biasanya pasif, dan semua arahan telah ditetapkan, yang menjadikannya kelihatan sangat tegar. Kami berharap robot yang disambungkan kepada ChatImg boleh berkomunikasi secara aktif dengan orang ramai. Bagaimana untuk melakukan ini? Pertama sekali, robot mesti dapat merasakan orang Ia mungkin untuk melihat keadaan dunia dan emosi orang secara objektif, atau mungkin untuk mendapatkan refleksi barulah robot itu dapat memahami dan berkomunikasi secara aktif dengan orang. Melalui dua contoh ini, saya merasakan bahawa matlamat ini boleh dicapai.

Akhir sekali, izinkan saya meringkaskan laporan hari ini. Pertama sekali, ChatGPT dan GPT-4 telah membawa inovasi kepada paradigma penyelidikan. Kita semua harus menerima perubahan ini secara aktif untuk mengatasi kesukaran. Penyelidikan multimodal tidak memerlukan mesin dengan ratusan kad Selagi strategi yang sepadan diterima pakai, sebilangan kecil mesin boleh melakukan kerja yang baik. Kedua, model generatif multi-modal sedia ada semuanya mempunyai masalah sendiri GPT-4 belum mempunyai versi visual terbuka, dan masih ada peluang untuk kita semua. Lebih-lebih lagi, saya fikir GPT-4 masih mempunyai masalah, yang mana model generatif berbilang mod akhirnya sepatutnya kelihatan seperti itu tidak memberikan jawapan yang sempurna (sebenarnya, ia tidak mendedahkan sebarang butiran GPT-4). Ini sebenarnya satu perkara yang baik Orang di seluruh dunia sangat pintar dan setiap orang mempunyai idea mereka sendiri. Ini mungkin mewujudkan situasi penyelidikan baru di mana seratus bunga mekar. Sekian sahaja ucapan saya, terima kasih semua.

Atas ialah kandungan terperinci 'Lu Zhiwu, seorang penyelidik di Universiti Renmin China, mencadangkan kesan penting ChatGPT pada model generatif pelbagai mod'. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI