Rumah >Peranti teknologi >AI >Tugas biasa! Tsinghua mencadangkan Flowformer rangkaian tulang belakang untuk mencapai kerumitan linear |

Tugas biasa! Tsinghua mencadangkan Flowformer rangkaian tulang belakang untuk mencapai kerumitan linear |

- 王林ke hadapan

- 2023-04-16 19:25:011535semak imbas

Kesejagatan tugas ialah salah satu matlamat teras penyelidikan model asas, dan ia juga satu-satunya cara untuk penyelidikan pembelajaran mendalam membawa kepada kecerdasan lanjutan. Dalam beberapa tahun kebelakangan ini, terima kasih kepada keupayaan pemodelan utama universal mekanisme perhatian, Transformer telah menunjukkan prestasi yang baik dalam banyak bidang dan secara beransur-ansur menunjukkan trend seni bina universal. Walau bagaimanapun, apabila panjang jujukan bertambah, pengiraan mekanisme perhatian standard mempamerkan kerumitan kuadratik, yang secara serius menghalang penggunaannya dalam pemodelan jujukan panjang dan model besar.

Untuk tujuan ini, satu pasukan dari Pusat Pengajian Perisian, Universiti Tsinghua meneroka dengan mendalam isu utama ini dan mencadangkan Flowformer rangkaian tulang belakang kerumitan linear tugas-universal, sambil mengekalkan kepelbagaian standard Transformer Pada masa yang sama, kerumitannya dikurangkan kepada linear, dan kertas itu diterima oleh ICML 2022.

Senarai pengarang: Wu Haixu, Wu Jialong, Xu Jiehui, Wang Jianmin, Long Mingsheng

Pautan: https://arxiv.org/pdf/2202.06258.pdf

Kod: https://github. com/thuml/ Flowformer

Berbanding dengan Transformer standard, model Flowformer yang dicadangkan dalam artikel ini mempunyai ciri-ciri berikut:

- Kerumitan linear boleh mengendalikan jujukan input beribu-ribu panjang; mekanisme perhatian asal Keupayaan pemodelan;

- Tugas universal, mencapai kecemerlangan dalam lima tugas utama urutan panjang, penglihatan, bahasa semula jadi, siri masa dan pembelajaran pengukuhan Kesan.

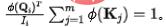

- 1. Analisis MasalahInput mekanisme perhatian standard mengandungi tiga bahagian: pertanyaan(), kunci() dan nilai(), dan kaedah pengiraannya Seperti berikut: di manakah matriks berat perhatian, dan keputusan pengiraan akhir akan diperolehi oleh gabungan berwajaran Kerumitan pengiraan proses di atas ialah. Adalah diperhatikan bahawa terdapat banyak kajian mengenai masalah pendaraban berterusan matriks multinomial dalam algoritma klasik. Khususnya, untuk mekanisme perhatian, kita boleh menggunakan undang-undang bersekutu pendaraban matriks untuk mencapai pengoptimuman, sebagai contoh, kerumitan kuadratik asal boleh dikurangkan kepada linear. Tetapi fungsi dalam mekanisme perhatian menjadikannya mustahil untuk menggunakan undang-undang bersekutu secara langsung. Oleh itu, cara mengalih keluar fungsi dalam mekanisme perhatian adalah kunci untuk mencapai kerumitan linear. Walau bagaimanapun, banyak kerja baru-baru ini telah menunjukkan bahawa fungsi memainkan peranan penting dalam mengelakkan pembelajaran perhatian yang remeh. Ringkasnya, kami menantikan penyelesaian reka bentuk model yang mencapai matlamat berikut: (1) mengalih keluar fungsi; (3) mengekalkan fleksibiliti model;

2. Motivasi

Mensasarkan matlamat (1), dalam kerja sebelumnya, kaedah kernel sering digunakan untuk menggantikan fungsi, iaitu melalui pengiraan perhatian anggaran (untuk fungsi bukan linear), tetapi mengalihkannya secara langsung akan menyebabkan perhatian remeh. Untuk tujuan ini, untuk matlamat (2), kerja sebelumnya terpaksa memperkenalkan beberapa pilihan induktif, yang mengehadkan kepelbagaian model

, dan oleh itu tidak memenuhi matlamat (3), seperti andaian lokaliti dalam cosFormer .Mekanisme persaingan dalam SoftmaxUntuk mencapai matlamat di atas, kita bermula dari sifat asas analisis. Kami ambil perhatian bahawa pada asalnya ia dicadangkan untuk melanjutkan operasi maksimum "pemenang-ambil-semua" ke dalam bentuk yang boleh dibezakan. Oleh itu, Terima kasih kepada mekanisme "persaingan" yang wujud, ia boleh membezakan pemberat perhatian antara token, dengan itu mengelakkan masalah perhatian biasa.

Berdasarkan pertimbangan di atas, kami cuba memperkenalkan mekanisme persaingan ke dalam reka bentuk mekanisme perhatian, untuk mengelakkan masalah perhatian remeh yang disebabkan oleh penguraian kaedah kernel.Mekanisme persaingan dalam aliran rangkaianKami memberi perhatian kepada model aliran rangkaian klasik (rangkaian aliran) dalam teori graf, "pemuliharaan"

( Pemuliharaan) adalah fenomena penting, iaitu, aliran masuk setiap nod adalah sama dengan aliran keluar. Diilhamkan oleh"Sumber tetap pasti akan menyebabkan persaingan"

, dalam artikel ini, kami cuba menganalisis semula aliran maklumat dalam mekanisme perhatian klasik dari perspektif aliran rangkaian, danmengubah persaingan melalui pemuliharaan sifat Memperkenalkan reka bentuk mekanisme perhatian untuk mengelakkan masalah perhatian biasa. 3. Flowformer3.1 Mekanisme perhatian dari perspektif aliran rangkaian

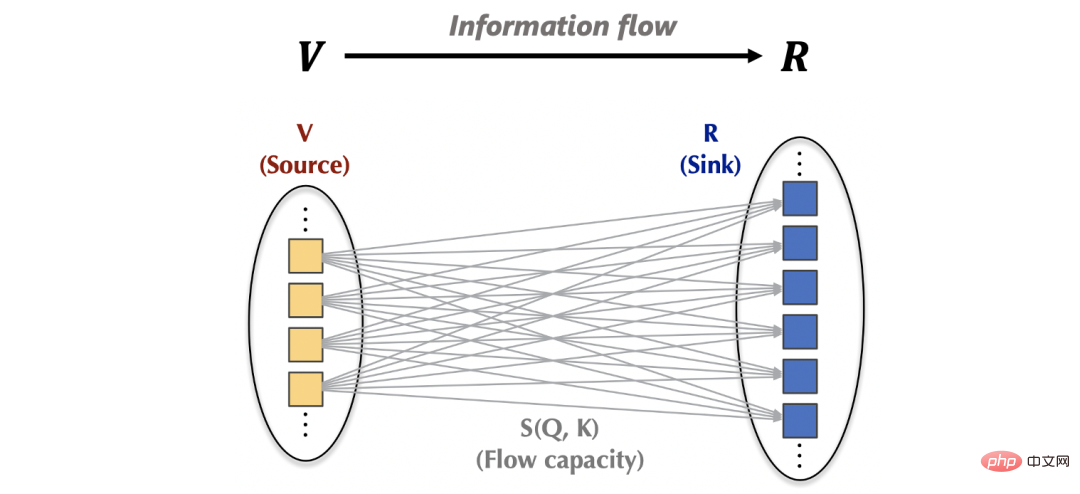

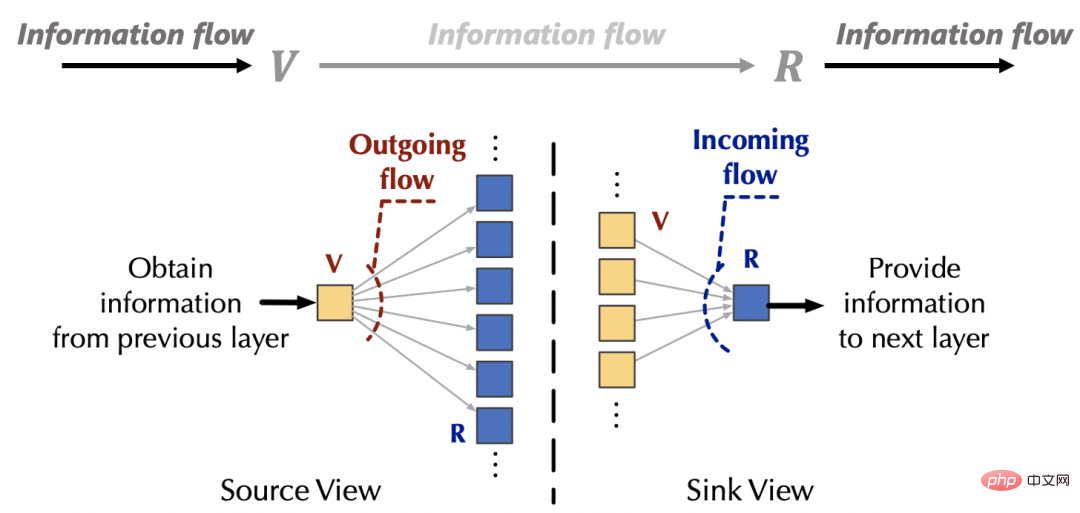

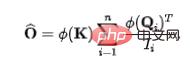

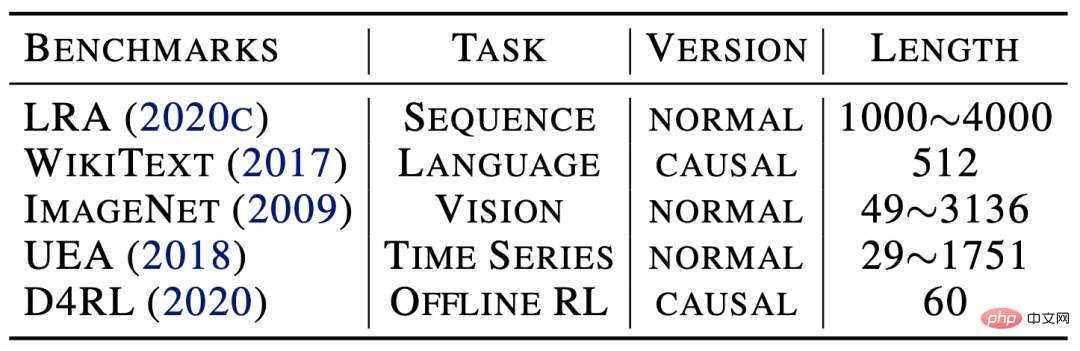

Di dalam mekanisme perhatian: aliran maklumat boleh dinyatakan sebagai: daripadaSumber

(sumber, sepadan) diagregatkan kepadatenggelam

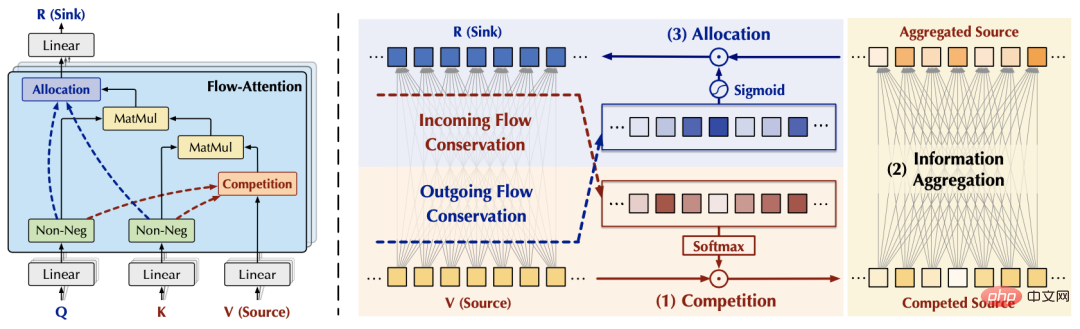

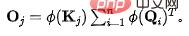

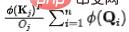

(sinki, sepadan) berdasarkan kapasiti aliran yang dipelajari (bersamaan dengan berat perhatian). Di luar mekanisme perhatian, maklumat sumber (v) datang dari lapisan atas rangkaian, dan maklumat sinki (R) juga akan disediakan ke lapisan suapan hadapan di bawah. Berdasarkan pemerhatian di atas, kita boleh lulus masing-masing daripada aliran masuk Daripada dua perspektif aliran dan aliran keluar, kami mengawal interaksi antara mekanisme perhatian dan rangkaian luaran untuk mencapai "sumber tetap" , dengan itu menyebabkan persaingan dalam sumber dan tenggelam masing-masing untuk mengelakkan perhatian biasa. Tanpa kehilangan keluasan, kami menetapkan jumlah maklumat interaksi antara mekanisme perhatian dan rangkaian luaran kepada nilai lalai 1. (1) Pemuliharaan aliran masuk sinki (R): tidak sukar diperolehi Sebelum pemuliharaan, untuk sinki ke, jumlah maklumat yang mengalir masuk ialah: Pada masa ini, disebabkan oleh pemuliharaan aliran masuk sinki, terdapat persaingan semula jadi antara pelbagai sumber (V) Hubungan, kami mengira jumlah maklumat yang diberikan oleh setiap sumber (V) pada masa ini, dan kami boleh mendapatkan: jumlah maklumat yang diberikan oleh setiap sumber di bawah keadaan persaingan, yang juga mewakili kepentingan setiap sumber. (2) Pemuliharaan aliran keluar dari punca (V): Sama seperti proses yang disebutkan di atas, sebelum pemuliharaan, untuk sumber pertama, jumlah maklumat yang mengalir daripadanya ialah: (3) Reka bentuk keseluruhan Berdasarkan keputusan di atas, kami mereka bentuk mekanisme Perhatian Aliran berikut, khususnya termasuk persaingan (Persaingan), pengagregatan (Agregasi), dan peruntukan (Peruntukan) tiga bahagian: Persaingan memperkenalkan mekanisme persaingan untuk menyerlahkan maklumat penting Pengagregatan merealisasikan kerumitan linear berdasarkan undang-undang bersekutu matriks memperkenalkan mekanisme persaingan dan memindahkan kawalan kepada; langkah seterusnya. Semua operasi dalam proses di atas mempunyai kerumitan linear. Pada masa yang sama, reka bentuk Aliran-Perhatian hanya bergantung pada prinsip pemuliharaan dalam aliran rangkaian dan menyepadukan semula aliran maklumat Oleh itu, ia tidak memperkenalkan keutamaan induktif baharu, memastikan kepelbagaian model. Flowformer diperoleh dengan menggantikan kerumitan kuadratik Attention dalam Transformer standard dengan Flow-Attention. Kertas kerja ini menjalankan eksperimen yang meluas pada set data standard: Seperti yang ditunjukkan dalam jadual di bawah, Flowformer melakukan dengan baik pada semua lima tugas utama, mengesahkan kepelbagaian model. Sila lihat kertas untuk keputusan percubaan terperinci.

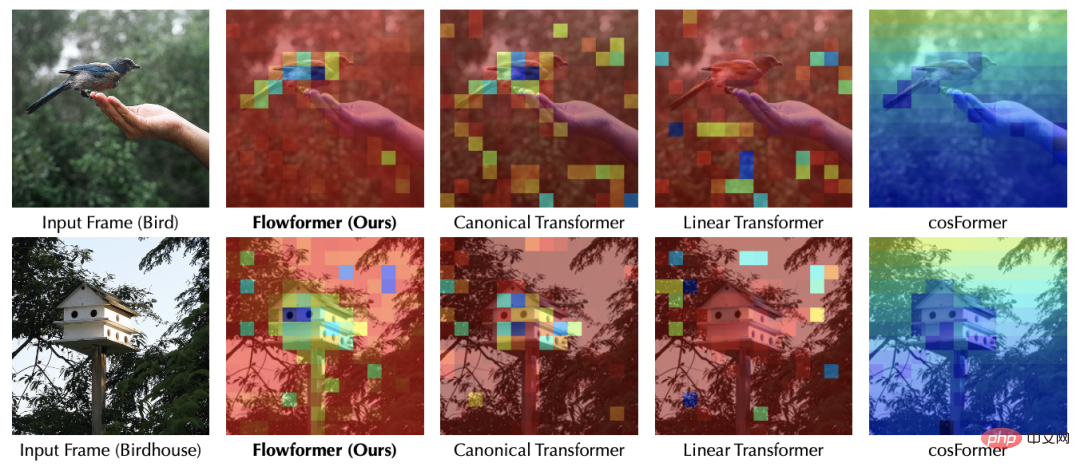

Untuk menerangkan lebih lanjut prinsip kerja Flowformer, kami menjalankan eksperimen visual mengenai perhatian (bersamaan dengan Flow-Attention) dalam tugas pengelasan ImageNet, yang mana kami boleh cari: Flowformer yang dicadangkan dalam artikel ini memperkenalkan prinsip pemuliharaan dalam aliran rangkaian ke dalam reka bentuk, dan secara semula jadi memperkenalkan mekanisme persaingan ke dalam pengiraan perhatian, dengan berkesan. mengelak Ia menyelesaikan masalah perhatian yang remeh dan mengekalkan fleksibiliti Transformer standard sambil mencapai kerumitan linear. Flowformer telah mencapai keputusan cemerlang dalam lima tugas utama: jujukan panjang, penglihatan, bahasa semula jadi, siri masa dan pembelajaran pengukuhan

3.2 Aliran-Perhatian

. Untuk menetapkan jumlah maklumat yang mengalir ke setiap sinki kepada unit 1, kami memperkenalkan

. Untuk menetapkan jumlah maklumat yang mengalir ke setiap sinki kepada unit 1, kami memperkenalkan  sebagai penormalan ke dalam pengiraan aliran maklumat (berat perhatian). Selepas penormalan, jumlah maklumat aliran masuk sinki ke adalah:

sebagai penormalan ke dalam pengiraan aliran maklumat (berat perhatian). Selepas penormalan, jumlah maklumat aliran masuk sinki ke adalah:

. Untuk menetapkan jumlah maklumat yang mengalir keluar dari setiap sumber kepada unit 1, kami akan memperkenalkan pengiraan aliran maklumat (berat perhatian) sebagai normalisasi. Selepas penormalan, jumlah maklumat aliran keluar daripada sumber ke-j ialah:

. Untuk menetapkan jumlah maklumat yang mengalir keluar dari setiap sumber kepada unit 1, kami akan memperkenalkan pengiraan aliran maklumat (berat perhatian) sebagai normalisasi. Selepas penormalan, jumlah maklumat aliran keluar daripada sumber ke-j ialah:  . Pada masa ini, disebabkan oleh pemuliharaan aliran keluar dari sumber, terdapat hubungan persaingan semula jadi antara singki () Kami mengira jumlah maklumat yang diterima oleh setiap sinki () pada masa ini, dan kami boleh mendapatkan: Dalam kes itu pertandingan, keputusan akhir yang diperlukan untuk setiap keputusan ialah Jumlah maklumat yang diterima.

. Pada masa ini, disebabkan oleh pemuliharaan aliran keluar dari sumber, terdapat hubungan persaingan semula jadi antara singki () Kami mengira jumlah maklumat yang diterima oleh setiap sinki () pada masa ini, dan kami boleh mendapatkan: Dalam kes itu pertandingan, keputusan akhir yang diperlukan untuk setiap keputusan ialah Jumlah maklumat yang diterima. 4 Eksperimen

5. Analisis

6 Ringkasan

6 Ringkasan

Atas ialah kandungan terperinci Tugas biasa! Tsinghua mencadangkan Flowformer rangkaian tulang belakang untuk mencapai kerumitan linear |. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI