Rumah >Peranti teknologi >AI >Bapa LSTM sekali lagi mencabar LeCun: Lima mata 'inovasi' anda semuanya ditiru daripada saya! Tetapi malangnya, 'Saya tidak dapat membacanya kembali'

Bapa LSTM sekali lagi mencabar LeCun: Lima mata 'inovasi' anda semuanya ditiru daripada saya! Tetapi malangnya, 'Saya tidak dapat membacanya kembali'

- 王林ke hadapan

- 2023-04-16 10:04:021077semak imbas

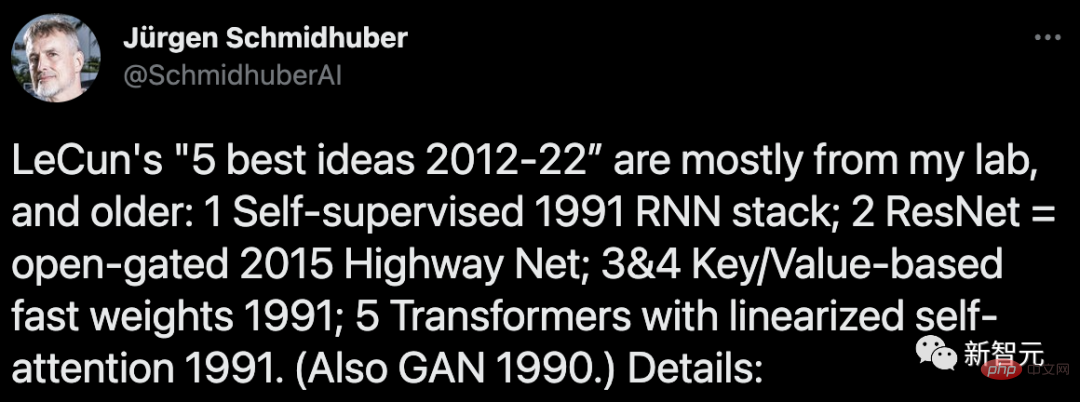

Baru-baru ini, Jürgen Schmidhuber, bapa LSTM, berselisih faham dengan LeCun sekali lagi!

Malah, pelajar yang mengenali lelaki pemarah ini sebelum ini mengetahui bahawa terdapat pengalaman yang tidak menyenangkan antara Jürgen Schmidhuber yang hebat dan beberapa nama besar dalam komuniti pembelajaran mesin.

Terutama apabila "tiga orang itu" memenangi Anugerah Turing bersama-sama, tetapi Schmidhuber tidak, lelaki tua itu bertambah marah...

Lagipun, Schmidhuber sentiasa percaya bahawa pemimpin ML semasa ini, seperti Bengio, Hinton, LeCun, termasuk bapa kepada "GAN" Goodfellow dan lain-lain, banyak daripada apa yang dipanggil "pencapaian perintis" mereka pertama kali dicadangkan olehnya. keluar, dan orang-orang ini tidak menyebut dia sama sekali dalam kertas itu.

Atas sebab ini, Schmidhuber pernah menulis artikel khas untuk mengkritik artikel ulasan "Deep Learning" yang diterbitkan oleh Bengio, Hinton, dan LeCun in Nature pada tahun 2015.

Terutamanya bercakap tentang keputusan dalam artikel ini, perkara mana yang disebut dahulu olehnya, dan perkara mana yang disebut dahulu oleh senior yang lain, bukan tiga pengarang yang menyebutnya pertama.

Kenapa awak bertengkar lagi?

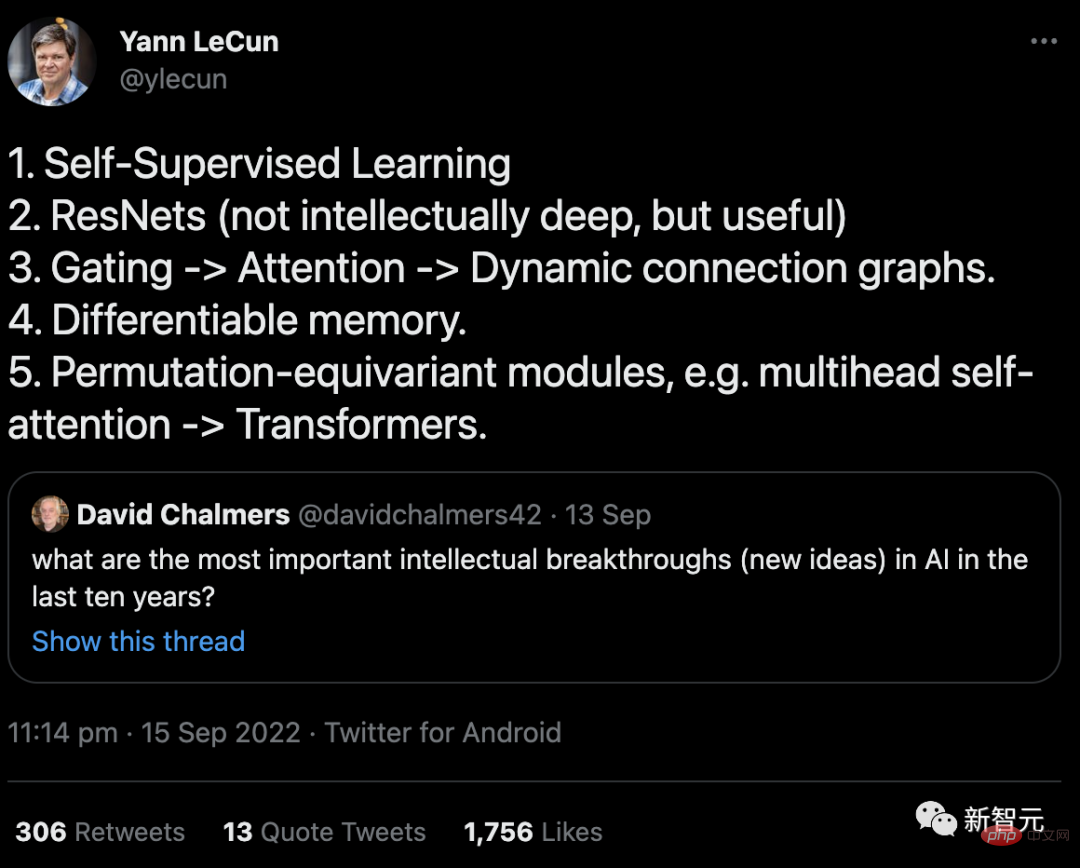

Berbalik kepada punca kejadian ini, ia sebenarnya tweet yang dihantar oleh LeCun pada bulan September.

Kandungannya adalah jawapan kepada soalan Profesor David Chalmers: "Apakah penemuan intelektual (idea baharu) yang paling penting dalam AI dalam sepuluh tahun yang lalu?" >

Dalam artikel itu, Schmidhuber menyenaraikan enam bukti secara terperinci untuk menyokong hujahnya.

Namun, berbanding kali terakhir, yang merupakan pertengkaran yang agak hangat, LeCun langsung tidak menghiraukannya kali ini...

1 "Pembelajaran kendiri" yang menjana label secara automatik rangkaian saraf (NN): Kembali sekurang-kurangnya kepada kerja saya pada tahun 1990-91.

(I) Penjanaan sasaran yang diselia sendiri dalam rangkaian saraf berulang (RNN) melalui pengekodan ramalan untuk belajar memampatkan jujukan data pada skala masa berbilang dan tahap abstraksi.Di sini, RNN "automaton" mempelajari pra-tugas "meramal input seterusnya" dan menyasarkan pemerhatian yang tidak dijangka dalam aliran data masuk ke mesin blok "penganalisis" RNN, yang mempelajari keteraturan peringkat lebih tinggi dan seterusnya memperhalusi pengetahuan ramalan yang diperolehnya kembali menjadi automasi melalui objektif latihan yang sesuai.

Ini sangat memudahkan tugasan pembelajaran mendalam hiliran klasifikasi jujukan yang sebelum ini tidak dapat diselesaikan.

Tetapi, perkataan ini juga digunakan dalam makalah terdahulu (1978)...

2. "ResNets": sebenarnya adalah Highway Nets yang saya cadangkan awal-awal lagi. Tetapi LeCun berpendapat bahawa kecerdasan ResNets adalah "tidak mendalam", yang membuatkan saya sangat sedih.

Sebelum saya mencadangkan Highway Nets, rangkaian suapan hadapan hanya mempunyai beberapa dozen lapisan (20-30 lapisan) paling banyak, dan Highway Nets ialah rangkaian neural suapan hadapan yang benar-benar mendalam yang pertama, dengan Beratus-ratus lapisan.

Pada tahun 1990-an, LSTM saya membawa kedalaman yang tidak terhingga kepada NN rekursif yang diawasi. Pada tahun 2000-an, Highway Nets yang diilhamkan oleh LSTM membawa kedalaman kepada NN suapan.

Hasilnya, LSTM telah menjadi NN yang paling banyak disebut pada abad ke-20, dan Highway Nets (ResNet) ialah NN yang paling banyak disebut dalam abad ke-21.

Boleh dikatakan bahawa mereka mewakili intipati pembelajaran mendalam, dan pembelajaran mendalam adalah mengenai kedalaman NN.

3 "Gating->Perhatian->Graf Bersambung Dinamik": Sekurang-kurangnya ia kembali kepada Pengaturcara dan Kunci Fast Weight saya dari 1991-93 -Nilai Rangkaian Memori ("Key-Nilai" dipanggil "DARI-KEPADA").

Pada tahun 1993, saya memperkenalkan istilah "perhatian" seperti yang kita gunakan hari ini.

Walau bagaimanapun, perlu diperhatikan bahawa gerbang pendaraban pertama di NN boleh dikesan kembali ke mesin pembelajaran mendalam Ivakhnenko & Lapa pada tahun 1965.

4. "Memori yang boleh dibezakan": Ia juga boleh dikesan kembali ke Fast Weight Programmer atau Key-Value Memory Networks pada tahun 1991.

Asingkan storan dan kawalan seperti dalam komputer tradisional, tetapi dengan cara pembezaan hujung ke hujung, penyesuaian, saraf sepenuhnya (bukannya dengan cara hibrid).

5 "Penggantian modul setara, seperti multi-head self-attention->Transformer": Saya menerbitkannya pada tahun 1991 Transformer dengan perhatian diri yang linear. Istilah yang sepadan "lampu sorot perhatian dalaman" bermula pada tahun 1993.

6 "GAN ialah konsep pembelajaran mesin terbaik dalam tempoh 10 tahun yang lalu"

Anda menyebut The. prinsip GAN (2014) ini sebenarnya dicadangkan oleh saya pada tahun 1990 atas nama rasa ingin tahu kecerdasan buatan.

Kali terakhir adalah beberapa bulan yang lalu

Sebenarnya, ini tidak lagi berlaku antara Schmidhuber dan LeCun Terdapat pertikaian buat kali pertama tahun ini.

Pada bulan Jun dan Julai, kedua-duanya bergaduh bolak-balik mengenai laporan tinjauan mengenai "Arah Masa Depan Perisikan Mesin Autonomi" yang diterbitkan oleh LeCun.

Pada 27 Jun, Yann LeCun menerbitkan kertas kerja "A Path Towards Autonomous Machine Intelligence" yang telah disimpannya selama beberapa tahun, memanggilnya sebagai "karya yang menunjukkan arah pembangunan masa depan daripada AI."

Kertas kerja ini secara sistematik membincangkan isu "bagaimana mesin boleh belajar seperti haiwan dan manusia" dan panjangnya lebih daripada 60 muka surat.

LeCun berkata bahawa artikel ini bukan sahaja pemikirannya tentang hala tuju umum pembangunan AI dalam 5-10 tahun akan datang, tetapi juga apa yang dia rancang untuk menyelidik dalam beberapa tahun akan datang, dan berharap dapat memberi inspirasi kepada komuniti AI lebih ramai datang untuk belajar bersama.

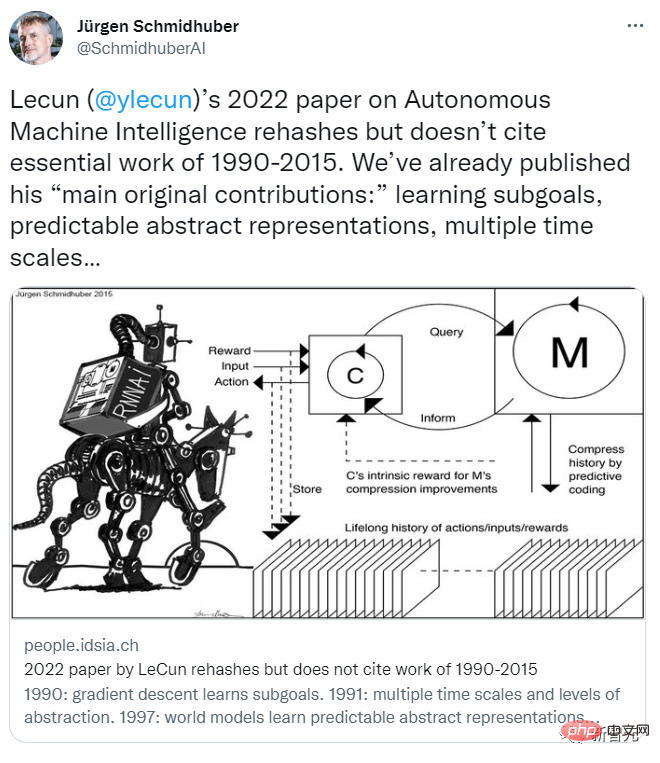

Dan Schmidhuber mengetahui tentang berita itu kira-kira sepuluh hari lebih awal, mendapat kertas itu dan segera menulis artikel untuk menyangkalnya.

Menurut catatan blog Schmidhuber sendiri, inilah yang berlaku pada masa itu:

Pada 14 Jun 2022, sebuah media sains mengeluarkan berita bahawa LeCun akan mengeluarkan laporan pada 27 Jun, dan menghantar draf laporan itu kepada saya (ia masih dalam tempoh kerahsiaan pada masa itu), dan saya diminta mengulas.

Saya menulis ulasan memberitahu mereka bahawa ini pada asasnya adalah replika kerja kami sebelum ini, yang tidak disebut dalam artikel LeCun.

Walau bagaimanapun, pendapat saya tidak didengari.

Malah, lama sebelum artikelnya diterbitkan, kami telah mencadangkan apa yang dipanggil "sumbangan asal utama" LeCun dalam kebanyakan artikel ini kandungan terutamanya termasuk:

(1) "Seni bina kognitif, di mana semua modul boleh diasingkan dan banyak modul boleh dilatih" (kami mencadangkannya pada tahun 1990).

(2) "Ramalkan struktur hierarki model dunia, perwakilan pembelajaran pada tahap abstraksi berbilang dan skala masa berbilang" (yang dicadangkan oleh kami pada 1991).

(3) "Paradigma pembelajaran penyeliaan kendiri yang menghasilkan perwakilan yang bermaklumat dan boleh diramal" (model kami telah digunakan dalam pembelajaran pengukuhan dan pembinaan dunia sejak 1997 Diubah suai)

(4) Model ramalan "untuk perancangan hierarki di bawah ketidakpastian", termasuk penjana submatlamat saraf berasaskan kecerunan (1990), konsep abstrak Penaakulan spatial (1997), rangkaian saraf yang "belajar bertindak terutamanya melalui pemerhatian” (2015), dan belajar berfikir (2015) semuanya dicadangkan oleh kami dahulu.

Pada 14 Julai, Yann LeCun menjawab, mengatakan bahawa perbincangan itu harus membina Dia berkata begini:

Saya tidak mahu. masuk ke dalam situasi. Dalam perdebatan sia-sia tentang "siapa yang mencipta konsep tertentu", anda tidak mahu menyelidiki 160 rujukan yang disenaraikan dalam artikel respons anda. Saya rasa pendekatan yang lebih membina ialah mengenal pasti 4 penerbitan yang anda fikir mungkin mengandungi idea dan kaedah daripada 4 sumbangan yang saya senaraikan.

Seperti yang saya katakan di awal makalah, terdapat banyak konsep yang telah wujud sejak sekian lama dan bukan anda mahupun saya penciptanya: contohnya, konsep model dunia yang boleh ditala halus, yang boleh dikesan kembali kepada kerja kawalan pengoptimuman awal.

Melatih model dunia menggunakan rangkaian saraf untuk mempelajari pengenalpastian sistem model dunia Idea ini boleh dikesan kembali ke akhir 1980-an, oleh Michael Jordan, Bernie Widrow, Robinson & Fallsside, Kumpathi Narendra, Paul Werbos Kerja yang dilakukan mendahului kerja anda.

Pada pendapat saya, jawapan lelaki jerami ini seolah-olah LeCun mengubah topik dan mengelakkan isu mengambil kredit untuk orang lain dalam apa yang dipanggil "sumbangan asal utama" beliau.

Saya menjawab pada 14 Julai:

Mengenai perkara yang anda katakan tentang "sesuatu yang tidak anda atau saya cipta": tuntutan kertas anda, menggunakan saraf rangkaian untuk pengenalan sistem boleh dikesan kembali ke awal 1990-an. Walau bagaimanapun, dalam respons anda sebelum ini anda nampaknya bersetuju dengan saya bahawa kertas pertama mengenai perkara ini muncul pada tahun 1980-an.

Bagi "sumbangan asal utama" anda, mereka sebenarnya menggunakan hasil kerja awal saya.

(1) Mengenai "seni bina kognitif di mana semua modul boleh dibezakan dan banyak modul boleh dilatih" yang anda cadangkan, "melalui motivasi intrinsik Tingkah laku pemanduan":

Saya mencadangkan seni bina yang boleh dibezakan untuk pembelajaran dan perancangan dalam talian pada tahun 1990. Ini adalah kawalan pertama dengan "motivasi intrinsik" Ia digunakan untuk menambah baik model dunia, yang bersifat generatif dan menentang ; GAN 2014 yang dipetik dalam artikel anda ialah versi terbitan model ini.

(2) Mengenai cadangan "struktur hierarki model dunia ramalan yang mempelajari perwakilan pada pelbagai peringkat abstraksi dan skala masa":

Ini dimungkinkan oleh Pemampat Sejarah Neural 1991 saya. Ia menggunakan pengekodan ramalan untuk mempelajari perwakilan dalaman hierarki bagi data jujukan panjang dengan cara yang diselia sendiri, dengan sangat memudahkan pembelajaran hiliran. Menggunakan prosedur penghalusan rangkaian saraf 1991 saya, perwakilan ini boleh diruntuhkan menjadi satu rangkaian saraf berulang (RNN).

(3) Mengenai "paradigma pembelajaran penyeliaan sendiri yang terkawal, menghasilkan perwakilan yang bermaklumat dan boleh diramal":

Ini mata telah dibuat dalam sistem yang saya cadangkan untuk dibina pada tahun 1997. Daripada meramalkan semua butiran input masa hadapan, ia boleh bertanya soalan abstrak sewenang-wenangnya dan memberikan jawapan yang boleh dikira dalam apa yang anda panggil "ruang perwakilan." Dalam sistem ini, dua model pembelajaran yang dipanggil "otak kiri" dan "otak kanan" memilih lawan dengan ganjaran maksimum untuk terlibat dalam permainan jumlah sifar, dan kadangkala bertaruh pada keputusan eksperimen pengiraan tersebut.

(4) Berkenaan model boleh beza ramalan perancangan hierarki anda yang boleh digunakan di bawah ketidakpastian, artikel anda menyatakan begini:

"Satu soalan yang belum dijawab ialah bagaimana konfigurator belajar untuk menguraikan tugas yang kompleks kepada satu siri sub-matlamat yang boleh diselesaikan oleh ejen sahaja. Saya akan menyerahkan soalan ini kepada masa hadapan "

Jangan bercakap tentang masa depan Malah, saya telah menerbitkan artikel ini lebih daripada 30 tahun yang lalu:

A Rangkaian saraf pengawal bertanggungjawab untuk mendapatkan input arahan tambahan dalam. bentuk (mula, sasaran). Rangkaian saraf penganggar bertanggungjawab untuk belajar meramalkan kos yang dijangkakan dari awal hingga matlamat. Penjana submatlamat berdasarkan rangkaian saraf berulang yang boleh ditala halus melihat input (permulaan, matlamat) ini dan mempelajari urutan submatlamat perantaraan kos minimum melalui keturunan kecerunan menggunakan rangkaian saraf penganggar.

(5) Anda juga menekankan rangkaian saraf yang "mempelajari tingkah laku terutamanya melalui pemerhatian." Kami sebenarnya menyelesaikan masalah ini sangat awal, dalam artikel 2015 ini, membincangkan masalah umum pembelajaran pengukuhan (RL) dalam persekitaran yang boleh diperhatikan separa.

Model dunia M mungkin pandai meramal beberapa perkara tetapi tidak pasti tentang yang lain. Pengawal C memaksimumkan fungsi objektifnya dengan belajar menanya dan mentafsir jawapan (lebih banyak corak pengaktifan) melalui urutan soalan ciptaan sendiri (corak pengaktifan).

C boleh mendapat manfaat daripada pembelajaran mengekstrak sebarang jenis maklumat algoritma daripada M, seperti untuk perancangan dan penaakulan hierarki, memanfaatkan pemerhatian pasif yang dikodkan dalam M, dsb.

Atas ialah kandungan terperinci Bapa LSTM sekali lagi mencabar LeCun: Lima mata 'inovasi' anda semuanya ditiru daripada saya! Tetapi malangnya, 'Saya tidak dapat membacanya kembali'. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI