Rumah >Peranti teknologi >AI >GPU boleh menghasilkan model 3D dalam beberapa saat! Kerja baharu OpenAI: Point-E boleh menjana model awan titik 3D menggunakan teks

GPU boleh menghasilkan model 3D dalam beberapa saat! Kerja baharu OpenAI: Point-E boleh menjana model awan titik 3D menggunakan teks

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-15 08:58:02972semak imbas

Di manakah kejayaan seterusnya yang akan membawa dunia AI dengan ribut?

Ramai orang meramalkan bahawa ia adalah penjana model 3D.

Selepas DALL-E 2 dilancarkan pada awal tahun mengejutkan semua orang dengan berus geniusnya, OpenAI mengeluarkan model penjanaan imej terbaharunya "POINT-E" pada hari Selasa, yang boleh menjana 3D terus daripada Model teks.

Pautan kertas: https://arxiv.org/pdf/2212.08751.pdf

Berbanding dengan pesaing (seperti DreamFusion Google) yang memerlukan beberapa GPU untuk berfungsi selama beberapa jam, POINT-E boleh menjana imej 3D dalam beberapa minit dengan hanya satu GPU.

Selepas ujian sebenar oleh editor, POINT-E pada asasnya boleh mengeluarkan imej 3D dalam beberapa saat selepas input segera Selain itu, imej output juga menyokong pengeditan tersuai, menyimpan dan fungsi lain.

Alamat: https://huggingface.co/spaces/openai/point-e

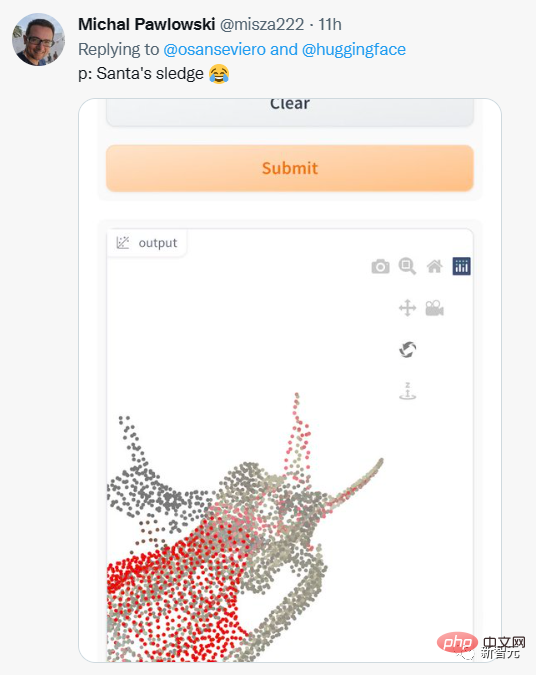

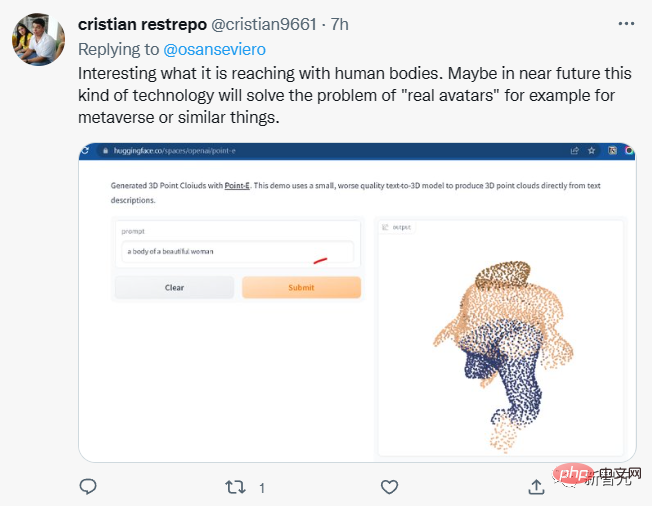

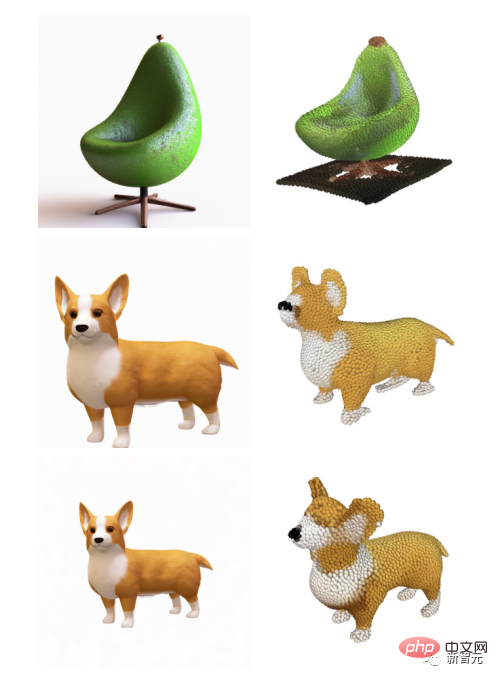

Netizen juga mula mencuba input segera yang berbeza.

Tetapi hasil output tidak selalunya memuaskan.

Sesetengah netizen berkata bahawa POINT-E mungkin dapat merealisasikan visi metaverse Meta?

Perlu diambil perhatian bahawa POINT-E menjana imej 3D melalui awan titik, iaitu set data titik dalam angkasa .

Ringkasnya, ia adalah untuk mengumpul data melalui model tiga dimensi untuk mendapatkan data awan titik yang mewakili bentuk 3D di angkasa.

Dari perspektif pengiraan, awan titik lebih mudah untuk disintesis, tetapi ia tidak dapat menangkap bentuk atau tekstur objek yang halus, yang berlaku pada masa ini dengan Point- A kekurangan E.

Untuk menangani had ini, pasukan Point-E melatih sistem kecerdasan buatan tambahan untuk menukar awan titik Point-E menjadi jerat.

Tukar titik awan Point-E kepada mesh

dalam Selain itu kepada model penjanaan jejaring bebas, Point-E terdiri daripada dua model:

Model teks-ke-imej (model teks-ke-imej) dan model 3D penukaran imej (imej -ke-model 3D).

Model penukaran teks ke imej adalah serupa dengan DALL-E 2 dan Stable Diffusion OpenAI, dilatih pada imej berlabel untuk memahami perkaitan antara perkataan dan konsep visual.

Satu set imej berpasangan dengan objek 3D kemudiannya dimasukkan ke dalam model transformasi 3D supaya model belajar untuk mengubah secara cekap antara kedua-duanya.

Apabila gesaan dimasukkan, model penukaran teks kepada imej menghasilkan objek pemaparan sintetik, yang disalurkan kepada model 3D penukaran imej kepada imej, yang kemudiannya menghasilkan awan titik.

Penyelidik OpenAI berkata Point-E telah dilatih pada set data berjuta-juta objek 3D dan metadata yang berkaitan.

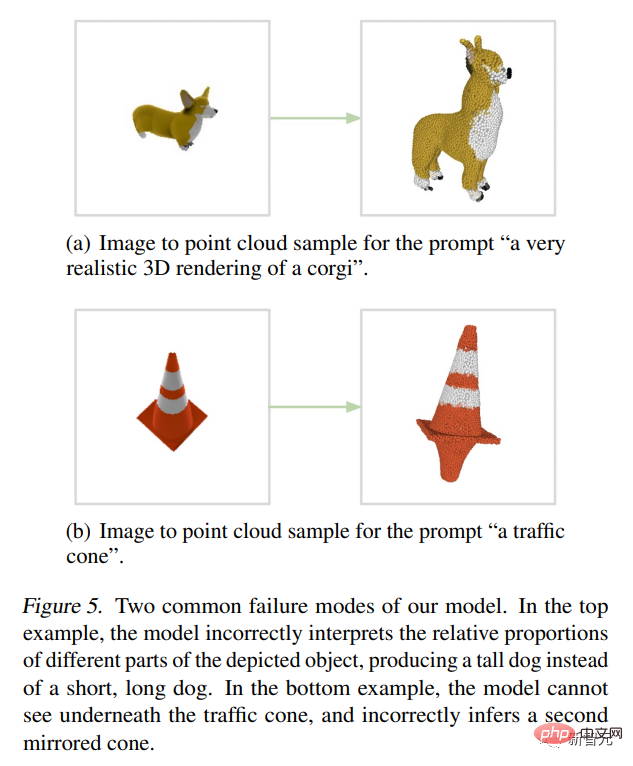

Tetapi ia tidak sempurna, model imej-ke-3D Point-E kadangkala gagal memahami imej dalam model teks-ke-imej, mengakibatkan bentuk yang tidak sepadan dengan teks petunjuk. Namun begitu, ia lebih pantas berbanding teknologi terkini yang terkini.

Mereka menulis dalam kertas:

Walaupun kaedah kami berprestasi lebih teruk daripada yang terkini dalam penilaian, ia hanya Sampel dijana dalam sebahagian kecil masa. Ini boleh menjadikannya lebih praktikal untuk aplikasi tertentu dan menemui objek 3D berkualiti tinggi.

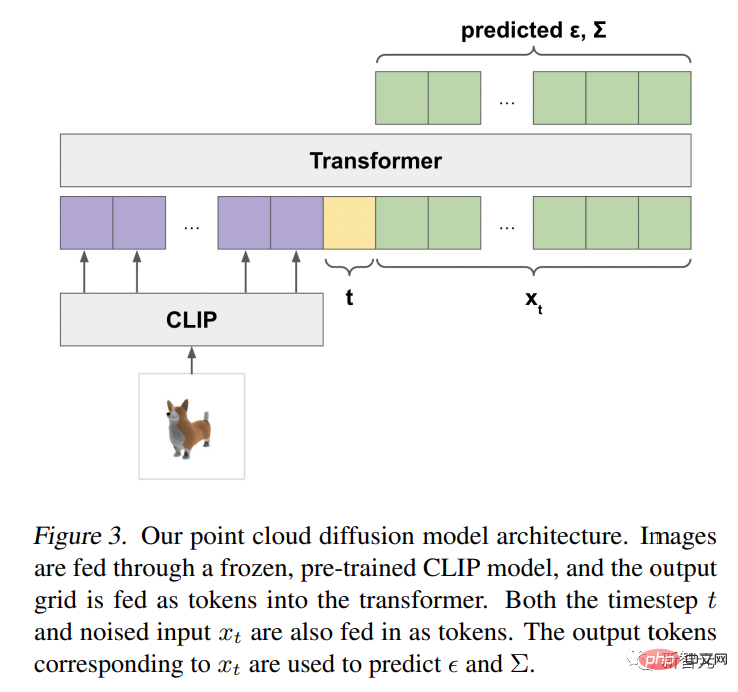

Seni bina Point-E dan mekanisme pengendalian

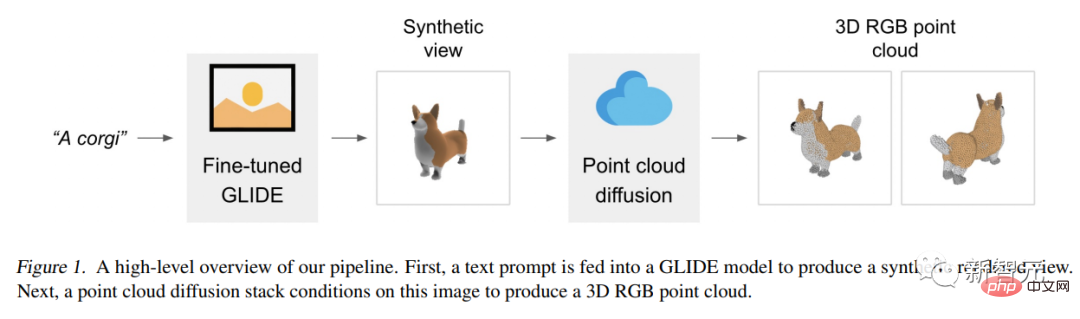

Model Point-E mula-mula menggunakan model resapan teks-ke-imej untuk menghasilkan paparan sintetik tunggal, dan kemudian menggunakan resapan kedua Model menghasilkan awan titik 3D yang dikondisikan pada imej yang dijana.

Walaupun kaedah ini masih belum tercanggih dari segi kualiti pensampelan, ia adalah satu hingga dua urutan magnitud lebih pantas, memberikan pertukaran praktikal untuk beberapa kegunaan kes.

Gambar berikut ialah gambarajah saluran paip peringkat tinggi model:

Kami bukan latihan Model generatif tunggal secara langsung menjana awan titik yang dikondisikan pada teks, tetapi sebaliknya membahagikan proses penjanaan kepada tiga langkah.

Mula-mula, hasilkan paparan komprehensif yang dikondisikan pada tajuk teks.

Seterusnya, hasilkan awan titik kasar (1,024 mata) berdasarkan paparan sintetik.

Akhir sekali, awan titik halus (4,096 mata) dikondisikan pada awan titik resolusi rendah dan paparan sintetik telah dihasilkan.

Selepas melatih model berjuta-juta model 3D, kami mendapati bahawa format data dan kualiti set data sangat berbeza-beza, yang membawa kami membangunkan pelbagai langkah pasca pemprosesan untuk memastikan data yang lebih tinggi kualiti.

Untuk menukar semua data ke dalam format biasa, kami menggunakan Blender untuk menjadikan setiap model 3D menjadi imej RGBAD dari 20 sudut kamera rawak (Blender menyokong berbilang format 3D , dengan enjin rendering yang dioptimumkan).

Untuk setiap model, skrip Blender menormalkan model menjadi kiub terikat, mengkonfigurasi tetapan pencahayaan standard dan akhirnya mengeksport imej RGBAD menggunakan enjin pemaparan masa nyata terbina dalam Blender.

Kemudian, gunakan Render untuk menukar setiap objek menjadi awan titik berwarna. Pertama, awan titik padat dibina untuk setiap objek dengan mengira titik untuk setiap piksel dalam setiap imej RGBAD. Awan titik ini biasanya mengandungi ratusan ribu mata taburan yang tidak sekata, jadi kami juga menggunakan pensampelan titik terjauh untuk mencipta awan titik 4K yang seragam.

Dengan membina awan titik terus daripada pemaparan, kami dapat mengelakkan pelbagai isu yang boleh timbul dengan pensampelan terus daripada jaringan 3D, titik persampelan yang terkandung dalam model atau memprosesnya dengan cara yang tidak Format fail biasa untuk menyimpan model 3D.

Akhir sekali, kami menggunakan pelbagai heuristik untuk mengurangkan kekerapan model berkualiti rendah dalam set data kami.

Mula-mula, kami menghapuskan objek satah dengan mengira SVD bagi setiap awan titik, mengekalkan hanya objek yang mempunyai nilai tunggal minimum lebih tinggi daripada ambang tertentu.

Seterusnya, kami mengumpulkan set data mengikut ciri CLIP (untuk setiap objek, kami purata ciri merentas semua pemaparan).

Kami mendapati bahawa sesetengah kelompok mengandungi banyak kategori model berkualiti rendah, manakala kelompok lain kelihatan lebih pelbagai atau boleh ditafsir.

Kami membahagikan kluster ini kepada beberapa baldi kualiti berbeza dan menggunakan campuran berwajaran baldi yang terhasil sebagai set data terakhir kami.

Prospek Permohonan

Penyelidik OpenAI menegaskan bahawa awan titik Point-E juga boleh digunakan untuk mencipta objek dunia sebenar, seperti percetakan 3D.

Dengan model penukaran mesh tambahan, sistem juga boleh memasuki aliran kerja pembangunan permainan dan animasi.

Walaupun semua mata kini tertumpu pada penjana seni 2D, sintesis model AI boleh menjadi pengganggu industri besar seterusnya.

Model 3D digunakan secara meluas dalam filem dan televisyen, reka bentuk dalaman, seni bina dan pelbagai bidang saintifik.

Pada masa ini, pembuatan model 3D biasanya mengambil masa beberapa jam, dan kemunculan Point-E hanya menggantikan kekurangan ini.

Penyelidik mengatakan bahawa Point-E masih mempunyai banyak kelemahan pada peringkat ini, seperti berat sebelah yang diwarisi daripada data latihan dan kekurangan langkah perlindungan untuk model yang mungkin digunakan untuk mencipta objek berbahaya.

Point-E hanyalah titik permulaan, dan mereka berharap ia akan memberi inspirasi kepada "kerja selanjutnya" dalam bidang sintesis teks-ke-3D.

Atas ialah kandungan terperinci GPU boleh menghasilkan model 3D dalam beberapa saat! Kerja baharu OpenAI: Point-E boleh menjana model awan titik 3D menggunakan teks. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI