Rumah >Peranti teknologi >AI >Mengapa pemantauan diri berkesan? Tesis kedoktoran Princeton setebal 243 halaman 'Memahami Pembelajaran Perwakilan Seliaan Sendiri' menerangkan secara menyeluruh tiga jenis kaedah: pembelajaran kontrastif, pemodelan bahasa dan ramalan kendiri.

Mengapa pemantauan diri berkesan? Tesis kedoktoran Princeton setebal 243 halaman 'Memahami Pembelajaran Perwakilan Seliaan Sendiri' menerangkan secara menyeluruh tiga jenis kaedah: pembelajaran kontrastif, pemodelan bahasa dan ramalan kendiri.

- PHPzke hadapan

- 2023-04-15 08:13:021046semak imbas

Pra-latihan telah muncul sebagai paradigma alternatif dan berkesan untuk mengatasi kelemahan ini, di mana model mula-mula dilatih menggunakan data yang mudah didapati dan kemudian digunakan untuk menyelesaikan tugas hiliran yang diminati, dengan data yang kurang berlabel berbanding pembelajaran yang diselia. .

Pra-latihan menggunakan data tidak berlabel, iaitu pembelajaran penyeliaan kendiri, amat revolusioner dan telah berjaya dalam pelbagai bidang: teks, penglihatan, pertuturan, dsb.

Ini menimbulkan persoalan yang menarik dan mencabar: Mengapakah pra-latihan pada data tidak berlabel harus membantu tugas hiliran yang kelihatan tidak berkaitan?

Alamat kertas: https://dataspace.princeton.edu/ handle/88435/dsp01t435gh21h

Kertas kerja ini membentangkan beberapa kerja yang mencadangkan dan membina rangka kerja teori untuk menyiasat mengapa pembelajaran penyeliaan kendiri bermanfaat untuk tugas hiliran.

Rangka kerja ini sesuai untuk pembelajaran kontrastif, pemodelan bahasa autoregresif dan kaedah berasaskan ramalan kendiri. Idea teras rangka kerja ini ialah pra-latihan membantu mempelajari representasi data berdimensi rendah, yang seterusnya membantu menyelesaikan tugas hiliran yang diminati dengan pengelas linear, yang memerlukan kurang data berlabel.

Topik biasa ialah memformalkan sifat ideal pengedaran data tidak berlabel untuk membina tugas pembelajaran yang diselia sendiri. Dengan pemformalan yang sesuai, dapat ditunjukkan bahawa lebih kurang meminimumkan objektif pra-latihan yang betul boleh mengekstrak isyarat hiliran yang dikodkan secara tersirat dalam pengedaran data tidak berlabel.

Akhir sekali, ditunjukkan bahawa isyarat boleh dinyahkod daripada perwakilan yang dipelajari menggunakan pengelas linear, sekali gus menyediakan pemformalkan untuk pemindahan "kemahiran dan pengetahuan" merentas tugas.

Pengenalan

Dalam usaha mereka bentuk ejen dan penyelesaian terdorong data kepada masalah Dalam proses itu, bidang pembelajaran mesin dan kecerdasan buatan telah mencapai kemajuan yang luar biasa dalam dekad yang lalu. Dengan kejayaan awal dalam penanda aras pembelajaran diselia yang mencabar seperti ImageNet [Deng et al., 2009], inovasi dalam pembelajaran mendalam kemudiannya membawa kepada model dengan prestasi luar biasa pada banyak penanda aras sedemikian dalam domain yang berbeza. Melatih model khusus tugasan sedemikian sememangnya mengagumkan dan mempunyai nilai praktikal yang besar. Walau bagaimanapun, ia mempunyai had penting dalam memerlukan set data berlabel atau beranotasi yang besar, yang selalunya mahal. Tambahan pula, dari perspektif kecerdasan, seseorang berharap untuk mempunyai model yang lebih umum yang, seperti manusia [Ahn dan Brewer, 1993], boleh belajar daripada pengalaman terdahulu, meringkaskannya ke dalam kemahiran atau konsep, dan menggunakan kemahiran atau Konsep ini untuk menyelesaikan tugasan baru dengan sedikit atau tiada demonstrasi. Lagipun, bayi belajar banyak melalui pemerhatian dan interaksi tanpa pengawasan yang jelas. Batasan ini memberi inspirasi kepada paradigma alternatif untuk pralatihan.

Tumpuan artikel ini adalah pada pra-latihan menggunakan jumlah data tidak berlabel yang tersedia dalam jumlah yang banyak. Idea untuk menggunakan data tidak berlabel telah lama menjadi tumpuan dalam pembelajaran mesin, terutamanya melalui pembelajaran tanpa seliaan dan separa penyeliaan. Penyesuaian moden menggunakan pembelajaran mendalam sering dipanggil pembelajaran penyeliaan kendiri (SSL) dan telah mula mengubah landskap pembelajaran mesin dan kecerdasan buatan melalui idea seperti pembelajaran kontrastif dan pemodelan bahasa. Idea pembelajaran penyeliaan sendiri adalah untuk membina tugasan tertentu menggunakan hanya data tidak berlabel, dan melatih model untuk melaksanakan tugas yang dibina dengan baik. Tugasan sedemikian biasanya memerlukan model untuk mengekod sifat struktur data dengan meramalkan bahagian (atau sifat) input yang tidak diperhatikan atau tersembunyi daripada bahagian yang diperhatikan atau disimpan [LeCun dan Misra, 2021]. Pembelajaran penyeliaan sendiri telah menunjukkan keluasan dan utiliti pada banyak tugas hiliran yang diminati, selalunya dengan kecekapan sampel yang lebih baik daripada menyelesaikan tugas dari awal, membawa kita satu langkah lebih dekat kepada matlamat ejen tujuan umum. Malah, baru-baru ini, model bahasa besar seperti GPT-3 [Brown et al., 2020] telah menunjukkan "tingkah laku timbul" yang menarik yang berlaku pada skala, mencetuskan lebih minat terhadap idea pralatihan yang diselia sendiri.

Walaupun pembelajaran penyeliaan kendiri telah berjaya secara empirikal dan terus menunjukkan janji yang hebat, di luar gerak hati yang kasar, pemahaman teori yang baik tentang cara ia berfungsi masih kurang. Kejayaan yang mengagumkan ini menimbulkan persoalan yang menarik kerana tidak jelas secara priori mengapa model yang dilatih pada satu tugas harus membantu tugasan lain yang kelihatan tidak berkaitan, iaitu mengapa latihan mengenai tugas a harus membantu Tugas b. Walaupun pemahaman teori lengkap tentang SSL (dan pembelajaran mendalam secara umum) adalah mencabar dan sukar difahami, memahami fenomena ini pada mana-mana tahap abstraksi boleh membantu membangunkan algoritma yang lebih berprinsip. Motivasi penyelidikan artikel ini ialah:

Mengapa latihan tentang tugasan pembelajaran yang diselia sendiri (menggunakan sejumlah besar data tidak berlabel) membantu menyelesaikan tugas hiliran yang kekurangan data Bagaimana untuk memindahkan "pengetahuan dan kemahiran" Memformalkan? ?

Walaupun terdapat sejumlah besar literatur tentang pembelajaran diselia, generalisasi daripada tugas SSL → tugas hiliran pada asasnya berbeza daripada generalisasi daripada set latihan → set ujian dalam pembelajaran diselia. Untuk pembelajaran diselia untuk tugas hiliran pengelasan, contohnya, model yang dilatih pada set latihan pasangan label input yang disampel daripada pengedaran yang tidak diketahui boleh digunakan secara langsung untuk penilaian pada set ujian ghaib yang disampel daripada pengedaran yang sama. Pengedaran asas ini mewujudkan sambungan dari set latihan ke set ujian. Walau bagaimanapun, sambungan konsep dari tugas SSL→tugas hiliran kurang jelas kerana data tidak berlabel yang digunakan dalam tugas SSL tidak mempunyai isyarat jelas tentang label hiliran. Ini bermakna model yang dipralatih pada tugasan SSL (cth., meramalkan sebahagian daripada input daripada yang lain) tidak boleh digunakan secara langsung pada tugasan hiliran (cth., meramalkan label kelas daripada input). Oleh itu, pemindahan "pengetahuan dan kemahiran" memerlukan langkah latihan tambahan menggunakan beberapa data berlabel, idealnya kurang daripada apa yang diperlukan untuk pembelajaran diselia dari awal. Sebarang pemahaman teori tentang tugas SSL → generalisasi tugas hiliran perlu menjawab soalan-soalan ini: "Apakah peranan intrinsik data tidak berlabel? dan "Bagaimana untuk menggunakan model pra-latihan untuk tugas hiliran?" Kertas ini menyasarkan tugas hiliran klasifikasi, dengan Buat andaian pengedaran pada data tidak berlabel dan gunakan idea pembelajaran perwakilan untuk mengkaji isu ini:

(a) (Andaian Pengedaran) Pengagihan data tidak berlabel secara tersirat mengandungi berkaitan Maklumat tentang tugas klasifikasi hiliran yang diminati.

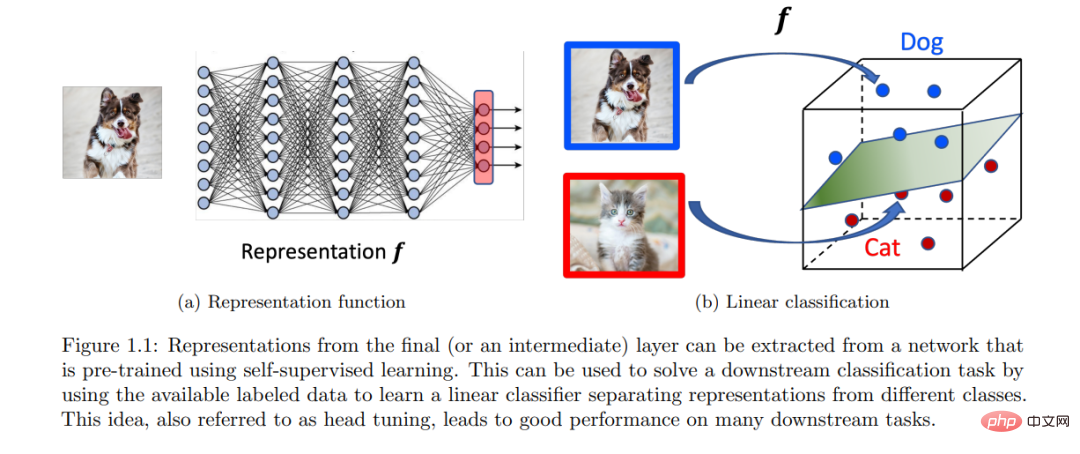

(b) (Pembelajaran Perwakilan) Model yang dilatih pada tugas SSL yang sesuai boleh mengekod isyarat melalui perwakilan yang dipelajari yang kemudiannya tugas pengelasan hiliran boleh diselesaikan menggunakan pengelas linear.

Titik (a) menunjukkan bahawa beberapa sifat struktur tidak berlabel secara tersirat memberi kita petunjuk tentang tugas hiliran seterusnya, dan pembelajaran penyeliaan kendiri boleh membantu belajar daripada data untuk mengusik isyarat ini . Perkara (b) mencadangkan cara yang mudah dan berkesan secara empirikal untuk menggunakan model terlatih, memanfaatkan perwakilan yang dipelajari model. Kertas kerja ini mengenal pasti dan mengira secara matematik sifat pengagihan data tidak berlabel, menunjukkan bahawa perwakilan yang baik boleh dipelajari untuk kaedah SSL yang berbeza seperti pembelajaran kontrastif, pemodelan bahasa dan ramalan kendiri. Dalam bahagian seterusnya, kami menyelidiki idea pembelajaran perwakilan dan menerangkan secara rasmi mengapa pembelajaran penyeliaan kendiri membantu tugasan hiliran.

Atas ialah kandungan terperinci Mengapa pemantauan diri berkesan? Tesis kedoktoran Princeton setebal 243 halaman 'Memahami Pembelajaran Perwakilan Seliaan Sendiri' menerangkan secara menyeluruh tiga jenis kaedah: pembelajaran kontrastif, pemodelan bahasa dan ramalan kendiri.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI