Rumah >Peranti teknologi >AI >Google dan MIT mencadangkan rangka kerja bersatu MAGE: pembelajaran perwakilan mengatasi MAE, dan penjanaan imej tanpa seliaan mengatasi Latent Diffusion

Google dan MIT mencadangkan rangka kerja bersatu MAGE: pembelajaran perwakilan mengatasi MAE, dan penjanaan imej tanpa seliaan mengatasi Latent Diffusion

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-14 20:28:011277semak imbas

Pengiktirafan dan penjanaan adalah dua tugas teras dalam bidang kecerdasan buatan Jika ia boleh digabungkan menjadi sistem bersatu, kedua-dua tugas ini harus saling melengkapi. Malah, dalam pemprosesan bahasa semula jadi, model seperti BERT [1] bukan sahaja mampu menghasilkan teks berkualiti tinggi tetapi juga mengekstrak ciri daripada teks.

Walau bagaimanapun, dalam bidang penglihatan komputer, model penjanaan imej semasa dan model pengecaman kebanyakannya dilatih secara berasingan, tanpa menggunakan sepenuhnya sinergi kedua-dua tugas ini. Ini disebabkan terutamanya oleh fakta bahawa model penjanaan imej dan pengecaman imej biasanya mempunyai perbezaan struktur yang penting: input penjanaan imej adalah ciri atau hingar berdimensi rendah, dan outputnya ialah imej asal berdimensi tinggi; input pengecaman imej adalah imej asal berdimensi tinggi, manakala output adalah ciri berdimensi rendah.

Baru-baru ini, penyelidik dari MIT dan Google Research mencadangkan kaedah pembelajaran perwakilan berdasarkan penyamaran semantik imej, mencapai penjanaan dan perwakilan imej dalam rangka kerja bersatu buat kali pertama mempelajari dan mencapai prestasi SOTA pada beberapa set data. Kertas penyelidikan telah diterima oleh CVPR 2023, dan kod yang berkaitan serta model pra-latihan telah menjadi sumber terbuka.

- Alamat kertas: https://arxiv.org/abs/2211.09117

- Alamat kod: https://github.com/LTH14/mage

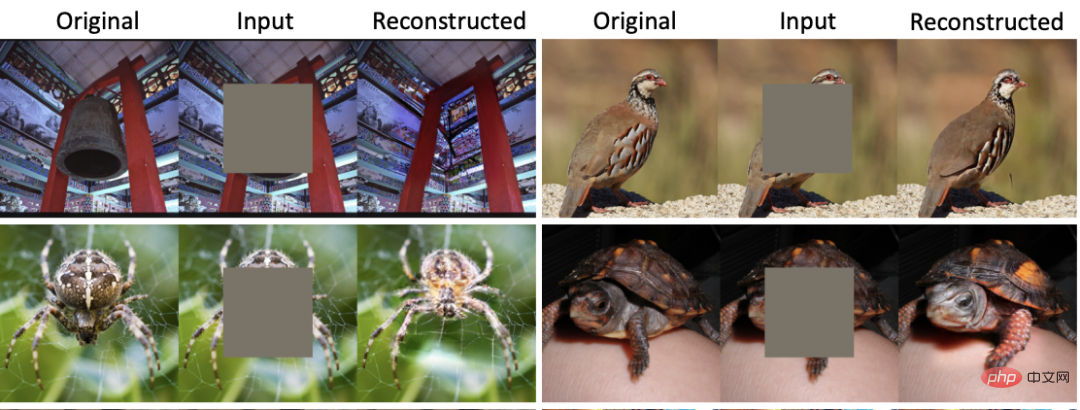

di CVPR 2022 Pada, MAE [2] mencadangkan kaedah pembelajaran perwakilan berdasarkan topeng imej (MIM) dan mencapai keputusan yang sangat baik pada berbilang subtugas. Pada kadar penyamaran sehingga 75%, MAE boleh membina semula imej yang hampir sepadan dengan semantik imej asal, dengan itu membenarkan rangkaian mempelajari ciri-ciri dalam imej dengan seliaan sendiri. Walau bagaimanapun, seperti yang ditunjukkan dalam Rajah 1, walaupun imej yang dibina semula oleh MAE mempunyai maklumat semantik yang serupa dengan imej asal, masalah kabur dan herotan yang serius berlaku. Isu yang sama timbul dalam semua kaedah pembelajaran perwakilan berasaskan MIM. Pada masa yang sama, model generatif semasa, sama ada model resapan atau GAN, tidak mempunyai keupayaan untuk mengekstrak ciri imej berkualiti tinggi.

Rajah 1: Perbandingan pembinaan semula MAE dan MAGE

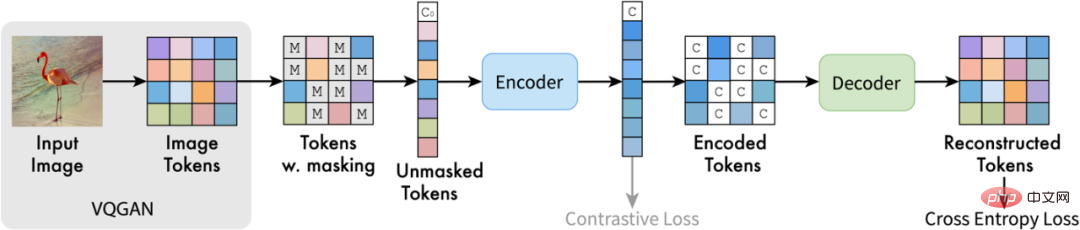

Gambaran Keseluruhan Kaedah

Sebagai tindak balas kepada masalah di atas, penulis artikel ini mencadangkan MAGE (Masked Generative Encoder), yang buat pertama kalinya merealisasikan penjanaan dan ciri imej bersatu model pengekstrakan. Berbeza daripada kaedah penyamaran di mana MIM bertindak terus pada imej, MAGE mencadangkan kaedah pemodelan token imej bertopeng berdasarkan simbol semantik imej. Seperti yang ditunjukkan dalam rajah, MAGE mula-mula menggunakan pengekod VQGAN [3] untuk menukar imej asal kepada simbol semantik diskret. Selepas itu, MAGE menutupnya secara rawak dan menggunakan struktur penyahkod pengekod berasaskan transformer untuk membina semula topeng Simbol semantik yang dibina semula boleh digunakan untuk menjana imej asal melalui penyahkod VQGAN. Dengan menggunakan kadar masking yang berbeza dalam latihan, MAGE boleh melatih kedua-dua model generatif (kadar masking hampir 100%) dan pembelajaran representasi (kadar masking 50%-80%). Seperti yang ditunjukkan dalam Rajah 1, imej yang dibina semula oleh MAGE bukan sahaja mempunyai maklumat semantik yang konsisten dengan imej asal, tetapi juga boleh memastikan kepelbagaian dan ketulenan imej yang dihasilkan pada masa yang sama.

Rajah 2: Rajah struktur MAGE

Hasil eksperimen

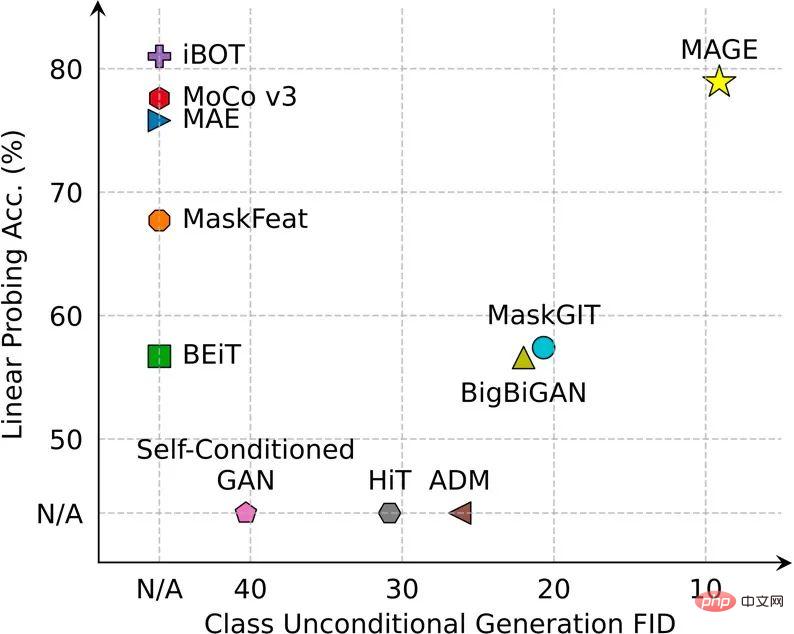

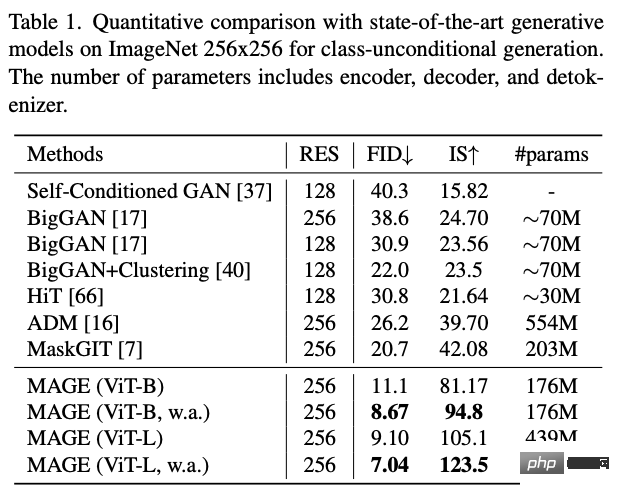

MAGE telah mencapai atau melebihi SOTA dalam berbilang penjanaan imej dan tugas pengecaman imej.

Dalam tugas penjanaan imej tanpa pengawasan ImageNet, FID MAGE menurun daripada sebelumnya > 20 kepada 7.04, malah mencapai tahap penjanaan imej diselia (FID Resapan Laten diselia pada ImageNet ialah 3.60) :

Gambar 3: Contoh penjanaan imej tanpa pengawasan MAGE

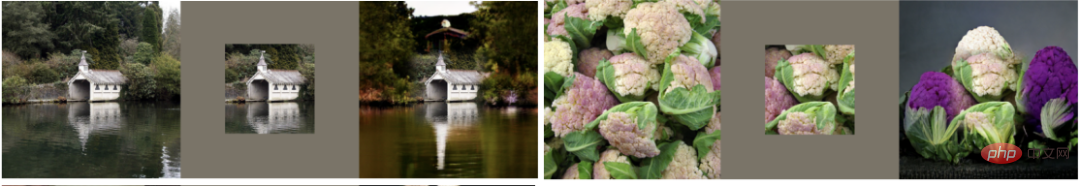

MAGE juga boleh melaksanakan pelbagai tugas penyuntingan imej, termasuk mengecat imej, mengecat luar dan menyahcrop:

Rajah 4: Sampel penyuntingan imej MAGE

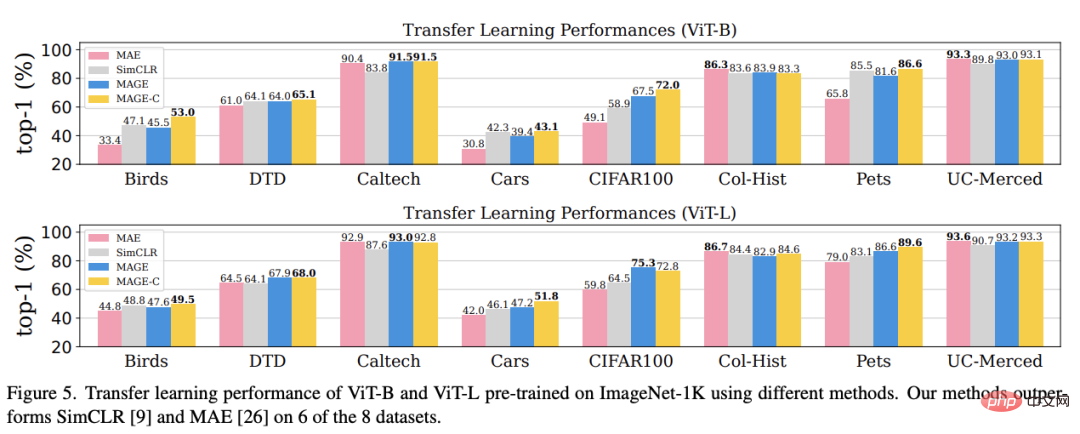

dalam Dari segi pembelajaran perwakilan , MAGE telah bertambah baik berbanding kaedah MIM semasa dalam tugasan seperti penyelidikan linear ImageNet, pembelajaran beberapa pukulan dan pembelajaran pemindahan, dan boleh mencapai atau melebihi tahap kaedah pembelajaran penyeliaan kendiri optimum semasa.

Kesimpulan

Kertas kerja ini bertujuan untuk menyatukan pembelajaran penjanaan imej dan perwakilan. Untuk tujuan ini, pengarang artikel ini mencadangkan MAGE, rangka kerja pembelajaran yang diselia sendiri berdasarkan topeng simbol semantik imej. Rangka kerja ini mudah dan cekap, dan buat pertama kalinya mencapai atau melebihi prestasi SOTA dalam kedua-dua penjanaan imej dan pembelajaran perwakilan. Pembaca yang berminat boleh melihat teks asal kertas untuk mengetahui lebih banyak butiran penyelidikan.

Atas ialah kandungan terperinci Google dan MIT mencadangkan rangka kerja bersatu MAGE: pembelajaran perwakilan mengatasi MAE, dan penjanaan imej tanpa seliaan mengatasi Latent Diffusion. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI