Rumah >Peranti teknologi >AI >Kelajuan inferens adalah 2 kali lebih pantas daripada Stable Diffusion Menjana dan membaiki imej boleh dilakukan dengan satu model Google, merealisasikan SOTA baharu.

Kelajuan inferens adalah 2 kali lebih pantas daripada Stable Diffusion Menjana dan membaiki imej boleh dilakukan dengan satu model Google, merealisasikan SOTA baharu.

- 王林ke hadapan

- 2023-04-14 18:49:031096semak imbas

Penjanaan teks-ke-imej ialah salah satu arah AIGC yang paling hangat pada tahun 2022 dan telah dipilih sebagai salah satu daripada sepuluh penemuan saintifik teratas pada tahun 2022 oleh "Sains". Baru-baru ini, kertas penjanaan teks-ke-imej baharu Google "Muse: Penjanaan Teks-Ke-Imej melalui Transformers Generatif Bertopeng" telah menarik perhatian yang hebat.

- Alamat kertas: https://arxiv.org/pdf/2301.00704v1.pdf

- Alamat projek: https://muse-model.github.io/

Kajian itu mencadangkan A model baharu untuk sintesis teks ke imej menggunakan pendekatan pemodelan imej bertopeng, di mana seni bina penyahkod imej dikondisikan pada pembenaman daripada pengekod T5-XXL Model Bahasa Besar (LLM) yang telah terlatih dan beku.

Sama seperti model Imagen Google sebelum ini, kajian ini mendapati bahawa penalaan berdasarkan LLM pra-latihan adalah penting untuk penjanaan imej yang realistik dan berkualiti tinggi. Model Muse dibina pada seni bina Transformer (Vaswani et al., 2017).

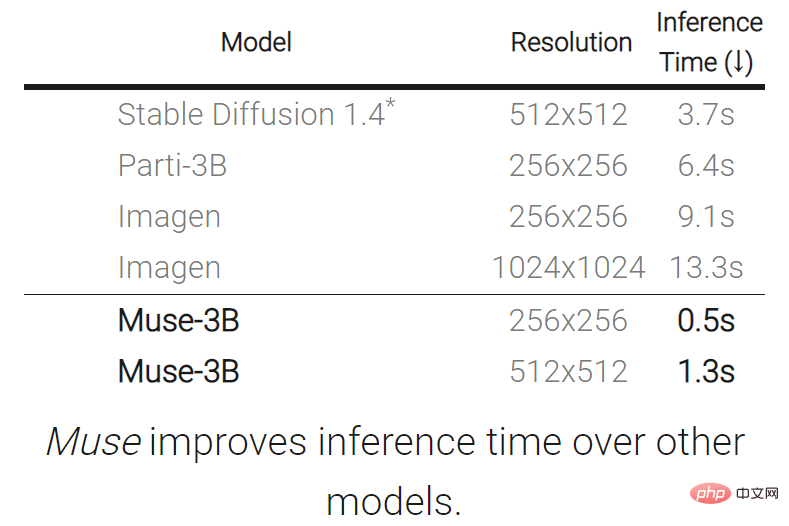

Berbanding dengan Imagen (Saharia et al., 2022) atau Dall-E2 (Ramesh et al., 2022) berdasarkan model resapan ruang piksel bertingkat Berbanding dengan Muse, kecekapan bertambah baik dengan ketara kerana penggunaan token diskret. Berbanding dengan model autoregresif SOTA Parti (Yu et al., 2022), Muse lebih cekap kerana penggunaan penyahkodan selari.

Berdasarkan keputusan percubaan pada TPU-v4, penyelidik menganggarkan Muse lebih 10 kali lebih pantas daripada model Imagen-3B atau Parti-3B dalam kelajuan inferens dan lebih pantas daripada Stable Diffusion v1 .4 (Rombach et al., 2022) 2 kali lebih cepat. Penyelidik percaya bahawa Muse lebih pantas daripada Stable Diffusion kerana model resapan digunakan dalam Stable Diffusion v1.4, yang jelas memerlukan lebih banyak lelaran semasa inferens.

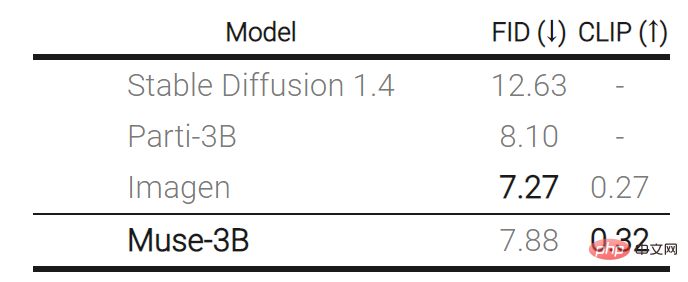

Sebaliknya, peningkatan kecekapan Muse tidak menyebabkan masalah penurunan kualiti imej yang dijana dan penurunan pemahaman semantik model terhadap gesaan teks input . Kajian ini menilai hasil penjanaan Muse terhadap pelbagai kriteria, termasuk skor CLIP (Radford et al., 2021) dan FID (Heusel et al., 2017). Model Muse-3B mencapai skor CLIP 0.32 dan skor FID 7.88 pada penanda aras pengesahan sifar pukulan COCO (Lin et al., 2014).

Mari kita lihat kesan penjanaan Muse:

Penjanaan Imej Teks: Model Muse menjana imej berkualiti tinggi daripada teks dengan pantas gesaan (dalam Pada TPUv4, ia mengambil masa 1.3 saat untuk menjana imej dengan resolusi 512x512 dan 0.5 saat untuk menjana imej dengan resolusi 256x256). Sebagai contoh, jana "beruang menunggang basikal dan burung hinggap pada hendal":

Model Muse melepasi imej di bawah syarat gesaan teks Token melakukan pensampelan semula berulang, menyediakan pengguna dengan sampel sifar, pengeditan tanpa topeng.

Muse juga menawarkan penyuntingan berasaskan topeng, seperti "Terdapat gazebo di tasik berlatar belakangkan daun musim luruh yang cantik."

Pengenalan Model

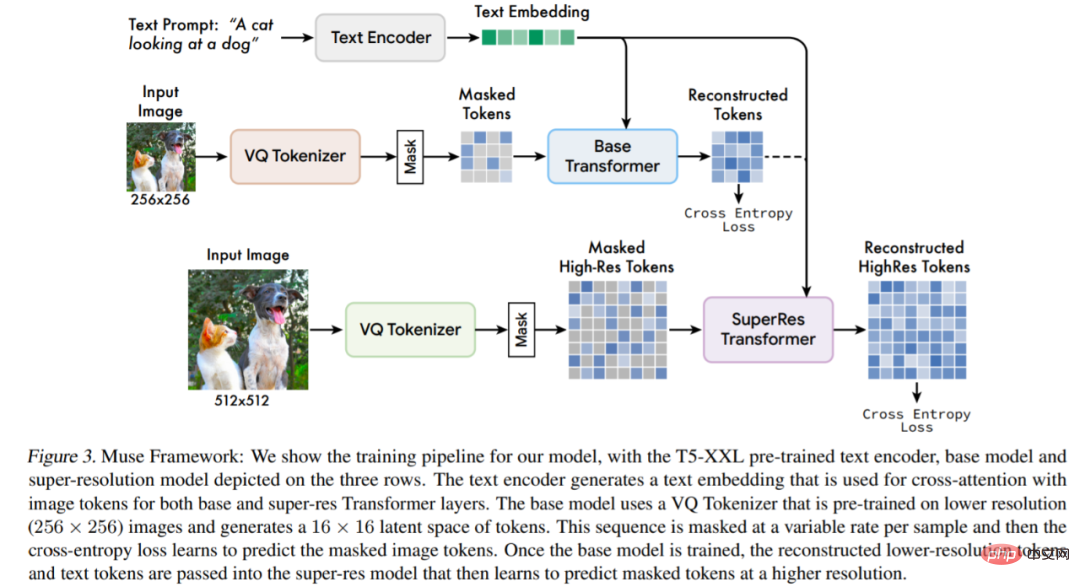

Muse dibina di atas beberapa komponen, Rajah 3 memberikan gambaran keseluruhan seni bina model.

Secara khususnya, komponen yang disertakan ialah:

Pengekod teks pra-latihan: Kajian ini mendapati bahawa menggunakan model bahasa besar (LLM) pra-latihan boleh meningkatkan kualiti penjanaan imej. Mereka membuat hipotesis bahawa model Muse belajar untuk memetakan konsep visual dan semantik yang kaya dalam pembenaman LLM kepada imej yang dijana. Memandangkan sari kata teks input, kajian itu meneruskannya melalui pengekod T5-XXL beku, menghasilkan jujukan 4096 dimensi bagi vektor benam bahasa. Vektor benam ini diunjurkan secara linear ke model Transformer.

Tokenisasi Semantik menggunakan VQGAN: Komponen teras model ini ialah penggunaan token semantik yang diperoleh daripada model VQGAN. Antaranya, VQGAN terdiri daripada pengekod dan penyahkod, dan lapisan kuantiti memetakan imej input kepada urutan token dalam buku kod pembelajaran. Kajian ini semuanya menggunakan lapisan konvolusi untuk membina pengekod dan penyahkod untuk menyokong pengekodan imej resolusi berbeza.

Model asas: Model asas ialah pengubah topeng di mana input adalah benam dan token imej diunjurkan kepada T5. Kajian ini menyimpan semua pembenaman teks (dibuka topeng), secara rawak menutup token imej dengan perkadaran berbeza dan menggantikannya dengan token [topeng] khas.

Model peleraian super: Kajian mendapati ia berfaedah untuk menggunakan lata model: pertama model asas yang menghasilkan peta terpendam 16 × 16 (bersamaan dengan imej 256 × 256) , dan kemudian Peta pendam asas ditambah sampel kepada model peleraian super, iaitu peta pendam 64 × 64 (bersamaan dengan imej 512 × 512).

Penalaan halus penyahkod: Untuk meningkatkan lagi keupayaan model menjana butiran halus, kajian ini meningkatkan kapasiti penyahkod VQGAN dengan menambah lebih banyak lapisan dan saluran baki sambil mengekalkan kapasiti pengekod kekal tidak berubah. Lapisan penyahkod baharu kemudiannya diperhalusi sambil membekukan pemberat pengekod VQGAN, buku kod dan pengubah (iaitu model asas dan model resolusi super).

Selain komponen di atas, Muse juga termasuk komponen nisbah topeng boleh ubah, komponen penyahkod selari berulang semasa inferens, dsb.

Eksperimen dan keputusan

Seperti yang ditunjukkan dalam jadual di bawah, Muse memendekkan masa inferens berbanding model lain.

Jadual berikut menunjukkan skor FID dan CLIP yang diukur oleh model berbeza pada COCO tangkapan sifar:

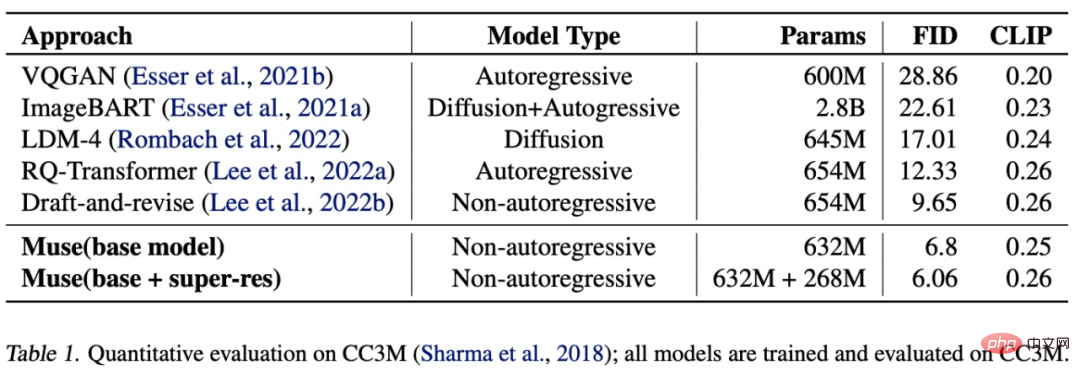

Seperti yang ditunjukkan dalam jadual di bawah, Muse (632M (asas)+268M (super-res) model parameter) memperoleh skor SOTA FID 6.06 apabila dilatih dan dinilai pada dataset CC3M.

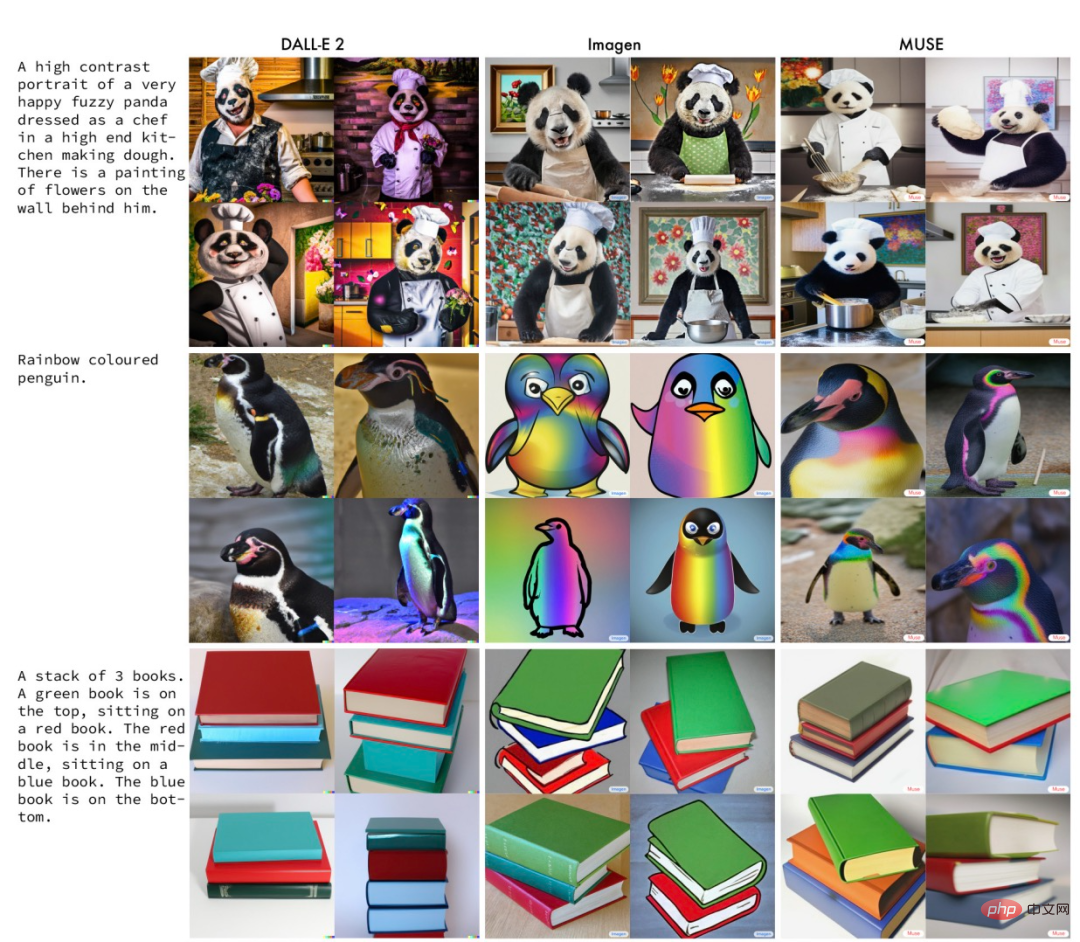

Gambar di bawah ialah contoh hasil yang dijana oleh Muse, Imagen dan DALL-E 2 di bawah gesaan yang sama.

Pembaca yang berminat boleh membaca teks asal kertas kerja untuk mengetahui lebih lanjut butiran penyelidikan.

Atas ialah kandungan terperinci Kelajuan inferens adalah 2 kali lebih pantas daripada Stable Diffusion Menjana dan membaiki imej boleh dilakukan dengan satu model Google, merealisasikan SOTA baharu.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI