Rumah >Peranti teknologi >AI >Pra-latihan tanpa perhatian; Pembelajaran Dalam Konteks didorong oleh GPT

Pra-latihan tanpa perhatian; Pembelajaran Dalam Konteks didorong oleh GPT

- WBOYke hadapan

- 2023-04-14 17:31:031157semak imbas

Kertas 1: ClimateNeRF: Rendering Neural Berasaskan Fizikal untuk Sintesis Iklim Ekstrim

- Pengarang: Yuan Li et al

- Alamat kertas: https://arxiv.org/pdf/2211.13226.pdf

Abstrak: Kertas kerja ini memperkenalkan kaedah baharu untuk menggabungkan simulasi fizikal dengan model adegan NeRF untuk menjana filem realistik fenomena fizikal dalam babak ini. Dari segi keputusan konkrit, kaedah ini boleh mensimulasikan kemungkinan kesan perubahan iklim secara realistik - apakah rupa taman permainan selepas banjir berskala kecil? Bagaimana pula selepas banjir besar? Bagaimana pula selepas ribut salji?

Disyorkan: Kabus, musim sejuk, banjir, model NeRF baharu menjadikan realistik fizikal filem blockbuster.

Kertas 2: Pralatihan Tanpa Perhatian

- Pengarang: Junxiong Wang et al

- Alamat kertas: https://arxiv.org/pdf/2212.10544.pdf

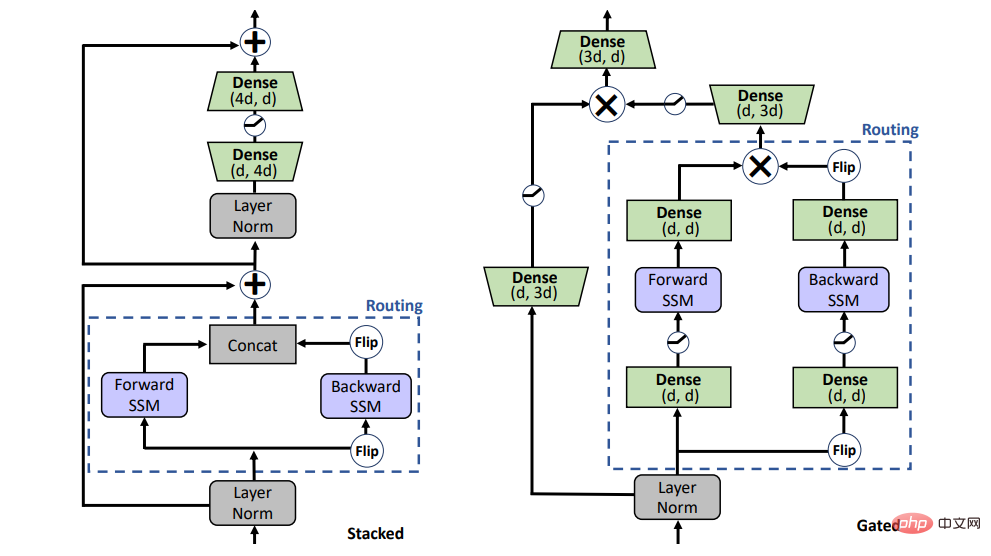

Abstrak: Kertas ini mencadangkan model Dwiarah Gating SSM (BiGS), yang menggabungkan lapisan Penghalaan berdasarkan Model Ruang Negeri (SSM) dan seni bina model berasaskan get darab untuk mereplikasi ramalan BERT tanpa menggunakan perhatian. .

Cadangan: Pra-latihan tidak memerlukan perhatian dan penskalaan kepada 4096 token tidak menjadi masalah, setanding dengan BERT.

Kertas 3: Satu Model untuk Mengedit Kesemuanya: Manipulasi Imej Dipacu Teks Bentuk Percuma dengan Modulasi Semantik

- Pengarang: Yiming Zhu et al

- Alamat kertas: https://arxiv.org/pdf/2210.07883.pdf

Abstrak: Baru-baru ini, menggunakan teks untuk membimbing penyuntingan imej telah mencapai kemajuan dan perhatian yang hebat, terutamanya berdasarkan model penyebaran denoising seperti StableDiffusion atau DALLE wait . Walau bagaimanapun, penyuntingan imej teks berasaskan GAN masih mempunyai beberapa masalah yang menunggu untuk diselesaikan Contohnya, dalam StyleCILP klasik, model mesti dilatih untuk setiap teks pendekatan satu-teks-ke-model tunggal ini menyusahkan dalam praktikal aplikasi.

Artikel ini mencadangkan FFCLIP dan menyelesaikan masalah ini Untuk input teks berbeza yang fleksibel, FFCLIP hanya memerlukan satu model untuk mengedit imej dengan sewajarnya, tanpa melatih semula model untuk setiap teks , dan mencapainya keputusan yang baik pada beberapa set data. Artikel ini telah diterima oleh NeurIPS 2022.

Disyorkan: Paradigma baharu untuk penyuntingan teks dan imej, satu model membolehkan penyuntingan imej berpandukan berbilang teks.

Kertas 4: ARAHAN KENDIRI: Menjajarkan Model Bahasa dengan Arahan Dihasilkan Sendiri

- Pengarang: Yizhong Wang et al

- Alamat kertas: https://arxiv.org/pdf/2212.10560v1.pdf

Abstrak: Universiti Washington dan institusi lain baru-baru ini bersama-sama menerbitkan sebuah kertas kerja Rangka kerja baharu INSTRUCT KENDIRI meningkatkan prestasi model bahasa yang telah dilatih dengan membimbing model tersebut. proses penjanaan sendiri. ARAHAN KENDIRI ialah proses separa automatik yang melakukan penalaan arahan pada LM pra-latihan menggunakan isyarat arahan daripada model itu sendiri.

Disyorkan: Tidak memerlukan anotasi manual, rangka kerja arahan yang dijana sendiri memecahkan kesesakan kos LLM seperti ChatGPT.

Kertas 5: Ab Initio Pengiraan Pepejal Nyata melalui Ansatz Rangkaian Neural

- Pengarang: Xiang Li et al

- Alamat kertas: https://www.nature.com/articles/s41467-022 - 35627-1

Abstrak: Pembelajaran mesin boleh memproses sejumlah besar data, menyelesaikan masalah saintifik dalam senario yang kompleks dan memimpin penerokaan saintifik kepada kawasan yang mustahil pada masa lalu. Sebagai contoh, DeepMind menggunakan perisian kecerdasan buatan AlphaFold untuk membuat ramalan yang sangat tepat bagi hampir semua struktur protein yang diketahui oleh komuniti saintifik kaedah halaju imej zarah (PIV) berdasarkan pembelajaran mendalam yang dicadangkan oleh Christian Lagemann telah banyak menambah baik tetapan manual semata-mata; daripada parameter. Skop penggunaan model adalah amat penting untuk penyelidikan dalam banyak bidang seperti kereta, aeroangkasa dan kejuruteraan bioperubatan.

Baru-baru ini, kerja "Pengiraan Ab initio pepejal sebenar melalui ansatz rangkaian saraf" oleh pasukan Penyelidikan Makmal AI ByteDance dan kumpulan penyelidik Chen Ji di Sekolah Fizik Universiti Peking menyediakan kaedah untuk mengkaji jirim pekat Satu idea baru dalam fizik, kerja ini mencadangkan fungsi gelombang rangkaian saraf pertama industri yang sesuai untuk sistem pepejal, merealisasikan pengiraan prinsip pertama pepejal, dan menolak keputusan pengiraan ke had termodinamik. Ia amat membuktikan bahawa rangkaian saraf ialah alat yang cekap untuk mengkaji fizik keadaan pepejal, dan juga menunjukkan bahawa teknologi pembelajaran mendalam akan memainkan peranan yang semakin penting dalam fizik jirim pekat. Hasil penyelidikan yang berkaitan telah diterbitkan dalam jurnal antarabangsa teratas Nature Communication pada 22 Disember 2022.

Disyorkan: Fungsi gelombang rangkaian saraf pertama industri yang sesuai untuk sistem pepejal telah diterbitkan dalam sub-jurnal Nature.

Kertas 6: Mengapa GPT Boleh Belajar Dalam Konteks Model Secara Rahsia Melakukan Keturunan Kecerunan sebagai Pengoptimum Meta

- Pengarang: Damai Dai et al

- Alamat kertas: https://arxiv.org/pdf/2212.10559v2.pdf

Abstrak: Pembelajaran Dalam Konteks (ICL) telah mencapai kejayaan besar pada model bahasa pra-latihan yang besar, tetapi mekanisme kerjanya masih merupakan Soalan yang tidak dijawab. Dalam artikel ini, penyelidik dari Universiti Peking, Universiti Tsinghua dan Microsoft memahami ICL sebagai sejenis penalaan halus tersirat, dan memberikan bukti empirikal untuk membuktikan bahawa ICL dan penalaan halus eksplisit berprestasi serupa pada pelbagai peringkat.

Disyorkan: Mengapakah Pembelajaran Dalam Konteks, didorong oleh GPT, berfungsi? Model melakukan penurunan kecerunan secara rahsia.

Kertas 7: Petunjuk Eksperimen Fungsi Otak Bukan Klasik

- Pengarang: Christian Matthias Kerskens et al

- Alamat kertas: https://iopscience.iop.org/article/10.1088/2399-6528/ac94be

Abstrak: Selama beberapa dekad, saintis telah meneroka mekanisme pengkomputeran dan pemikiran otak manusia. Namun, struktur otak manusia terlalu kompleks, mengandungi berpuluh bilion neuron, bersamaan dengan trilion cip, jadi sukar untuk kita ketahui. Roger Penrose, yang memenangi Hadiah Nobel dalam Fizik untuk sumbangannya kepada kajian lubang hitam, pernah dengan berani mencadangkan idea "kesedaran kuantum", iaitu, otak manusia itu sendiri adalah struktur kuantum, atau komputer kuantum. Tetapi pandangan ini telah dipersoalkan.

Kajian baru-baru ini dari Universiti Trinity Dublin mencadangkan bahawa otak kita melakukan pengiraan kuantum, dengan alasan bahawa terdapat kekusutan dalam otak manusia yang dimediasi oleh fungsi otak yang berkaitan dengan kesedaran. Jika fungsi otak ini mesti beroperasi dengan cara bukan klasik, maka ini bermakna kesedaran adalah bukan klasik, iaitu proses kognitif otak melibatkan pengiraan kuantum.

Disyorkan: Pemikiran otak ialah pengkomputeran kuantum. Terdapat bukti baharu untuk spekulasi ini.

Stesen Radio Mingguan ArXiv

Heart of Machine bekerjasama dengan Stesen Radio Mingguan ArXiv yang dimulakan oleh Chu Hang dan Luo Ruotian, dan memilih kertas kerja yang lebih penting minggu ini berdasarkan 7 Kertas, termasuk 10 kertas terpilih setiap satu dalam bidang NLP, CV dan ML . Dan sediakan ringkasan audio kertas tersebut, butirannya adalah seperti berikut:

10 Kertas NLPAudio: 00:0020:18

10 kertas NLP terpilih minggu ini Ya:

1 Adakah induksi tatabahasa yang tidak diawasi memerlukan piksel? (daripada Serge Belongie, Kilian Q. Weinberger, Jitendra Malik, Trevor Darrell)

2. Memahami Stereotaip dalam Model Bahasa: Ke Arah Pengukuran Teguh dan Penyahbiakan Pukulan Sifar (dari Bernhard Schölkopf)

3 Terjemahan Mesin dan Penilaian Kontrastif (daripada Cordelia Schmid, Ivan Laptev)

4 )

5 Mengenai Penggunaan Data Selari untuk Anggaran Kualiti Terjemahan (dari Dacheng Tao)

6 Penilaian Suka Manusia untuk Penjanaan Bahasa Semulajadi dengan Analisis Ralat (dari Dacheng Tao)

7 Bolehkah Model Dialog Berorientasikan Tugasan Semasa Mengautomasikan Senario Dunia Sebenar? (dari Kyunghyun Cho )

8 Pada Titik Buta Metrik Penilaian Berasaskan Model untuk Penjanaan Teks (daripada Kyunghyun Cho)

9. Beyond Contrastive Learning: Model Generative Variational for Multilingual Retrieval (daripada William W. Cohen)

10. Kesan Perwakilan Simbolik terhadap Pembelajaran Dalam Konteks. daripada Li Erran Li, Eric Xing)

10 Kertas CVAudio: 00:0023: 15

10 kertas kerja unggulan CV minggu ini ialah:

1. -Penjanaan Imej. (daripada Eric Horvitz)

3. Tinjauan Ringkas tentang Pengecaman Orang pada Jarak Jauh (daripada Rama Chellappa)

. 4. MetaCLUE: Towards Comprehensive Visual Metaphors Research (dari Leonidas Guibas, William T. Freeman)

5. Aliasing ialah Pemacu Serangan Adversarial

6. Rangkaian Lajur Boleh Balik (dari Xiangyu Zhang)

7 Hi-LASSIE: High-Fidelity Articulated Shape and Skeleton Discovery daripada Jarang Imej Ensemble. . (daripada Ming-Hsuan Yang)

8. Pembesaran Titik Tahap Objek untuk Pengesanan Objek 3D Separa diselia (dari Ming-Hsuan Yang)

9. Melancarkan Kuasa Penggerak Visual Pada Tahap Piksel (daripada Alan Yuille)

10. Daripada Imej kepada Gesaan Teks: VQA Tangkapan Sifar dengan Model Bahasa Besar Pembekuan. (dari Dacheng Tao, Steven C.H. Hoi)

Atas ialah kandungan terperinci Pra-latihan tanpa perhatian; Pembelajaran Dalam Konteks didorong oleh GPT. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI