Rumah >Peranti teknologi >AI >Buat pertama kalinya, 'Pengarah Pengajaran' diperkenalkan ke dalam penyulingan model, dan pemampatan berskala besar adalah lebih baik daripada 24 kaedah SOTA.

Buat pertama kalinya, 'Pengarah Pengajaran' diperkenalkan ke dalam penyulingan model, dan pemampatan berskala besar adalah lebih baik daripada 24 kaedah SOTA.

- PHPzke hadapan

- 2023-04-14 15:46:031049semak imbas

Berdepan dengan model pembelajaran mendalam yang semakin mendalam dan data besar video yang besar, algoritma kecerdasan buatan semakin bergantung pada sumber pengkomputeran. Untuk meningkatkan prestasi dan kecekapan model dalam dengan berkesan, dengan meneroka kebolehsulingan dan ketersedian model, kertas kerja ini mencadangkan teknologi pemampatan model bersatu berdasarkan model "Dekan-guru-pelajar".

Keputusan ini telah disiapkan oleh pasukan penyelidik bersama Akademi Sains Rakyat dan Institut Automasi, Akademi Sains China Kertas kerja yang berkaitan diterbitkan pada jurnal antarabangsa teratas mengenai kecerdasan buatan, IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI) on. Pencapaian ini merupakan kali pertama peranan "pengarah pengajar" telah diperkenalkan ke dalam teknologi penyulingan model, menyatukan penyulingan dan menyesuaikan model dalam.

Alamat kertas: https://ieeexplore.ieee.org/abstract/document/9804342

Pada masa ini, pencapaian ini telah digunakan pada enjin carian pintar silang mod "Baize" yang dibangunkan secara bebas oleh Sains dan Teknologi Rakyat. "Baize" memecahkan halangan ekspresi maklumat antara modaliti yang berbeza seperti grafik, teks, audio dan video, dan memetakan maklumat mod yang berbeza seperti teks, gambar, suara dan video ke dalam ruang perwakilan ciri bersatu, dengan video sebagai teras, pembelajaran pelbagai modaliti Pengukuran jarak bersatu boleh digunakan untuk merapatkan jurang semantik kandungan berbilang modal seperti teks, suara dan video untuk mencapai keupayaan carian bersatu.

Walau bagaimanapun, dalam menghadapi data Internet yang besar, terutamanya data besar video, penggunaan sumber pengkomputeran oleh model dalam merentas mod semakin meningkat secara beransur-ansur. Berdasarkan hasil penyelidikan ini, "Baize" boleh memampatkan saiz model pada skala besar sambil memastikan prestasi algoritma, dengan itu mencapai keupayaan pemahaman dan carian pintar merentas mod daya tinggi dan kuasa rendah. Menurut aplikasi praktikal awal, teknologi ini boleh memampatkan skala parameter model besar lebih daripada empat kali secara purata. Di satu pihak, ia boleh mengurangkan penggunaan model sumber pengkomputeran berprestasi tinggi seperti pelayan GPU Sebaliknya, model besar yang tidak boleh digunakan di tepi boleh disuling dan dimampatkan untuk mencapai penggunaan kuasa rendah pada bahagian. tepi.

Rangka kerja pembelajaran bersekutu untuk pemampatan model

Mampatan dan pecutan model algoritma dalam boleh dicapai melalui pembelajaran penyulingan atau keratan jarang berstruktur, tetapi ini Terdapat beberapa batasan dalam kedua-dua bidang. Bagi kaedah pembelajaran penyulingan, ia bertujuan untuk melatih model ringan (iaitu, rangkaian pelajar) untuk mensimulasikan model yang kompleks dan besar (iaitu, rangkaian guru). Di bawah bimbingan rangkaian guru, rangkaian pelajar boleh mencapai prestasi yang lebih baik daripada latihan sahaja.

Walau bagaimanapun, algoritma pembelajaran penyulingan hanya menumpukan pada peningkatan prestasi rangkaian pelajar dan sering mengabaikan kepentingan struktur rangkaian. Struktur rangkaian pelajar secara amnya telah ditetapkan dan ditetapkan semasa proses latihan.

Untuk keratan jarang berstruktur atau keratan penapis, kaedah ini bertujuan untuk memotong rangkaian yang berlebihan dan kompleks ke dalam rangkaian yang jarang dan padat. Walau bagaimanapun, pemangkasan model hanya digunakan untuk mendapatkan struktur yang padat. Tiada kaedah sedia ada menggunakan sepenuhnya "pengetahuan" yang terkandung dalam model kompleks asal. Penyelidikan terkini menggabungkan pembelajaran penyulingan dengan pemangkasan jarang berstruktur untuk mengimbangi prestasi dan saiz model. Tetapi kaedah ini terhad kepada gabungan mudah fungsi kehilangan.

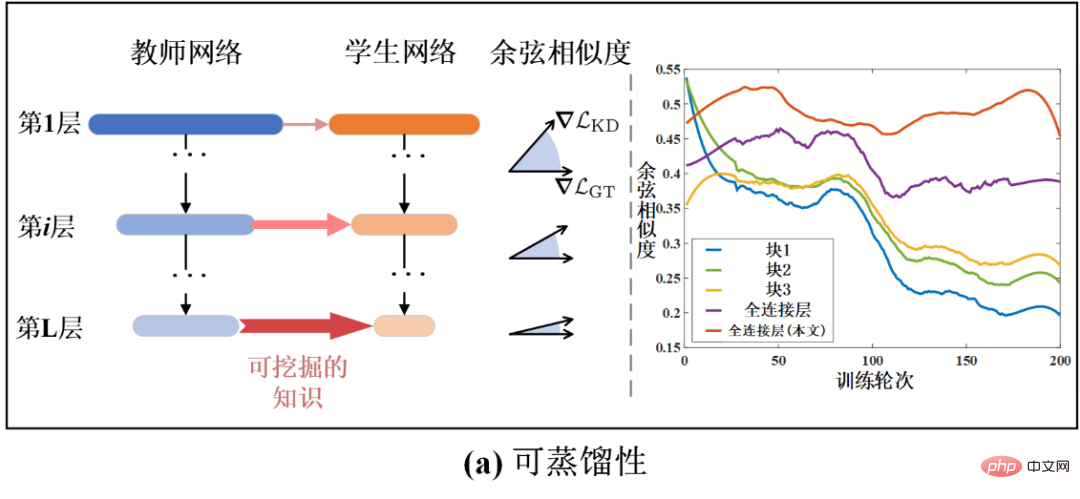

Bagi menganalisis isu di atas secara mendalam, kajian ini terlebih dahulu melatih model berdasarkan penderiaan termampat Dengan menganalisis prestasi dan struktur model, didapati terdapat dua sifat penting untuk model algoritma dalam: kebolehsulingan Kebolehsulingan dan kebolehselapan.

Secara khusus, kebolehsulingan merujuk kepada ketumpatan yang boleh menyaring pengetahuan berkesan daripada rangkaian guru. Ia boleh diukur dengan peningkatan prestasi yang dicapai oleh rangkaian pelajar di bawah bimbingan rangkaian guru. Sebagai contoh, rangkaian pelajar dengan kebolehsulingan yang lebih tinggi boleh mencapai prestasi yang lebih tinggi. Kebolehsulingan juga boleh dianalisis secara kuantitatif pada peringkat lapisan rangkaian.

Seperti yang ditunjukkan dalam Rajah 1-(a), graf bar mewakili kesamaan kosinus (Cosine Similarity) antara kecerunan kehilangan pembelajaran penyulingan dan kecerunan kehilangan pengelasan nilai sebenar. Persamaan kosinus yang lebih besar menunjukkan bahawa pengetahuan tentang penyulingan semasa lebih membantu untuk prestasi model. Dengan cara ini, persamaan kosinus juga boleh menjadi ukuran kebolehsulingan. Ia boleh dilihat daripada Rajah 1-(a) bahawa kebolehsulingan secara beransur-ansur meningkat apabila bilangan lapisan model menjadi lebih dalam. Ini juga menerangkan sebab penyeliaan yang biasa digunakan dalam pembelajaran penyulingan digunakan dalam beberapa lapisan terakhir model. Selain itu, dalam pusingan latihan yang berbeza, model pelajar juga mempunyai kebolehsulingan yang berbeza, kerana persamaan kosinus juga berubah apabila masa latihan berubah. Oleh itu, adalah perlu untuk menganalisis secara dinamik kebolehsulingan lapisan yang berbeza semasa proses latihan.

Sebaliknya, sparsity merujuk kepada kadar pemangkasan (atau kadar mampatan) yang model boleh perolehi di bawah kehilangan ketepatan terhad. Kebolehtahanan yang lebih tinggi sepadan dengan potensi untuk kadar tanaman yang lebih tinggi. Seperti yang ditunjukkan dalam Rajah 1-(b), lapisan atau modul rangkaian yang berbeza mempamerkan kebolehtelapan yang berbeza. Sama seperti kebolehsulingan, kebolehselapan juga boleh dianalisis pada peringkat lapisan rangkaian dan dalam dimensi masa. Walau bagaimanapun, pada masa ini tiada kaedah untuk meneroka dan menganalisis kebolehsulingan dan jarang berlaku. Kaedah sedia ada sering menggunakan mekanisme latihan tetap, yang menjadikannya sukar untuk mencapai hasil yang optimum.

Rajah 1 Gambarajah skematik kebolehsulingan dan jarang rangkaian neural dalam

Bagi menyelesaikan masalah di atas, kajian ini menganalisis proses latihan pemampatan model untuk mendapatkan penemuan yang relevan tentang kebolehsulingan dan kezaliman. Diilhamkan oleh penemuan ini, kajian ini mencadangkan kaedah mampatan model berdasarkan pembelajaran bersama kebolehsulingan dinamik dan kebolehselapan. Ia boleh menggabungkan pembelajaran penyulingan secara dinamik dan keratan jarang berstruktur, dan menyesuaikan mekanisme latihan bersama secara adaptif dengan mempelajari kebolehsulingan dan keterlanjuran.

Berbeza daripada rangka kerja "Guru-Pelajar" konvensional, kaedah yang dicadangkan dalam artikel ini boleh digambarkan sebagai rangka kerja "Pembelajaran-dalam-Sekolah", Kerana ia mengandungi tiga modul utama: jaringan guru, jaringan pelajar dan jaringan dekan.

Secara khusus, sama seperti sebelum ini, rangkaian guru mengajar rangkaian pelajar. Rangkaian pengarah pengajaran bertanggungjawab untuk mengawal keamatan pembelajaran dalam talian pelajar dan cara mereka belajar. Dengan mendapatkan status rangkaian guru dan rangkaian pelajar semasa, rangkaian dekan boleh menilai kebolehsulingan dan kebolehselapan rangkaian pelajar semasa, dan kemudian mengimbangi dan mengawal kekuatan penyeliaan pembelajaran penyulingan dan penyeliaan keratan jarang berstruktur secara dinamik.

Untuk mengoptimumkan kaedah dalam artikel ini, penyelidikan ini juga mencadangkan algoritma pengoptimuman bersama pembelajaran penyulingan & jahitan berdasarkan kaedah pengganda arah seli untuk mengemas kini rangkaian pelajar. Untuk mengoptimumkan dan mengemas kini rangkaian pengarah pengajaran, artikel ini mencadangkan algoritma pengoptimuman pengarah pengajaran berasaskan meta-pembelajaran. Kebolehsulingan pula boleh dipengaruhi oleh melaraskan isyarat penyeliaan secara dinamik. Seperti yang ditunjukkan dalam Rajah 1-(a), kaedah dalam kertas kerja ini terbukti dapat melambatkan aliran kebolehsulingan menurun dan meningkatkan kebolehsulingan keseluruhan dengan menggunakan pengetahuan penyulingan secara rasional.

Rangka kerja algoritma keseluruhan dan carta alir kaedah ini ditunjukkan dalam rajah di bawah. Rangka kerja tersebut mengandungi tiga modul utama, rangkaian guru, rangkaian pelajar dan rangkaian pengarah pengajaran. Antaranya, rangkaian berlebihan kompleks awal yang akan dimampatkan dan dipangkas dianggap sebagai rangkaian guru, dan dalam proses latihan seterusnya, rangkaian asal yang secara beransur-ansur jarang dianggap sebagai rangkaian pelajar. Rangkaian dekan ialah rangkaian meta yang memasukkan maklumat rangkaian guru dan rangkaian pelajar untuk mengukur kebolehsulingan dan keterlanjuran semasa, dengan itu mengawal keamatan penyeliaan pembelajaran penyulingan dan jarang.

Dengan cara ini, pada setiap saat, rangkaian pelajar boleh dibimbing dan dikecilkan oleh pengetahuan yang disuling secara dinamik. Sebagai contoh, apabila rangkaian pelajar mempunyai kebolehsulingan yang lebih tinggi, dekan akan membiarkan isyarat penyeliaan penyulingan yang lebih kuat membimbing rangkaian pelajar (lihat isyarat anak panah merah jambu dalam Rajah 2 sebaliknya, apabila rangkaian pelajar mempunyai kejarang yang lebih tinggi Oleh itu, dekan akan memberikan isyarat penyeliaan jarang yang lebih kuat pada rangkaian pelajar (lihat isyarat anak panah oren dalam Rajah 2).

Rajah 2 Gambarajah skematik algoritma pemampatan model berdasarkan pembelajaran bersama kebolehsulingan dan kezatan

Hasil eksperimen

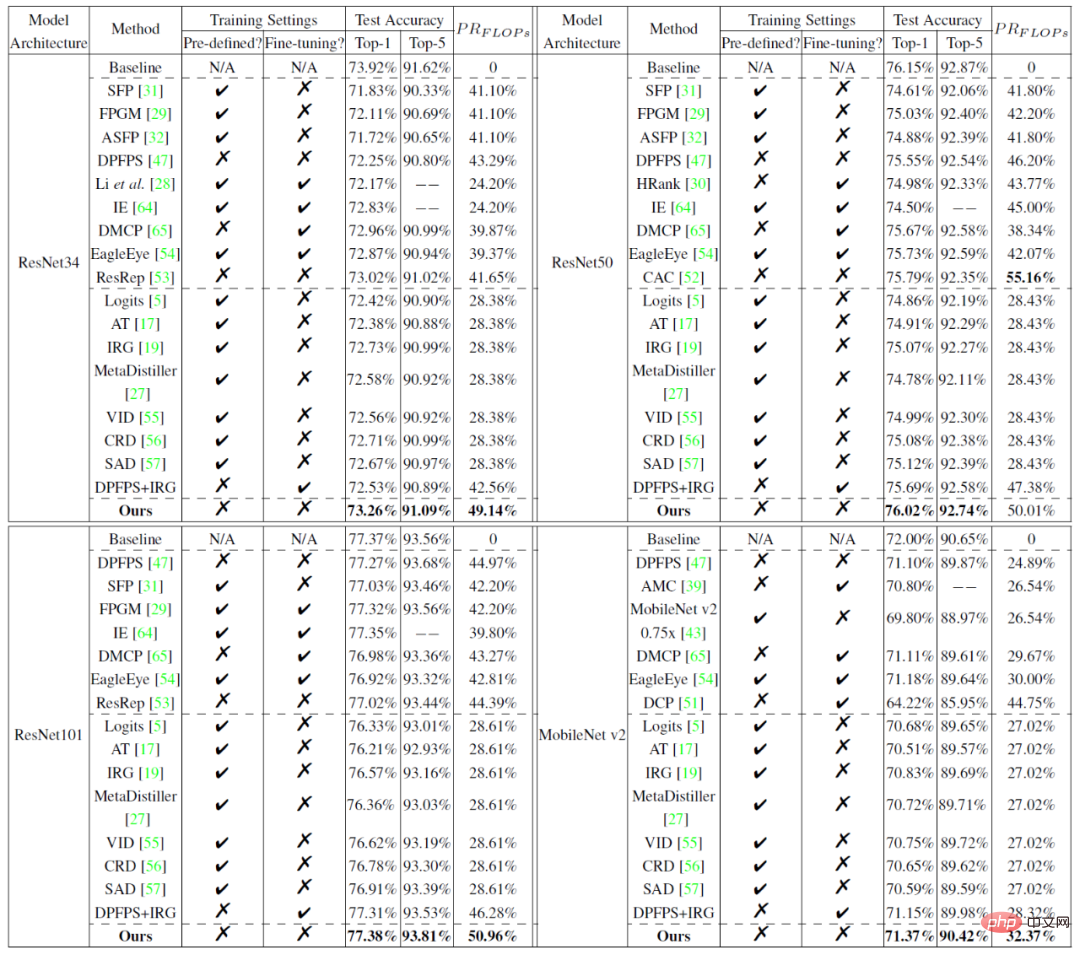

Percubaan membandingkan kaedah yang dicadangkan dalam artikel ini dengan 24 kaedah pemampatan model arus perdana (termasuk kaedah keratan jarang dan kaedah pembelajaran penyulingan) pada set data berskala kecil CIFAR dan set data berskala besar ImageNet. Keputusan eksperimen ditunjukkan dalam rajah di bawah, yang membuktikan keunggulan kaedah yang dicadangkan dalam artikel ini.

Jadual 1 Perbandingan prestasi hasil pemangkasan model pada CIFAR10:

Jadual 2 tentang perbandingan Prestasi ImageNet hasil pemangkasan model:

Untuk butiran penyelidikan lanjut, sila rujuk kertas asal.

Atas ialah kandungan terperinci Buat pertama kalinya, 'Pengarah Pengajaran' diperkenalkan ke dalam penyulingan model, dan pemampatan berskala besar adalah lebih baik daripada 24 kaedah SOTA.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI