Rumah >Peranti teknologi >AI >Berpura-pura menjadi pengarang manusia, ChatGPT dan penyalahgunaan lain menimbulkan kebimbangan, sebuah artikel meringkaskan kaedah pengesanan teks yang dijana AI

Berpura-pura menjadi pengarang manusia, ChatGPT dan penyalahgunaan lain menimbulkan kebimbangan, sebuah artikel meringkaskan kaedah pengesanan teks yang dijana AI

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-14 14:10:031239semak imbas

Kemajuan terkini dalam teknologi penjanaan bahasa semula jadi (NLG) telah meningkatkan kepelbagaian, kawalan dan kualiti teks yang dihasilkan oleh model bahasa besar dengan ketara. Satu contoh yang ketara ialah ChatGPT OpenAI, yang telah menunjukkan prestasi unggul dalam tugas seperti menjawab soalan, menulis e-mel, kertas dan kod. Walau bagaimanapun, keupayaan baru untuk menjana teks dengan cekap ini juga menimbulkan kebimbangan tentang pengesanan dan pencegahan penyalahgunaan model bahasa besar dalam tugas seperti pancingan data, maklumat salah dan ketidakjujuran akademik. Contohnya, disebabkan kebimbangan tentang pelajar yang menggunakan ChatGPT untuk menulis kerja rumah, sekolah awam New York melarang penggunaan ChatGPT, dan media juga mengeluarkan amaran tentang berita palsu yang dihasilkan oleh model bahasa yang besar. Kebimbangan tentang penyalahgunaan model bahasa besar ini telah menghalang penggunaan penjanaan bahasa semula jadi dalam bidang penting seperti media dan pendidikan.

Terdapat perbincangan yang semakin meningkat baru-baru ini tentang sama ada dan cara mengesan teks yang dihasilkan oleh model bahasa besar dengan betul Artikel ini menyediakan pengenalan teknikal yang komprehensif kepada kaedah pengesanan sedia ada.

- Alamat kertas: https://github.com/datamllab/The-Science- of-LLM-generated-Text-Detection

- Alamat penyelidikan berkaitan: https://github.com/datamllab/awsome-LLM-generated-text-detection /tree/main

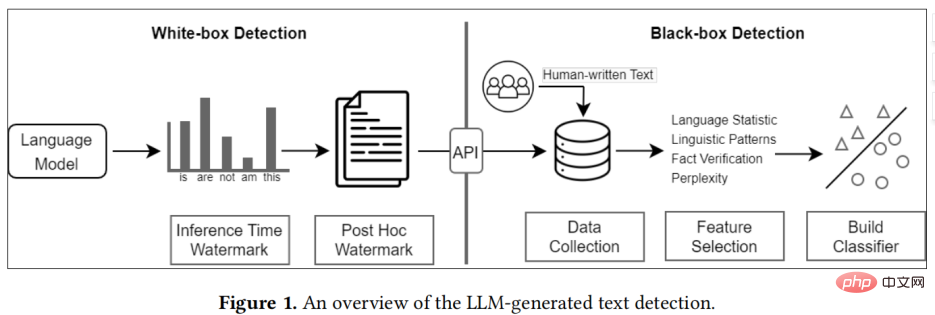

Kaedah sedia ada boleh dibahagikan secara kasar kepada dua kategori: Pengesanan kotak hitam dan pengesanan kotak putih.

Gambaran Keseluruhan Penjanaan Model Bahasa Besar untuk Pengesanan Teks

- Kaedah pengesanan kotak hitam biasanya hanya mempunyai akses peringkat API kepada model bahasa yang besar. Oleh itu, pendekatan jenis ini bergantung pada pengumpulan sampel teks daripada manusia dan mesin untuk melatih model klasifikasi; Jejak dan kesan teks yang dijana dengan mengawal gelagat penjanaan model atau menambahkan tera air pada teks yang dijana.

- Secara praktiknya, pengesan kotak hitam biasanya dibina oleh pihak ketiga, seperti GPTZero, manakala pengesan kotak putih biasanya dibina oleh pembangun model bahasa besar.

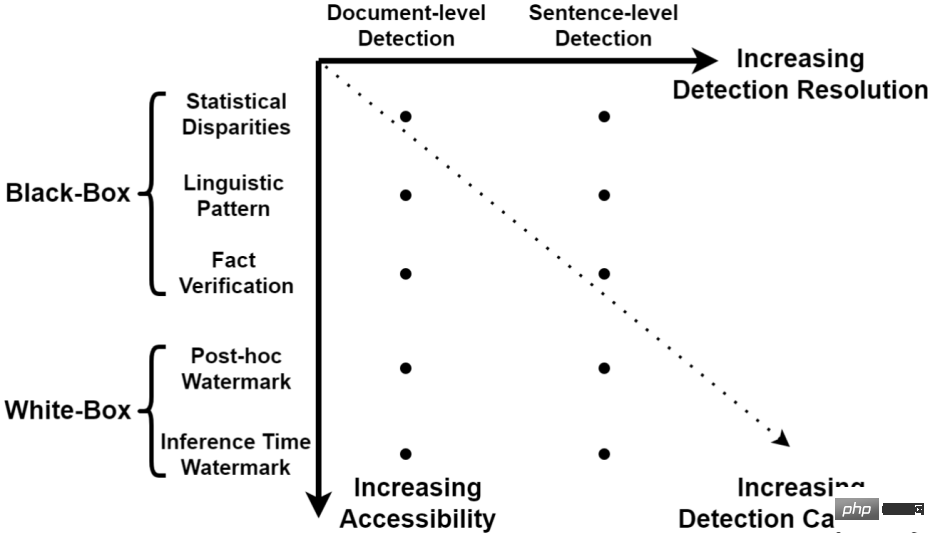

Taksonomi pengesanan teks yang dijanaPengesanan kotak hitam

Pengesanan kotak hitam secara amnya mempunyai tiga langkah, iaitu pengumpulan data, pemilihan ciri dan penubuhan model. Untuk pengumpulan teks manusia, satu kaedah ialah merekrut profesional untuk pengumpulan data, tetapi kaedah ini memakan masa dan intensif buruh serta tidak sesuai untuk pengumpulan data yang besar set. Kaedah yang lebih cekap ialah menggunakan data teks manusia sedia ada, seperti mengumpul entri yang disunting oleh pelbagai pakar daripada Wikipedia, atau mengumpul data daripada media, seperti Reddit.

Pemilihan ciri secara amnya dibahagikan kepada ciri statistik, ciri linguistik dan ciri fakta. Ciri statistik biasanya digunakan untuk menyemak sama ada teks yang dijana oleh model bahasa besar berbeza daripada teks manusia dalam beberapa penunjuk statistik teks yang biasa digunakan termasuk TFIDF, Undang-undang Zip

, dsb. Ciri linguistik umumnya mencari beberapa ciri linguistik, seperti bahagian pertuturan,analisis kebergantungan , analisis sentimen, dsb. Akhir sekali, model bahasa besar selalunya menghasilkan pernyataan kontrafaktual, jadi pengesahan fakta juga boleh memberikan beberapa maklumat yang membezakan teks yang dijana oleh model bahasa besar. Model klasifikasi sedia ada biasanya dibahagikan kepada model pembelajaran mesin tradisional, seperti SVM. Penyelidikan terkini cenderung menggunakan model bahasa sebagai tulang belakang, seperti BERT dan RoBERTa, dan telah mencapai prestasi pengesanan yang lebih tinggi.

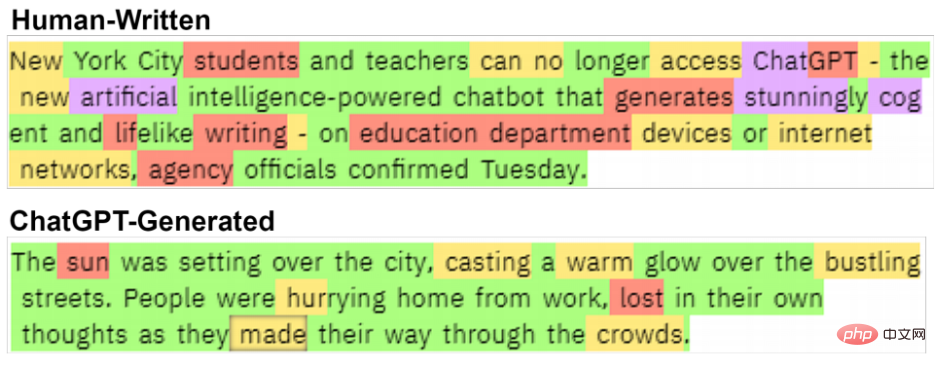

Terdapat perbezaan yang jelas antara kedua-dua teks ini. teks tulisan manusia dari Chalkbeat New York.

Pengesanan kotak putih

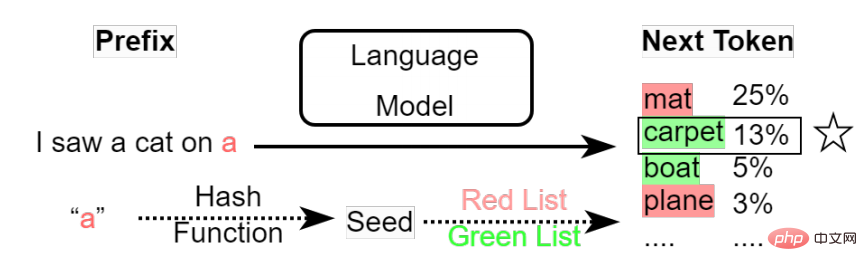

Pengesanan kotak putih biasanya lalai kepada pengesanan yang disediakan oleh pembangun model bahasa besar. Berbeza daripada pengesanan kotak hitam, pengesanan kotak putih mempunyai akses penuh kepada model, jadi ia boleh membenamkan tera air dengan menukar output model untuk mencapai tujuan pengesanan.

Kaedah pengesanan semasa boleh dibahagikan kepada tera air post-hoc dan tera air masa inferens :

- Tanda air post-hoc adalah untuk menambah beberapa maklumat tersembunyi pada teks untuk pengesanan seterusnya selepas model bahasa besar telah menjana teks; untuk menukar mekanisme pensampelan token model bahasa besar untuk menambah tera air Dalam proses menjana setiap token oleh model bahasa besar, ia akan memilih perkataan yang dijana seterusnya berdasarkan kebarangkalian semua token dan strategi pensampelan yang telah ditetapkan Anda boleh menambah tera air dalam proses.

Pengarang bimbang

(1)Untuk model kotak hitam, pengumpulan data merupakan langkah yang sangat kritikal, tetapi proses ini adalah sangat mudah untuk memperkenalkan bias. Sebagai contoh, set data sedia ada tertumpu terutamanya pada beberapa tugas seperti menjawab soalan dan penjanaan cerita, yang memperkenalkan kecenderungan subjek. Selain itu, teks yang dihasilkan oleh model besar selalunya mempunyai gaya atau format tetap. Bias ini sering digunakan oleh pengelas kotak hitam sebagai ciri utama untuk pengelasan dan mengurangkan keteguhan pengesanan. Apabila keupayaan model bahasa berskala besar bertambah baik, jurang antara teks yang dihasilkan oleh model bahasa berskala besar dan manusia akan menjadi lebih kecil dan lebih kecil, mengakibatkan ketepatan pengesanan warna hitam. -model kotak semakin rendah Oleh itu, pengesanan kotak putih adalah kaedah pengesanan yang lebih menjanjikan pada masa hadapan.

(2)

Kaedah pengesanan sedia ada lalai kepada model bahasa besar yang dimiliki oleh syarikat, jadi semua Pengguna memperoleh perkhidmatan model bahasa berskala besar syarikat melalui API perhubungan banyak dengan satu ini sangat berguna untuk penggunaan sistem pengesanan. Tetapi jika syarikat sumber terbuka model bahasa yang besar, ini akan menyebabkan hampir semua kaedah pengesanan sedia ada menjadi tidak berkesan. Untuk pengesanan kotak hitam, kerana pengguna boleh memperhalusi model mereka dan menukar gaya atau format output model, pengesanan kotak hitam tidak dapat mencari ciri pengesanan biasa.

Pengesanan kotak putih mungkin penyelesaiannya. Walau bagaimanapun, pengguna juga boleh memperhalusi model dan menukar mekanisme pensampelan token model untuk mengalih keluar tera air. Pada masa ini tiada teknologi penanda air yang boleh melindungi pengguna daripada potensi ancaman ini.

Atas ialah kandungan terperinci Berpura-pura menjadi pengarang manusia, ChatGPT dan penyalahgunaan lain menimbulkan kebimbangan, sebuah artikel meringkaskan kaedah pengesanan teks yang dijana AI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI