Rumah >Peranti teknologi >AI >Hampir sepuluh ribu orang menonton ucapan terbaharu Hinton: Algoritma latihan rangkaian saraf ke hadapan ke hadapan, kertas itu telah diumumkan kepada umum

Hampir sepuluh ribu orang menonton ucapan terbaharu Hinton: Algoritma latihan rangkaian saraf ke hadapan ke hadapan, kertas itu telah diumumkan kepada umum

- 王林ke hadapan

- 2023-04-14 10:22:071128semak imbas

Persidangan NeurIPS 2022 sedang giat dijalankan Pakar dan cendekiawan dari semua lapisan masyarakat sedang berkomunikasi dan berbincang tentang pembelajaran mendalam, penglihatan komputer, pembelajaran mesin berskala besar, teori pembelajaran, pengoptimuman, teori sparsity dan banyak lagi. sub-bidang.

Pada mesyuarat itu, pemenang Anugerah Turing dan perintis pembelajaran mendalam Geoffrey Hinton telah dijemput untuk memberi ucapan sebagai pengiktirafan terhadap kertas kerja "ImageNet Classification" yang beliau tulis bersama sepuluh tahun lalu dengan graduannya pelajar Alex Krizhevsky dan Ilya Sutskever dengan Deep Convolutional Neural Networks," yang telah dianugerahkan Hadiah Ujian Masa untuk "impak yang luar biasa" di atas padang. Diterbitkan pada tahun 2012, kerja ini merupakan kali pertama rangkaian saraf konvolusi mencapai prestasi peringkat manusia dalam pertandingan pengecaman imej ImageNet, dan ia merupakan acara penting yang melancarkan gelombang ketiga kecerdasan buatan.

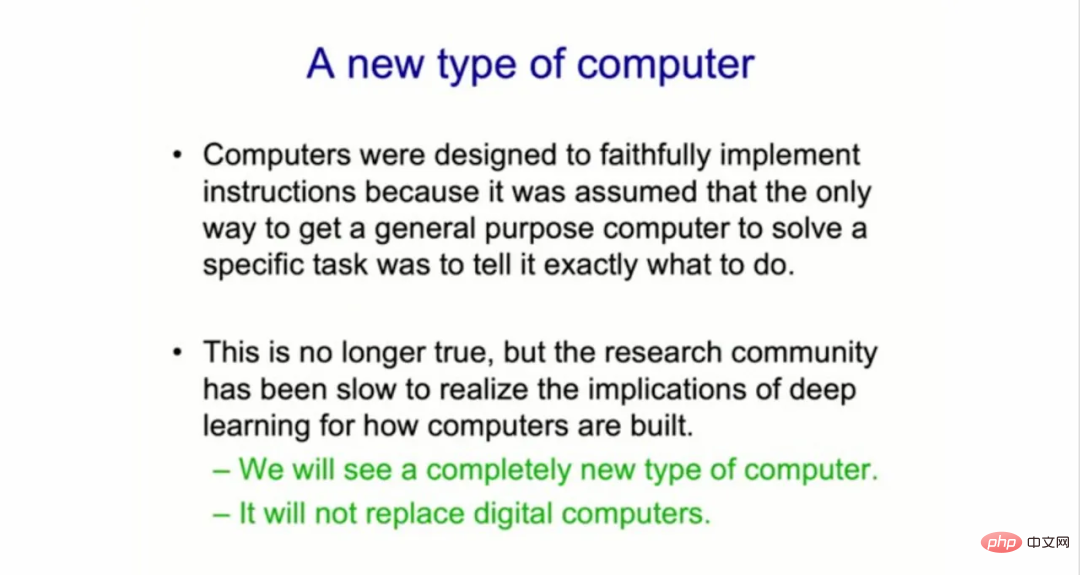

Hinton Tema ucapan ini ialah "Algoritma Hadapan-Hadapan untuk Melatih Rangkaian Neural Dalam". Dalam ucapannya, Geoffrey Hinton berkata, "Komuniti penyelidikan pembelajaran mesin telah lambat menyedari kesan pembelajaran mendalam terhadap cara komputer dibina." akan mencetuskan Revolusi dalam sistem komputer , ini ialah gabungan perisian dan perkakasan baharu yang meletakkan AI "ke dalam pembakar roti anda". Dia menyambung, "Saya fikir kita akan melihat jenis komputer yang sama sekali berbeza yang tidak akan dapat dilakukan selama beberapa tahun. Tetapi ada sebab yang baik untuk melihat perkara ini jenis komputer yang sama sekali berbeza." Komputer. 》

Membina jenis komputer baharu yang berbeza sama sekali

Sehingga kini, semua digital komputer telah dibina untuk menjadi "abadi" (abadi), di mana perkakasan direka untuk menjadi sangat boleh dipercayai supaya perisian yang sama boleh dijalankan di mana-mana. "Kami boleh menjalankan program yang sama pada perkakasan fizikal yang berbeza, dan pengetahuannya kekal abadi." "Itu mungkin sangat berguna kepada kita.

Pada pandangan Hinton,

Sistem komputer masa depan akan mengambil pendekatan yang berbeza: mereka akan menjadi "neuromorphic" dan biasa ( fana)

. Ini bermakna setiap komputer akan menjadi gabungan ketat perisian rangkaian saraf dan perkakasan terputus-putus, dalam erti kata mempunyai komponen analog dan bukannya digital, yang boleh mengandungi unsur ketidakpastian dan berkembang dari semasa ke semasa. Hinton menjelaskan, “Alternatifnya sekarang ialah kami akan meninggalkan pengasingan perkakasan dan perisian, tetapi saintis komputer benar-benar tidak menyukainya. 》

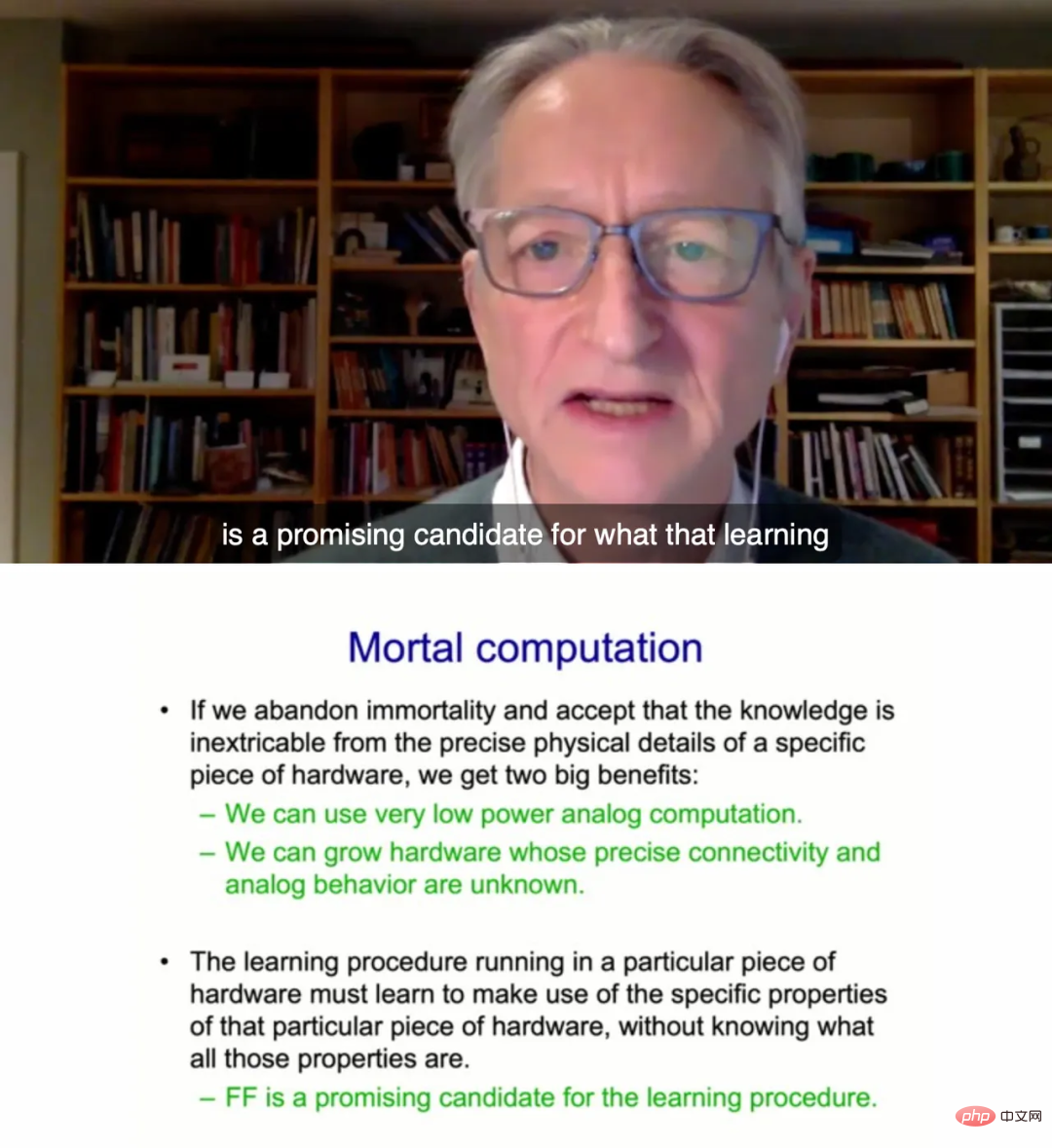

Apa yang dipanggil pengiraan mortal bermaksud pengetahuan yang dipelajari oleh sistem tidak dapat dipisahkan daripada perkakasan. Komputer biasa ini boleh "berkembang" daripada kilang pembuatan cip yang mahal.

Apa yang dipanggil pengiraan mortal bermaksud pengetahuan yang dipelajari oleh sistem tidak dapat dipisahkan daripada perkakasan. Komputer biasa ini boleh "berkembang" daripada kilang pembuatan cip yang mahal.

Hinton menegaskan bahawa jika kita melakukan ini, kita boleh menggunakan pengiraan analog berkuasa sangat rendah dan menggunakan pemberat memristor untuk melakukan teraflops pemprosesan selari. Ini merujuk kepada cip eksperimen berusia beberapa dekad berdasarkan komponen litar tak linear. Di samping itu, kami boleh mengembangkan perkakasan tanpa memahami kualiti tepat tingkah laku tepat bagi bit perkakasan yang berbeza.

Walau bagaimanapun, Hinton juga berkata bahawa komputer biasa baharu itu tidak akan menggantikan komputer digital tradisional "Ia bukan komputer yang mengawal akaun bank anda, dan ia juga tidak tahu berapa banyak anda mempunyai wang. boleh bercakap dengan pembakar roti anda menggunakan hanya beberapa watt kuasa.

Rangkaian FF sesuai untuk perkakasan pengkomputeran biasa

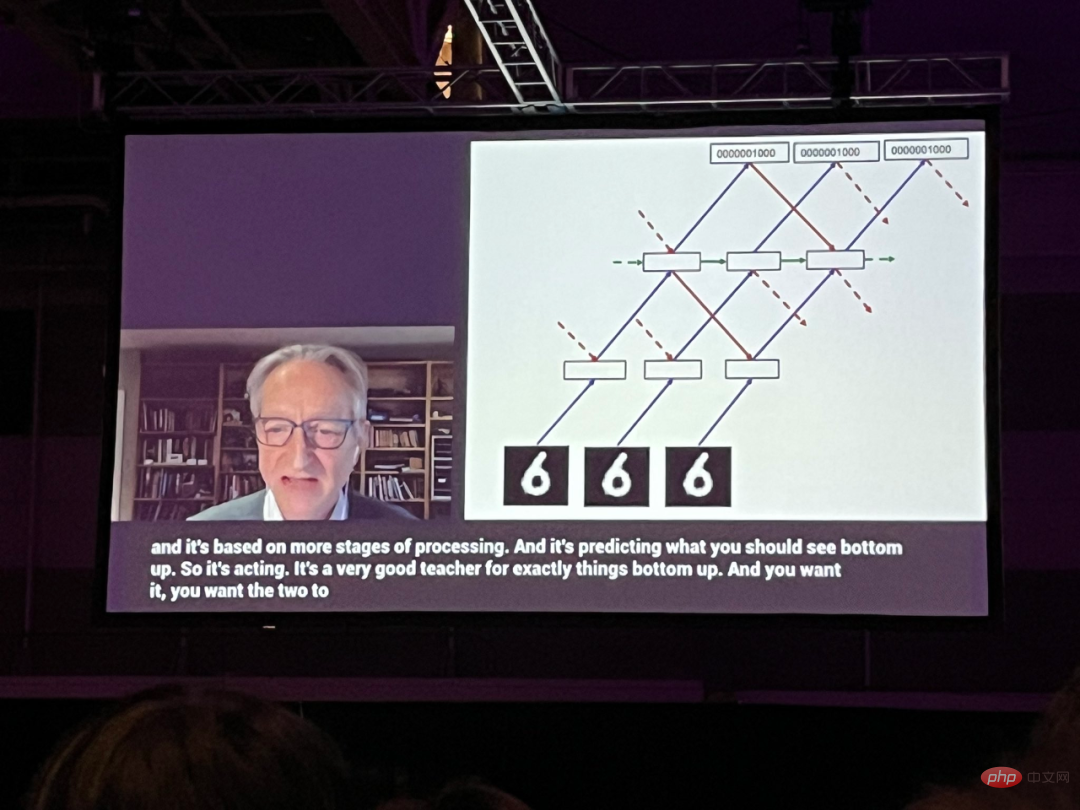

Dalam ceramah ini, Hinton menghabiskan sebahagian besar masa bercakap tentang kaedah rangkaian saraf baharu, yang dipanggilnya Ia ialah rangkaian Forward-Forward (FF), yang menggantikan teknik perambatan belakang yang digunakan dalam hampir semua rangkaian saraf. Hinton mencadangkan bahawa dengan mengalih keluar perambatan belakang, rangkaian hadapan mungkin lebih munasabah menghampiri apa yang berlaku di dalam otak dalam kehidupan sebenar.

Draf kertas kerja ini disiarkan di laman utama Hinton di Universiti Toronto:

Pautan kertas: https://www.cs.toronto.edu/~hinton/FFA13.pdf

Hinton berkata bahawa kaedah FF mungkin lebih sesuai untuk perkakasan pengkomputeran biasa. "Untuk melakukan sesuatu seperti ini pada masa ini, kita perlu mempunyai program pembelajaran yang akan dijalankan dalam perkakasan proprietari, dan ia perlu belajar untuk mengeksploitasi sifat khusus perkakasan proprietari itu, tanpa mengetahui apakah semua sifat itu. Tetapi saya fikir algoritma ke hadapan ialah Pilihan yang berpotensi. "

Satu halangan untuk membina komputer analog baharu, katanya, adalah kepentingan diletakkan pada kebolehpercayaan menjalankan perisian pada berjuta-juta peranti. "Setiap telefon ini perlu bermula sebagai telefon bayi, dan ia perlu belajar bagaimana untuk menjadi telefon," kata Hinton. "Dan ia sangat menyakitkan."

Hinton berkata: "Masih sangat sedikit orang yang berminat dalam pengkomputeran analog yang sanggup melepaskan keabadian. Ini kerana keterikatan kepada konsistensi, kebolehramalan. Tetapi jika Anda mahu perkakasan analog melakukan perkara yang sama setiap kali, dan lambat laun anda menghadapi masalah sebenar dengan semua kekacauan ini Hinton memperkenalkan prosedur pembelajaran rangkaian saraf baru dan secara eksperimen menunjukkan bahawa ia berfungsi dengan cukup baik pada beberapa masalah kecil. Kandungan khusus adalah seperti berikut:

Apakah yang salah dengan penyebaran balik?

Kejayaan pembelajaran mendalam sepanjang dekad yang lalu telah membuktikan keberkesanan melakukan penurunan kecerunan stokastik dengan sejumlah besar parameter dan sejumlah besar data. Kecerunan biasanya dikira dengan perambatan balik, yang telah menyebabkan minat sama ada otak melaksanakan perambatan balik atau sama ada terdapat cara lain untuk mendapatkan kecerunan yang diperlukan untuk melaraskan berat sambungan.Penyebaran balik kekal tidak munasabah sebagai model bagaimana korteks serebrum belajar, walaupun banyak usaha untuk melaksanakannya seperti neuron sebenar. Pada masa ini tiada bukti yang meyakinkan bahawa korteks serebrum secara eksplisit menyebarkan derivatif ralat atau menyimpan aktiviti saraf untuk digunakan dalam perambatan belakang berikutnya. Sambungan atas ke bawah dari satu kawasan kortikal ke kawasan lebih awal dalam laluan visual tidak seperti yang dijangkakan, iaitu, sambungan bawah ke atas akan berlaku jika perambatan belakang digunakan dalam sistem visual. Sebaliknya, mereka membentuk gelung di mana aktiviti saraf melalui kira-kira setengah dozen lapisan kortikal di dua kawasan dan kemudian kembali ke tempat ia bermula.

Penyebaran balik melalui masa amat tidak boleh dipercayai sebagai cara untuk mempelajari urutan. Untuk memproses aliran input deria tanpa tamat masa yang kerap, otak perlu menyalurkan data deria melalui pelbagai peringkat pemprosesan deria Ia memerlukan program pembelajaran yang boleh belajar "dengan cepat." Perwakilan dalam peringkat saluran paip kemudiannya mungkin memberikan maklumat atas ke bawah yang mempengaruhi perwakilan dalam peringkat awal saluran paip dalam langkah masa berikutnya, tetapi sistem persepsi perlu membuat alasan dan belajar dalam masa nyata tanpa berhenti untuk melakukan perambatan balik.Satu lagi had serius perambatan belakang ialah ia memerlukan pengetahuan lengkap tentang pengiraan yang dilakukan dalam hantaran hadapan untuk mengira derivatif yang betul. Jika kita memasukkan kotak hitam dalam hantaran hadapan, maka perambatan belakang tidak lagi boleh dilakukan melainkan kita mempelajari model kotak hitam yang boleh dibezakan. Seperti yang akan kita lihat, kotak hitam tidak mengubah prosedur pembelajaran algoritma FF sama sekali, kerana tidak ada keperluan untuk melakukan backpropagate melaluinya.

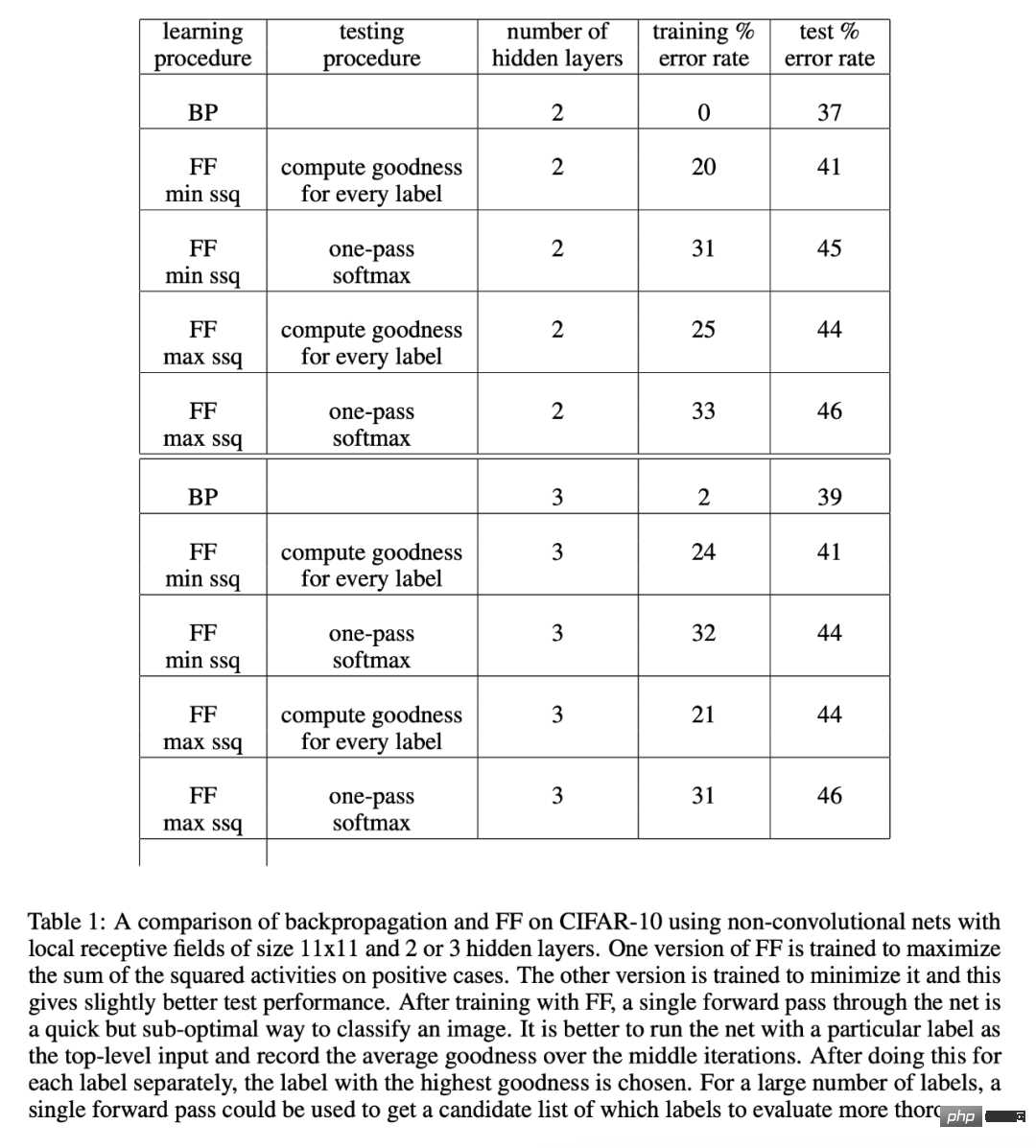

Dengan ketiadaan model lulus hadapan yang sempurna, seseorang mungkin menggunakan salah satu daripada banyak bentuk pembelajaran pengukuhan. Ideanya adalah untuk melakukan gangguan rawak pada pemberat atau aktiviti saraf dan mengaitkan gangguan ini dengan perubahan dalam fungsi hasil. Tetapi program pembelajaran pengukuhan mengalami kebolehubahan yang tinggi: sukar untuk melihat kesan mengganggu satu pembolehubah apabila banyak pembolehubah lain terganggu secara serentak. Untuk meratakan bunyi bising yang disebabkan oleh semua gangguan lain, kadar pembelajaran perlu berkadar songsang dengan bilangan pembolehubah yang terganggu, yang bermaksud bahawa skala pembelajaran pengukuhan adalah buruk dan tidak boleh dibandingkan dengan songsang untuk rangkaian besar yang mengandungi berjuta-juta atau berbilion-bilion parameter persaingan komunikasi. Maksud utama kertas kerja ini ialah rangkaian saraf yang mengandungi ketaklinearan yang tidak diketahui tidak perlu menggunakan pembelajaran pengukuhan. Algoritma FF adalah setanding dalam kelajuan dengan perambatan belakang, tetapi mempunyai kelebihan digunakan apabila butiran tepat pengiraan hadapan tidak diketahui. Ia juga mempunyai kelebihan kerana dapat belajar sambil disalurkan pada data berjujukan melalui rangkaian saraf, tanpa perlu menyimpan aktiviti saraf atau berhenti menyebarkan derivatif ralat. Secara amnya, algoritma FF adalah lebih perlahan daripada perambatan belakang, dan generalisasinya tidak sesuai untuk beberapa masalah mainan yang dikaji dalam artikel ini, jadi apabila kuasa rendah Ia tidak mungkin menggantikan perambatan balik dalam aplikasi yang terlalu terhad. Untuk model yang sangat besar yang dilatih pada set data yang sangat besar, jenis penerokaan ini akan terus menggunakan perambatan balik. Algoritma FF mungkin lebih baik daripada perambatan belakang dalam dua aspek, satu adalah sebagai model pembelajaran korteks serebrum, dan satu lagi adalah sebagai penggunaan perkakasan simulasi kuasa sangat rendah tanpa menggunakan tetulang pembelajaran. Algoritma Hadapan-Hadapan ialah prosedur pembelajaran berbilang lapisan tamak yang diilhamkan oleh mesin Boltzmann dan anggaran kontrastif hingar. Ideanya adalah untuk menggantikan hantaran ke hadapan dan ke belakang bagi rambatan ke belakang dengan dua hantaran ke hadapan , kedua-dua hantaran hadapan ini berada dalam cara yang sama Beroperasi antara satu sama lain, tetapi pada data yang berbeza, dengan matlamat yang bertentangan. Antaranya, pas positif beroperasi pada data sebenar dan melaraskan pemberat untuk meningkatkan kebaikan dalam setiap lapisan tersembunyi; Dalam kertas itu, Hinton menunjukkan prestasi algoritma FF melalui eksperimen pada CIFAR-10. CIFAR-10 mempunyai 50,000 imej latihan yang bersaiz 32 x 32 piksel dengan tiga saluran warna setiap piksel. Oleh itu, setiap imej mempunyai 3072 dimensi. Latar belakang imej ini adalah kompleks dan sangat berubah-ubah, dan tidak boleh dimodelkan dengan baik dengan data latihan yang terhad. Secara umumnya, apabila rangkaian yang disambungkan sepenuhnya dengan dua hingga tiga lapisan tersembunyi dilatih dengan kaedah perambatan belakang, melainkan lapisan tersembunyi adalah sangat kecil, kesan overfitting adalah sangat lemah, jadi hampir semua keputusan yang dilaporkan adalah untuk rangkaian konvolusi. Memandangkan FF bertujuan untuk digunakan dalam rangkaian di mana perkongsian berat tidak boleh dilaksanakan, ia dibandingkan dengan rangkaian perambatan belakang, yang menggunakan medan penerimaan tempatan untuk mengehadkan bilangan pemberat, tanpa mengehadkan terlalu banyak bilangan unit tersembunyi. Tujuannya hanyalah untuk menunjukkan bahawa, dengan sejumlah besar unit tersembunyi, FF berprestasi setanding dengan perambatan belakang untuk imej yang mengandungi latar belakang yang sangat berubah-ubah. Jadual 1 menunjukkan prestasi ujian rangkaian yang dilatih dengan perambatan belakang dan FF, yang kedua-duanya menggunakan pereputan berat untuk mengurangkan pemasangan berlebihan. Untuk butiran penyelidikan lanjut, sila rujuk kertas asal. Algoritma FF

Atas ialah kandungan terperinci Hampir sepuluh ribu orang menonton ucapan terbaharu Hinton: Algoritma latihan rangkaian saraf ke hadapan ke hadapan, kertas itu telah diumumkan kepada umum. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI