Peranti teknologi

Peranti teknologi AI

AI DetectGPT: Pengesanan teks janaan mesin tangkapan sifar menggunakan kelengkungan probabilistik

DetectGPT: Pengesanan teks janaan mesin tangkapan sifar menggunakan kelengkungan probabilistikDetectGPT: Pengesanan teks janaan mesin tangkapan sifar menggunakan kelengkungan probabilistik

Tujuan DetectGPT adalah untuk menentukan sama ada sekeping teks dijana oleh llm tertentu, seperti GPT-3. Untuk mengklasifikasikan perenggan x, DetectGPT mula-mula menjana gangguan kecil pada perenggan ~xi menggunakan model pra-latihan biasa (cth., T5). DetectGPT kemudian membandingkan kebarangkalian log sampel asal x dengan setiap sampel terganggu ~xi. Jika nisbah log purata adalah tinggi, sampel mungkin daripada model sumber.

ChatGPT ialah topik hangat. Terdapat perbincangan berterusan tentang sama ada mungkin untuk mengesan bahawa artikel telah dijana oleh model bahasa besar (LLM). DetectGPT mentakrifkan kriteria berasaskan kelengkungan baharu untuk menilai sama ada untuk menjana daripada LLM tertentu. DetectGPT tidak memerlukan latihan pengelas berasingan, mengumpul set data petikan sebenar atau terjana, atau menanda air teks yang dijana secara eksplisit. Ia hanya menggunakan kebarangkalian log yang dikira oleh model minat dan gangguan rawak artikel daripada model bahasa pralatih tujuan umum yang lain (cth., T5).

1. DetectGPT: Pilih atur rawak dan andaian

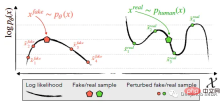

Mengenal pasti dan menggunakan saluran janaan mesin x~pθ (kiri) pada negatif logp (x) ) Trend dalam kawasan kelengkungan di mana sampel berdekatan mempunyai kebarangkalian log model yang lebih rendah secara purata. Sebaliknya, teks tulisan manusia x~preal(.) (kanan) cenderung untuk tidak menduduki kawasan dengan kelengkungan kebarangkalian log negatif yang ketara.

DetectGPT adalah berdasarkan andaian bahawa sampel daripada model sumber pθ biasanya terletak pada kawasan kelengkungan negatif fungsi kebarangkalian logaritma pθ, yang berbeza daripada teks manusia. Jika kita menggunakan gangguan kecil pada sekeping teks x~pθ, menghasilkan ~x, bilangan sampel yang dijana mesin log pθ(x) - log pθ(~x) sepatutnya agak besar berbanding dengan teks tulisan manusia. Dengan menggunakan andaian ini, mula-mula pertimbangkan fungsi gangguan q(.|x), yang memberikan taburan ke atas ~x, versi x yang diubah suai sedikit dengan makna yang serupa (biasanya pertimbangkan teks panjang perenggan x yang kasar). Sebagai contoh, q(.|x) mungkin hasil daripada hanya meminta manusia untuk menulis semula salah satu ayat untuk x sambil mengekalkan makna x. Dengan menggunakan konsep fungsi gangguan, perbezaan gangguan d (x; pθ, q) boleh ditakrifkan:

Oleh itu, andaian 4.1 berikut ialah :

Jika q(.|x) ialah sampel daripada model pengisi topeng (seperti T5) dan bukannya tulisan semula manusia, maka Andaian 4.1 boleh menjadi Pendekatan automatik, berskala untuk ujian empirikal.

2. DetectGPT: Ujian automatik

Selepas menulis semula artikel, kebarangkalian logaritma artikel yang dihasilkan oleh model ( The purata penurunan dalam perbezaan gangguan) sentiasa lebih tinggi daripada artikel tulisan manusia

Untuk data sebenar, 500 artikel berita daripada set data XSum telah digunakan. Menggunakan output empat llms berbeza apabila digesa untuk 30 token pertama setiap artikel dalam XSum. Gangguan digunakan menggunakan T5-3B, menutup rentang sampel rawak sebanyak 2 perkataan sehingga 15% daripada perkataan dalam artikel bertopeng. Jangkaan dalam persamaan (1) di atas dianggarkan oleh 100 sampel dalam T5.

Keputusan percubaan di atas menunjukkan bahawa terdapat perbezaan yang signifikan dalam taburan perbezaan gangguan antara artikel tulisan manusia dan sampel model selalunya mempunyai perbezaan gangguan yang lebih besar. Berdasarkan keputusan ini, adalah mungkin untuk mengesan sama ada sekeping teks dijana oleh model p dengan hanya mengambang perbezaan gangguan.

Menormalkan perbezaan gangguan dengan sisihan piawai pemerhatian yang digunakan untuk menganggarkan E~x q(.|x) log p (~x) menyediakan pengesanan yang lebih baik, biasanya meningkatkan AUROC sekitar 0.020 , jadi versi ternormal perbezaan gangguan digunakan dalam eksperimen.

Kesan kod pseudo proses pengesananGPT

Perbezaan gangguan mungkin berguna, perkara yang diukur tidak dapat dijelaskan dengan jelas, jadi pengarang dalam bahagian seterusnya Gunakan kelengkungan untuk terangkan.

3. Tafsirkan perbezaan gangguan sebagai kelengkungan

Perbezaan gangguan menghampiri ukuran kelengkungan tempatan fungsi kebarangkalian log berhampiran petikan calon, lebih khusus, ia selaras dengan Hessian of fungsi kebarangkalian log Surih negatif matriks adalah berkadar.

Bahagian ini mempunyai banyak kandungan, jadi saya tidak akan menerangkannya secara terperinci di sini Jika anda berminat, anda boleh membaca kertas asal, yang secara kasarnya diringkaskan seperti berikut:

Persampelan dalam ruang semantik memastikan semua sampel kekal dekat dengan manifold data, memandangkan kebarangkalian log dijangka sentiasa berkurangan jika penanda gangguan ditambah secara rawak. Jadi matlamat boleh ditafsirkan sebagai lebih kurang mengekang kelengkungan pada manifold data.

4. Paparan keputusan

Pengesanan teks janaan mesin tangkapan sifar

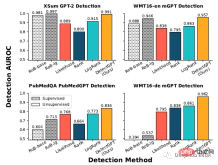

Setiap percubaan menggunakan 150 hingga 500 contoh untuk penilaian. Teks yang dijana mesin dijana dengan menggesa 30 token pertama teks sebenar. Gunakan AUROC) untuk menilai prestasi.

Dapat dilihat bahawa DetectGPT memaksimumkan ketepatan pengesanan purata cerita XSum (AUROC meningkat sebanyak 0.1) dan konteks Wikipedia SQuAD (AUROC meningkat sebanyak 0.05).

Untuk 14 daripada 15 kombinasi set data dan model, DetectGPT menyediakan prestasi pengesanan paling tepat, dengan purata peningkatan dalam AUROC sebanyak 0.06.

Perbandingan dengan pengesan diselia

Model pengesanan teks janaan mesin diselia dilatih pada set data besar teks sebenar dan terjana dalam Prestasi pada teks dalam pengedaran (baris atas) adalah sebaik DetectGPT, atau lebih baik. Kaedah sifar pukulan digunakan pada domain baharu (baris bawah) seperti teks perubatan PubMed dan data berita Jerman dalam WMT16.

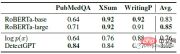

Dinilai pada 200 sampel daripada setiap set data, pengesan yang diselia menunjukkan prestasi yang sama seperti DetectGPT pada data dalam pengedaran seperti berita Inggeris, tetapi dalam kes penulisan saintifik bahasa Inggeris, prestasinya jauh lebih teruk daripada pendekatan sampel sifar, yang gagal sepenuhnya dalam tulisan Jerman.

Purata AUROC DetectGPT untuk GPT-3 adalah setanding dengan model diselia yang dilatih khusus untuk pengesanan teks janaan mesin.

150 contoh diekstrak daripada dataset PubMedQA, XSum dan writingprompt. Dua model pengesan berasaskan roberta pra-terlatih dibandingkan dengan DetectGPT dan garis dasar ambang kemungkinan. DetectGPT boleh menyediakan pengesanan yang bersaing dengan model seliaan yang lebih berkuasa.

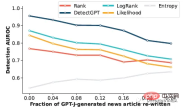

Variasi pengesanan teks janaan mesin

Bahagian ini adalah untuk melihat sama ada pengesan boleh mengesan teks jana mesin yang diedit manusia. Semakan manual telah disimulasikan dengan menggantikan 5 rentang perkataan teks dengan sampel dari T5–3B sehingga r% teks diganti. DetectGPT dapat mengekalkan pengesanan AUROC melebihi 0.8 walaupun hampir satu perempat daripada teks dalam sampel model telah diganti. DetectGPT menunjukkan prestasi pengesanan terkuat merentas semua peringkat semakan.

Atas ialah kandungan terperinci DetectGPT: Pengesanan teks janaan mesin tangkapan sifar menggunakan kelengkungan probabilistik. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Membaca Indeks AI 2025: Adakah AI rakan, musuh, atau juruterbang bersama?Apr 11, 2025 pm 12:13 PM

Membaca Indeks AI 2025: Adakah AI rakan, musuh, atau juruterbang bersama?Apr 11, 2025 pm 12:13 PMLaporan Indeks Perisikan Buatan 2025 yang dikeluarkan oleh Stanford University Institute for Manusia Berorientasikan Kecerdasan Buatan memberikan gambaran yang baik tentang revolusi kecerdasan buatan yang berterusan. Mari kita menafsirkannya dalam empat konsep mudah: kognisi (memahami apa yang sedang berlaku), penghargaan (melihat faedah), penerimaan (cabaran muka), dan tanggungjawab (cari tanggungjawab kita). Kognisi: Kecerdasan buatan di mana -mana dan berkembang pesat Kita perlu menyedari betapa cepatnya kecerdasan buatan sedang berkembang dan menyebarkan. Sistem kecerdasan buatan sentiasa bertambah baik, mencapai hasil yang sangat baik dalam ujian matematik dan pemikiran kompleks, dan hanya setahun yang lalu mereka gagal dalam ujian ini. Bayangkan AI menyelesaikan masalah pengekodan kompleks atau masalah saintifik peringkat siswazah-sejak tahun 2023

Bermula dengan Meta Llama 3.2 - Analytics VidhyaApr 11, 2025 pm 12:04 PM

Bermula dengan Meta Llama 3.2 - Analytics VidhyaApr 11, 2025 pm 12:04 PMMeta's Llama 3.2: Lompat ke hadapan dalam Multimodal dan Mobile AI META baru -baru ini melancarkan Llama 3.2, kemajuan yang ketara dalam AI yang memaparkan keupayaan penglihatan yang kuat dan model teks ringan yang dioptimumkan untuk peranti mudah alih. Membina kejayaan o

AV Bytes: Meta ' s llama 3.2, Google's Gemini 1.5, dan banyak lagiApr 11, 2025 pm 12:01 PM

AV Bytes: Meta ' s llama 3.2, Google's Gemini 1.5, dan banyak lagiApr 11, 2025 pm 12:01 PMLandskap AI minggu ini: Badai kemajuan, pertimbangan etika, dan perdebatan pengawalseliaan. Pemain utama seperti Openai, Google, Meta, dan Microsoft telah melepaskan kemas kini, dari model baru yang terobosan ke peralihan penting di LE

Kos manusia bercakap dengan mesin: Bolehkah chatbot benar -benar peduli?Apr 11, 2025 pm 12:00 PM

Kos manusia bercakap dengan mesin: Bolehkah chatbot benar -benar peduli?Apr 11, 2025 pm 12:00 PMIlusi yang menghiburkan sambungan: Adakah kita benar -benar berkembang dalam hubungan kita dengan AI? Soalan ini mencabar nada optimis Simposium MIT Media Lab "yang memajukan AI (AHA)". Manakala acara itu mempamerkan cutting-EDG

Memahami Perpustakaan Scipy di PythonApr 11, 2025 am 11:57 AM

Memahami Perpustakaan Scipy di PythonApr 11, 2025 am 11:57 AMPengenalan Bayangkan anda seorang saintis atau jurutera menangani masalah kompleks - persamaan pembezaan, cabaran pengoptimuman, atau analisis Fourier. Kemudahan penggunaan dan kemampuan grafik Python menarik, tetapi tugas -tugas ini menuntut alat yang berkuasa

3 Kaedah untuk menjalankan Llama 3.2 - Analytics VidhyaApr 11, 2025 am 11:56 AM

3 Kaedah untuk menjalankan Llama 3.2 - Analytics VidhyaApr 11, 2025 am 11:56 AMMeta's Llama 3.2: Powerhouse AI Multimodal Model multimodal terbaru Meta, Llama 3.2, mewakili kemajuan yang ketara dalam AI, yang membanggakan pemahaman bahasa yang dipertingkatkan, ketepatan yang lebih baik, dan keupayaan penjanaan teks yang unggul. Keupayaannya t

Mengotomatisasi Pemeriksaan Kualiti Data dengan DagsterApr 11, 2025 am 11:44 AM

Mengotomatisasi Pemeriksaan Kualiti Data dengan DagsterApr 11, 2025 am 11:44 AMJaminan Kualiti Data: Pemeriksaan Automatik dengan Dagster dan Harapan Hebat Mengekalkan kualiti data yang tinggi adalah penting untuk perniagaan yang didorong data. Apabila jumlah data dan sumber meningkat, kawalan kualiti manual menjadi tidak cekap dan terdedah kepada kesilapan.

Adakah kerangka utama mempunyai peranan dalam era AI?Apr 11, 2025 am 11:42 AM

Adakah kerangka utama mempunyai peranan dalam era AI?Apr 11, 2025 am 11:42 AMMain Frames: Wira Unsung Revolusi AI Walaupun pelayan cemerlang dalam aplikasi tujuan umum dan mengendalikan pelbagai pelanggan, kerangka utama dibina untuk tugas tinggi, misi kritikal. Sistem yang kuat ini sering dijumpai di Heavil

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

MinGW - GNU Minimalis untuk Windows

Projek ini dalam proses untuk dipindahkan ke osdn.net/projects/mingw, anda boleh terus mengikuti kami di sana. MinGW: Port Windows asli bagi GNU Compiler Collection (GCC), perpustakaan import yang boleh diedarkan secara bebas dan fail pengepala untuk membina aplikasi Windows asli termasuk sambungan kepada masa jalan MSVC untuk menyokong fungsi C99. Semua perisian MinGW boleh dijalankan pada platform Windows 64-bit.

PhpStorm versi Mac

Alat pembangunan bersepadu PHP profesional terkini (2018.2.1).

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

SublimeText3 versi Inggeris

Disyorkan: Versi Win, menyokong gesaan kod!

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa