Rumah >Peranti teknologi >AI >Penyelidikan yang sangat penting! 32 kertas kerja melihat dengan teliti titik panas AI pada tahun 2022

Penyelidikan yang sangat penting! 32 kertas kerja melihat dengan teliti titik panas AI pada tahun 2022

- 王林ke hadapan

- 2023-04-13 19:34:012003semak imbas

Sementara dunia masih pulih, penyelidikan tidak melambatkan kepesatannya, terutamanya dalam bidang kecerdasan buatan.

Selain itu, tahun ini terdapat penekanan baharu pada etika AI, berat sebelah, tadbir urus dan ketelusan.

Kecerdasan buatan dan pemahaman kita tentang otak manusia serta kaitannya dengan kecerdasan buatan sentiasa berkembang, dan dalam masa terdekat, aplikasi ini yang meningkatkan kualiti hidup kita akan bersinar.

Blogger terkenal Louis Bouchard turut mengira 32 (!) penemuan teknologi AI pada tahun 2022 dalam blognya.

Mari kita lihat apakah kajian yang menakjubkan ini!

Alamat artikel: https://www.louisbouchard.ai/2022-ai-recap/

LaMA: Pengecatan Topeng Besar Teguh Resolusi Berdasarkan Konvolusi Fourier

Anda pasti pernah mengalami situasi ini: anda dan rakan anda mengambil gambar foto yang hebat. Akibatnya, anda mendapati seseorang berada di belakang anda, memusnahkan foto yang ingin anda hantar kepada Moments atau Xiaohongshu. Tetapi sekarang, ini tidak lagi menjadi masalah.

Kaedah lukisan topeng besar teguh resolusi berdasarkan lilitan Fourier, membolehkan pengguna mengalih keluar kandungan yang tidak diingini daripada imej dengan mudah. Kedua-dua orang dan tong sampah boleh hilang dengan mudah.

Ia seperti pereka PS profesional di dalam poket anda, yang boleh dibersihkan dengan mudah dengan hanya satu klik.

Walaupun nampak mudah, pemulihan imej merupakan masalah yang telah lama perlu diselesaikan oleh ramai penyelidik AI.

Pautan kertas: https://arxiv.org/abs/2109.07161

Alamat projek: https://github.com/saic-mdal/lama

Demo Colab: https://colab.research .google.com/github/saic-mdal/lama/blob/master/colab/LaMa_inpainting.ipynb

Penjelasan video: https://youtu.be /Ia79AvGzveQ

Analisis ringkas: https://www.louisbouchard.ai/lama/

STIT: Berdasarkan pada Real Video Face Editing oleh GAN

Anda pasti pernah mengalami pengalaman ini: apabila menonton filem, anda akan mendapati bahawa pelakon dalam filem itu kelihatan jauh lebih muda daripada anda.

Will Smith dalam "Gemini Man"

Sebelum ini, yang memerlukan profesional untuk menghabiskan beratus-ratus atau bahkan beribu-ribu jam kerja menyunting adegan di mana pelakon ini muncul secara manual. Tetapi dengan AI, anda boleh melakukannya dalam beberapa minit.

Malah, banyak teknologi membolehkan anda meningkatkan senyuman dan menjadikan anda kelihatan lebih muda atau lebih tua, semuanya dilakukan secara automatik menggunakan algoritma berasaskan kecerdasan buatan. Ia dipanggil manipulasi muka berasaskan AI dalam video dan mewakili keadaan seni pada tahun 2022.

Pautan kertas: https://arxiv.org/abs/2201.08361

Alamat projek: https://github.com/rotemtzaban/STIT

Penjelasan video: https://youtu.be/mqItu9XoUgk

Cerpen analisis : https://www.louisbouchard.ai/stitch-it-in-time/

NeROIC: Rendering saraf menggunakan galeri dalam talian

Rendering saraf Model 3D yang realistik boleh dijana di angkasa melalui gambar objek, orang atau pemandangan.

Dengan teknologi ini, anda hanya perlu mempunyai beberapa gambar objek dan anda boleh meminta mesin memahami objek dalam gambar ini dan mensimulasikan rupa objek tersebut di angkasa.

Memahami bentuk fizikal objek melalui imej adalah mudah untuk manusia kerana kita memahami dunia sebenar. Tetapi untuk mesin yang hanya boleh melihat piksel, ia adalah cabaran yang sama sekali berbeza.

Bagaimanakah model yang dijana boleh disepadukan ke dalam senario baharu? Bagaimana jika keadaan pencahayaan dan sudut foto berbeza dan model yang dihasilkan akan berubah dengan sewajarnya? Ini adalah soalan yang Snapchat dan University of Southern California perlu tangani dalam kajian baharu ini.

Pautan kertas: https://arxiv.org/abs/2201.02533

Alamat projek: https://github.com/snap-research/NeROIC

Penjelasan video: https://youtu.be /88Pl9zD1Z78

Analisis ringkas: https://www.louisbouchard.ai/neroic/

Pelukis Ucapan: Teks Pembaikan pertuturan bersyarat

Untuk imej, teknologi pembaikan berasaskan pembelajaran mesin bukan sahaja boleh mengalih keluar kandungan, tetapi juga mengisi bahagian imej yang hilang berdasarkan maklumat latar belakang.

Untuk pemulihan video, cabarannya bukan sahaja untuk mengekalkan konsistensi dari bingkai ke bingkai, tetapi juga untuk mengelak daripada menghasilkan artifak yang salah. Pada masa yang sama, apabila anda berjaya "menendang" seseorang daripada video, anda perlu memadamkan suaranya juga.

Untuk tujuan ini, penyelidik Google telah mencadangkan kaedah pembaikan suara baharu yang boleh membetulkan tatabahasa, sebutan dan juga menghilangkan hingar latar dalam video.

Pautan kertas: https://arxiv.org/abs/2202.07273

Penjelasan video: https://youtu.be/zIIc4bRf5Hg

Analisis ringkas: https://www.louisbouchard.ai/speech-inpainting-with-ai/

GFP-GAN: Menggunakan muka muka generatif untuk mencapai pemulihan muka buta dunia sebenar

Adakah anda mempunyai beberapa foto lama yang telah anda kumpulkan kerana usianya? Kualiti gambar kabur? Jangan risau, dengan Pemulihan Wajah Buta, kenangan anda akan kekal selama-lamanya.

Model AI baharu dan percuma ini boleh membaiki kebanyakan foto lama anda dalam sekelip mata. Ia berfungsi dengan baik walaupun foto prapemulihan berkualiti sangat rendah. Ini dahulunya agak mencabar.

Apa yang lebih menarik ialah anda boleh mencubanya dengan cara yang anda suka. Mereka telah membuka sumber kod dan mencipta demo dan aplikasi dalam talian untuk semua orang mencuba. Saya percaya teknologi ini akan mengejutkan anda!

Pautan kertas: https://arxiv.org/abs/2101.04061

Alamat projek: https://github.com/TencentARC/GFPGAN

Demo Colab: https://colab.research.google.com/drive/1sVsoBd9AjckIXThgtZhGrHRfFI6UUYOo

Permohonan dalam talian: https: //huggingface.co/spaces/akhaliq/GFPGAN

Penjelasan video: https://youtu.be/nLDVtzcSeqM

Analisis ringkas: https://www.louisbouchard.ai/gfp-gan/

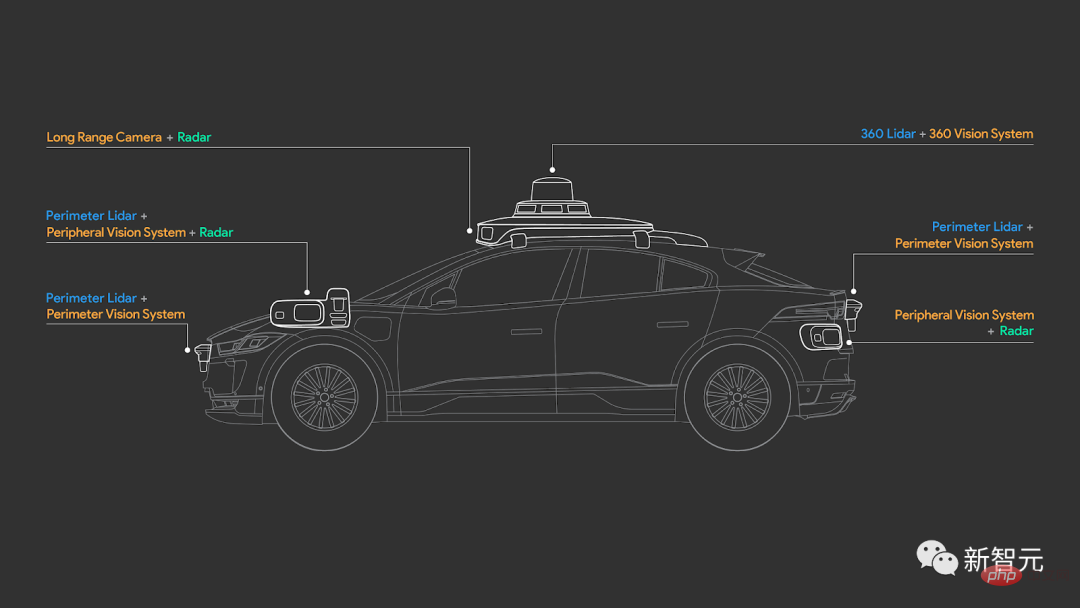

4D-Net: Pembelajaran penjajaran pelbagai mod

Bagaimanakah kereta pandu sendiri "melihat enam arah"?

Anda mungkin pernah mendengar tentang penderia LiDAR atau kamera pelik lain yang digunakan oleh syarikat kereta. Tetapi bagaimana mereka bekerja, bagaimana mereka melihat dunia, dan apakah sebenarnya yang mereka lihat secara berbeza berbanding kita?

Pautan kertas: https://arxiv.org/abs/2109.01066

Tidak seperti Tesla yang hanya menggunakan kamera untuk memahami dunia, kebanyakan pengeluar kereta pandu sendiri, seperti Waymo, menggunakan kamera biasa dan penderia LiDAR 3D.

Mereka tidak menjana imej seperti kamera biasa, sebaliknya menjana awan titik 3D, menggunakan maklumat penderiaan RGB, mengukur jarak antara objek dan mengira cahaya laser berdenyut yang mereka pancarkan ke objek masa pembiakan.

Namun, bagaimanakah kita boleh menggabungkan maklumat ini dengan berkesan dan menjadikan kenderaan itu memahaminya? Apakah yang akan dilihat oleh kenderaan itu? Adakah pemanduan autonomi cukup selamat? Kertas penyelidikan baharu daripada Waymo dan Google akan menjawab misteri ini.

Penjelasan video: https://youtu.be/0nJMnw1Ldks

Analisis cerpen: https : //www.louisbouchard.ai/waymo-lidar/

NeRF Segera: Primitif saraf segera berdasarkan pengekodan cincang berbilang resolusi

Cara lulus Foto meniru rupa dunia?

Menggunakan model AI, orang ramai boleh menukar imej yang ditangkap kepada model 3D berkualiti tinggi. Tugas yang mencabar ini membolehkan penyelidik menggunakan imej 2D untuk mencipta cara objek atau orang akan kelihatan dalam dunia tiga dimensi.

Menggunakan primitif saraf berkod cincang (primitif grafik), NVIDIA mencapai latihan NeRF selama 5 saat dan mencapai hasil yang lebih baik. Dalam masa kurang daripada dua tahun penyelidikan, kelajuan latihan NeRF telah meningkat lebih daripada 1,000 kali ganda.

Pautan kertas: https://arxiv.org/abs/2201.05989

Alamat projek: https://github.com/NVlabs/instant-ngp

Video Penjelasan: https://youtu.be/UHQZBQOVAIU

Analisis ringkas: https://www.louisbouchard.ai/nvidia-photos-into-3d- adegan/

DALL·E 2: Model penjanaan teks-ke-imej berdasarkan ciri CLIP

Tahun lepas, OpenAI mengeluarkan teks-ke-imej model generasi DALL·E. Kini, versi DALL·E 2 yang dinaik taraf hadir lagi.

DALL·E 2 bukan sahaja menjana imej realistik daripada teks, tetapi outputnya mempunyai resolusi empat kali ganda!

Walau bagaimanapun, peningkatan prestasi nampaknya tidak mencukupi untuk memuaskan OpenAI, jadi mereka turut membenarkan DALL·E 2 mempelajari kemahiran baharu: pembaikan imej.

Maksudnya, anda boleh mengedit imej dengan DALL·E 2, atau menambah sebarang elemen baharu yang anda mahu, seperti menambah flamingo di latar belakang.

Pautan kertas: https://arxiv.org/abs/2204.06125

Penjelasan video: https://youtu.be/rdGVbPI42sA

Analisis ringkas: https://www.louisbouchard.ai/openais -new-model-dall-e-2-is-amazing/

MyStyle: Personalized generation priors

Google dan Universiti Tel Aviv mencadangkan satu Sangat berkuasa Teknologi DeepFake. Dengan itu, anda boleh melakukan hampir apa sahaja.

Cuma ambil ratusan foto seseorang, mengekod imej mereka dan betulkan, edit atau cipta apa sahaja rupa yang anda mahukan.

Ia menakjubkan dan menakutkan, terutamanya apabila anda melihat hasil yang dihasilkan.

Pautan kertas: https://arxiv.org/abs/2203.17272

Alamat projek: https://mystyle-personalized-prior.github.io/

Penjelasan video: https://youtu. be/BNWAEvFfFvQ

Analisis ringkas: https://www.louisbouchard.ai/mystyle/

PILIH: Buka model bahasa Transformer pra-latihan

Apa yang menjadikan GPT-3 begitu hebat ialah seni bina dan saiznya.

Ia mempunyai 175 bilion parameter, dua kali ganda bilangan neuron dalam otak manusia! Rangkaian saraf yang begitu besar membolehkan model mempelajari hampir keseluruhan internet, memahami cara kita menulis, bertukar dan memahami teks.

Apabila orang kagum dengan fungsi berkuasa GPT-3, Meta mengambil langkah besar ke arah komuniti sumber terbuka. Mereka mengeluarkan model yang sama berkuasa yang kini sumber terbuka sepenuhnya!

Bukan sahaja model ini mempunyai lebih daripada 100 bilion parameter tahap, tetapi juga, berbanding GPT-3, OPT-175B lebih terbuka dan boleh diakses.

Pautan kertas: https://arxiv.org/abs/2205.01068

Alamat projek: https://github.com/facebookresearch/metaseq

Pautan video: https://youtu.be/Ejg0OunCi9U

Analisis ringkas: https://www.louisbouchard.ai/opt-meta/

BlobGAN: Perwakilan Adegan Diskret Spatial

Untuk cara menerangkan adegan, pasukan penyelidik Adobe telah memberikan kaedah baharu: BlobGAN.

BlobGAN menggunakan "gumpalan" untuk menerangkan objek dalam adegan. Para penyelidik boleh memindahkan gumpalan, menjadikannya lebih besar, lebih kecil, atau dipadamkan, yang akan mempunyai kesan yang sama pada objek yang mereka wakili dalam imej.

Apabila pengarang berkongsi hasil mereka, anda boleh mencipta imej baharu dalam set data dengan menduplikasi gumpalan.

Kini, kod BlobGAN telah menjadi sumber terbuka Jika anda berminat, cepatlah mencubanya.

Pautan kertas: https://arxiv.org/abs/2205.02837

Alamat projek: https://github.com/dave-epstein/blobgan

Demo Colab: https://colab.research.google.com/drive /1clvh28Yds5CvKsYYENGLS3iIIrlZK4xO?usp=sharing#scrollTo=0QuVIyVplOKU

Penjelasan video: https://Ejpi. 🎜>

Analisis ringkas: https://www.louisbouchard.ai/blobgan/

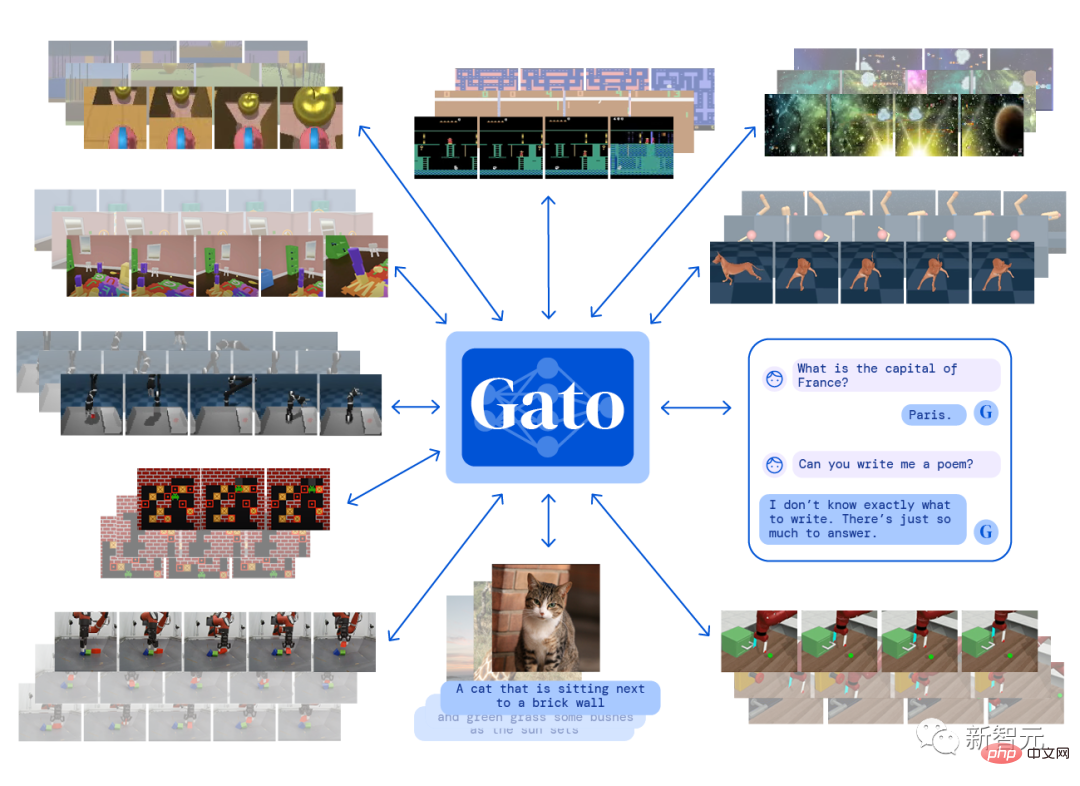

Gato: Ejen GeneralisDeepMind membina satu ejen "universal" Gato. Anda boleh bermain permainan Atari, mencipta imej sari kata, bersembang dengan orang dan mengawal senjata robot!

Apa yang lebih mengejutkan ialah ia boleh menyelesaikan semua tugas dengan melatihnya sekali sahaja dan menggunakan pemberat yang sama.

Gato ialah ejen pelbagai modal. Ini bermakna ia boleh membuat kapsyen untuk imej dan bertindak sebagai chatbot untuk menjawab soalan.

Walaupun GPT-3 juga boleh bersembang dengan anda, jelas sekali Gato boleh melakukan lebih banyak lagi. Lagipun, selalunya terdapat AI yang boleh berbual, tetapi tidak banyak yang boleh bermain permainan dengan mereka.

Pautan kertas: https://arxiv.org/abs/2205.06175

Penjelasan video: https://youtu.be/xZKSWNv6Esc

Analisis cerpen: https : //www.louisbouchard.ai/deepmind-gato/

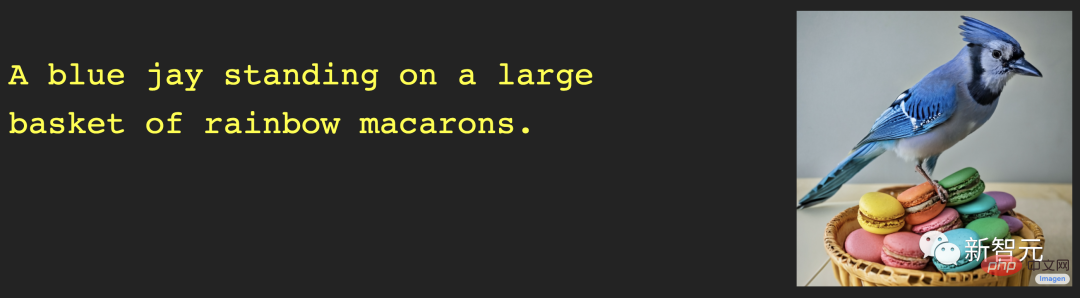

Imej: Model Resapan Teks-ke-Imej dengan Pemahaman Bahasa MendalamJika anda fikir DALL · E 2 hebat, jadi mari lihat apa yang model baharu daripada Google Brain – Imagen – boleh lakukan ini.

DALL·E sangat mengagumkan, tetapi imej yang dijana selalunya kurang realisme. Ini adalah masalah yang ingin diselesaikan oleh Imagen oleh pasukan Google.

Menurut penanda aras yang membandingkan model teks-ke-imej, Imagen telah mencapai hasil yang luar biasa dalam sintesis imej teks dengan pembenaman teks untuk model bahasa besar. Imej yang dihasilkan adalah imaginatif dan realistik.

Pautan kertas: https://arxiv.org/abs/2205.11487

Alamat projek: https://imagen.research.google/

Penjelasan video: https ://youtu.be/qhtYPhPWCsI

Analisis ringkas: https://www.louisbouchard.ai/google-brain-imagen/

DALL·E MiniSatu set gambar mengejutkan Xiao Zha menjadi popular di Twitter buat seketika. Set karya nilai untuk wang San ini telah dicipta oleh DALL·E mini.

Sebagai "versi belia" keluarga DALL·E, DALL·E mini adalah percuma dan sumber terbuka. Kod telah ditinggalkan, siapakah watak seterusnya yang akan diubah suai secara ajaib?

Alamat projek: https://github.com/borisdayma/dalle-mini

Pengalaman dalam talian: https:// huggingface.co/spaces/dalle-mini/dalle-mini

Penjelasan video: https://youtu.be/K3bZXXjW788

Analisis ringkas: https://www.louisbouchard.ai/dalle-mini/

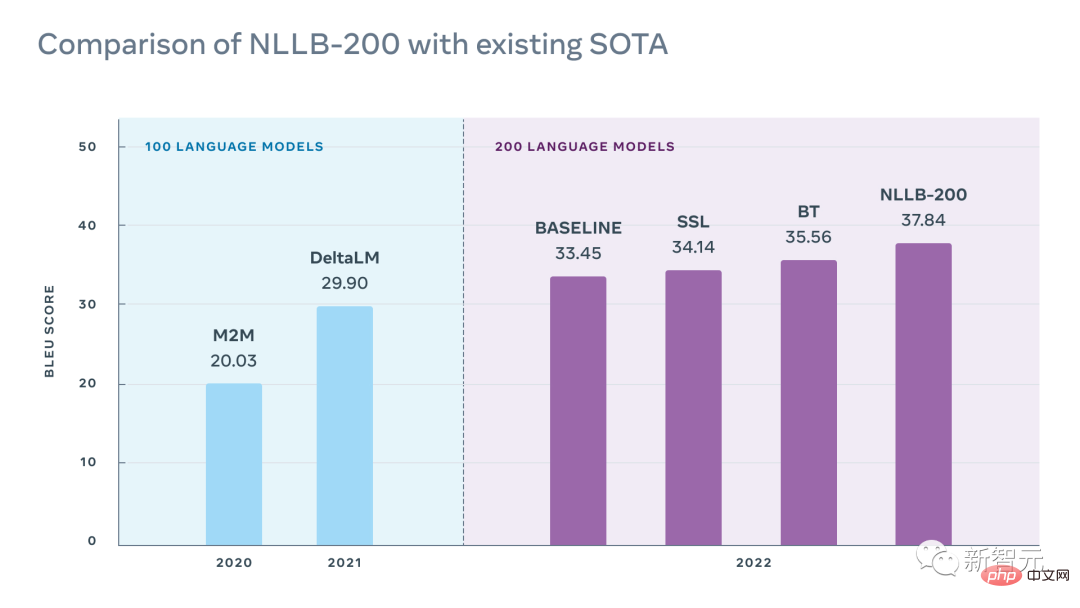

NLLB: Tiada bahasa tertinggal

Model NLLB-200 yang dikeluarkan oleh Meta AI ini, konsep penamaan model berasal daripada "Tiada Bahasa Tertinggal" (Tiada Bahasa Tertinggal), dan ia boleh mencapai terjemahan arbitrari dalam lebih 200 bahasa.

Kemuncak penyelidikan ialah penyelidik telah memperbaik kebanyakan latihan bahasa sumber rendah dengan pelbagai urutan magnitud, sambil mencapai keputusan SOTA untuk 200+ terjemahan bahasa.

Pautan kertas: https://research.facebook.com/publications/no-language-left-behind/

Alamat projek: https://github.com/facebookresearch/fairseq/tree/nllb

Pengalaman dalam talian: https://nllb.metademolab.com/

Penjelasan video: https://youtu. be/2G4NeG17Eis

Analisis ringkas: https://www.louisbouchard.ai/no-language-left-behind/

Sistem penderiaan getaran optik Dwi Pengatup

Bolehkah bunyi juga dilihat?

Penyelidikan ini, yang memenangi Anugerah Kehormat Kertas Terbaik CVPR 2022, mencadangkan kaedah Dual-Shutter novel untuk mengesan pelbagai sumber adegan secara serentak dengan menggunakan kamera "perlahan" (130FPS) Kelajuan tinggi (naik). hingga 63kHz) getaran permukaan dan melakukannya dengan menangkap getaran yang disebabkan oleh sumber audio.

Justeru, pelbagai keperluan seperti pengasingan alat muzik dan penghapusan bunyi dapat direalisasikan.

Pautan kertas: https://openaccess.thecvf.com/content/CVPR2022/papers/Sheinin_Dual-Shutter_Optical_Vibration_VPR_Sensing_20_Pdf >

Alamat projek: https://imaging.cs.cmu.edu/vibration/

Penjelasan video: https://youtu.be/n1M8ZVspJcs

Analisis ringkas: https://www.louisbouchard .ai/cvpr-2022-best-paper/

Make-A-Scene: Penjanaan teks-ke-imej berasaskan adegan dengan keutamaan manusiaMake-A-Scene bukan sekadar "DALL·E yang lain".

Walaupun DALL·E boleh menjana imej rawak berdasarkan gesaan teks, yang sungguh hebat, ia juga mengehadkan kawalan pengguna ke atas hasil yang dijana.

Matlamat Meta adalah untuk mempromosikan ekspresi kreatif, menggabungkan aliran teks-ke-imej ini dengan model lakaran-ke-imej sebelumnya, menghasilkan "Make-A-Scene": Teks A gabungan hebat antara penjanaan imej bersyarat lakaran.

Pautan kertas: https://arxiv.org/abs/2203.13131

Penjelasan video: https://youtu.be/K3bZXXjW788

Analisis ringkas: https://www.louisbouchard. ai/make-a-scene/

BANMo: Bina model animasi 3D sasaran daripada mana-mana video

Berdasarkan penyelidikan daripada Meta ini, anda hanya perlu Memandangkan mana-mana video yang menangkap objek boleh ubah bentuk, seperti memuat naik beberapa video kucing dan anjing, BANMo boleh membina semula model 3D animasi yang boleh diedit dengan menyepadukan petunjuk 2D daripada beribu-ribu imej ke dalam ruang kanonik Dan tiada templat bentuk yang dipratentukan diperlukan.

Pautan kertas: https://arxiv.org/abs/2112.12761

Alamat projek: https://github.com/facebookresearch/banmo

Penjelasan video: https://youtu.be/jDTy-liFoCQ

Analisis ringkas: https://www.louisbouchard.ai/banmo/

Menggunakan model resapan terpendam untuk sintesis imej resolusi tinggi

Model penjanaan imej popular tahun ini DALL·E, Imagen dan Stable Diffusion yang berkuasa, model penjanaan imej yang berkuasa ini Apakah fungsinya mempunyai persamaan? Selain daripada kos pengiraan yang tinggi dan masa latihan yang panjang, semuanya berdasarkan mekanisme resapan yang sama.

Model penyebaran baru-baru ini telah mencapai keputusan SOTA dalam kebanyakan tugas imej, termasuk teks ke imej menggunakan DALL·E dan banyak tugas berkaitan penjanaan imej lain seperti mengecat imej, pemindahan gaya atau resolusi super imej.

Pautan kertas: https://arxiv.org/abs/2112.10752

Alamat projek: https://github.com/CompVis/latent-diffusion

Penjelasan video: https://youtu.be /RGBdD3Wn-g

Analisis ringkas: https://www.louisbouchard.ai/latent-diffusion-models/

PSG: Model penjanaan imej berasaskan pemandangan

AI boleh membantu anda mengenal pasti objek dalam imej dengan tepat, tetapi memahami hubungan antara objek dan persekitaran tidak begitu mudah.

Untuk tujuan ini, penyelidik dari Politeknik Nanyang mencadangkan tugas penjanaan graf pemandangan panoptik (PSG) berdasarkan segmentasi panorama.

Berbanding dengan penjanaan graf pemandangan tradisional berdasarkan bingkai pengesanan, tugas PSG memerlukan output menyeluruh bagi semua perhubungan dalam imej (termasuk perhubungan antara objek, perhubungan antara objek dan latar belakang, dan hubungan latar belakang dengan latar belakang) dan gunakan blok pembahagian yang tepat untuk mencari objek.

Pautan kertas: https://arxiv.org/abs/2207.11247

Alamat projek: https://psgdataset.org/

Permohonan dalam talian: https://huggingface.co/spaces/ECCV2022/ PSG

Penjelasan video: https://youtu.be/cSsE_H_0Cr8

Analisis ringkas: https://www.louisbouchard.ai/psg/

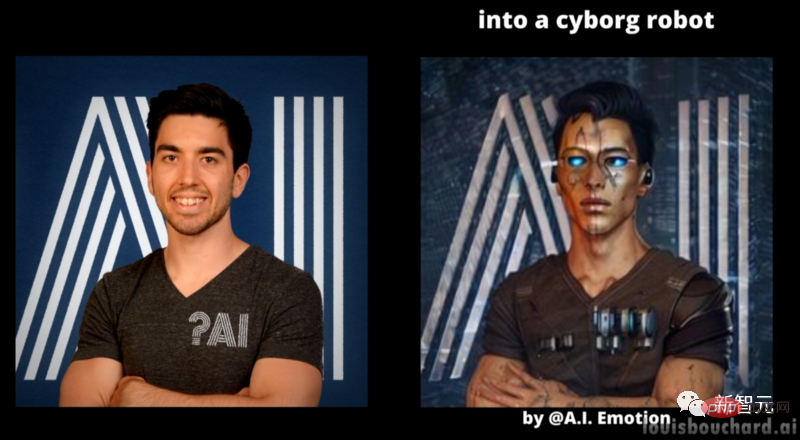

Menggunakan penyongsangan teks untuk mencapai penjanaan teks ke imej yang diperibadikan

Tahun ini, model penjanaan imej pengeluar utama boleh dikatakan seperti lapan orang abadi menyeberangi laut, masing-masing menunjukkan kuasa ajaib mereka, tetapi bagaimana untuk menjadikan model itu menghasilkan karya imej dengan gaya tertentu?

Ulama dari Universiti Tel Aviv dan NVIDIA telah bekerjasama untuk melancarkan model penjanaan imej diperibadikan yang boleh DIY imej yang anda mahukan.

Pautan kertas: https://arxiv.org/abs/2208.01618

Alamat projek: https://texttual-inversion.github.io/

Penjelasan video : https://youtu.be/f3oXa7_SYek

Analisis ringkas: https://www.louisbouchard.ai/imageworthoneword/

Model pra-latihan imej bahasa untuk pengecaman video umum

Pembelajaran model teks visual sudah pasti mencapai kejayaan yang besar, tetapi bagaimana untuk melatih imej bahasa baharu ini Lanjutan kaedah kepada domain video kekal sebagai soalan terbuka.

Ahli akademik dari Microsoft dan Akademi Sains China telah mencadangkan kaedah yang mudah dan berkesan untuk menyesuaikan secara langsung model imej bahasa pra-latihan kepada pengecaman video, dan bukannya pra-latihan model baharu daripada calar.

Pautan kertas: https://arxiv.org/abs/2208.02816

Alamat projek: https://github.com/microsoft/VideoX/tree/master/X-CLIP

Penjelasan video: https://youtu.be/seb4lmVPEe8

Analisis ringkas: https://www.louisbouchard.ai/general-video-recognition/

Buat- A-Video: Model video penjanaan teks sekali klik

Pelukis melukis di atas kanvas sepuas hatinya Dengan gambaran yang begitu jelas dan licin, bolehkah anda berfikir bahawa setiap bingkai video itu dihasilkan oleh AI?

Make-A-Video yang dilancarkan oleh MetaAI boleh menghasilkan gaya video yang berbeza dalam beberapa saat dengan hanya memasukkan beberapa perkataan, yang dipanggil "Versi Video DALL·E" Ia bukan keterlaluan.

Pautan kertas: https://arxiv.org/abs/2209.14792

Penjelasan video: https://youtu.be/MWwESVyHWto

Analisis ringkas: https: //www.louisbouchard.ai/make-a-video/

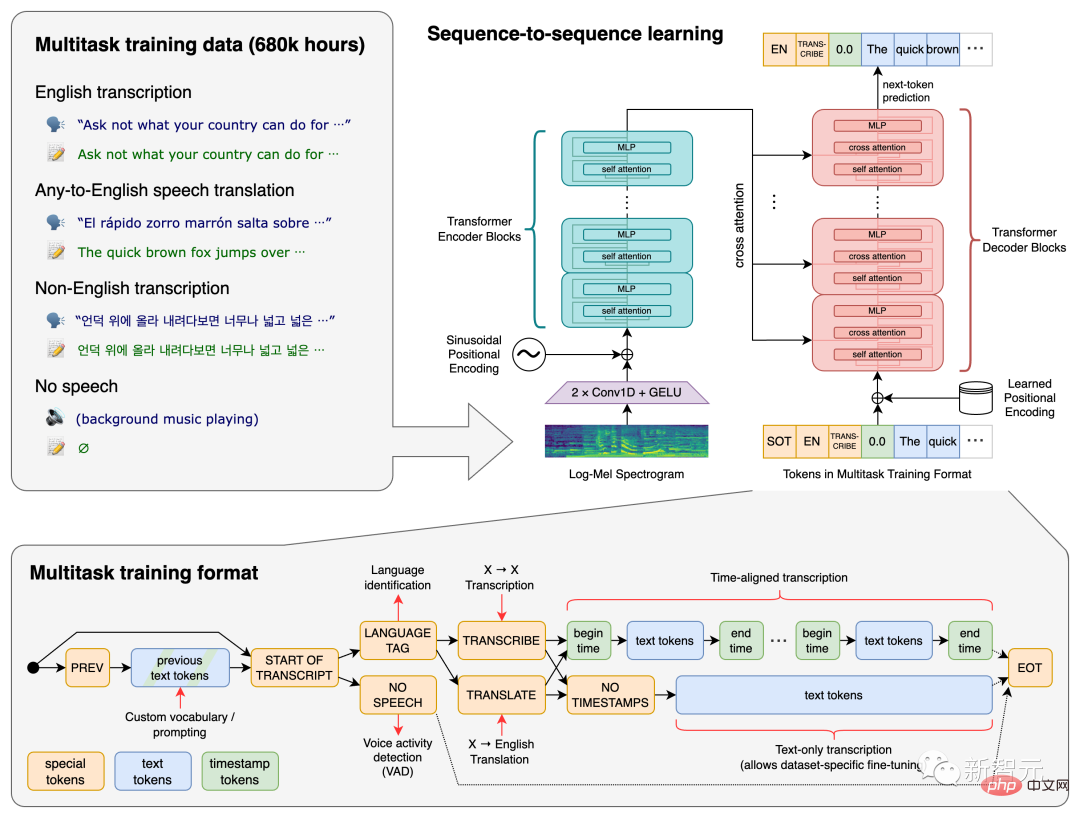

Bisikan: Model Pengecaman Pertuturan Terselia Berskala Besar yang Lemah

Pernahkah anda terfikir tentang itu? Perisian terjemahan yang boleh menterjemah pertuturan dengan cepat dalam video, walaupun dalam bahasa yang anda sendiri tidak faham?

Sumber terbuka OpenAI Whisper boleh melakukan perkara itu.

Whisper telah dilatih pada lebih daripada 680,000 jam data berbilang bahasa Ia boleh mengecam bunyi berbilang bahasa dalam latar belakang yang bising dan menukarnya kepada teks.

Pautan kertas: https://arxiv.org/abs/2212.04356

Alamat projek: https://github.com/openai/whisper

Penjelasan video: https://youtu.be/uFOkMme19Zs

Analisis ringkas :https://www.louisbouchard.ai/whisper/

DreamFusion: Gunakan imej 2D untuk menjana model 3D

Teks boleh menjana imej, video, dan Terdapat model 3D~

DreamFusion yang dilancarkan oleh Google boleh menjana model 3D dengan satu klik dengan menggunakan model resapan teks-ke-imej 2D yang telah terlatih, model resapan yang dilatih pada berbilion-bilion pasangan imej-teks Memacu penemuan terkini dalam sintesis model teks-ke-3D.

Pautan kertas: https://arxiv.org/abs/2209.14988

Penjelasan video: https://youtu.be/epuU0VRIcjE

Analisis cerpen: https : //www.louisbouchard.ai/dreamfusion/

Imagic: Kaedah penyuntingan imej sebenar berdasarkan model resapan

Menggunakan model penjanaan imej teks seperti DALL ·E , anda boleh mendapatkan gambar yang anda inginkan dengan hanya memasukkan baris teks, tetapi imej yang dihasilkan oleh AI kadangkala tidak begitu sempurna.

Penyelidik dari Google, Institut Teknologi Israel dan Institut Sains Weizmann memperkenalkan kaedah penyuntingan imej sebenar berdasarkan model resapan - Imagic, yang boleh dicapai hanya menggunakan teks PS foto sebenar.

Sebagai contoh, kita boleh menukar pose dan komposisi seseorang sambil mengekalkan ciri asalnya, atau saya mahu anjing berdiri duduk dan burung melebarkan sayapnya.

Pautan kertas: https://arxiv.org/abs/2210.09276

Alamat projek: https://imagic-editing.github.io/

Penjelasan video: https://youtu.be/ gbpPQ5kVJhM

Analisis ringkas: https://www.louisbouchard.ai/imagic/

eDiffi: Higher High -model sintesis imej teks berkualiti

Model sintesis imej yang lebih kuat daripada DALL·E dan Resapan Stabil ada di sini!

Ini ialah eDiffi NVIDIA, yang boleh menjana imej berkualiti lebih tinggi dengan lebih tepat Selain itu, menambah templat berus boleh menambahkan lebih kreativiti dan fleksibiliti pada karya anda.

Pautan kertas: https://arxiv.org/abs/2211.01324

Alamat projek: https://deepimagination.cc/eDiff-I/

Penjelasan video : https://youtu.be/grwp-ht_ixo

Analisis ringkas: https://www.louisbouchard.ai/ediffi/

Sifat Infinite: Mempelajari penjanaan pemandangan alam yang tidak terhingga daripada satu imej

Pernahkah anda terfikir untuk mengambil foto dan membukanya seperti pintu? gambar?

Ulama dari Google dan Cornell University telah mengubah imaginasi ini menjadi realiti dengan InfiniteNature-Zero, yang boleh menjana pemandangan alam semula jadi tanpa had daripada satu imej.

Pautan kertas: https://arxiv.org/abs/2207.11148

Alamat projek: https://infinite-nature.github.io/

Penjelasan video : https://youtu.be/FQzGhukV-l0

Analisis ringkas: https://www.louisbouchard.ai/infinitenature-zero

Galactica: Model bahasa yang besar untuk sains

Galactica yang dibangunkan oleh Meta ialah model bahasa yang besar yang setanding saiznya dengan GPT-3, tetapi ia cemerlang dalam Ia adalah pengetahuan saintifik.

Model boleh menulis kertas putih kerajaan, ulasan berita, halaman Wikipedia dan kod, ia juga tahu cara memetik dan cara menulis persamaan. Ini adalah masalah besar untuk kecerdasan buatan dan sains.

Pautan kertas: https://arxiv.org/abs/2211.09085

Penjelasan video: https://youtu.be/2GfxkCWWzLU

Analisis cerpen: https : //www.louisbouchard.ai/galactica/

RAD-NeRF: Model sintesis potret masa nyata berdasarkan penguraian spatial audio

Sejak kemunculan daripada DeepFake dan NeRF , AI mengubah wajah nampaknya perkara biasa, tetapi terdapat masalah Wajah yang diubah oleh AI kadangkala mendedahkan rahsianya kerana ia tidak sepadan dengan bentuk mulut.

Kemunculan RAD-NeRF boleh menyelesaikan masalah ini. Ia boleh melakukan sintesis potret masa nyata pembesar suara yang muncul dalam video, dan juga menyokong avatar tersuai.

Pautan kertas: https://arxiv.org/abs/2211.12368

Alamat projek: https://me.kiui.moe/radnerf/

Penjelasan video: https://youtu.be/ JUqnLN6Q4B0

Analisis ringkas: https://www.louisbouchard.ai/rad-nerf/

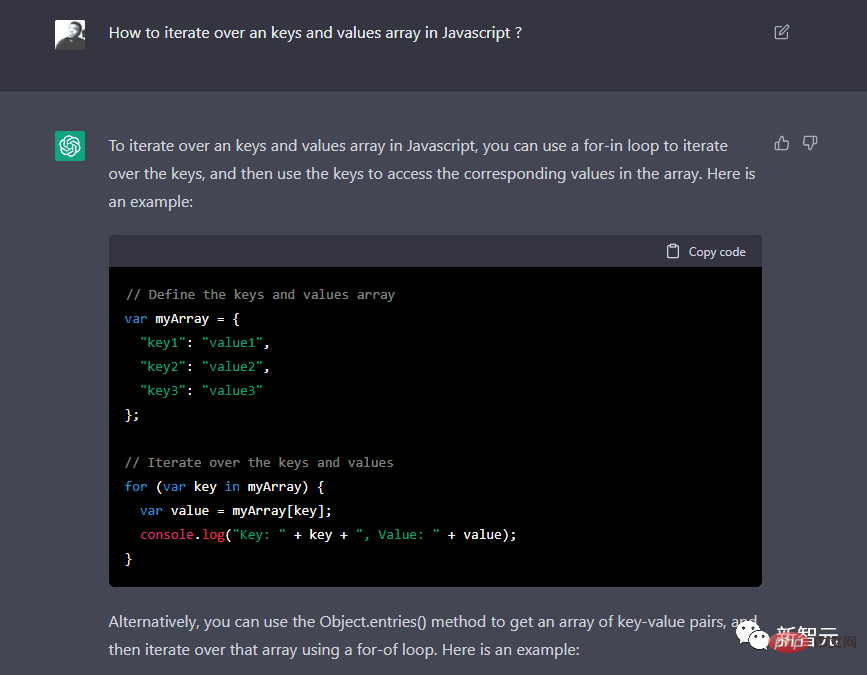

CtGPT: Model bahasa dioptimumkan untuk dialog

Bagaimanakah kerja blockbuster AI pada tahun 2022 tanpa ChatGPT Ini telah menjadi popular di seluruh Internet dan telah dibangunkan oleh netizen untuk menulis artikel lucah, menaip kod, dsb . Model aplikasi universal, jika anda belum mengetahuinya, datang dan lihat!

Penjelasan video: https://youtu.be/AsFgn8vU-tQ

Analisis ringkas: https://www.louisbouchard.ai/chatgpt/

Penuaan semula wajah video yang boleh digunakan terus dalam pengeluaran

Walaupun model penglihatan komputer semasa boleh menjana usia wajah, pemindahan gaya, dsb., ini hanya kelihatan keren dan hampir tiada kesan dalam aplikasi sebenar biasanya mempunyai masalah dengan wajah seperti kehilangan ciri resolusi, dan keputusan yang tidak stabil dalam bingkai video berikutnya selalunya memerlukan penyuntingan sekunder manual.

Baru-baru ini Disney mengeluarkan kaedah praktikal, automatik sepenuhnya pertama untuk wajah penuaan semula dalam imej video untuk kegunaan pengeluaran, FRAN (Rangkaian Penuaan Semula Wajah) , secara rasmi mengumumkan penamatan teknologi bergantung pada jurusolek untuk mengubah kesan visual umur pelakon dalam filem.

Pautan kertas: https://dl.acm.org/doi/pdf/10.1145/3550454.3555520

Alamat projek: https://studios.disneyresearch.com/2022/11/30/production-ready-face-re-aging-for-visual-effects/

Penjelasan video: https://youtu.be/WC03N0NFfwk

Analisis ringkas: https://www.louisbouchard.ai/disney-re-age/

Atas ialah kandungan terperinci Penyelidikan yang sangat penting! 32 kertas kerja melihat dengan teliti titik panas AI pada tahun 2022. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI