Rumah >Peranti teknologi >AI >Dengan hanya kuasa pengkomputeran yang begitu banyak, bagaimana untuk meningkatkan prestasi model bahasa? Google mempunyai idea baharu

Dengan hanya kuasa pengkomputeran yang begitu banyak, bagaimana untuk meningkatkan prestasi model bahasa? Google mempunyai idea baharu

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-13 14:01:091421semak imbas

Dalam beberapa tahun kebelakangan ini, model bahasa (LM) telah menjadi lebih menonjol dalam penyelidikan pemprosesan bahasa semula jadi (NLP) dan menjadi semakin berpengaruh dalam amalan. Secara umum, meningkatkan saiz model telah ditunjukkan untuk meningkatkan prestasi merentas pelbagai tugasan NLP.

Walau bagaimanapun, cabaran untuk meningkatkan model juga jelas: melatih model baharu yang lebih besar memerlukan banyak sumber pengkomputeran. Di samping itu, model baru sering dilatih dari awal dan tidak boleh menggunakan berat latihan model sebelumnya.

Untuk masalah ini, penyelidik Google meneroka dua kaedah pelengkap untuk meningkatkan prestasi model bahasa sedia ada dengan ketara tanpa menggunakan banyak sumber pengkomputeran tambahan.

Pertama, dalam artikel "Melangkaui Undang-undang Penskalaan dengan 0.1% Pengiraan Tambahan", para penyelidik memperkenalkan UL2R, model pra-latihan peringkat kedua ringan yang menggunakan sasaran enoisers Campuran. UL2R meningkatkan prestasi pada pelbagai tugas, membuka kunci prestasi prestasi walaupun pada tugas yang sebelum ini mempunyai prestasi hampir rawak.

Pautan kertas: https://arxiv.org/pdf/2210.11399.pdf

Selain itu , Dalam "Menskalakan Model Bahasa Diperhalusi Arahan", kami meneroka masalah model bahasa penalaan halus pada set data yang mengandungi arahan, proses yang kami panggil "Flan". Pendekatan ini bukan sahaja meningkatkan prestasi tetapi juga meningkatkan kebolehgunaan model bahasa kepada input pengguna.

Pautan kertas: https://arxiv.org/abs/2210.11416

Akhir sekali, Flan dan UL2R boleh digabungkan sebagai teknologi pelengkap dalam model yang dipanggil Flan-U-PaLM 540B, yang mengatasi prestasi model PaLM 540B yang belum ditala pada julat penanda aras penilaian yang mencabar Prestasi adalah 10% lebih tinggi.

Latihan UL2R

Secara tradisinya, kebanyakan model bahasa dilatih terlebih dahulu mengenai matlamat pemodelan bahasa kausal untuk membolehkan model Meramalkan perkataan seterusnya dalam urutan (seperti GPT-3 atau PaLM) atau menolak matlamat, di mana model belajar memulihkan ayat asal daripada urutan perkataan yang rosak (seperti T5).

Walaupun terdapat beberapa pertukaran dalam objektif pemodelan bahasa, iaitu, model bahasa kausal berprestasi lebih baik pada penjanaan ayat panjang, manakala model bahasa yang dilatih pada objektif denoising berprestasi lebih baik pada denoising- aspek penalaan berprestasi lebih baik, tetapi dalam kerja sebelumnya, penyelidik menunjukkan bahawa objektif enoisers hibrid yang merangkumi kedua-dua objektif mencapai prestasi yang lebih baik dalam kedua-dua kes.

Walau bagaimanapun, pra-latihan model bahasa besar dari awal pada sasaran yang berbeza adalah sukar dari segi pengiraan. Oleh itu, kami mencadangkan pembaikan UL2 (UL2R), peringkat tambahan yang meneruskan pra-latihan dengan sasaran UL2 dan hanya memerlukan jumlah pengiraan yang agak kecil.

Kami menggunakan UL2R pada PaLM dan memanggil model bahasa baharu yang terhasil U-PaLM.

Dalam penilaian empirikal kami, kami mendapati bahawa dengan hanya sedikit latihan UL2, model itu bertambah baik dengan ketara.

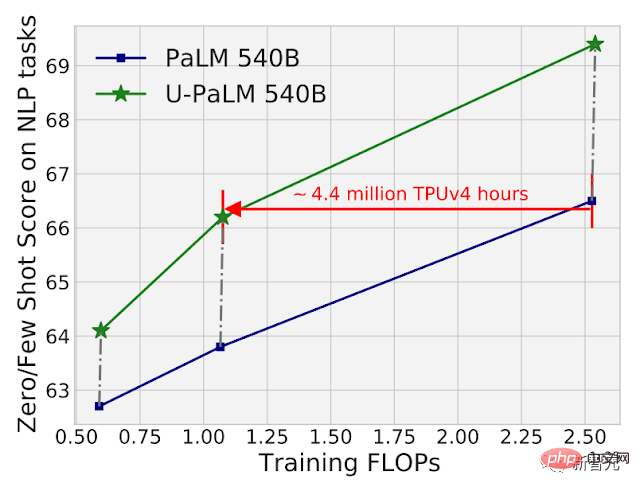

Contohnya, dengan menggunakan UL2R pada pusat pemeriksaan perantaraan PaLM 540B, prestasi PaLM 540B pada pusat pemeriksaan akhir boleh dicapai sambil menggunakan 2 kali usaha pengiraan. Sudah tentu, penggunaan UL2R pada pusat pemeriksaan PaLM 540B terakhir juga akan membawa peningkatan yang besar.

Perbandingan pengiraan dan prestasi model PaLM 540B dan U-PaLM 540B pada 26 penanda aras NLP. U-PaLM 540B terus melatih PaLM, dengan jumlah pengiraan yang sangat kecil tetapi peningkatan prestasi yang hebat.

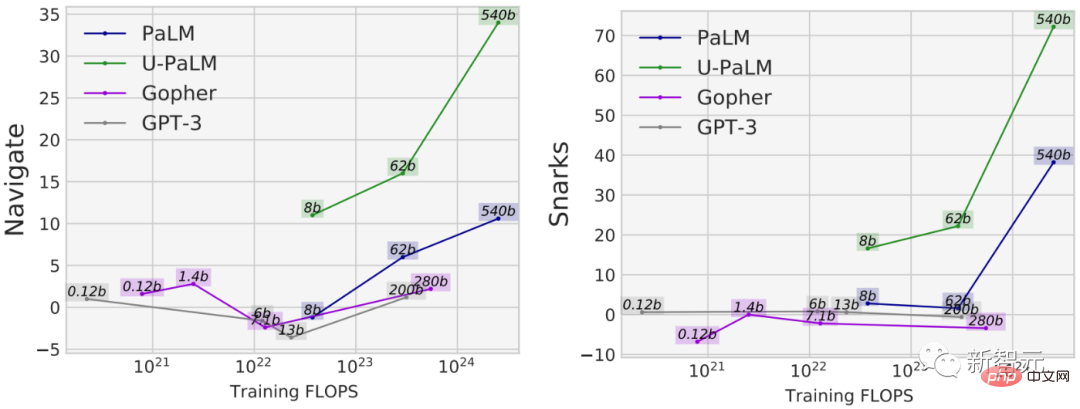

Faedah lain menggunakan UL2R ialah ia berprestasi lebih baik pada sesetengah tugas berbanding model yang dilatih semata-mata pada matlamat pemodelan bahasa sebab-akibat. Sebagai contoh, terdapat banyak tugasan BIG-Bench dengan apa yang dipanggil "keupayaan muncul", yang merupakan keupayaan yang hanya tersedia dalam model bahasa yang cukup besar.

Walaupun cara paling biasa untuk menemui keupayaan yang baru muncul ialah dengan meningkatkan model, UL2R sebenarnya boleh memberi inspirasi kepada keupayaan yang muncul tanpa meningkatkan model.

Sebagai contoh, dalam tugas navigasi BIG-Bench, yang mengukur keupayaan model untuk melaksanakan pengesanan keadaan, semua model kecuali U-PaLM mempunyai kurang latihan FLOP Pada 10^23. Contoh lain ialah tugas Snarks BIG-Bench, yang mengukur keupayaan model untuk mengesan bahasa sarkastik.

Untuk kedua-dua keupayaan daripada BIG-Bench, prestasi tugas yang muncul ditunjukkan, U-PaLM mencapai prestasi yang muncul pada saiz model yang lebih kecil disebabkan penggunaan sasaran UL2R .

Penalaan halus arahan

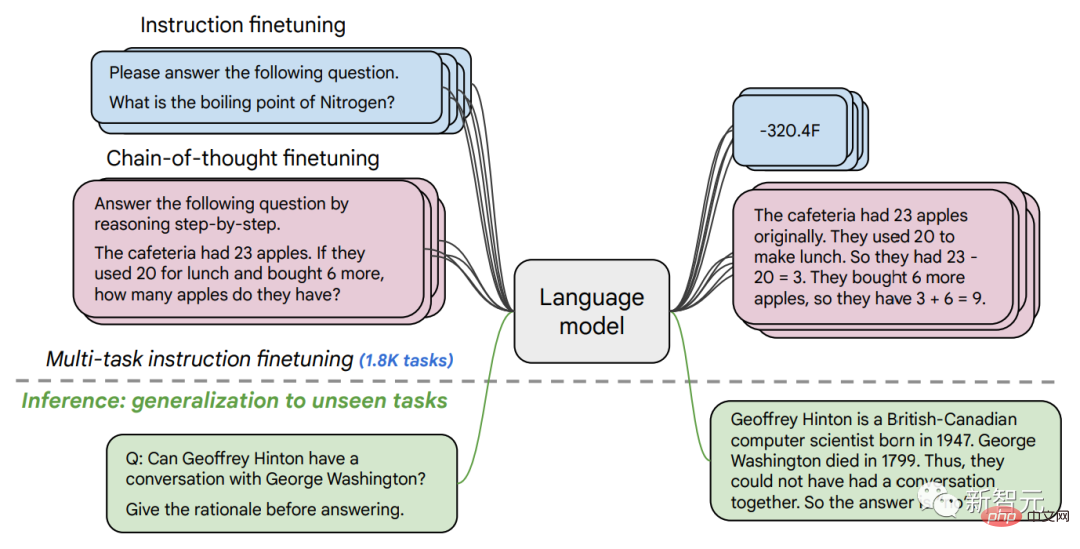

Dalam kertas kedua, kami meneroka penalaan halus arahan, yang melibatkan arahan penalaan halus dalam satu set arahan. Penalaan halus pada set data NLP.

Dalam kerja sebelumnya, kami menggunakan penalaan halus arahan pada model parameter 137B pada 62 tugasan NLP, seperti menjawab soalan pendek, mengelaskan emosi yang dinyatakan dalam filem atau mengklasifikasikan ayat Sepanyol dan banyak lagi.

Dalam kerja ini, kami memperhalusi model bahasa parameter 540B pada lebih 1.8K tugasan. Selain itu, kerja sebelumnya hanya model bahasa yang diperhalusi dengan beberapa contoh (cth., MetaICL) atau model bahasa contoh sifar tanpa contoh (cth., FLAN, T0), manakala kami memperhalusi gabungan kedua-duanya.

Kami juga menyertakan data penalaan halus rantai pemikiran, yang membolehkan model melakukan inferens berbilang langkah. Kami memanggil kaedah kami yang lebih baik "Flan" untuk model bahasa yang diperhalusi.

Perlu diambil perhatian bahawa walaupun apabila diperhalusi pada 1.8K tugasan, Flan hanya menggunakan sebahagian kecil daripada pengiraan berbanding dengan pra-latihan (untuk PaLM 540B, Flan hanya Memerlukan 0.2% pengiraan pra-latihan).

Memperhalusi model bahasa pada tugasan 1.8K yang dirumuskan sebagai arahan dan menilai model pada tugasan baharu Tidak termasuk dalam pemangkasan. Penalaan halus dilakukan dengan/tanpa contoh (iaitu, 0-shot dan few-shot), dan dengan/tanpa rantai pemikiran, membolehkan model digeneralisasikan merentas pelbagai senario penilaian.

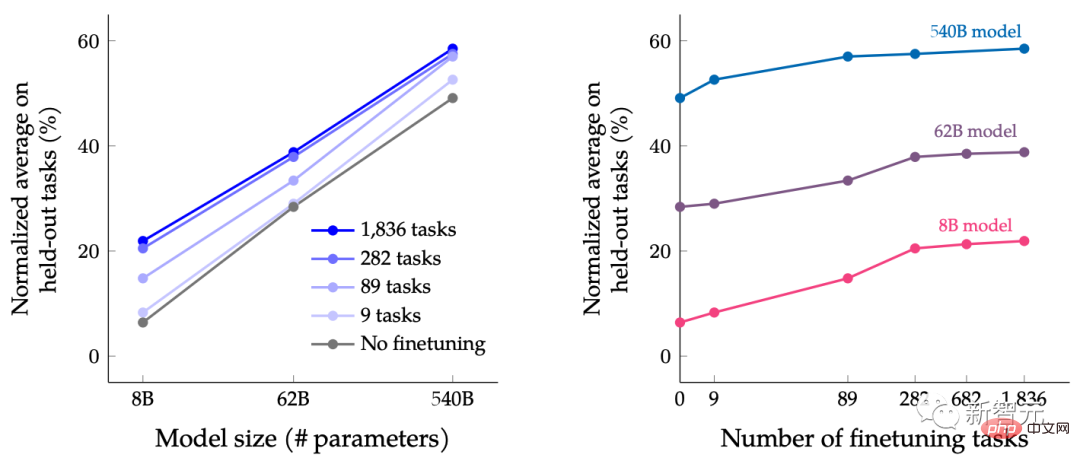

Dalam kertas ini, LM dalam julat saiz diperhalusi arahan, dengan tujuan mengkaji kesan bersama meluaskan saiz model bahasa secara serentak dan meningkatkan bilangan tugasan penalaan halus.

Sebagai contoh, untuk model bahasa kelas PaLM, termasuk spesifikasi parameter 8B, 62B dan 540B. Model kami dinilai berdasarkan empat kriteria penilaian penanda aras yang mencabar (MMLU, BBH, TyDiQA dan MGSM) dan mendapati bahawa kedua-dua memperluaskan bilangan parameter dan memperhalusi bilangan tugasan boleh meningkatkan prestasi pada tugasan baharu dan yang sebelum ini tidak kelihatan.

Memperluas model parameter kepada 540B dan menggunakan tugasan penalaan halus 1.8K boleh meningkatkan prestasi. Paksi-y bagi rajah di atas ialah purata ternormal bagi empat suite penilaian (MMLU, BBH, TyDiQA dan MGSM).

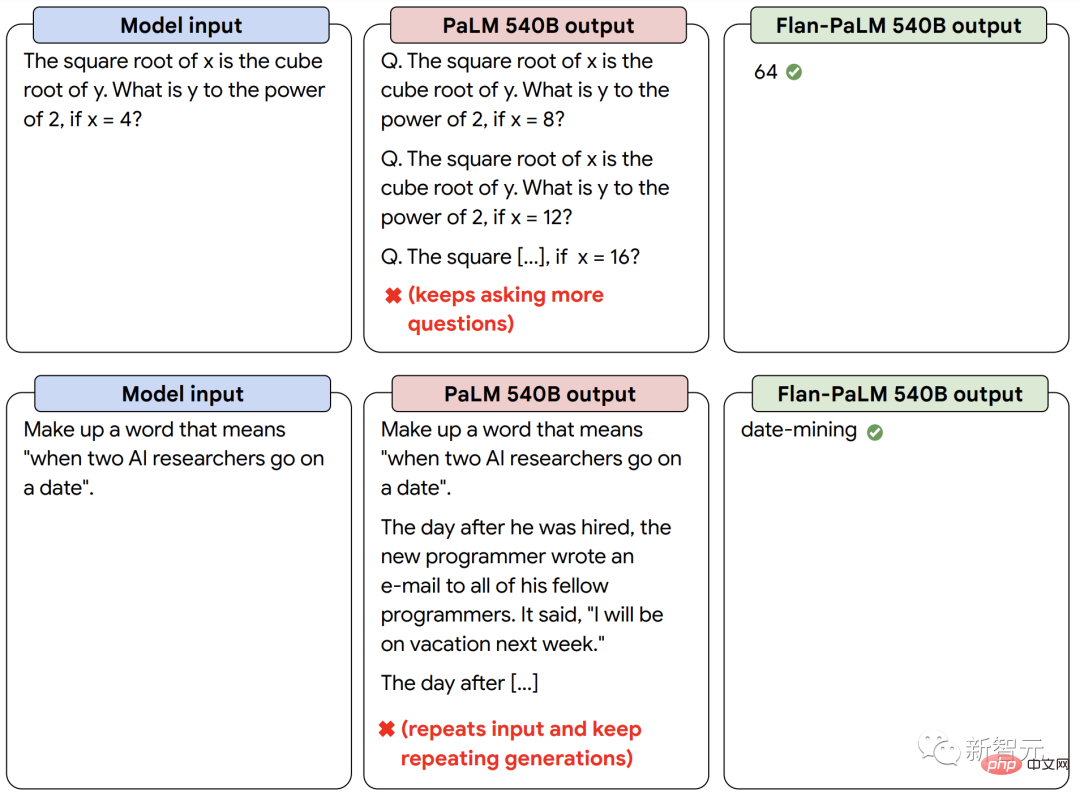

Selain prestasi yang lebih baik, LM yang diperhalusi arahan dapat bertindak balas kepada arahan pengguna pada masa inferens tanpa memerlukan sejumlah kecil contoh atau petunjuk kejuruteraan. Ini menjadikan LM lebih mesra pengguna merentas pelbagai input. Contohnya, LM tanpa penalaan halus arahan kadangkala mengulangi input atau gagal mengikut arahan, tetapi penalaan halus arahan boleh mengurangkan ralat tersebut.

Model bahasa yang diperhalusi arahan kami Flan-PaLM bertindak balas dengan lebih baik kepada arahan daripada model PaLM tanpa penalaan halus arahan.

Menggabungkan kuasa yang kuat untuk mencapai "1+1>2"

Akhir sekali, kami menunjukkan bahawa UL2R dan Flan boleh digabungkan untuk melatih model Flan-U-PaLM .

Memandangkan Flan menggunakan data baharu daripada tugasan NLP dan boleh mencapai penjejakan arahan mata sifar, kami menggunakan Flan sebagai kaedah pilihan kedua selepas UL2R.

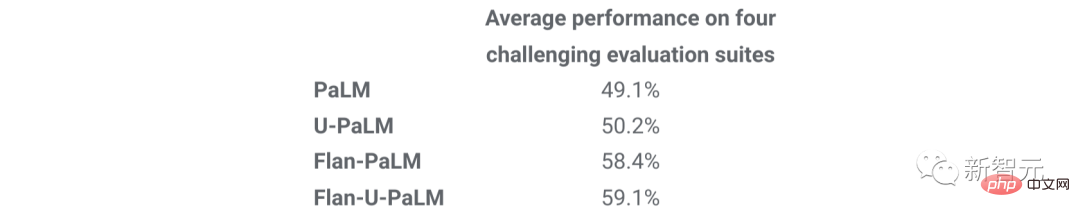

Kami menilai sekali lagi empat suite penanda aras dan mendapati model Flan-U-PaLM mengatasi model PaLM dengan hanya UL2R (U-PaLM) atau hanya Flan (Flan-PaLM). Tambahan pula, apabila digabungkan dengan rantaian pemikiran dan ketekalan diri, Flan-U-PaLM mencapai SOTA baharu pada penanda aras MMLU dengan skor 75.4%.

Berbanding dengan hanya menggunakan UL2R (U-PaLM) atau hanya menggunakan Flan (Flan-U-PaLM), membandingkan UL2R dan Flan (Flan - U-PaLM) digabungkan membawa kepada prestasi terbaik: purata ternormal bagi empat suite penilaian (MMLU, BBH, TyDiQA dan MGSM).

Secara amnya, UL2R dan Flan ialah dua kaedah pelengkap untuk menambah baik model bahasa pra-latihan. UL2R menggunakan data yang sama untuk menyesuaikan LM kepada objektif bercampur denoisers, manakala Flan memanfaatkan data latihan daripada lebih 1.8K tugasan NLP untuk mengajar model mengikut arahan.

Apabila model bahasa semakin besar, teknik seperti UL2R dan Flan, yang meningkatkan prestasi umum tanpa memerlukan pengiraan yang berat, mungkin menjadi semakin menarik.

Atas ialah kandungan terperinci Dengan hanya kuasa pengkomputeran yang begitu banyak, bagaimana untuk meningkatkan prestasi model bahasa? Google mempunyai idea baharu. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI