Rumah >Peranti teknologi >AI >Dihasilkan bersama oleh Qingbei! Tinjauan untuk memahami selok-belok 'Transformer+Reinforcement Learning'

Dihasilkan bersama oleh Qingbei! Tinjauan untuk memahami selok-belok 'Transformer+Reinforcement Learning'

- PHPzke hadapan

- 2023-04-13 14:01:031183semak imbas

Sejak dikeluarkan, model Transformer dengan cepat menjadi seni bina saraf arus perdana dalam bidang pemprosesan bahasa semula jadi dan penglihatan komputer dalam tetapan pembelajaran yang diselia.

Walaupun kegilaan Transformer telah mula melanda seluruh bidang pembelajaran pengukuhan, kerana ciri-ciri RL itu sendiri, seperti keperluan untuk unik ciri, reka bentuk seni bina, dsb. Gabungan semasa Transformer dan pembelajaran tetulang tidak lancar, dan laluan pembangunannya tidak mempunyai kertas yang relevan untuk meringkaskannya secara menyeluruh.

Baru-baru ini, penyelidik dari Universiti Tsinghua, Universiti Peking, dan Tencent bersama-sama menerbitkan kertas penyelidikan mengenai gabungan Transformer dan pembelajaran pengukuhan, mengkaji secara sistematik penggunaan Transformer dalam pembelajaran pengukuhan dan proses pembangunan.

Pautan kertas: https://arxiv.org/pdf/2301.03044.pdf

Artikel tersebut mengklasifikasikan hasil kerja berkaitan sedia ada, menjalankan perbincangan mendalam tentang setiap subbidang, dan akhirnya meringkaskan prospek masa depan hala tuju penyelidikan ini.

Transformer dengan RL

Pembelajaran pengukuhan (RL) menyediakan bentuk matematik untuk membuat keputusan berurutan, membolehkan model memperoleh tingkah laku pintar secara automatik .

RL menyediakan rangka kerja umum untuk kawalan berasaskan pembelajaran Dengan pengenalan rangkaian saraf dalam, kepelbagaian pembelajaran pengukuhan mendalam (DRL) juga telah mencapai kemajuan yang besar dalam beberapa tahun kebelakangan ini. tetapi masalah kecekapan sampel menghalang aplikasi DRL yang meluas dalam dunia sebenar.

Untuk menyelesaikan masalah ini, satu mekanisme yang berkesan ialah memperkenalkan bias induktif dalam rangka kerja DRL Yang lebih penting ialah pilihan seni bina penghampiran fungsi rangkaian neural ejen DRL.

Walau bagaimanapun, isu pemilihan reka bentuk seni bina dalam DRL masih belum diterokai sepenuhnya berbanding reka bentuk seni bina dalam pembelajaran terselia (SL), dan kebanyakan karya sedia ada pada seni bina RL Kerja itu bermotivasi dengan kejayaan komuniti pembelajaran (separuh) diselia.

Sebagai contoh, amalan biasa untuk mengendalikan input berasaskan imej berdimensi tinggi dalam DRL ialah memperkenalkan rangkaian neural konvolusi (CNN); Rangkaian Neural (RNN).

Dalam beberapa tahun kebelakangan ini, seni bina Transformer telah merevolusikan paradigma pembelajaran dalam pelbagai tugas SL dan telah menunjukkan prestasi yang unggul kepada CNN dan RNN Sebagai contoh, seni bina Transformer mampu mengendalikan perhubungan model dan mempunyai kebolehskalaan yang sangat baik.

Diinspirasikan oleh kejayaan SL, minat industri untuk mengaplikasikan Transformer dalam pembelajaran pengukuhan telah melonjak, yang boleh dikesan kembali ke kertas pada 2018, di mana mekanisme perhatian kendiri telah digunakan untuk struktur berstruktur Penaakulan perhubungan untuk perwakilan negeri.

Selepas itu, ramai penyelidik mula cuba menerapkan perhatian kendiri pada pembelajaran perwakilan untuk mengekstrak hubungan antara entiti, yang boleh membawa kepada pembelajaran dasar yang lebih baik.

Selain pembelajaran perwakilan negeri, kerja sebelumnya juga menggunakan Transformer untuk menangkap pergantungan temporal pelbagai langkah untuk menangani isu kebolehmerhatian separa.

Baru-baru ini, RL luar talian telah menarik perhatian kerana keupayaannya untuk menggunakan set data berskala besar luar talian juga menunjukkan bahawa seni bina Transformer boleh digunakan secara langsung sebagai model untuk jujukan membuat keputusan dan boleh digeneralisasikan kepada Pelbagai tugas dan bidang.

Tujuan kertas penyelidikan ini adalah untuk memperkenalkan bidang Transformers in Reinforcement Learning (TransformRL).

Walaupun Transformer telah dianggap sebagai model asas untuk kebanyakan penyelidikan SL semasa, ia masih kurang diterokai dalam komuniti RL. Malah, berbanding dengan medan SL, menggunakan Transformer sebagai penganggar fungsi dalam RL memerlukan penyelesaian beberapa masalah yang berbeza:

1 Data latihan ejen RL biasanya merupakan fungsi dasar semasa , yang akan menyebabkan tidak pegun dalam proses pembelajaran Transformer.

2 Algoritma RL sedia ada biasanya sangat sensitif terhadap pilihan reka bentuk semasa proses latihan, termasuk seni bina rangkaian dan kapasiti.

3. Seni bina berasaskan Transformer sering mengalami kos pengkomputeran dan ingatan yang tinggi, yang bermaksud bahawa latihan dan inferens adalah lambat dan mahal.

Sebagai contoh, dalam beberapa kes kecerdasan buatan dalam permainan, kecekapan penjanaan sampel sangat mempengaruhi prestasi latihan, bergantung pada kos pengiraan rangkaian dasar RL dan rangkaian nilai.

Masa depan TransformRL

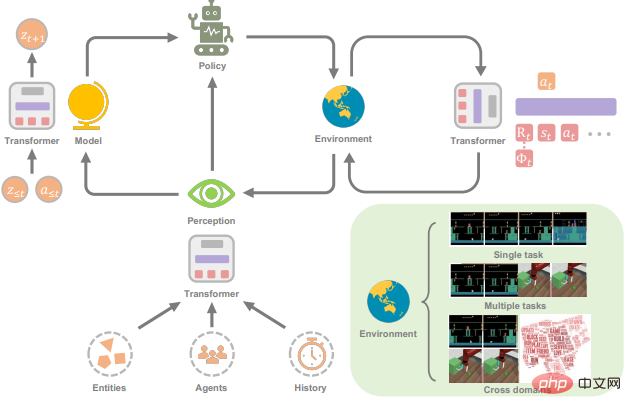

Kemajuan Transformers untuk RL dikaji secara ringkas dalam kertas kerja terutamanya termasuk:

1. Transformer boleh digunakan sebagai modul berkuasa dalam RL, seperti modul perwakilan atau model dunia; >

3. Transformer boleh meningkatkan prestasi generalisasi merentas tugasan dan domain.

Memandangkan Transformer telah menunjukkan prestasi yang kukuh dalam komuniti kecerdasan buatan yang lebih luas, penyelidik percaya bahawa menggabungkan Transformer dan RL adalah hala tuju penyelidikan yang menjanjikan. Berikut adalah beberapa butiran tentang prospek Masa Depan ini dan soalan terbuka dalam arah.

Menggabungkan pembelajaran pengukuhan dan pembelajaran penyeliaan (sendiri)

Menjejaki pembangunan TransformRL, anda boleh mendapati bahawa kaedah latihannya juga Merangkumi pembelajaran RL dan (penyeliaan kendiri).

Apabila digunakan sebagai modul perwakilan yang dilatih di bawah rangka kerja RL tradisional, pengoptimuman seni bina Transformer biasanya tidak stabil. Paradigma pembelajaran (seliaan kendiri) boleh menghapuskan masalah triad yang boleh membawa maut apabila menggunakan Transformers untuk menyelesaikan masalah membuat keputusan melalui pemodelan jujukan.

Di bawah rangka kerja pembelajaran (seliaan sendiri), prestasi strategi amat dikekang oleh kualiti data luar talian, dan pertukaran yang jelas antara eksploitasi dan penerokaan tidak lagi wujud , jadi strategi yang lebih baik boleh dipelajari apabila menggabungkan pembelajaran RL dan (seliaan kendiri) dalam pembelajaran Transformer.

Sesetengah kerja telah mencuba penyelesaian pra-latihan dan penalaan halus yang diselia untuk penyertaan RL, tetapi di bawah strategi yang agak tetap, penerokaan akan dihadkan, yang juga merupakan salah satu kesesakan yang perlu diselesaikan .

Selain itu, tugasan yang digunakan untuk penilaian prestasi juga agak mudah. Bolehkah Transfomer memanjangkan pembelajaran seliaan (sendiri) ini kepada set data yang lebih besar dan persekitaran yang lebih Kompleks dan nyata -aplikasi dunia juga patut diterokai lebih lanjut.

Selain itu, penyelidik berharap kerja masa hadapan akan memberikan lebih banyak pandangan teori dan empirikal tentang keadaan di mana pembelajaran penyeliaan (sendiri) itu dijangka berprestasi baik.

Sambung pembelajaran dalam talian dan luar talian melalui Transformer

Masuk ke RL luar talian Ia adalah peristiwa penting untuk TransformRL, tetapi sebenarnya, menggunakan Transformer untuk menangkap kebergantungan dalam urutan keputusan dan strategi abstrak adalah terutamanya tidak dapat dipisahkan daripada sokongan data luar talian yang banyak digunakan.

Walau bagaimanapun, untuk beberapa tugasan membuat keputusan, adalah tidak mungkin untuk menyingkirkan rangka kerja dalam talian dalam aplikasi praktikal.

Di satu pihak, tidak begitu mudah untuk mendapatkan data pakar dalam sesetengah tugasan, sebaliknya sesetengah persekitaran bersifat terbuka (seperti Minecraft), yang bermaksud strategi itu mesti sentiasa diselaraskan, untuk mengendalikan tugas yang tidak dilihat semasa interaksi dalam talian.

Oleh itu, penyelidik percaya bahawa adalah perlu untuk menghubungkan pembelajaran dalam talian dan pembelajaran luar talian.

Kebanyakan kemajuan penyelidikan selepas Decision Transformer memfokuskan pada rangka kerja pembelajaran luar talian, dan beberapa usaha cuba untuk menerima pakai paradigma pra-latihan luar talian dan penalaan halus dalam talian. Walau bagaimanapun, anjakan pengedaran dalam penalaan halus dalam talian masih wujud dalam algoritma RL luar talian, dan penyelidik menjangka dapat menyelesaikan masalah ini melalui beberapa reka bentuk khas Transformer Keputusan.

Tambahan pula, cara melatih Transformer Keputusan dalam talian dari awal adalah soalan terbuka yang menarik.

Struktur pengubah disesuaikan untuk masalah membuat Keputusan

Struktur pengubah dalam siri kaedah Pengubah Keputusan semasa Terutamanya a vanila Transformer, yang pada asalnya direka untuk urutan teks dan mungkin mempunyai beberapa sifat yang tidak sesuai untuk masalah keputusan.

Sebagai contoh, adakah sesuai untuk menggunakan mekanisme perhatian diri vanila untuk jujukan trajektori? Adakah elemen yang berbeza dalam urutan keputusan atau bahagian yang berbeza dari elemen yang sama perlu dibezakan dalam pembenaman kedudukan?

Di samping itu, memandangkan terdapat banyak varian yang mewakili trajektori sebagai jujukan dalam algoritma Pengubah Keputusan yang berbeza, masih terdapat kekurangan penyelidikan sistematik tentang cara memilih daripadanya.

Contohnya, bagaimana untuk memilih maklumat petunjuk yang mantap apabila menggunakan algoritma sedemikian dalam industri?

Dan Transformer vanila juga merupakan struktur yang mahal dari segi pengiraan, yang menjadikannya mahal dalam kedua-dua fasa latihan dan inferens, dan mempunyai jejak ingatan yang tinggi, yang juga mengehadkan keupayaannya untuk menangkap kebergantungan panjang.

Untuk mengurangkan masalah ini, beberapa kerja dalam NLP telah menambah baik struktur Transformer, tetapi sama ada struktur serupa boleh digunakan untuk masalah membuat keputusan juga patut diterokai.

Gunakan Transformer untuk melaksanakan lebih banyak ejen umum

Dalam kertas kerja, Transformers untuk ejen generalis Kajian telah menunjukkan potensi Transformers sebagai strategi umum.

Malah, reka bentuk Transformer membenarkan pemprosesan berbilang modaliti (seperti imej, video, teks dan suara) dengan cara yang sama seperti memproses blok, dan menunjukkan keperluan untuk ultra- rangkaian berkapasiti besar dan Skala yang sangat baik untuk set data yang besar.

Kerja terkini juga telah mencapai kemajuan yang ketara dalam ejen latihan yang mampu melaksanakan tugas berbilang modal dan merentas domain.

Walau bagaimanapun, memandangkan ejen ini dilatih pada set data berskala besar, masih belum pasti sama ada mereka hanya menghafal set data dan sama ada mereka boleh melakukan Generalize yang berkesan.

Oleh itu, cara mempelajari ejen yang boleh membuat generalisasi kepada tugas yang tidak kelihatan tanpa andaian yang kukuh masih menjadi persoalan yang patut dikaji.

Selain itu, penyelidik juga ingin tahu sama ada Transformer cukup berkuasa untuk digunakan untuk mempelajari model dunia umum yang boleh digunakan untuk tugasan dan senario yang berbeza.

RL for Transformers

Sementara artikel tersebut telah membincangkan bagaimana RL boleh mendapat manfaat daripada model Transformer, sebaliknya adalah juga benar Yang berkata, menggunakan RL untuk meningkatkan latihan Transformer kekal sebagai masalah terbuka yang menarik yang belum diterokai dengan baik.

Dapat dilihat bahawa pembelajaran tetulang baru-baru ini daripada maklum balas manusia (RLHF) boleh mempelajari model ganjaran dan menggunakan algoritma RL untuk memperhalusi Transformer untuk menjadikan model bahasa konsisten dengan niat manusia yang konsisten.

Pada masa hadapan, penyelidik percaya bahawa RL boleh menjadi alat yang berguna untuk meningkatkan lagi prestasi Transformer dalam bidang lain.

Atas ialah kandungan terperinci Dihasilkan bersama oleh Qingbei! Tinjauan untuk memahami selok-belok 'Transformer+Reinforcement Learning'. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI