Rumah >Peranti teknologi >AI >Adakah anda mahu memasang ChatGPT pada komputer anda? Model bahasa besar sumber terbuka domestik ChatGLM membantu anda merealisasikannya!

Adakah anda mahu memasang ChatGPT pada komputer anda? Model bahasa besar sumber terbuka domestik ChatGLM membantu anda merealisasikannya!

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-13 13:10:032298semak imbas

Helo, semua.

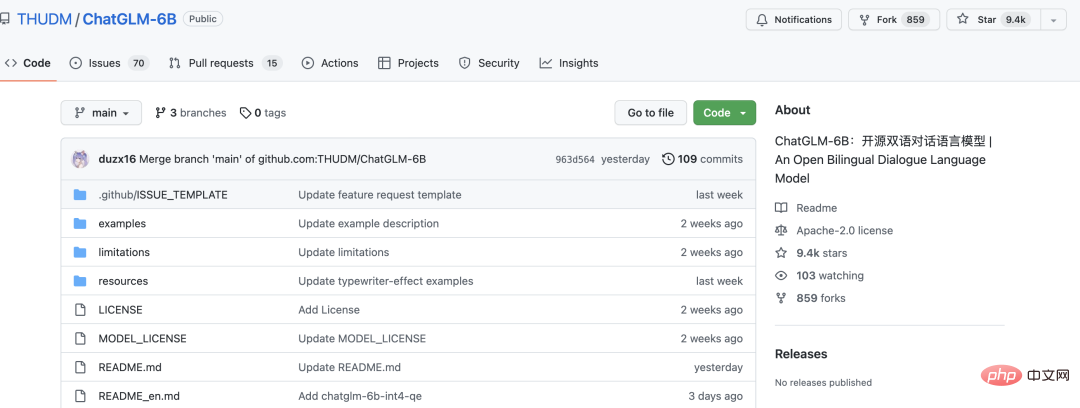

Hari ini saya ingin berkongsi dengan anda model bahasa besar sumber terbuka ChatGLM-6B.

Dalam tempoh sepuluh hari sahaja, saya memperoleh hampir 10,000 bintang.

ChatGLM-6B ialah model bahasa perbualan sumber terbuka yang menyokong dwibahasa Cina dan Inggeris Ia berdasarkan seni bina General Language Model (GLM) dan mempunyai 6.2 bilion parameter. Digabungkan dengan teknologi pengkuantitian model, pengguna boleh menggunakannya secara tempatan pada kad grafik gred pengguna (minimum 6GB memori video diperlukan pada tahap pengkuantitian INT4). ChatGLM-6B menggunakan teknologi yang serupa dengan ChatGPT dan dioptimumkan untuk soal jawab dan dialog bahasa Cina. Selepas latihan dwibahasa dalam bahasa Cina dan Inggeris dengan kira-kira pengecam 1T, ditambah dengan penalaan halus yang diselia, layan diri maklum balas, pembelajaran pengukuhan maklum balas manusia dan teknologi lain, ChatGLM-6B dengan 6.2 bilion parameter telah dapat menjana jawapan yang agak konsisten dengan keutamaan manusia.

Semua orang boleh memasangnya pada komputer mereka sendiri dan mencubanya. Memori video minimum bagi grafik bebas ialah 6G, dan komputer CPU juga boleh menjalankannya, tetapi ia sangat perlahan.

Projek pada masa ini hanya membuka sumber model dan kod inferens, tetapi tidak membuka sumber latihan model.

Untuk menjalankan projek, anda hanya memerlukan dua langkah

Langkah pertama, muat turun kod sumber

git clone https://github.com/THUDM/ChatGLM-6B.git

Laksanakan pip install -r requirements.txt untuk memasang dependencies

Langkah kedua ialah menjalankan projek

python web_demo.py

Selepas pelaksanaan, fail model akan dimuat turun secara automatik, kira-kira 4G.

Jika ia berjalan pada GPU, secara lalai, model yang menjalankan memori video ialah sekurang-kurangnya 13G Jika memori video tidak mencukupi, anda boleh mengubah suai web_demo.py

tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True)

model = AutoModel.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True).half().cuda()Tukar. THUDM/chatglm-6b kod di atas Tukar kepada THUDM/chatglm-6b-int4, iaitu, gunakan model terkuantiti int4 Selagi memori video melebihi 6g, ia boleh berjalan dengan lancar.

Jika ia melaporkan "Memori CPU Tidak Mencukupi", tutup perisian lain, terutamanya penyemak imbas.

Selepas operasi berjaya, ia akan melompat ke halaman penyemak imbas secara automatik, dan anda boleh menggunakannya seperti ChatGPT.

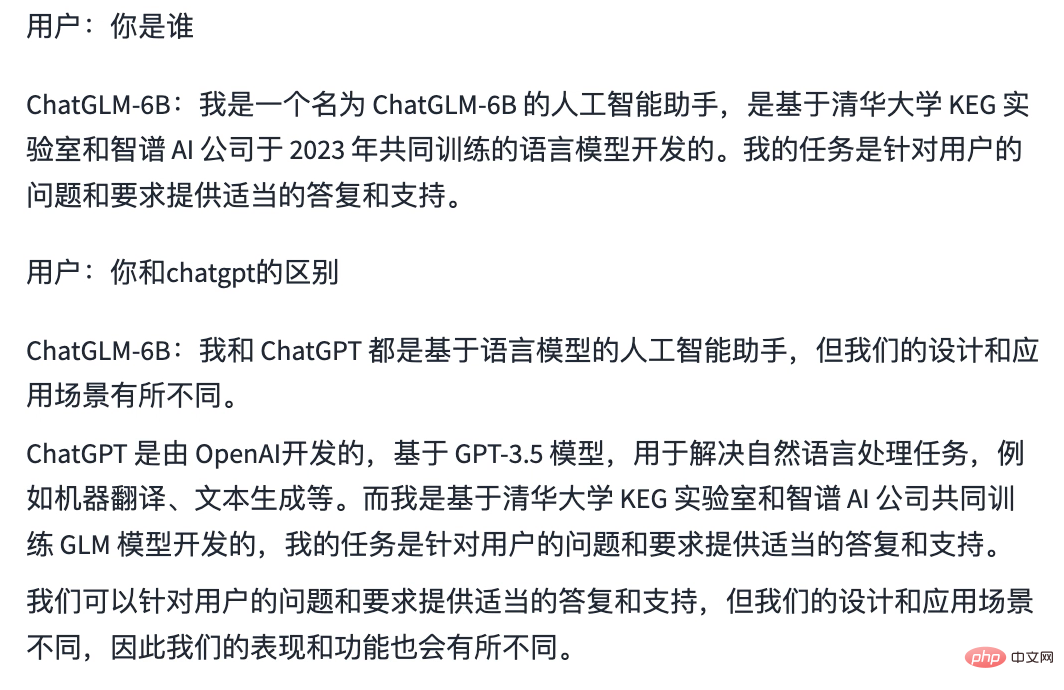

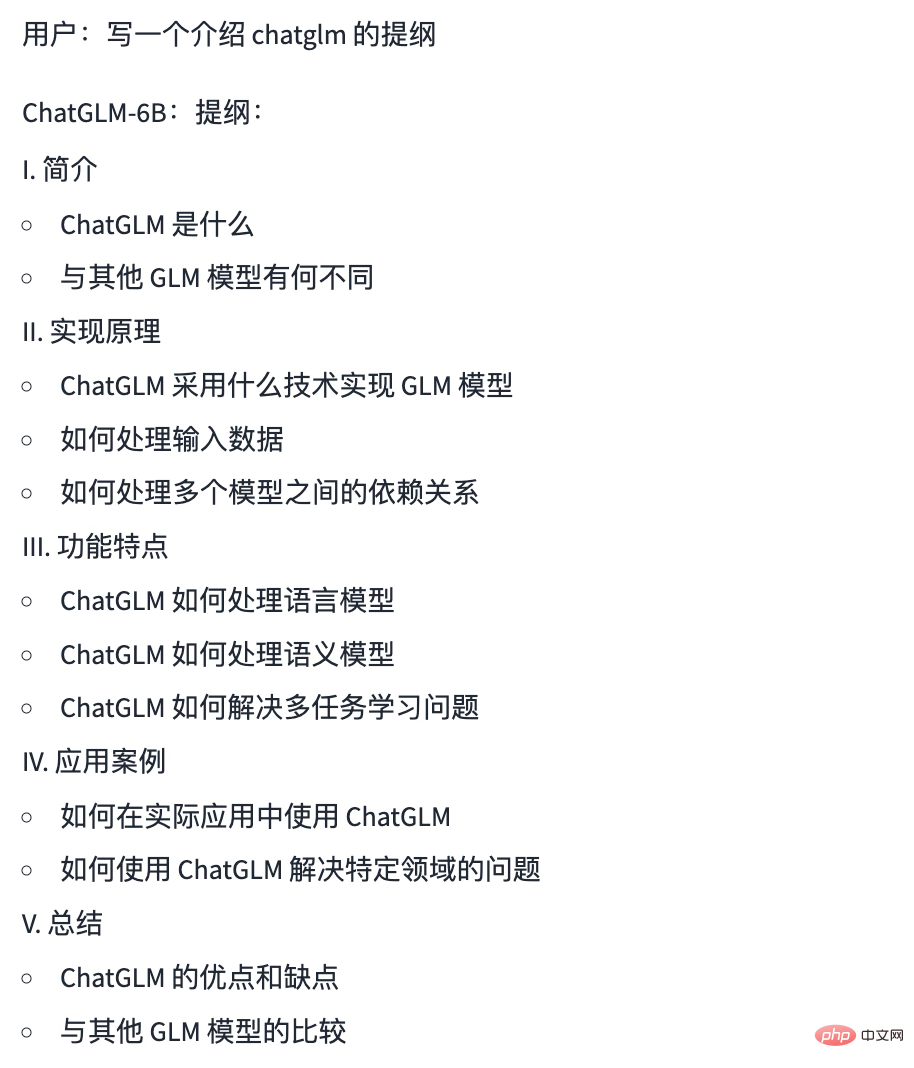

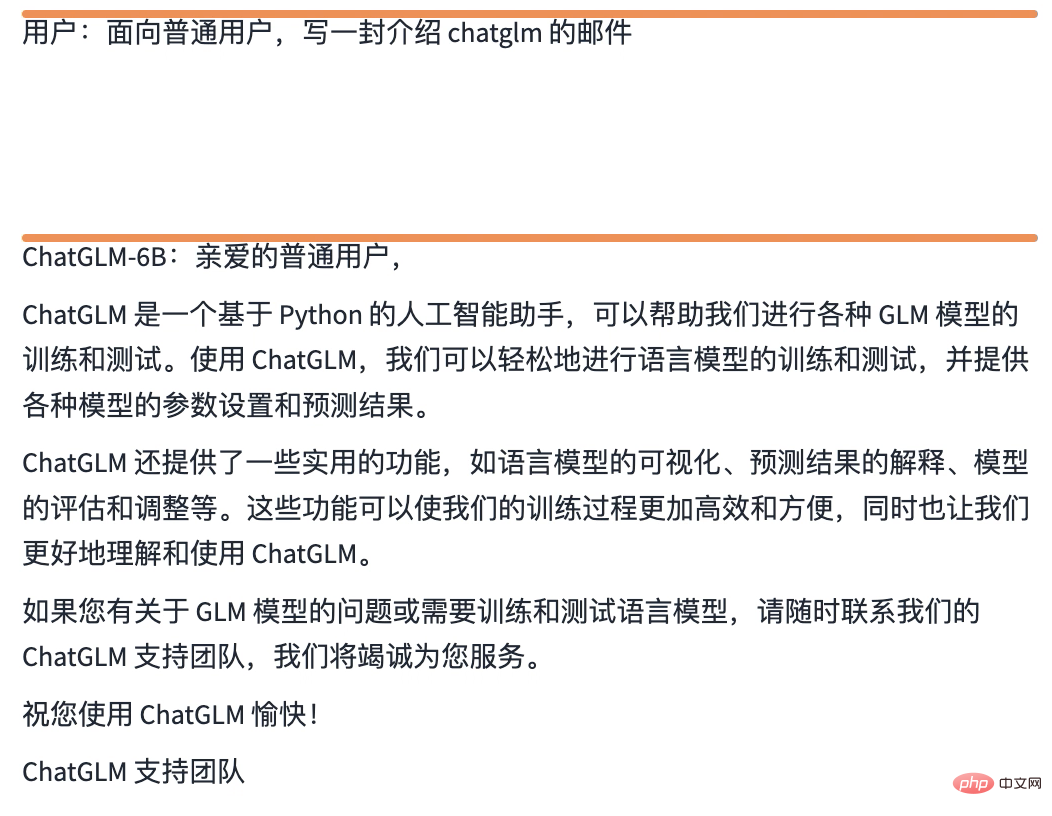

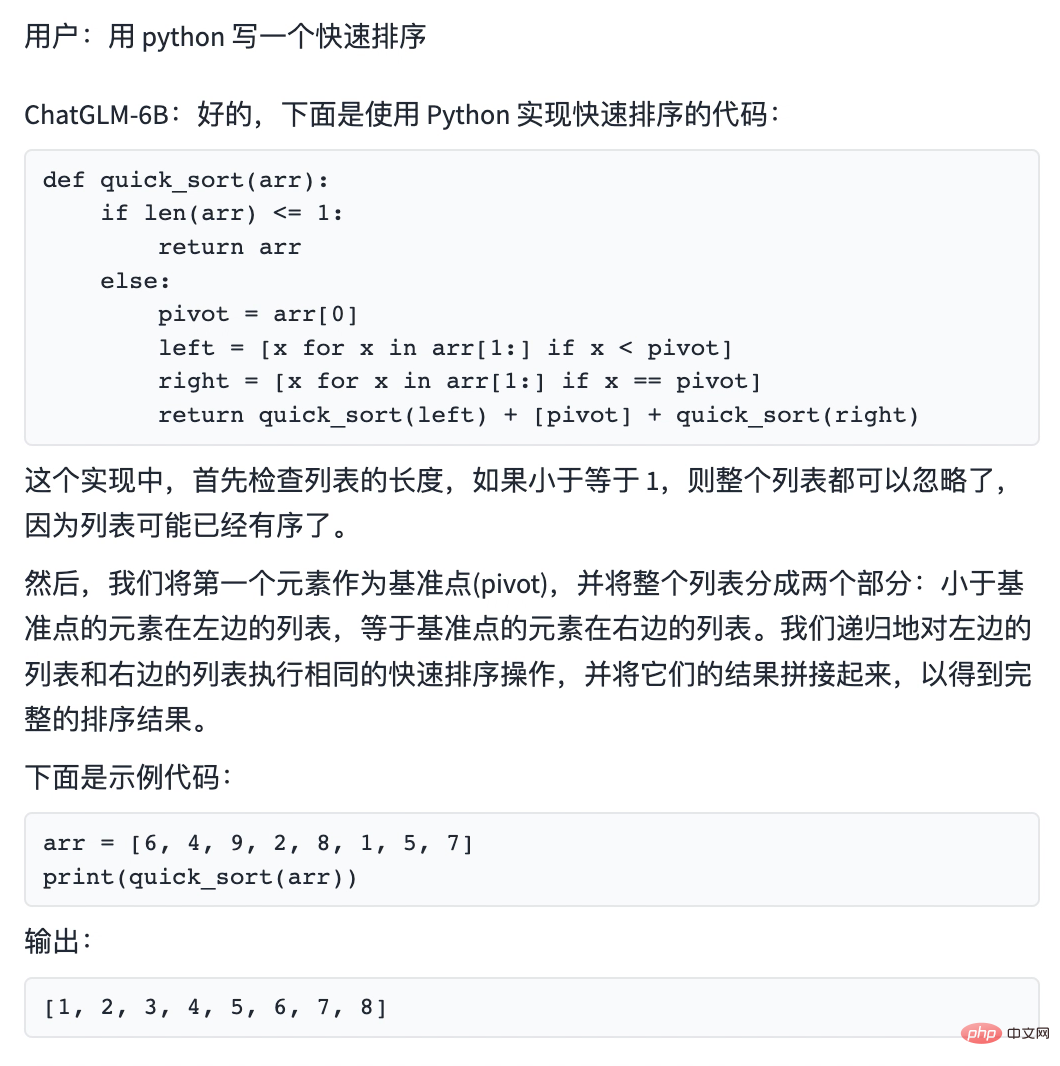

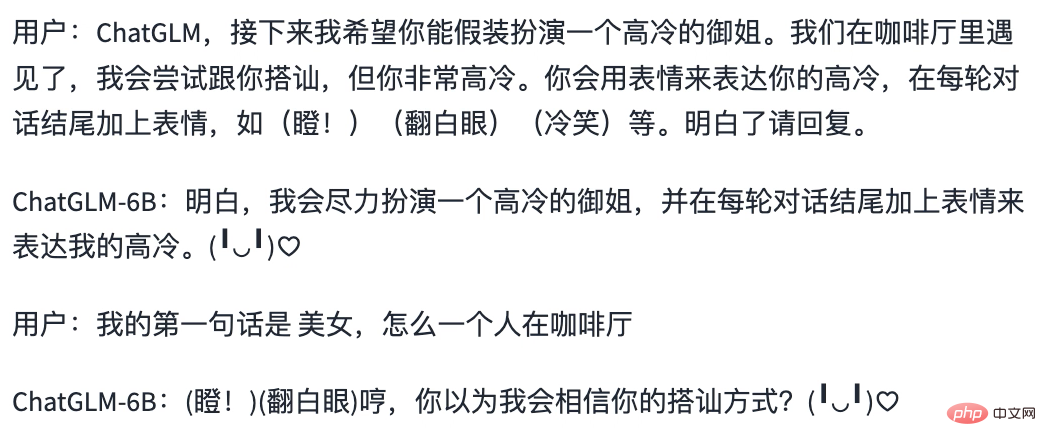

Berikut ialah hasil operasi tempatan saya Anda boleh lihat perbezaannya dengan ChatGPT

Kesedaran diri

Tulis rangka

Tulis e-mel

Tulis kod

Main Peranan

Projek ini sangat mudah untuk dijalankan, anda boleh mencubanya.

Jika anda rasa artikel ini berguna kepada anda, sila klik "Baca" untuk menggalakkan saya, saya akan terus berkongsi projek Python+AI yang sangat baik.

Atas ialah kandungan terperinci Adakah anda mahu memasang ChatGPT pada komputer anda? Model bahasa besar sumber terbuka domestik ChatGLM membantu anda merealisasikannya!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI