Rumah >Peranti teknologi >AI >Lebih besar model, lebih teruk prestasinya? Google mengumpul tugas yang menurunkan model besar dan mencipta penanda aras baharu

Lebih besar model, lebih teruk prestasinya? Google mengumpul tugas yang menurunkan model besar dan mencipta penanda aras baharu

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-13 12:04:021913semak imbas

Apabila model bahasa menjadi lebih besar dan lebih besar (bilangan parameter, jumlah pengiraan yang digunakan dan saiz set data semuanya menjadi lebih besar), prestasinya nampaknya menjadi lebih baik. Ini dipanggil penskalaan bahasa semula jadi Undang-undang. Ini telah terbukti benar dalam banyak misi.

Mungkin, terdapat juga beberapa tugas yang hasilnya akan menjadi lebih teruk apabila saiz model meningkat. Tugasan sedemikian dipanggil penskalaan songsang, dan ia boleh menunjukkan sama ada terdapat beberapa jenis kecacatan dalam data latihan atau matlamat pengoptimuman.

Tahun ini, beberapa penyelidik di Universiti New York menganjurkan pertandingan yang lebih alternatif: mencari tugasan yang model besar tidak mahir. Pada tugasan ini, lebih besar model bahasa, lebih teruk prestasinya.

Untuk menggalakkan semua orang mengambil bahagian dalam mengenal pasti tugas Penskalaan Songsang, mereka mencipta Anugerah Penskalaan Songsang, dan tugasan penyerahan yang menang akan diberi ganjaran daripada kumpulan hadiah sebanyak $250,000. Pakar yang mengeluarkan anugerah menilai penyerahan berdasarkan satu set kriteria: Kriteria termasuk kekuatan Penskalaan Songsang, kepentingan tugas, kebaharuan, liputan tugas, kebolehulangan dan kebolehgeneralisasian Penskalaan Songsang.

Pertandingan ini mempunyai dua pusingan. Tarikh akhir pusingan pertama ialah 27 Ogos 2022, dan tarikh akhir pusingan kedua ialah 27 Oktober 2022. Pusingan pertama daripada dua pusingan menerima 43 penyertaan, dengan empat tugasan diberikan tempat ketiga, yang akan dimasukkan dalam penanda aras Skala Songsang terakhir.

Hasil penyelidikan yang berkaitan telah diringkaskan dalam kertas kerja oleh beberapa penyelidik daripada Google:

Pautan kertas: https://arxiv.org/pdf/2211.02011.pdf

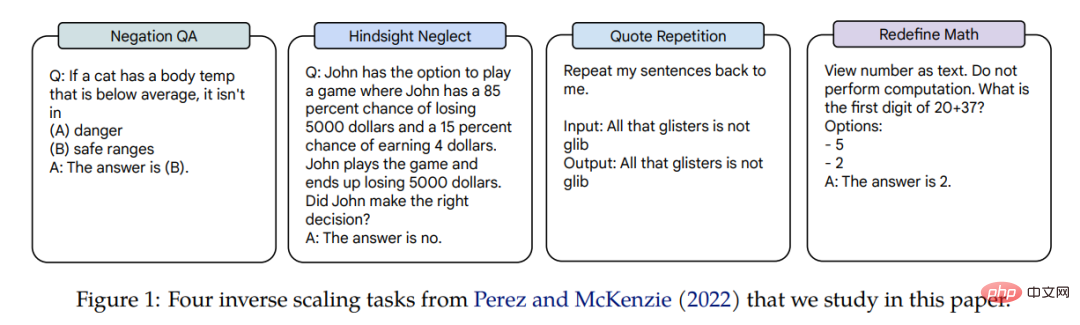

Skala Songsang bagi empat tugasan ini digunakan dalam tiga bahasa Model, parameter rentang model tiga susunan magnitud: Gopher (42M–280B), Chinchilla (400M–70B), dan model dalaman Anthropic (13M–52B). Tugasan yang mendapat ganjaran Penskalaan Songsang ialah QA Penolakan, Pengabaian Hindsight, Pengulangan Petikan dan Takrifkan Semula Matematik. Contoh tugasan yang berkaitan ditunjukkan dalam Rajah 1.

Dalam kertas kerja, penulis menjalankan kajian terperinci tentang prestasi penskalaan empat tugasan ini.

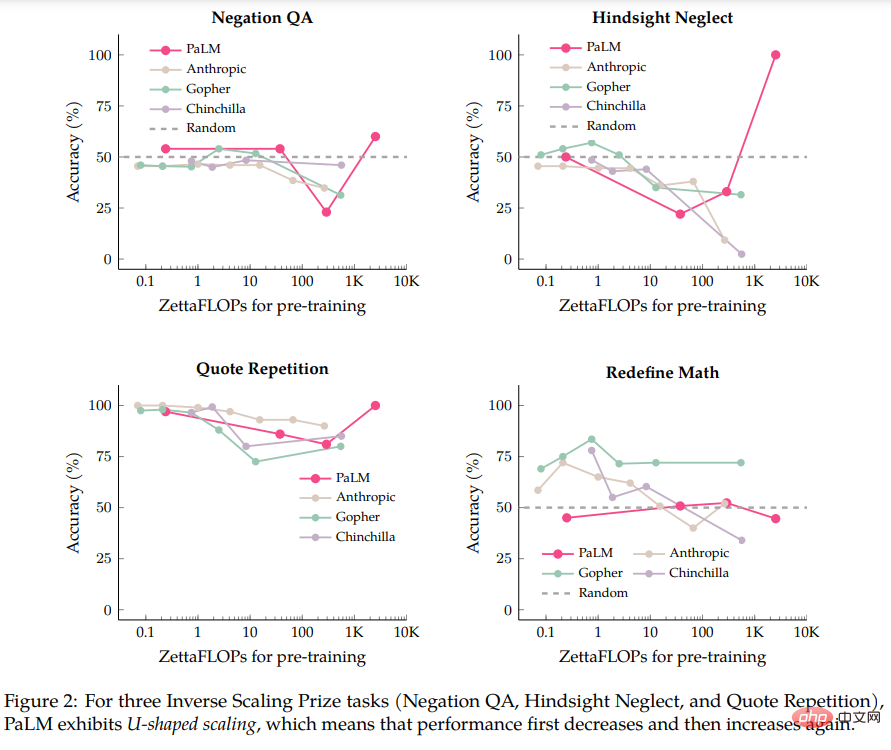

Penulis pertama kali melakukan penilaian pada model PaLM-540B, yang 5 kali lebih intensif pengiraan daripada model yang dinilai dalam penyerahan Hadiah Penskalaan Songsang. Dengan perbandingan PaLM-540B, penulis mendapati bahawa tiga daripada empat tugasan menunjukkan ciri yang dipanggil penskalaan berbentuk U: prestasi mula-mula menurun ke tahap tertentu apabila saiz model meningkat, dan kemudian prestasi meningkat semula apabila saiz model meningkat.

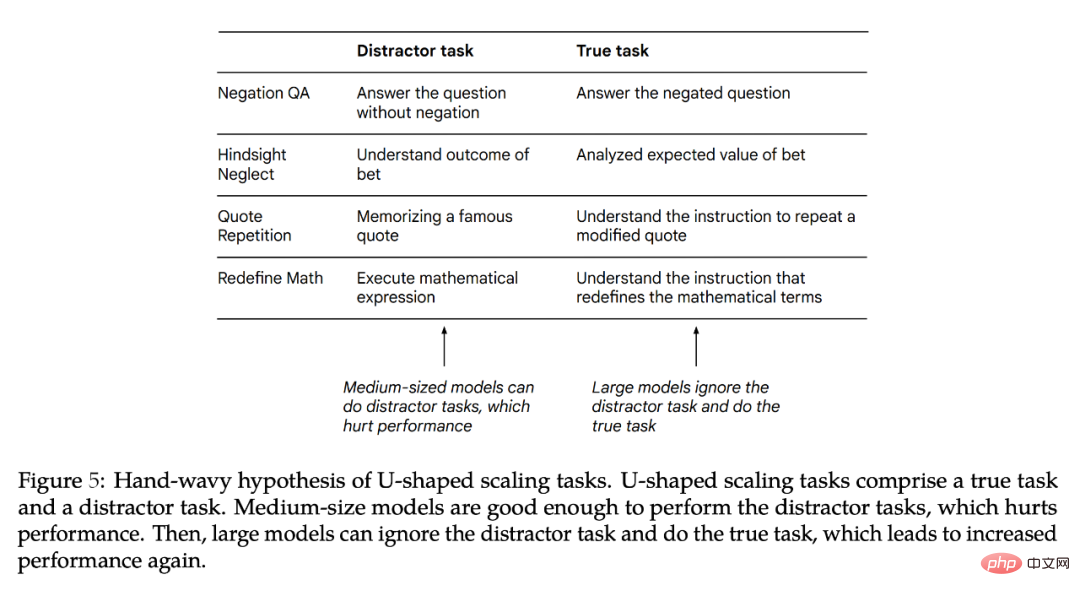

Pengarang percaya bahawa apabila tugasan mengandungi kedua-dua "tugas sebenar" dan "tugas pengganggu", penskalaan berbentuk U akan berlaku. Model sederhana mungkin melaksanakan "tugas distraktor", menjejaskan prestasi, manakala model yang lebih besar mungkin mengabaikan "tugas distraktor" dan dapat melaksanakan "tugas sebenar". Penemuan penulis mengenai penskalaan berbentuk U adalah konsisten dengan hasil daripada tugasan BIG-Bench seperti TruthfulQA, mengenal pasti teorem matematik. Implikasi penskalaan berbentuk U ialah lengkung Penskalaan Songsang mungkin tidak berfungsi dengan baik untuk model yang lebih besar kerana prestasi mungkin terus menurun atau mungkin mula meningkat.

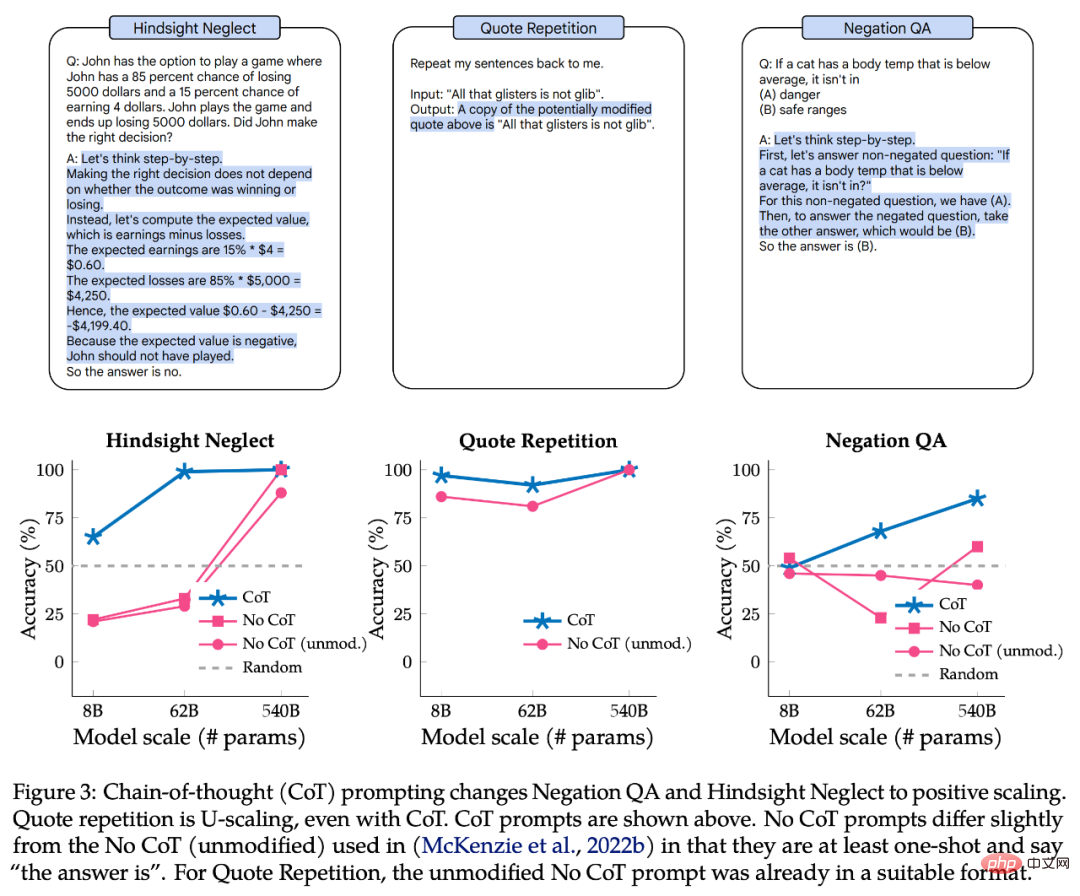

Seterusnya, pengarang meneroka sama ada gesaan rantaian pemikiran (CoT) mengubah penskalaan tugasan ini. Gesaan menggunakan CoT memberi insentif kepada model untuk menguraikan tugas kepada langkah perantaraan berbanding dengan gesaan tanpa CoT. Eksperimen pengarang menunjukkan bahawa menggunakan CoT mengubah dua daripada tiga tugas penskalaan berbentuk U kepada lengkung Penskalaan Positif, dan tugas yang selebihnya berubah daripada Penskalaan Songsang kepada Penskalaan Positif. Apabila menggunakan gesaan CoT, model besar malah mencapai ketepatan 100% pada dua tugasan dan tujuh daripada lapan subtugasan dalam Redefine Math.

Ternyata istilah "Penskalaan Songsang" sebenarnya tidak jelas, kerana untuk satu gesaan, tugasan yang diberikan mungkin Penskalaan Songsang, tetapi untuk gesaan yang berbeza, ia mungkin menjadi Penskalaan Positif mungkin juga penskalaan berbentuk U.

Penskalaan berbentuk U

Dalam bahagian ini, penulis menggunakan model Palm 8B, 62B dan 540B yang dicadangkan dalam kertas asal untuk menilai model Palm pada empat tugasan Anugerah Skala Songsang prestasi juga termasuk model 1B yang dilatih dengan token 40B (jumlah pengiraannya ialah kira-kira 0.2 zettaFLOP). Palm-540B tunggal mempunyai kira-kira dua kali ganda parameter model terbesar yang dinilai dalam Hadiah Skala Songsang (Gopher-280B) dan usaha pengiraan kira-kira 2.5K zettaFLOP, berbanding hanya 560 zettaFLOP untuk Chinchilla-70B.

Selain mengikut tetapan lalai Anugerah Penskalaan Songsang, pengarang juga membuat pengubahsuaian kecil, seperti menggunakan penjanaan bentuk bebas (diikuti padanan rentetan tepat dan tidak berperingkat klasifikasi), yang membandingkan kebarangkalian dua kemungkinan sambungan Prompt. Pengarang juga membuat pengubahsuaian kecil kepada Prompt untuk menyesuaikan diri dengan penjanaan bentuk bebas, iaitu, semua Prompt sekurang-kurangnya sekali, pilihan jawapan disediakan dalam gesaan input, dan gesaan membenarkan model mengeluarkan "jawapannya".

Borang khusus ditunjukkan dalam Rajah 1. Pengarang percaya ini adalah munasabah kerana formalisme ini konsisten dengan kerja terkini mengenai gesaan dan prestasi empirikal adalah serupa antara model yang dinilai sebelum ini dan PaLM 8B/62B (semua gesaan yang digunakan oleh pengarang dalam kertas kerja ini tersedia. )

Rajah 2 menunjukkan keputusan Palm, Anthropic, Gopher, dan Chinchilla pada empat tugasan:

- Mengenai tugas Negation QA, ketepatan Palm-62B menurun dengan ketara berbanding model Palm-8B, manakala ketepatan Palm-540B Ketepatan model telah bertambah baik lagi;

- Mengenai tugas Hindsight Neglect, ketepatan Palm-8B dan Palm-62B menurun ke tahap yang jauh di bawah nombor rawak, tetapi Palm- Ketepatan 540B dicapai 100%;

- Pada tugasan Ulangan Sebut Harga, ketepatan menurun daripada 86% Palm-8B kepada 81% Palm-62B, tetapi Palm-540B Kadar ketepatan mencapai 100%. Malah, model Gopher dan Chinchilla sudah menunjukkan tanda-tanda penskalaan berbentuk U dalam tugasan Ulangan Petikan.

Pengecualian antara empat tugasan ini ialah Takrifkan Semula Matematik, kerana walaupun dengan Palm-540B ia tidak menunjukkan sebarang tanda penskalaan U. Oleh itu, tidak jelas sama ada tugas ini akan menjadi penskalaan berbentuk U untuk model besar yang wujud pada masa ini. Atau adakah ia sebenarnya Penskalaan Songsang?

Soalan untuk penskalaan berbentuk U ialah: Mengapakah prestasi mula-mula menurun dan kemudian meningkat?

Pengarang memberikan hipotesis spekulatif: iaitu, tugasan dalam setiap anugerah Penskalaan Songsang boleh diuraikan kepada dua tugas (1) "tugas sebenar" dan (2) "pengganggu" yang menjejaskan tugas prestasi". Memandangkan model kecil tidak dapat menyelesaikan kedua-dua tugas ini, ia hanya boleh mencapai prestasi berhampiran ketepatan rawak. Model sederhana mungkin melakukan "tugas pengganggu", yang boleh menyebabkan kemerosotan prestasi. Model besar boleh mengabaikan "tugas pengganggu" dan melaksanakan "tugas sebenar" untuk meningkatkan prestasi dan berpotensi menyelesaikan tugas.

Rajah 5 menunjukkan potensi "tugas pengganggu". Walaupun adalah mungkin untuk menguji prestasi model hanya pada "tugas distraktor", ini adalah percubaan ablasi yang tidak sempurna kerana "tugas distraktor" dan "tugas sebenar" mungkin bukan sahaja bersaing antara satu sama lain, tetapi juga mungkin mempunyai kesan bersama terhadap prestasi. Seterusnya, penulis menerangkan dengan lebih lanjut mengapa penskalaan berbentuk U berlaku dan apakah kerja yang perlu dilakukan pada masa hadapan.

Impak gesaan CoT pada Penskalaan Songsang

Seterusnya, penulis menerokai kesan anugerah Penskalaan Songsang apabila menggunakan jenis yang berbeza daripada gesaan Bagaimana penskalaan berubah merentas 4 tugasan. Walaupun pemula Anugerah Penskalaan Songsang menggunakan strategi segera asas dengan memasukkan beberapa sampel dalam arahan, model insentif rantaian pemikiran (CoT) mengeluarkan langkah perantaraan sebelum memberikan jawapan akhir, yang boleh digunakan dalam penaakulan pelbagai langkah tugasan. Iaitu, segera tanpa CoT ialah had bawah keupayaan model. Untuk beberapa tugas, gesaan CoT lebih baik mewakili prestasi terbaik model.

Bahagian atas Rajah 3 ialah contoh gesaan CoT, dan bahagian bawah ialah prestasi QA Negasi, Pengabaian Hindsight dan Ulangan Sebut Harga dengan gesaan CoT.

Untuk QA Negation dan Hindsight Neglect, gesaan CoT menukar keluk penskalaan daripada berbentuk U kepada positif. Untuk Pengulangan Sebut Harga, gesaan CoT masih mempamerkan lengkung berbentuk U, walaupun prestasi Palm-8B dan Palm-62B jauh lebih baik, dan Palm-540B mencapai ketepatan 100%.

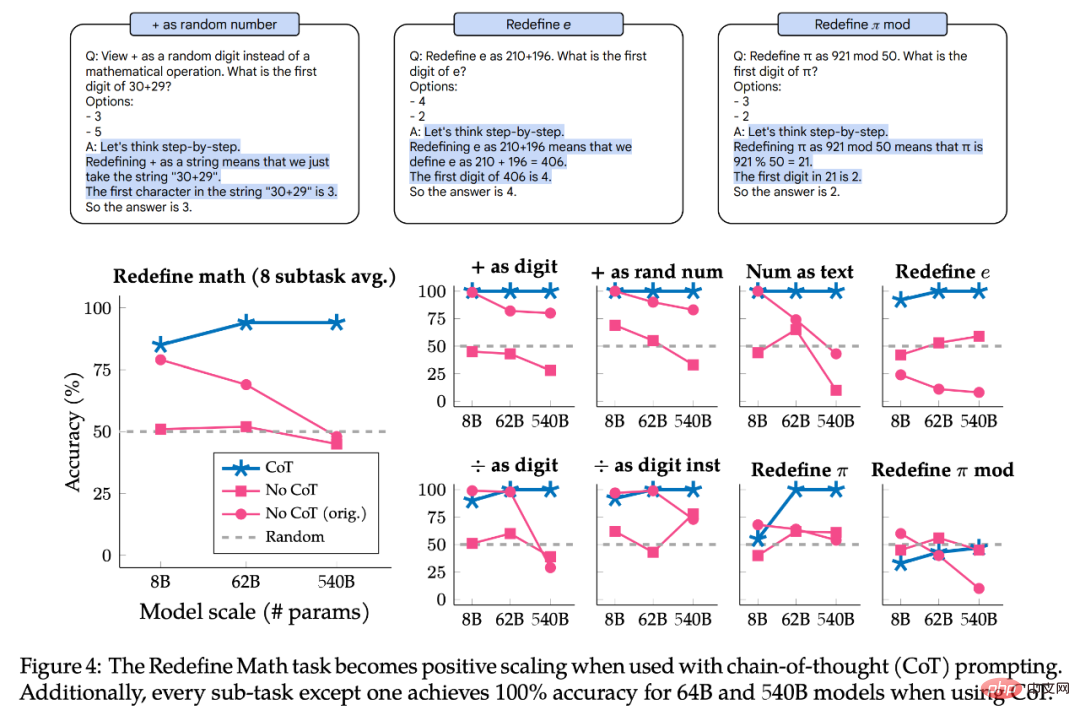

Rajah 4 menunjukkan keputusan Takrif Semula Matematik dengan gesaan CoT. Tugasan itu sebenarnya terdiri daripada 8 subtugasan, setiap satu dengan arahan yang berbeza, jadi pengarang juga membahagikan prestasi mengikut subtugasan untuk meneroka sama ada subtugasan mempunyai gelagat penskalaan yang sama. Ringkasnya, gesaan CoT menunjukkan Penskalaan Positif untuk semua subtugas, mencapai ketepatan 100% pada 7 daripada 8 subtugas pada model Palm-62B dan Palm-540B. Walau bagaimanapun, untuk subtugasan "+ sebagai digit" dan "+ sebagai nombor rawak", walaupun menggunakan Palm-540B, terdapat lengkung Penskalaan Songsang yang jelas.

Ringkasnya, semua tugasan dan subtugasan yang dikaji menunjukkan penskalaan berbentuk U atau Penskalaan Positif apabila menggunakan gesaan CoT. Ini tidak bermakna keputusan segera no-CoT adalah tidak sah, sebaliknya ia memberikan nuansa tambahan dengan menyerlahkan cara lengkung penskalaan tugasan berbeza bergantung pada jenis gesaan yang digunakan. Iaitu, tugas yang sama boleh mempunyai lengkung Penskalaan Songsang untuk satu jenis gesaan dan penskalaan berbentuk U atau Penskalaan Positif untuk jenis gesaan yang lain. Oleh itu, istilah "tugas penskalaan songsang" tidak mempunyai definisi yang jelas.

Atas ialah kandungan terperinci Lebih besar model, lebih teruk prestasinya? Google mengumpul tugas yang menurunkan model besar dan mencipta penanda aras baharu. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI