Rumah >Peranti teknologi >AI >GPU tunggal merealisasikan pembuatan keputusan dalam talian 20Hz, tafsiran kaedah perancangan trajektori yang cekap terkini berdasarkan model penjanaan jujukan

GPU tunggal merealisasikan pembuatan keputusan dalam talian 20Hz, tafsiran kaedah perancangan trajektori yang cekap terkini berdasarkan model penjanaan jujukan

- 王林ke hadapan

- 2023-04-13 10:43:021706semak imbas

Sebelum ini kami telah memperkenalkan aplikasi kaedah pemodelan jujukan berdasarkan Model Transformer dan Diffusion dalam pembelajaran pengukuhan khususnya dalam bidang kawalan berterusan luar talian. Antaranya, Trajectory Transformer (TT) dan Diffusser ialah algoritma perancangan berasaskan model Mereka menunjukkan ramalan trajektori berketepatan tinggi dan fleksibiliti yang baik, tetapi kelewatan membuat keputusan agak tinggi. Khususnya, TT mendiskrisikan setiap dimensi secara bebas sebagai simbol dalam jujukan, yang menjadikan keseluruhan jujukan sangat panjang, dan penggunaan masa penjanaan jujukan akan meningkat dengan cepat apabila dimensi keadaan dan tindakan meningkat.

Untuk membolehkan model penjanaan trajektori mencapai kelajuan membuat keputusan tahap praktikal, kami memulakan projek penjanaan trajektori yang cekap dan membuat keputusan selari dengan Diffusser (bertindih tetapi harus nanti). Pemikiran pertama kami adalah untuk menyesuaikan keseluruhan taburan trajektori menggunakan Transformer+Mixture of Gaussian dalam ruang berterusan dan bukannya taburan diskret. Walaupun masalah pelaksanaan tidak diketepikan, kami tidak dapat memperoleh model penjanaan yang agak stabil di bawah pendekatan ini. Kemudian kami mencuba Variational Autoencoder (VAE) dan membuat beberapa penemuan. Walau bagaimanapun, ketepatan pembinaan semula VAE tidak begitu ideal, menjadikan prestasi kawalan hiliran agak berbeza daripada TT. Selepas beberapa pusingan lelaran, akhirnya kami memilih VQ-VAE sebagai model asas untuk penjanaan trajektori, dan akhirnya memperoleh algoritma baharu yang boleh membuat sampel dan merancang dengan cekap, dan melakukan jauh lebih baik daripada kaedah berasaskan model lain pada tugas kawalan dimensi tinggi. Kami Memanggil Perancang Autoenkod Trajektori (TAP).

- Laman utama projek: https://sites.google .com/view/latentplan

- Halaman utama kertas: https://arxiv.org/abs/2208.10291

Kecekapan perancangan dan prestasi berdimensi tinggi

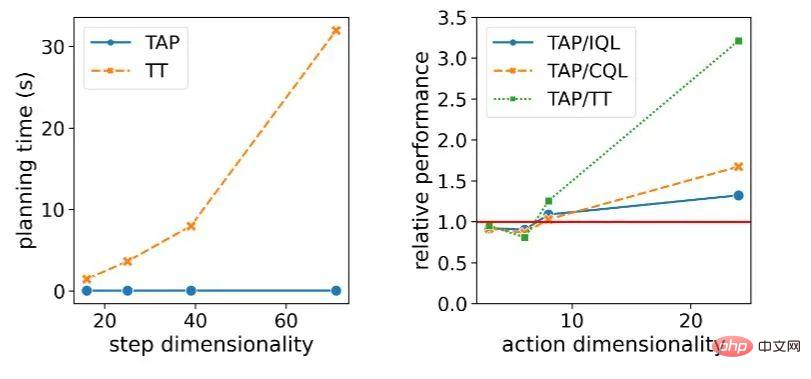

Di bawah satu GPU, TAP boleh membuat keputusan dalam talian dengan mudah dengan kecekapan membuat keputusan 20Hz Dalam tugasan D4RL berdimensi rendah, keputusan-. membuat kelewatan hanya TT Sekitar 1%. Lebih penting lagi, apabila keadaan tugas dan dimensi tindakan D meningkat, kelewatan keputusan teoritikal TT akan berkembang dengan kubus  , dan Peresap secara teorinya akan berkembang secara linear

, dan Peresap secara teorinya akan berkembang secara linear  , manakala kelajuan membuat keputusan TAP tidak dipengaruhi oleh dimensi

, manakala kelajuan membuat keputusan TAP tidak dipengaruhi oleh dimensi  . Dari segi prestasi membuat keputusan ejen, apabila dimensi tindakan meningkat, prestasi TAP bertambah baik berbanding kaedah lain, dan peningkatan berbanding kaedah berasaskan model (seperti TT) amat ketara.

. Dari segi prestasi membuat keputusan ejen, apabila dimensi tindakan meningkat, prestasi TAP bertambah baik berbanding kaedah lain, dan peningkatan berbanding kaedah berasaskan model (seperti TT) amat ketara.

Kepentingan kelewatan membuat keputusan terhadap tugasan membuat keputusan dan kawalan adalah sangat jelas Walaupun algoritma seperti MuZero berprestasi baik dalam persekitaran simulasi, ia memerlukan respons masa nyata dan pantas dalam dunia sebenar, kelewatan membuat keputusan yang berlebihan akan menjadi kesukaran utama dalam penggunaannya. Di samping itu, di bawah premis mempunyai persekitaran simulasi, kelajuan membuat keputusan yang perlahan juga akan membawa kepada kos ujian yang tinggi untuk algoritma yang serupa, dan kos penggunaan dalam pembelajaran pengukuhan dalam talian juga akan menjadi agak tinggi.

Selain itu, kami percaya bahawa membenarkan kaedah pemodelan penjanaan jujukan diperluaskan dengan lancar kepada tugasan dengan dimensi yang lebih tinggi juga merupakan sumbangan TAP yang sangat penting. Dalam dunia nyata, kebanyakan masalah yang kami harap pembelajaran pengukuhan akhirnya dapat diselesaikan sebenarnya mempunyai dimensi keadaan dan tindakan yang lebih tinggi. Contohnya, untuk pemanduan autonomi, input daripada pelbagai penderia tidak mungkin kurang daripada 100 walaupun selepas prapemprosesan pada pelbagai peringkat persepsi. Kawalan robot kompleks selalunya juga mempunyai ruang tindakan yang tinggi Darjah kebebasan semua sendi manusia adalah kira-kira 240, yang sepadan dengan ruang tindakan sekurang-kurangnya 240 dimensi Robot yang fleksibel seperti manusia juga memerlukan tindakan berdimensi tinggi angkasa lepas.

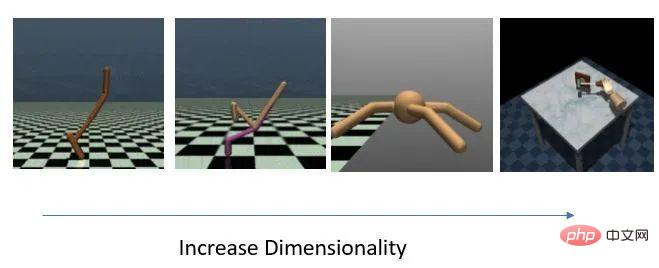

Empat set tugasan dengan dimensi yang semakin meningkat secara beransur-ansur

Perubahan dalam kependaman keputusan dan prestasi model relatif apabila dimensi tugas berkembang

Gambaran Keseluruhan Kaedah

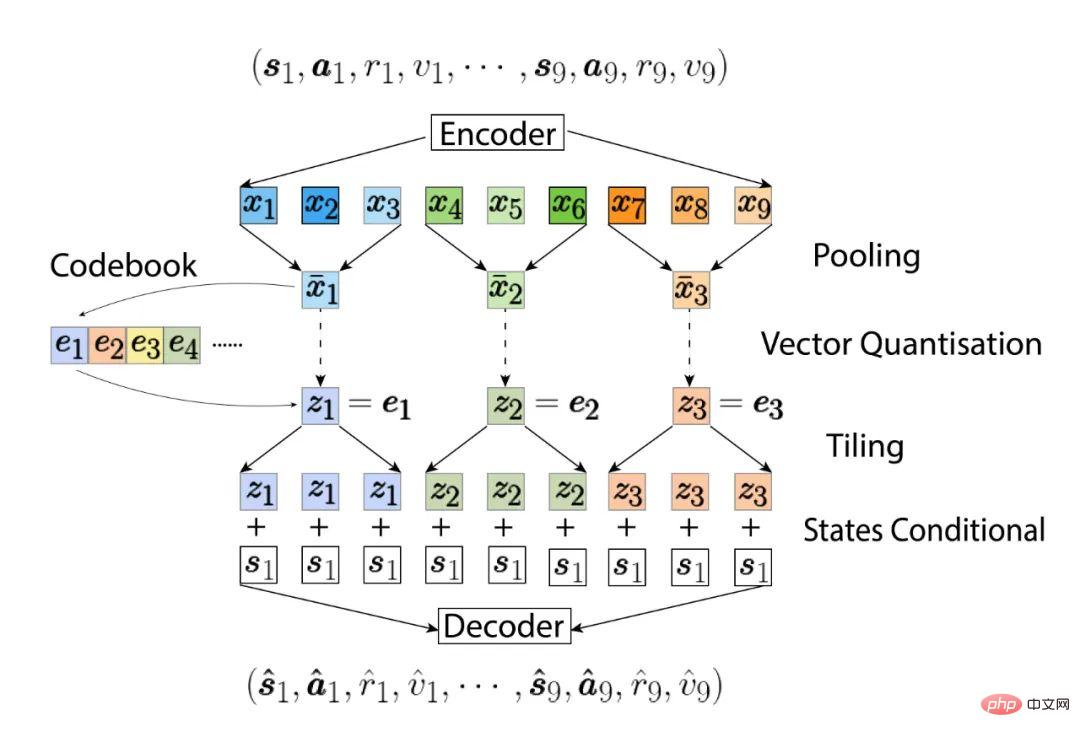

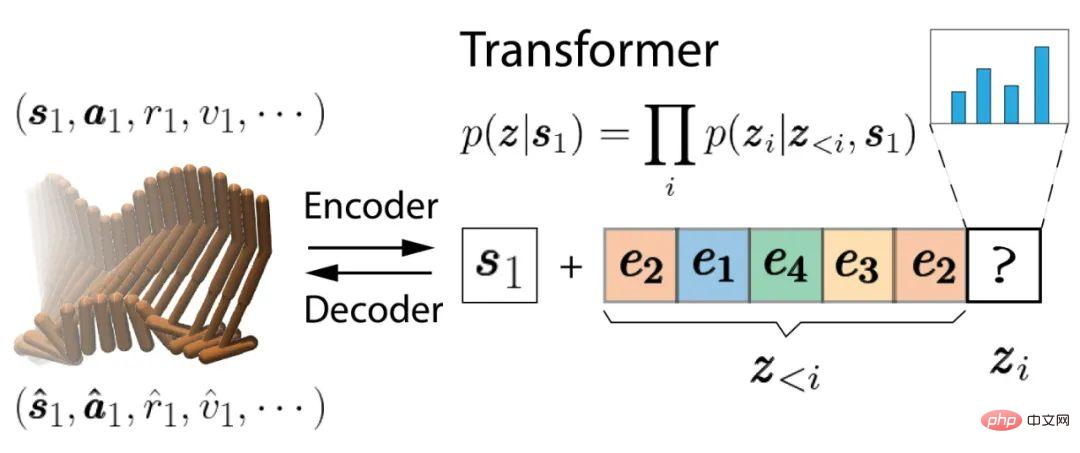

Pertama, latih bahagian pengekod auto VQ-VAE Terdapat dua perbezaan daripada VQ-VAE yang asal. Perbezaan pertama ialah kedua-dua pengekod dan penyahkod adalah berdasarkan Causal Transformer dan bukannya CNN. Perbezaan kedua ialah kita mempelajari taburan kebarangkalian bersyarat, dan trajektori yang mungkin dimodelkan mesti bermula dari keadaan semasa  . Pengekod automatik mempelajari pemetaan dua arah antara trajektori bermula daripada keadaan semasa

. Pengekod automatik mempelajari pemetaan dua arah antara trajektori bermula daripada keadaan semasa  dan kod pendam. Kod terpendam ini disusun dalam susunan kronologi seperti trajektori asal dan setiap kod terpendam akan dipetakan ke trajektori langkah

dan kod pendam. Kod terpendam ini disusun dalam susunan kronologi seperti trajektori asal dan setiap kod terpendam akan dipetakan ke trajektori langkah  sebenar. Disebabkan kami menggunakan Pengubah Sebab, kod terpendam dengan kedudukan temporal yang lebih rendah (seperti

sebenar. Disebabkan kami menggunakan Pengubah Sebab, kod terpendam dengan kedudukan temporal yang lebih rendah (seperti  ) tidak akan menghantar maklumat kepada urutan yang lebih tinggi (seperti

) tidak akan menghantar maklumat kepada urutan yang lebih tinggi (seperti  ), yang membenarkan TAP untuk menyahkod trajektori panjang NL melalui bahagian pengekodan tersembunyi N pertama, yang sangat berguna apabila menggunakannya untuk perancangan seterusnya.

), yang membenarkan TAP untuk menyahkod trajektori panjang NL melalui bahagian pengekodan tersembunyi N pertama, yang sangat berguna apabila menggunakannya untuk perancangan seterusnya.

Kami kemudiannya akan menggunakan Transformer gaya GPT-2 yang lain untuk memodelkan taburan kebarangkalian bersyarat bagi kod pendam ini  :

:

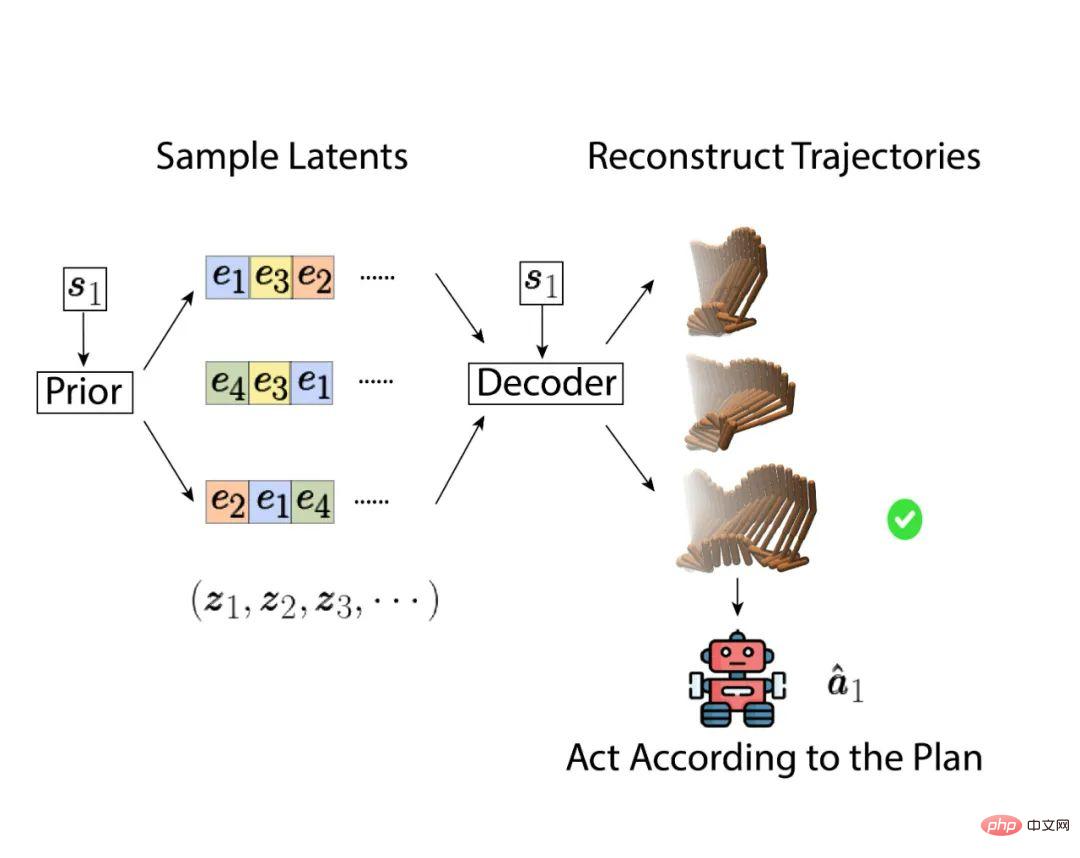

Apabila membuat keputusan, kita boleh mencari trajektori masa depan yang terbaik dengan mengoptimumkan dalam ruang pembolehubah terpendam, bukannya dalam ruang tindakan asal Optimize . Kaedah yang sangat mudah tetapi berkesan adalah dengan mengambil sampel terus daripada pengedaran pengekodan terpendam, dan kemudian pilih trajektori yang berprestasi terbaik, seperti yang ditunjukkan di bawah:

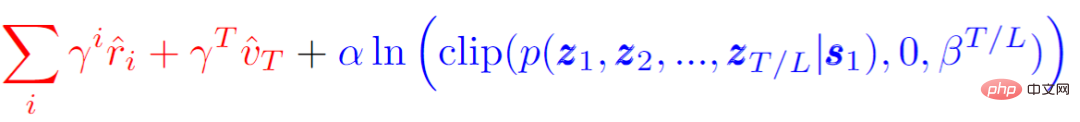

Skor objektif yang dirujuk semasa memilih trajektori optimum akan mempertimbangkan pulangan jangkaan trajektori (ganjaran ditambah penilaian langkah terakhir) dan kemungkinan atau kebarangkalian trajektori itu sendiri. Seperti formula berikut, dengan  ialah nombor yang jauh lebih besar daripada pulangan tertinggi Apabila kebarangkalian trajektori lebih tinggi daripada ambang

ialah nombor yang jauh lebih besar daripada pulangan tertinggi Apabila kebarangkalian trajektori lebih tinggi daripada ambang  , kriteria untuk. menilai trajektori ini ialah Pulangan yang dijangkakan (diserlahkan dalam warna merah), jika tidak, kebarangkalian trajektori ini sendiri akan menjadi komponen dominan (diserlahkan dengan warna biru). Dalam erti kata lain, TAP akan memilih satu dengan jangkaan pulangan tertinggi di antara trajektori yang lebih besar daripada ambang.

, kriteria untuk. menilai trajektori ini ialah Pulangan yang dijangkakan (diserlahkan dalam warna merah), jika tidak, kebarangkalian trajektori ini sendiri akan menjadi komponen dominan (diserlahkan dengan warna biru). Dalam erti kata lain, TAP akan memilih satu dengan jangkaan pulangan tertinggi di antara trajektori yang lebih besar daripada ambang.

Walaupun pensampelan langsung boleh menjadi sangat berkesan apabila jujukan ramalan adalah pendek apabila bilangan sampel cukup besar, di bawah premis mengehadkan bilangan sampel dan jumlah masa yang diperlukan untuk perancangan, adalah lebih baik untuk menggunakan pengoptimum yang lebih baik akan membawa kepada prestasi yang lebih baik. Dua animasi berikut menunjukkan perbezaan antara trajektori yang dijana oleh pensampelan langsung dan carian rasuk apabila meramalkan 144 langkah ke masa hadapan. Trajektori ini disusun mengikut skor sasaran akhir Trajektori di bahagian atas lapisan atas mempunyai skor yang lebih tinggi, dan trajektori yang disusun di belakangnya mempunyai skor yang lebih rendah. Selain itu, trajektori dengan skor rendah juga akan mempunyai ketelusan yang lebih rendah.

Dalam gambar kita dapat melihat bahawa banyak dinamik trajektori yang dihasilkan oleh pensampelan langsung tidak stabil dan tidak mematuhi undang-undang fizikal, khususnya, trajektori yang lebih ringan di latar belakang hampir semua terapung. Ini semua adalah trajektori dengan kebarangkalian yang agak rendah dan akan dihapuskan apabila pelan akhir dipilih. Trajektori di barisan hadapan kelihatan lebih dinamik, tetapi prestasi yang sepadan agak lemah, dan nampaknya ia akan jatuh. Sebaliknya, carian rasuk secara dinamik akan mempertimbangkan kebarangkalian trajektori apabila mengembangkan pembolehubah tersembunyi seterusnya, supaya cawangan dengan kebarangkalian yang sangat rendah akan ditamatkan lebih awal, supaya trajektori calon yang dihasilkan akan menumpukan pada prestasi dan kemungkinan yang lebih baik berada di sekeliling.

Pensampelan langsung

Carian rasuk

Hasil eksperimen

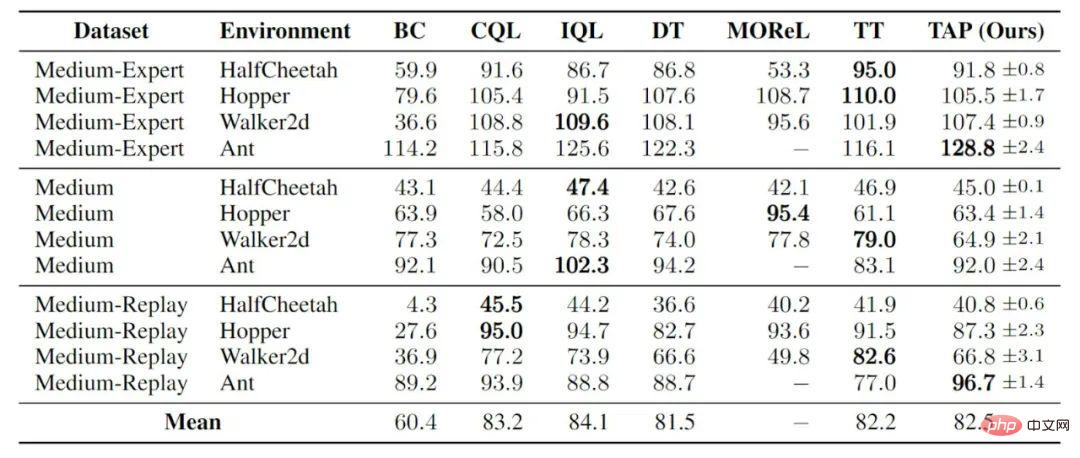

Jika tiada penilaian dan penambahbaikan strategi yang lebih maju, bergantung semata-mata pada kelebihan ketepatan ramalan, dalam Hidup tugasan berdimensi rendah, TAP telah mencapai prestasi yang setanding dengan pembelajaran pengukuhan luar talian yang lain:

kawalan pergerakan gim

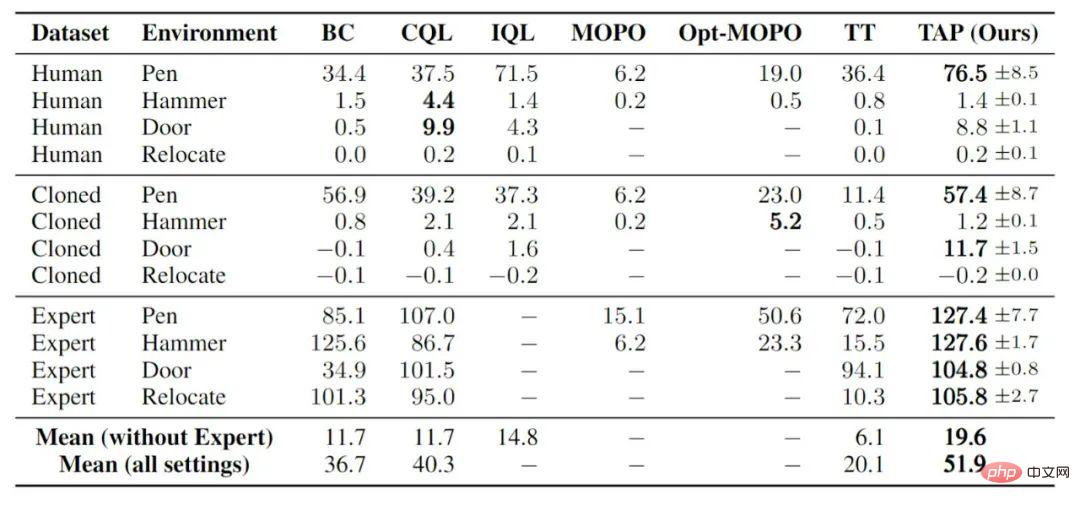

Pada tugasan berdimensi tinggi, TAP telah mencapai prestasi yang jauh lebih baik daripada kaedah berasaskan model yang lain, dan juga mengatasi prestasi biasa tanpa model. Sebenarnya ada dua soalan terbuka yang masih belum terjawab. Yang pertama ialah sebab kaedah berasaskan model terdahulu berprestasi lemah dalam tugas pembelajaran tetulang luar talian berdimensi tinggi ini, dan yang kedua ialah sebab TAP boleh mengatasi banyak kaedah tanpa model pada tugasan ini. Salah satu andaian kami ialah amat sukar untuk mengoptimumkan dasar mengenai masalah dimensi tinggi sambil turut mengambil kira menghalang dasar daripada menyimpang terlalu banyak daripada dasar tingkah laku. Apabila model dipelajari, ralat dalam model itu sendiri boleh menguatkan kesukaran ini. TAP mengalihkan ruang pengoptimuman ke ruang pembolehubah terpendam diskret yang kecil, yang menjadikan keseluruhan proses pengoptimuman lebih mantap.

kawalan tangan robotik adroit

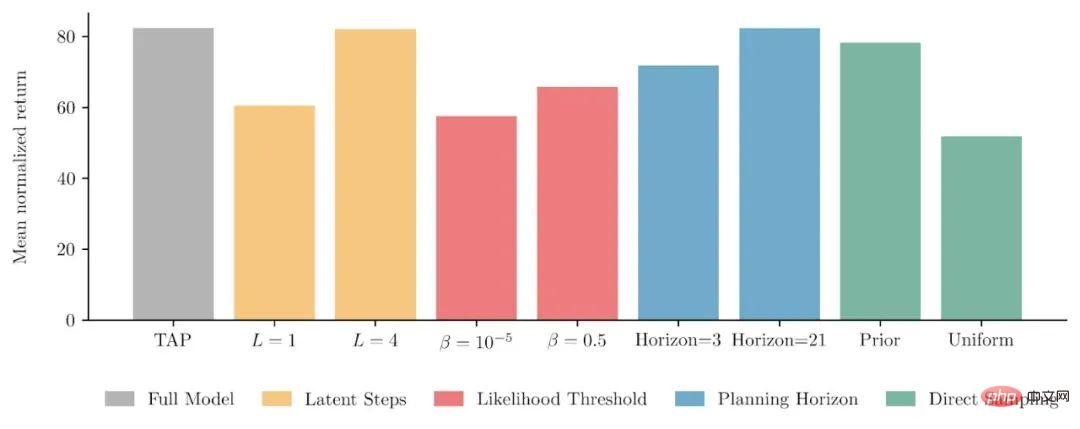

Beberapa kajian hirisan

Untuk banyak reka bentuk dalam TAP, kami juga menjalankan satu siri kajian hirisan mengenai tugas kawalan pergerakan gim. Yang pertama ialah bilangan langkah trajektori yang setiap kod pendam sebenarnya sepadan dengan  (histogram kuning Fakta telah membuktikan bahawa membiarkan pembolehubah pendam sepadan dengan peralihan keadaan berbilang langkah bukan sahaja). kelebihan pengiraan, tetapi juga prestasi model akhir Terdapat juga peningkatan. Dengan melaraskan ambang yang mencetuskan penalti trajektori berkemungkinan rendah dalam fungsi objektif carian

(histogram kuning Fakta telah membuktikan bahawa membiarkan pembolehubah pendam sepadan dengan peralihan keadaan berbilang langkah bukan sahaja). kelebihan pengiraan, tetapi juga prestasi model akhir Terdapat juga peningkatan. Dengan melaraskan ambang yang mencetuskan penalti trajektori berkemungkinan rendah dalam fungsi objektif carian  (histogram merah), kami juga mengesahkan bahawa kedua-dua bahagian fungsi objektif sememangnya membantu prestasi akhir model. . Perkara lain ialah bilangan langkah yang dirancang ke masa hadapan (ufuk perancangan, histogram biru) mempunyai sedikit kesan ke atas prestasi model Dalam carian pasca penempatan, walaupun hanya satu pembolehubah terpendam dikembangkan, prestasi ejen akhir hanya akan dikurangkan. sebanyak 10%.

(histogram merah), kami juga mengesahkan bahawa kedua-dua bahagian fungsi objektif sememangnya membantu prestasi akhir model. . Perkara lain ialah bilangan langkah yang dirancang ke masa hadapan (ufuk perancangan, histogram biru) mempunyai sedikit kesan ke atas prestasi model Dalam carian pasca penempatan, walaupun hanya satu pembolehubah terpendam dikembangkan, prestasi ejen akhir hanya akan dikurangkan. sebanyak 10%.

Akhirnya kami mencuba prestasi TAP di bawah pensampelan langsung (histogram hijau). Ambil perhatian bahawa bilangan sampel yang diambil di sini ialah 2048, manakala bilangan dalam animasi di atas hanyalah 256, dan animasi di atas menjana pelan untuk 144 langkah seterusnya, tetapi sebenarnya model asas kami mengarahkan perancangan untuk 15 langkah. Kesimpulannya ialah persampelan langsung boleh mencapai prestasi yang sama dengan carian rasuk apabila bilangan sampel mencukupi dan laluan yang dirancang tidak panjang. Tetapi ini adalah satu kes pensampelan daripada taburan bersyarat yang dipelajari bagi pembolehubah terpendam Jika kita mengambil sampel secara langsung dengan kebarangkalian yang sama daripada pengekodan terpendam, ia akan menjadi lebih teruk daripada model TAP yang lengkap pada akhirnya.

Hasil kajian hirisan

Atas ialah kandungan terperinci GPU tunggal merealisasikan pembuatan keputusan dalam talian 20Hz, tafsiran kaedah perancangan trajektori yang cekap terkini berdasarkan model penjanaan jujukan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI