Rumah >Peranti teknologi >AI >Model pra-latihan Teks-ke-SQL dua peringkat berbilang tugas MIGA berdasarkan T5

Model pra-latihan Teks-ke-SQL dua peringkat berbilang tugas MIGA berdasarkan T5

- PHPzke hadapan

- 2023-04-13 09:46:021359semak imbas

Semakin banyak kerja telah membuktikan bahawa model bahasa pra-latihan (PLM) mengandungi pengetahuan yang kaya Untuk tugasan yang berbeza, menggunakan kaedah latihan yang sesuai untuk memanfaatkan PLM boleh meningkatkan prestasi model. Dalam tugas Text-to-SQL, penjana arus perdana semasa adalah berdasarkan pepohon sintaks dan perlu direka bentuk untuk sintaks SQL.

Baru-baru ini, NetEase Interactive Entertainment AI Lab bekerjasama dengan Guangdong University of Foreign Studies dan Columbia University untuk mencadangkan model pra-latihan berbilang tugas dua peringkat MIGA berdasarkan pra-latihan kaedah model bahasa pra-latihan T5. MIGA memperkenalkan tiga tugas tambahan dalam peringkat pra-latihan dan menyusunnya ke dalam paradigma tugas penjanaan bersatu, yang boleh melatih secara seragam semua set data Teks-ke-SQL pada masa yang sama, dalam peringkat penalaan halus, MIGA menyasarkan ralat; berbilang pusingan dialog Masalah pemindahan digunakan untuk gangguan SQL, yang meningkatkan keteguhan penjanaan model.

Pada masa ini untuk penyelidikan Teks-ke-SQL, kaedah arus perdana adalah terutamanya model penyahkod pengekod berdasarkan pepohon sintaks SQL, yang boleh memastikan bahawa hasil yang dihasilkan mesti mematuhi sintaks SQL , tetapi ia perlu disasarkan sintaks SQL direka khas. Terdapat juga beberapa penyelidikan terkini mengenai Text-to-SQL berdasarkan model bahasa generatif, yang boleh mewarisi pengetahuan dan keupayaan model bahasa pra-latihan dengan mudah.

Untuk mengurangkan pergantungan pada pokok sintaks dan memanfaatkan kebolehan model bahasa pra-latihan dengan lebih baik, kajian ini mencadangkan model berbilang bahasa dua peringkat di bawah rangka kerja pra- model T5 terlatih. Model pra-latihan Teks-ke-SQL Tugasan MIGA (MultI-tugas Ggenerasi frAmework ).

MIGA dibahagikan kepada dua peringkat proses latihan:

- Dalam peringkat pra-latihan, MIGA menggunakan pra-latihan yang sama paradigma latihan sebagai T5 , tiga tugas tambahan tambahan yang berkaitan dengan Text-to-SQL dicadangkan untuk merangsang pengetahuan dengan lebih baik dalam model bahasa pra-latihan. Kaedah latihan ini boleh menyatukan semua set data Text-to-SQL dan mengembangkan skala data latihan juga boleh mereka bentuk tugas tambahan yang lebih berkesan untuk meneroka lebih lanjut potensi pengetahuan model bahasa yang telah dilatih.

- Dalam fasa penalaan halus, MIGA menyasarkan masalah penghantaran ralat yang cenderung berlaku dalam perbualan berbilang pusingan dan SQL Ia mengganggu sejarah SQL semasa proses latihan, menjadikan penjanaan pusingan semasa SQL lebih berkesan.

Model MIGA mengatasi model berasaskan pepohon sintaks terbaik semasa pada dua set data awam Teks-ke-SQL dialog berbilang pusingan Penyelidikan berkaitan telah dijalankan oleh AAAI 2023 Diterima.

Alamat kertas: https://arxiv.org/abs/2212.09278

Butiran model MIGA

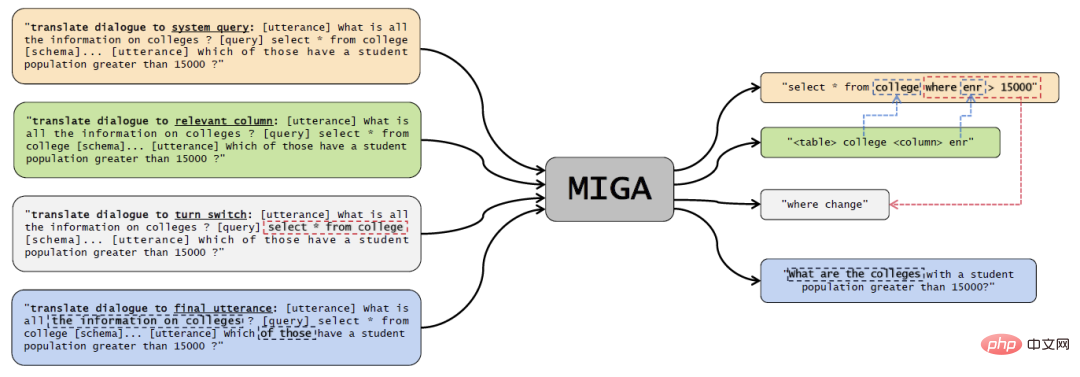

Rajah 1 rajah model MIGA.

Fasa pra-latihan pelbagai tugas

Kajian ini terutamanya merujuk kepada kaedah pra-latihan daripada T5, berdasarkan model T5 terlatih direka dengan empat tugas pra-latihan:

- Teks-ke-SQL Tugas utama: Untuk bahagian kuning dalam gambar di atas, reka bentuk Prompt sebagai "terjemah dialog kepada pertanyaan sistem", dan kemudian gunakan beberapa token khas untuk menterjemah perbualan sejarah, pangkalan data maklumat dan SQL Pernyataan disambungkan dan dimasukkan ke dalam pengekod T5, dan penyahkod terus mengeluarkan pernyataan SQL yang sepadan dengannya; , gesaan reka bentuk ialah "terjemah dialog ke lajur yang berkaitan", input pengekod T5 juga konsisten dengan tugas utama, dan penyahkod perlu mengeluarkan jadual dan lajur data yang berkaitan dengan masalah semasa, untuk meningkatkan pemahaman model of Text-to-SQL;

- Ramalan operasi pusingan semasa: Bahagian kelabu dalam gambar di atas direka sebagai "terjemah dialog untuk menukar suis". pemahaman konteks dalam berbilang pusingan dialog, membandingkan dialog dan SQL pusingan sebelumnya, penyahkod perlu mengeluarkan perubahan yang telah dibuat kepada tujuan perbualan semasa Sebagai contoh, dalam contoh dalam gambar, keadaan di mana telah diubah;

- Ramalan perbualan akhir: bahagian biru dalam gambar di atas, reka bentuk Prompt Tujuan "terjemahkan dialog kepada ujaran akhir" adalah untuk membolehkan model memahami kontekstual dengan lebih baik dialog. Penyahkod perlu mengeluarkan keseluruhan dialog berbilang pusingan dan penerangan masalah lengkap yang sepadan dengan SQL pada saat terakhir.

- Melalui reka bentuk kaedah latihan yang bersatu, MIGA boleh menjadi serba boleh dan fleksibel untuk mengendalikan lebih banyak tugasan tambahan yang berkaitan dengan tugas, dan ia juga mempunyai kelebihan berikut:

Merujuk kepada langkah-langkah manusia menulis SQL, teks perbualan kepada tugasan SQL diuraikan kepada beberapa sub-tugas, membolehkan tugas utama belajar daripadanya; 🎜>

Format pembinaan sampel latihan adalah konsisten dengan T5, yang boleh memaksimumkan potensi model T5 pra-latihan untuk tugasan sasaran; daripada pelbagai tugas tambahan. Apabila digunakan pada tugas tertentu, model pra-latihan di atas hanya perlu diperhalusi menggunakan objektif latihan yang sama dalam data berlabel tugas khusus.- Dalam peringkat pra-latihan, kajian menyepadukan data daripada dataset Text-to-SQL Spider dan dataset Text-to-SQL perbualan SparC dan CoSQL untuk melatih model T5.

- Fasa penalaan halus

Selepas fasa pra-latihan, kajian ini hanya menggunakan Text-to- Tugasan SQL untuk memperhalusi model. Apabila meramalkan pusingan semasa SQL, kajian ini akan menggabungkan SQL yang diramalkan pada pusingan sebelumnya Dalam proses ini, untuk cuba mengatasi masalah penghantaran ralat yang disebabkan oleh beberapa pusingan dialog dan penjanaan, kajian ini mencadangkan skema gangguan SQL. . , mengganggu pusingan sejarah SQL dalam data input dengan kebarangkalian α. Gangguan penyataan SQL terutamanya mencontohkan token yang sepadan dengan kebarangkalian β, dan kemudian melakukan salah satu gangguan berikut:

Gunakan lajur dalam jadual data yang sama untuk secara rawak ubah suai atau baharu Tambah lajur dalam bahagian PILIH;

Ubah suai struktur dalam keadaan JOIN, seperti menukar kedudukan kedua-dua jadual;Ubah suai"* ” Semua lajur ialah beberapa lajur lain;

- Tukar “asc” dan “desc”.

- Gangguan di atas ialah ralat penjanaan SQL yang paling biasa disebabkan oleh penghantaran ralat yang didapati secara statistik dalam eksperimen Oleh itu, gangguan dilakukan untuk situasi ini untuk mengurangkan pergantungan model aspek ini. Penilaian eksperimen

- Dataset penilaian ialah perbualan berbilang pusingan Text-to-SQL: SparC dan CoSQL.

- Petunjuk penilaian ialah:

QM: Padanan Soalan, yang bermaksud bahawa SQL yang dihasilkan dalam satu pusingan soalan tepat sepadan dengan Proportion output anotasi;

IM: Padanan Interaksi, menunjukkan perkadaran semua SQL yang dijana dalam keseluruhan pusingan lengkap dialog berbilang pusingan yang sepadan sepenuhnya dengan output anotasi.

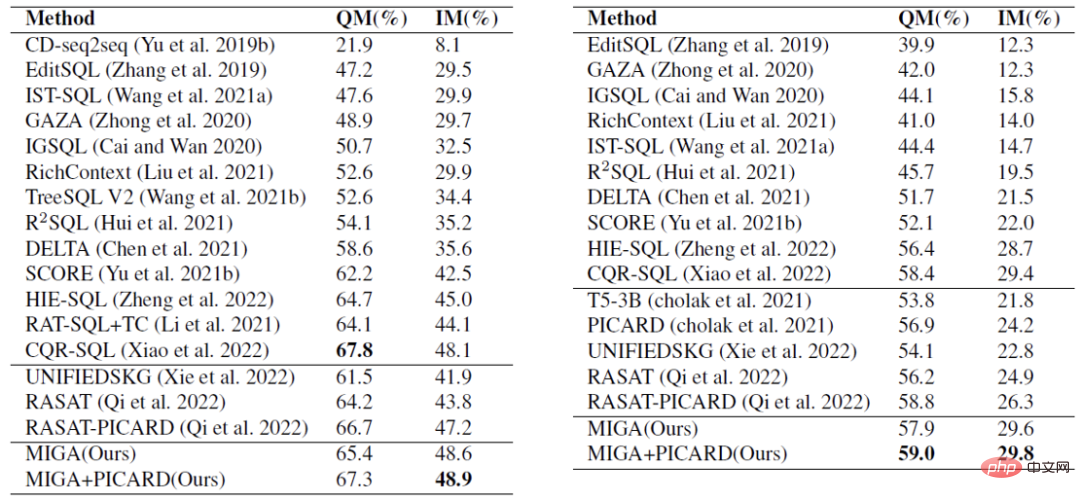

Dalam percubaan perbandingan dalam Jadual 1, MIGA mengatasi dialog berbilang pusingan terbaik semasa dari segi skor IM pada dua set data dan skor QM CoSQL -Model SQL. Dan berbanding dengan jenis penyelesaian berasaskan T5 yang sama, MIGA meningkatkan IM sebanyak 7.0% dan QM masing-masing sebanyak 5.8%.

Jadual 1 Analisis eksperimen perbandingan, bahagian pertama ialah model pokok, dan bahagian kedua ialah model generatif berdasarkan pra-latihan.

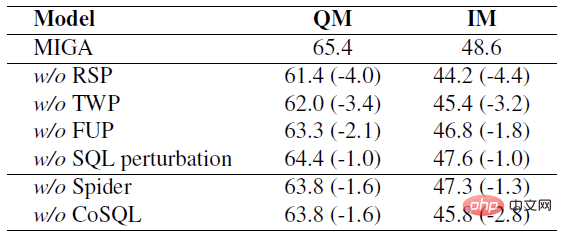

Dalam eksperimen ablasi dalam Jadual 2, kajian ini meneroka beberapa tugasan dalam proses latihan dua peringkat MIGA, dan juga membuktikan bahawa tugasan ini masing-masing akan memberi kesan kepada Tugasan sasaran telah dipertingkatkan kepada pelbagai peringkat.

Jadual 2 Untuk tugas SparC, mengalih keluar setiap tugas atau data masing-masing mengakibatkan penurunan dalam penunjuk.

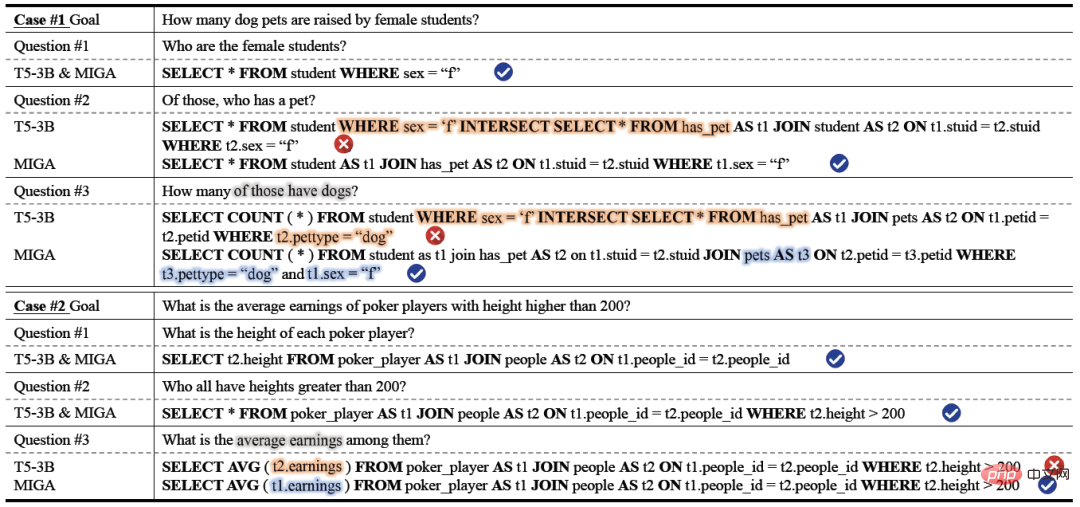

Dalam keputusan analisis kes sebenar, kestabilan dan ketepatan penjanaan MIGA adalah lebih baik daripada yang berdasarkan model latihan T5-3B itu adalah lebih baik dalam penjanaan Ia lebih baik daripada model lain dalam operasi gabungan berbilang jadual dan pemetaan lajur dan jadual. Dalam Soalan#2 Kes#1, model T5-3B tidak boleh menjana SQL yang sah untuk struktur JOIN yang agak kompleks (sambungan dua jadual), yang membawa kepada ramalan yang salah untuk struktur JOIN yang lebih kompleks (sambungan tiga jadual) dalam Soalan #3. MIGA meramalkan struktur JOIN dengan tepat dan mengekalkan keadaan sebelumnya t1.sex="f" dengan baik. Dalam Kes #2, T5-3B mengelirukan berbilang lajur dalam jadual berbeza dan kesilapan pendapatan untuk lajur jadual orang, manakala MIGA mengenal pasti lajur itu dengan betul sebagai milik jadual poker_player dan memautkannya kepada t1.

Jadual 3 Analisis kes.

Kesimpulan

NetEase Interactive Entertainment AI Lab mencadangkan model pra-latihan berbilang tugas dua peringkat berasaskan T5 untuk Text-to-SQL: MIGA . Dalam peringkat pra-latihan, MIGA menguraikan tugasan Text-to-SQL kepada tiga subtugas tambahan dan menyatukannya ke dalam paradigma penjanaan urutan-ke-jujukan untuk memotivasikan model T5 pra-terlatih dengan lebih baik. Dan mekanisme gangguan SQL diperkenalkan dalam peringkat penalaan halus untuk mengurangkan kesan penghantaran ralat dalam berbilang pusingan senario penjanaan Teks-ke-SQL.

Pada masa hadapan, pasukan penyelidik akan meneroka lagi strategi yang lebih berkesan untuk memanfaatkan kuasa model bahasa yang sangat besar, dan meneroka cara yang lebih elegan dan berkesan untuk terus mengatasi masalah yang disebabkan oleh penyampaian yang salah Masalah pengurangan kesan.

Atas ialah kandungan terperinci Model pra-latihan Teks-ke-SQL dua peringkat berbilang tugas MIGA berdasarkan T5. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI