Rumah >Peranti teknologi >AI >Pemaju ketawa gila! Kebocoran mengejutkan LLaMa mencetuskan kegilaan penggantian ChatGPT, dan medan LLM sumber terbuka berubah.

Pemaju ketawa gila! Kebocoran mengejutkan LLaMa mencetuskan kegilaan penggantian ChatGPT, dan medan LLM sumber terbuka berubah.

- 王林ke hadapan

- 2023-04-12 23:40:061239semak imbas

Siapa sangka kebocoran LLaMA yang tidak dijangka akan mencetuskan percikan inovasi terbesar dalam medan LLM sumber terbuka.

Serangkaian alternatif sumber terbuka ChatGPT yang luar biasa - "Keluarga Alpaca", kemudian muncul dengan cara yang mempesonakan.

Geseran antara sumber terbuka dan pengedaran berasaskan API adalah salah satu percanggahan yang paling mendesak dalam ekosistem AI generatif.

Dalam ruang teks ke imej, keluaran Stable Diffusion jelas menunjukkan bahawa sumber terbuka ialah mekanisme pengedaran yang berdaya maju untuk model asas.

Walau bagaimanapun, ini tidak berlaku dalam bidang model bahasa besar Penerobosan terbesar dalam bidang ini, seperti model seperti GPT-4, Claude dan Cohere, hanya tersedia. melalui API.

Alternatif sumber terbuka kepada model ini tidak menunjukkan tahap prestasi yang sama, terutamanya dalam keupayaan untuk mengikut arahan manusia. Walau bagaimanapun, kebocoran yang tidak dijangka benar-benar mengubah keadaan ini.

Kebocoran “Epik” LLaMA

Beberapa minggu lalu, Meta AI melancarkan model bahasa besar LLaMA.

LLaMA mempunyai versi yang berbeza, termasuk parameter 7B, 13B, 33B dan 65B Walaupun ia lebih kecil daripada GPT-3, ia boleh bersaing dengan GPT-3 pada banyak tugasan .

LLaMA bukan sumber terbuka pada mulanya, tetapi seminggu selepas dikeluarkan, model itu tiba-tiba bocor pada 4chan, mencetuskan ribuan muat turun.

Insiden ini boleh dipanggil "kebocoran epik" kerana ia telah menjadi sumber inovasi yang tidak berkesudahan dalam bidang model bahasa besar.

Dalam beberapa minggu sahaja, inovasi ejen LLM yang dibina di atasnya telah meledak.

Alpaca, Vicuna, Koala, ChatLLaMA, FreedomGPT, ColossalChat... Mari kita tinjau bagaimana ledakan besar "keluarga alpaca" ini dilahirkan.

Alpaca Pada pertengahan bulan Mac, model besar Alpaca yang dikeluarkan oleh Stanford menjadi popular.

Alpaca ialah model baharu yang diperhalusi daripada LLaMA 7B Meta Ia hanya menggunakan 52k data dan prestasinya lebih kurang sama dengan GPT-3.5.

Kuncinya ialah kos latihan amat rendah, kurang daripada 600 dolar AS.

Penyelidik Stanford membandingkan GPT-3.5 (text-davinci-003) dan Alpaca 7B dan mendapati bahawa prestasi kedua-dua model adalah sangat serupa. Alpaca menang 90 berbanding 89 kali menentang GPT-3.5.

Bagi pasukan Stanford, jika mereka ingin melatih model mengikut arahan berkualiti tinggi dalam bajet, mereka mesti menghadapi dua cabaran penting: mempunyai model bahasa pra-latihan yang berkuasa, dan data mengikut arahan yang berkualiti tinggi.

Tepat sekali, model LLaMA yang diberikan kepada penyelidik akademik menyelesaikan masalah pertama.

Untuk cabaran kedua, kertas kerja "Self-Instruct: aligning Language Model with Self Generated Instructions" memberi inspirasi yang baik, iaitu menggunakan model bahasa yang kukuh sedia ada untuk menjana data arahan secara automatik .

Kelemahan terbesar model LLaMA ialah kekurangan penalaan halus arahan. Salah satu inovasi terbesar OpenAI ialah penggunaan penalaan arahan pada GPT-3.

Dalam hal ini, Stanford menggunakan model bahasa besar sedia ada untuk menjana secara automatik demonstrasi arahan berikut.

Kini, Alpaca secara langsung dianggap sebagai "Resapan Stabil model teks besar" oleh netizen.

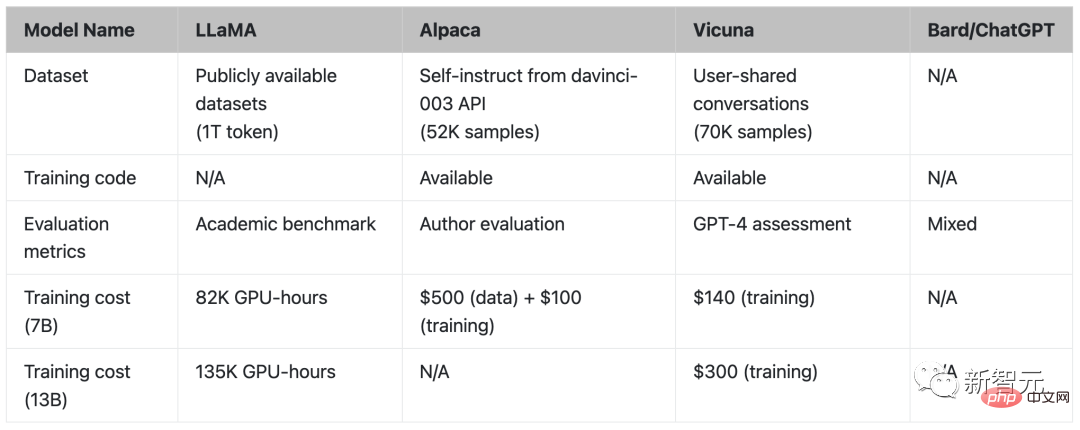

Vicuna Pada penghujung Mac, penyelidik dari UC Berkeley, Carnegie Mellon University, Stanford University dan UC San Diego sumber terbuka Vicuna, penalaan halus LLaMA yang sepadan dengan prestasi Versi GPT-4.

Parameter 13 bilion Vicuna dilatih dengan menyempurnakan LLaMA pada perbualan kongsi pengguna yang dikumpulkan oleh ShareGPT, dan kos latihan ialah hampir AS$300.

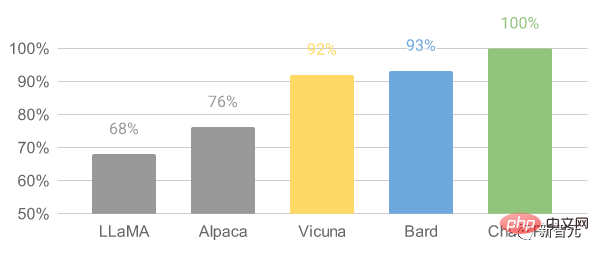

Hasilnya menunjukkan bahawa Vicuna-13B mencapai keupayaan yang setanding dengan ChatGPT dan Bard dalam lebih daripada 90% kes.

Untuk proses latihan Vicuna-13B, butirannya adalah seperti berikut:

Pertama, penyelidik memulakan perbualan ChatGPT Kira-kira 70K perbualan telah dikumpulkan di laman web perkongsian ShareGPT.

Seterusnya, penyelidik mengoptimumkan skrip latihan yang disediakan oleh Alpaca untuk membolehkan model mengendalikan berbilang pusingan perbualan dan urutan yang panjang dengan lebih baik. Kemudian PyTorch FSDP telah digunakan untuk satu hari latihan pada 8 GPU A100.

Dari segi penilaian kualiti model, penyelidik mencipta 80 soalan berbeza dan menilai output model menggunakan GPT-4.

Untuk membandingkan model yang berbeza, penyelidik menggabungkan output setiap model menjadi satu gesaan dan kemudian meminta GPT-4 menilai model yang memberikan jawapan yang lebih baik.

Perbandingan LLaMA, Alpaca, Vicuna dan ChatGPT

Koala

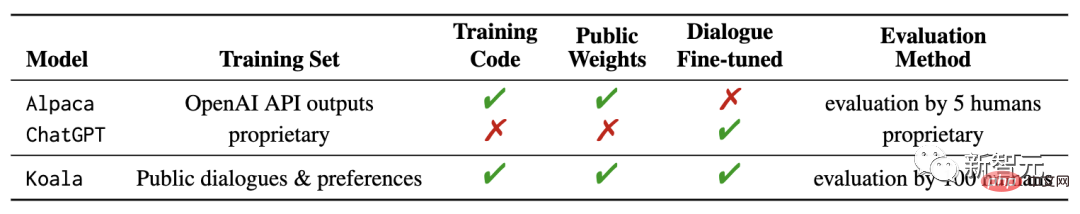

Baru-baru ini, UC Berkeley AI Research Institute (BAIR) mengeluarkan model baharu "Koala". Berbanding dengan penggunaan data GPT OpenAI sebelum ini untuk penalaan halus, perbezaan antara Koala ialah ia menggunakan pemerolehan rangkaian -data berkualiti untuk latihan.

Hasil penyelidikan menunjukkan bahawa Koala boleh menjawab pelbagai pertanyaan pengguna dengan berkesan, menghasilkan jawapan yang selalunya lebih popular daripada Alpaca, dan sekurang-kurangnya berkesan seperti ChatGPT dalam separuh daripada kes sehingga dan ke bawah.

Para penyelidik berharap hasil eksperimen ini dapat meneruskan perbincangan mengenai prestasi relatif model sumber tertutup yang besar berbanding model awam yang kecil, terutamanya kerana keputusan menunjukkan bahawa bagi mereka yang boleh dijalankan secara tempatan Model kecil boleh mencapai prestasi model besar jika data latihan dikumpul dengan teliti.

Malah, hasil percubaan model Alpaca yang dikeluarkan sebelum ini oleh Universiti Stanford dan penalaan halus data LLaMA berdasarkan model GPT OpenAI telah ditunjukkan, data yang betul boleh meningkatkan model sumber terbuka yang lebih kecil dengan ketara.

Ini juga merupakan hasrat asal penyelidik Berkeley untuk membangunkan dan mengeluarkan model Koala, dengan harapan dapat memberikan satu lagi bukti eksperimen hasil perbincangan ini.

Koala memperhalusi data interaksi percuma yang diperoleh daripada Internet dan memberi perhatian khusus kepada data termasuk interaksi dengan model sumber tertutup berprestasi tinggi seperti ChatGPT.

Daripada mengejar data rangkaian sebanyak mungkin untuk memaksimumkan volum data, penyelidik menumpukan pada pengumpulan set data berkualiti tinggi yang kecil, termasuk data suling ChatGPT, Data sumber terbuka dsb.

ChatLLaMA

ChatLLaMA sumber terbuka Nebuly, rangka kerja yang membolehkan kami mencipta pembantu perbualan menggunakan data kami sendiri.

ChatLLaMA membolehkan kami mencipta pembantu seperti ChatGPT yang diperibadikan hiper menggunakan data kami sendiri dan pengiraan sesedikit mungkin.

Dengan mengandaikan bahawa pada masa hadapan, kami tidak lagi bergantung pada seorang pembantu besar yang "memerintah semua orang", semua orang boleh membuat versi pembantu ChatGPT diperibadikan mereka sendiri, yang boleh menyokong pelbagai keperluan manusia. macam permintaan.

Walau bagaimanapun, mencipta pembantu diperibadikan sedemikian memerlukan usaha dalam pelbagai aspek: penciptaan set data, latihan cekap menggunakan RLHF dan pengoptimuman inferens.

Tujuan perpustakaan ini adalah untuk memberi ketenangan fikiran kepada pembangun dengan mengabstrakkan kerja yang diperlukan untuk mengoptimumkan dan mengumpul sejumlah besar data.

ChatLLaMA direka untuk membantu pembangun mengendalikan pelbagai kes penggunaan, semuanya berkaitan dengan latihan RLHF dan inferens yang dioptimumkan. Berikut ialah beberapa rujukan kes penggunaan:

- Cipta pembantu diperibadikan seperti ChatGPT untuk tugasan khusus menegak (perundangan, perubatan, permainan, penyelidikan akademik, dll.);

- Ingin melatih pembantu seperti ChatGPT yang cekap menggunakan data terhad pada infrastruktur perkakasan tempatan

- Ingin membuat versi peribadi anda sendiri seperti pembantu ChatGPT; , Pada masa yang sama, elakkan kos luar kawalan;

- Saya ingin tahu seni bina model yang mana (LLaMA, OPT, GPTJ, dll.) yang paling memenuhi keperluan saya dari segi perkakasan, belanjawan pengkomputeran dan prestasi;

- Ingin menyelaraskan pembantu dengan nilai peribadi/syarikat, budaya, jenama dan manifesto saya.

Dibina menggunakan Electron dan React, FreedomGPT ialah aplikasi desktop yang membolehkan pengguna menjalankan LLaMA pada mesin tempatan mereka.

Ciri-ciri FreedomGPT jelas daripada namanya - soalan yang dijawabnya tidak tertakluk kepada sebarang penapisan atau penapisan keselamatan.

Apl ini dibangunkan oleh Age of AI, firma modal teroka AI.

FreedomGPT dibina di atas Alpaca. FreedomGPT menggunakan ciri membezakan Alpaca, kerana Alpaca agak mudah untuk diakses dan disesuaikan daripada model lain.

ChatGPT mengikut dasar penggunaan OpenAI dan mengehadkan kebencian, kecederaan diri, ancaman, keganasan dan kandungan seksual.

Tidak seperti ChatGPT, FreedomGPT menjawab soalan tanpa berat sebelah atau pilih kasih dan tidak akan teragak-agak untuk menjawab topik kontroversi atau kontroversi.

FreedomGPT malah menjawab "Cara membuat bom di rumah", yang OpenAI dialih keluar secara khusus daripada GPT-4.

FreedomGPT adalah unik kerana ia mengatasi sekatan penapisan dan memenuhi topik kontroversi tanpa sebarang jaminan. Simbolnya ialah Patung Liberty kerana model bahasa besar yang unik dan berani ini melambangkan kebebasan.

FreedomGPT malah boleh dijalankan secara setempat pada komputer anda tanpa memerlukan sambungan Internet.

Selain itu, versi sumber terbuka akan dikeluarkan tidak lama lagi, membenarkan penyesuaian penuh oleh pengguna dan organisasi.

ColossalChat

ColossalChat yang dicadangkan oleh UC Berkeley hanya memerlukan kurang daripada 10 bilion parameter untuk mencapai keupayaan dwibahasa Cina dan Inggeris, dan kesannya adalah setara dengan ChatGPT dan GPT-3.5 .

Selain itu, ColossalChat, yang berasaskan model LLaMA, juga menghasilkan semula proses RLHF yang lengkap dan pada masa ini merupakan projek sumber terbuka yang paling hampir dengan laluan teknikal asal ChatGPT.

Set data latihan dwibahasa Cina-Inggeris

ColossalChat mengeluarkan set data dwibahasa yang mengandungi kira-kira 100,000 pasangan soalan dan jawapan bahasa Cina dan Inggeris.

Set data ini dikumpul dan dibersihkan daripada senario masalah sebenar pada platform media sosial sebagai set data benih, dilanjutkan menggunakan arahan kendiri dan kos anotasi adalah lebih kurang $900.

Set data ini mengandungi data benih yang lebih realistik dan pelbagai yang meliputi julat topik yang lebih luas daripada set data yang dijana oleh kaedah arahan kendiri yang lain.

Dataset data ini sesuai untuk penalaan halus dan latihan RLHF. ColossalChat boleh mencapai interaksi perbualan yang lebih baik apabila menyediakan data berkualiti tinggi, dan juga menyokong bahasa Cina.

Lengkapkan saluran paip RLHF

Terdapat tiga peringkat replikasi algoritma RLHF:

Dalam RLHF-Stage1, penalaan halus arahan diselia dilakukan menggunakan set data dwibahasa di atas untuk memperhalusi model.

Dalam RLHF-Stage2, model ganjaran dilatih dengan menyusun secara manual output berbeza daripada gesaan yang sama untuk menetapkan skor yang sepadan, dan kemudian menyelia latihan model ganjaran.

Dalam RLHF-Stage3, algoritma pembelajaran pengukuhan digunakan, yang merupakan bahagian paling kompleks dalam proses latihan.

Saya percaya lebih banyak projek akan dikeluarkan tidak lama lagi.

Tiada siapa menjangkakan kebocoran LLaMA yang tidak dijangka ini akan mencetuskan cetusan inovasi terbesar dalam bidang LLM sumber terbuka.

Atas ialah kandungan terperinci Pemaju ketawa gila! Kebocoran mengejutkan LLaMa mencetuskan kegilaan penggantian ChatGPT, dan medan LLM sumber terbuka berubah.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI